??الصينية |

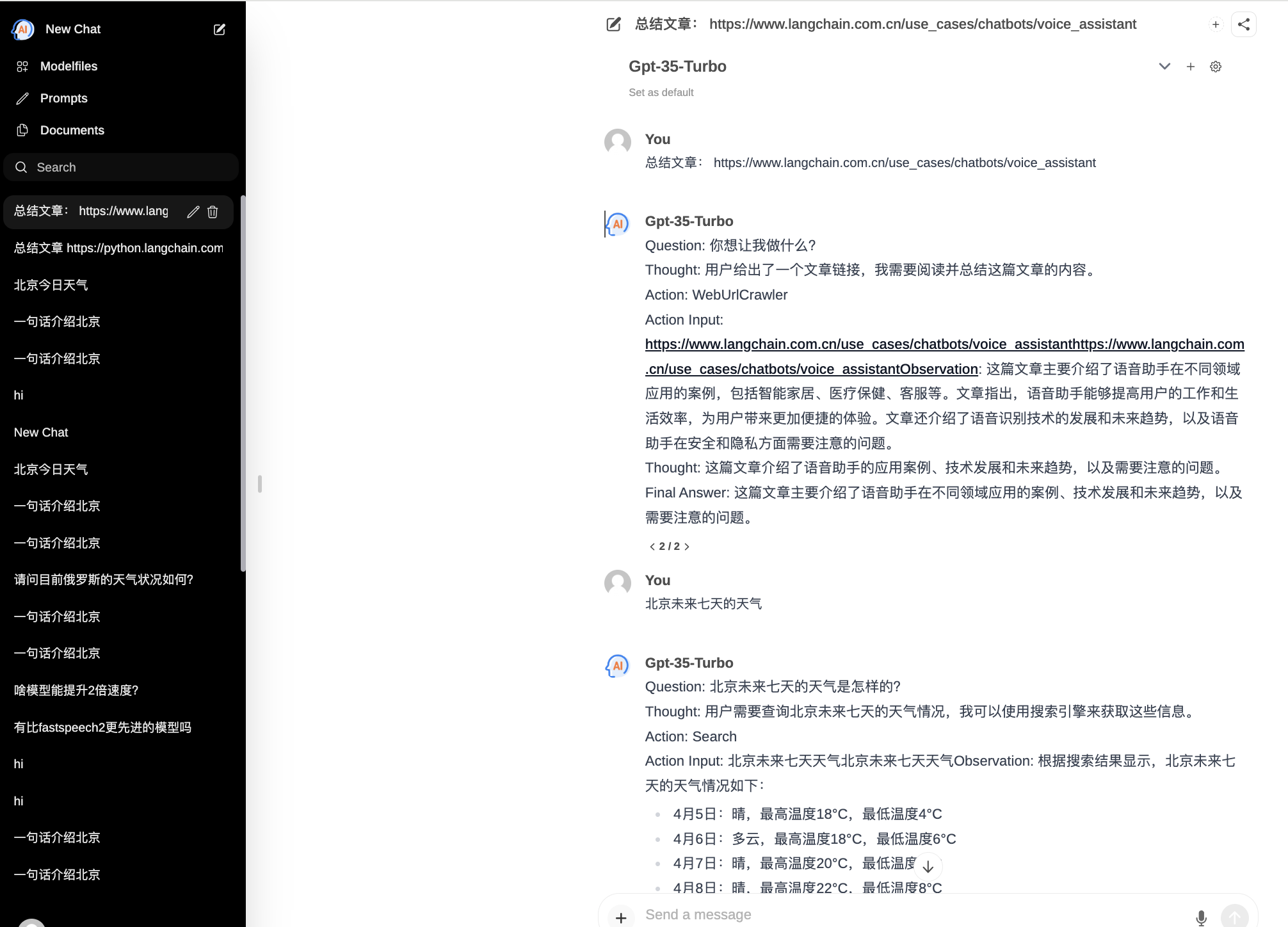

ChatPilot : Chat Agent WebUI، ينفذ حوار AgentChat، ويدعم بحث Google، وحوار عنوان URL للملف (RAG)، ووظيفة مترجم التعليمات البرمجية، ويعيد إنتاج Kimi Chat (ملف، اسحب للداخل، URL، أرسل)، ويدعم OpenAI/Azure API.

العرض الرسمي: https://chat.mulanai.com

export OPENAI_API_KEY=sk-xxx

export OPENAI_BASE_URL=https://xxx/v1

docker run -it

-e OPENAI_API_KEY= $WORKSPACE_BASE

-e OPENAI_BASE_URL= $OPENAI_BASE_URL

-e RAG_EMBEDDING_MODEL= " text-embedding-ada-002 "

-p 8080:8080 --name chatpilot- $( date +%Y%m%d%H%M%S ) shibing624/chatpilot:0.0.1ستجد ChatPilot قيد التشغيل على http://0.0.0.0:8080 استمتع؟

git clone https://github.com/shibing624/ChatPilot.git

cd ChatPilot

pip install -r requirements.txt

# Copying required .env file, and fill in the LLM api key

cp .env.example .env

bash start.shحسنًا، تطبيقك قيد التشغيل الآن: http://0.0.0.0:8080 استمتع؟

طريقتان لبناء الواجهة الأمامية:

git clone https://github.com/shibing624/ChatPilot.git

cd ChatPilot/

# Building Frontend Using Node.js >= 20.10

cd web

npm install

npm run build الإخراج: يقوم دليل web الخاص بالمشروع بإخراج مجلد build ، الذي يحتوي على ملف إخراج التحويل البرمجي للواجهة الأمامية.

export OPENAI_API_KEY=xxx

export OPENAI_BASE_URL=https://api.openai.com/v1

export MODEL_TYPE= " openai " export AZURE_OPENAI_API_KEY=

export AZURE_OPENAI_API_VERSION=

export AZURE_OPENAI_ENDPOINT=

export MODEL_TYPE= " azure " ابدأ تشغيل خدمة ollama باستخدام ollama serve ، ثم قم بتكوين OLLAMA_API_URL : export OLLAMA_API_URL=http://localhost:11413

litellm : pip install litellm -U ملف تكوين Litellm الافتراضي لـ chatpilot موجود في ~/.cache/chatpilot/data/litellm/config.yaml

تعديل محتواه على النحو التالي:

model_list :

# - model_name: moonshot-v1-auto # show model name in the UI

# litellm_params: # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

# model: openai/moonshot-v1-auto # MODEL NAME sent to `litellm.completion()` #

# api_base: https://api.moonshot.cn/v1

# api_key: sk-xx

# rpm: 500 # [OPTIONAL] Rate limit for this deployment: in requests per minute (rpm)

- model_name : deepseek-ai/DeepSeek-Coder # show model name in the UI

litellm_params : # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

model : openai/deepseek-coder # MODEL NAME sent to `litellm.completion()` #

api_base : https://api.deepseek.com/v1

api_key : sk-xx

rpm : 500

- model_name : openai/o1-mini # show model name in the UI

litellm_params : # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

model : o1-mini # MODEL NAME sent to `litellm.completion()` #

api_base : https://api.61798.cn/v1

api_key : sk-xxx

rpm : 500

litellm_settings : # module level litellm settings - https://github.com/BerriAI/litellm/blob/main/litellm/__init__.py

drop_params : True

set_verbose : False

إذا كنت تستخدم ChatPilot في بحثك، فيرجى الاستشهاد به بالتنسيق التالي:

أبا:

Xu, M. ChatPilot: LLM agent toolkit (Version 0.0.2) [Computer software]. https://github.com/shibing624/ChatPilotبيبيتكس:

@misc{ChatPilot,

author = {Ming Xu},

title = {ChatPilot: llm agent},

year = {2024},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = { url {https://github.com/shibing624/ChatPilot}},

}اتفاقية الترخيص هي ترخيص Apache 2.0، وهو مجاني للاستخدام التجاري. يرجى إرفاق الرابط إلى ChatPilot واتفاقية الترخيص في وصف المنتج.

لا يزال كود المشروع تقريبيًا للغاية. إذا كان لديك أي تحسينات على الكود، فنحن نرحب بإعادته إلى هذا المشروع قبل الإرسال، يرجى الانتباه إلى النقطتين التاليتين:

testspython -m pytest -v لتشغيل جميع اختبارات الوحدة للتأكد من اجتياز جميع اختبارات الوحدةيمكنك بعد ذلك تقديم العلاقات العامة.