غالبًا ما تكافح أنظمة RAG التقليدية لتقديم إجابات مرضية عندما يطرح المستخدمون أسئلة غامضة أو غامضة دون توفير سياق كافٍ. يؤدي هذا إلى إجابات غير مفيدة مثل "لا أعرف" أو إجابات غير صحيحة ومختلقة مقدمة من LLM. يحتوي هذا الريبو على تعليمات برمجية لتحسين وكلاء RAG التقليديين.

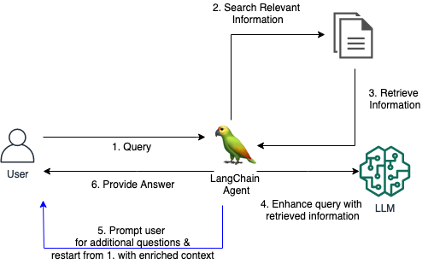

نقدم أداة LangChain مخصصة لوكيل RAG، والتي تمكن الوكيل من المشاركة في حوار محادثة مع المستخدم عندما يكون السؤال الأولي غير واضح أو غامض للغاية. من خلال طرح أسئلة توضيحية، وحث المستخدم على مزيد من التفاصيل، ودمج المعلومات السياقية، يمكن للوكيل جمع السياق اللازم لتقديم إجابة دقيقة ومفيدة - حتى من استعلام أولي غامض.

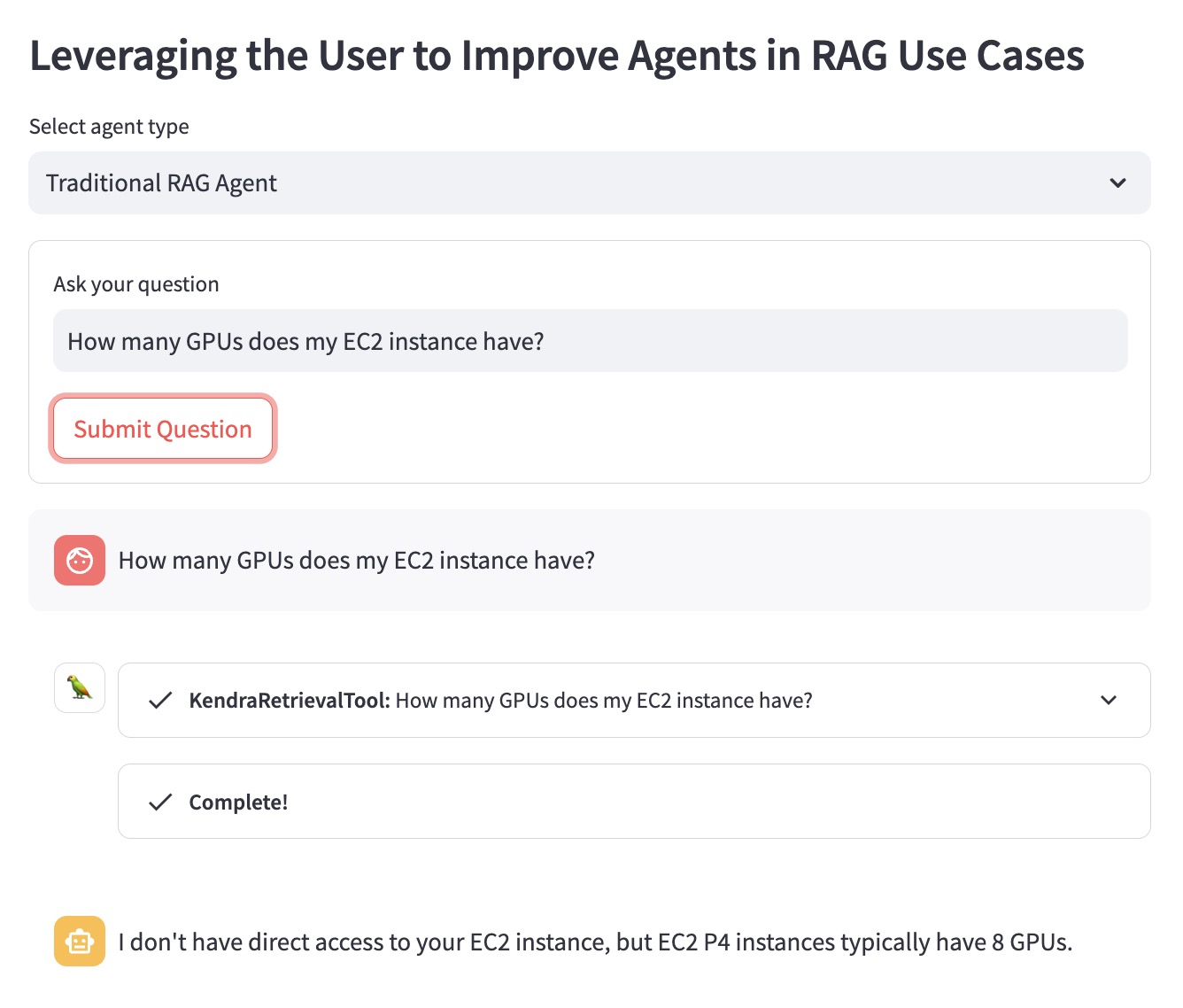

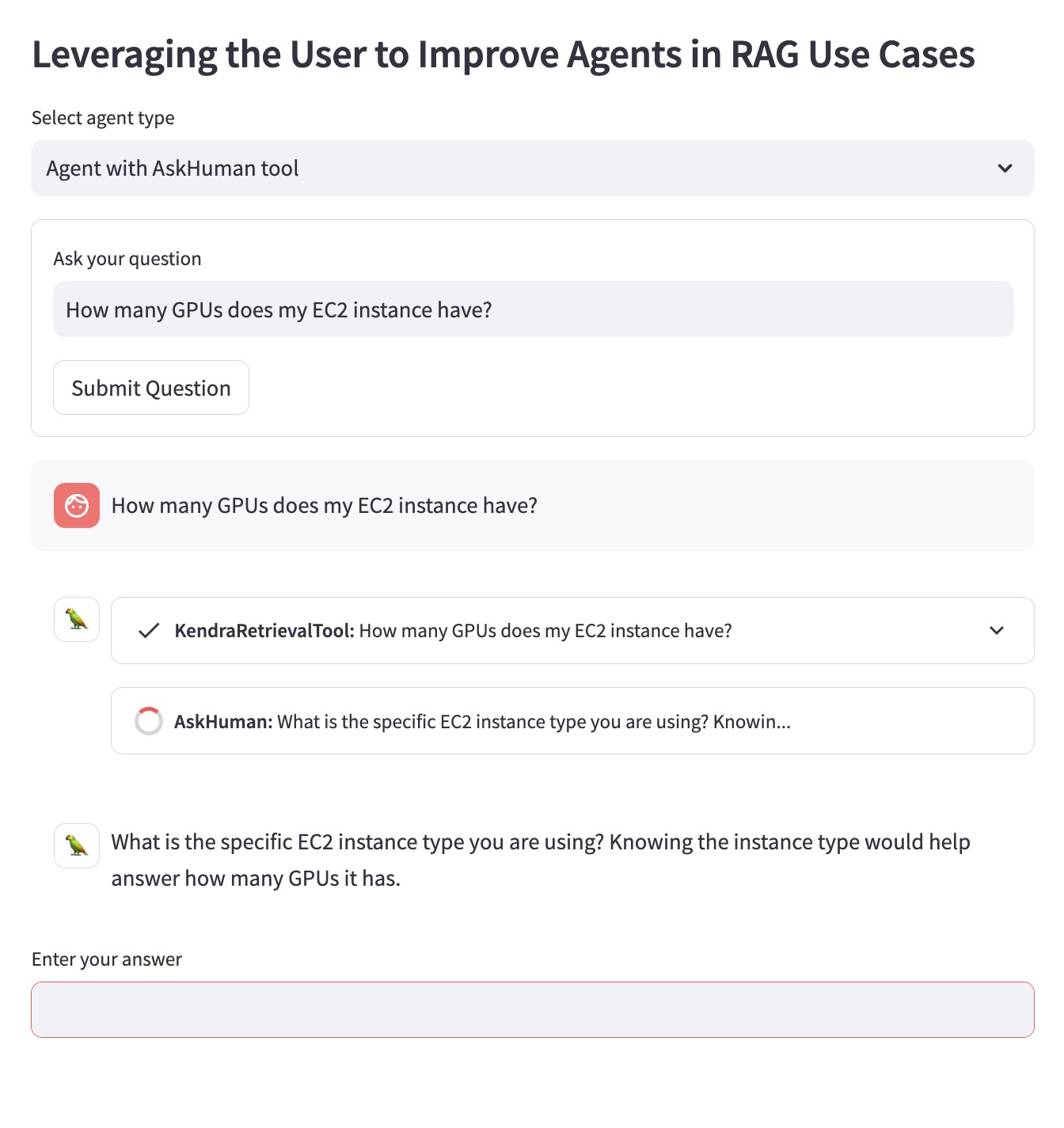

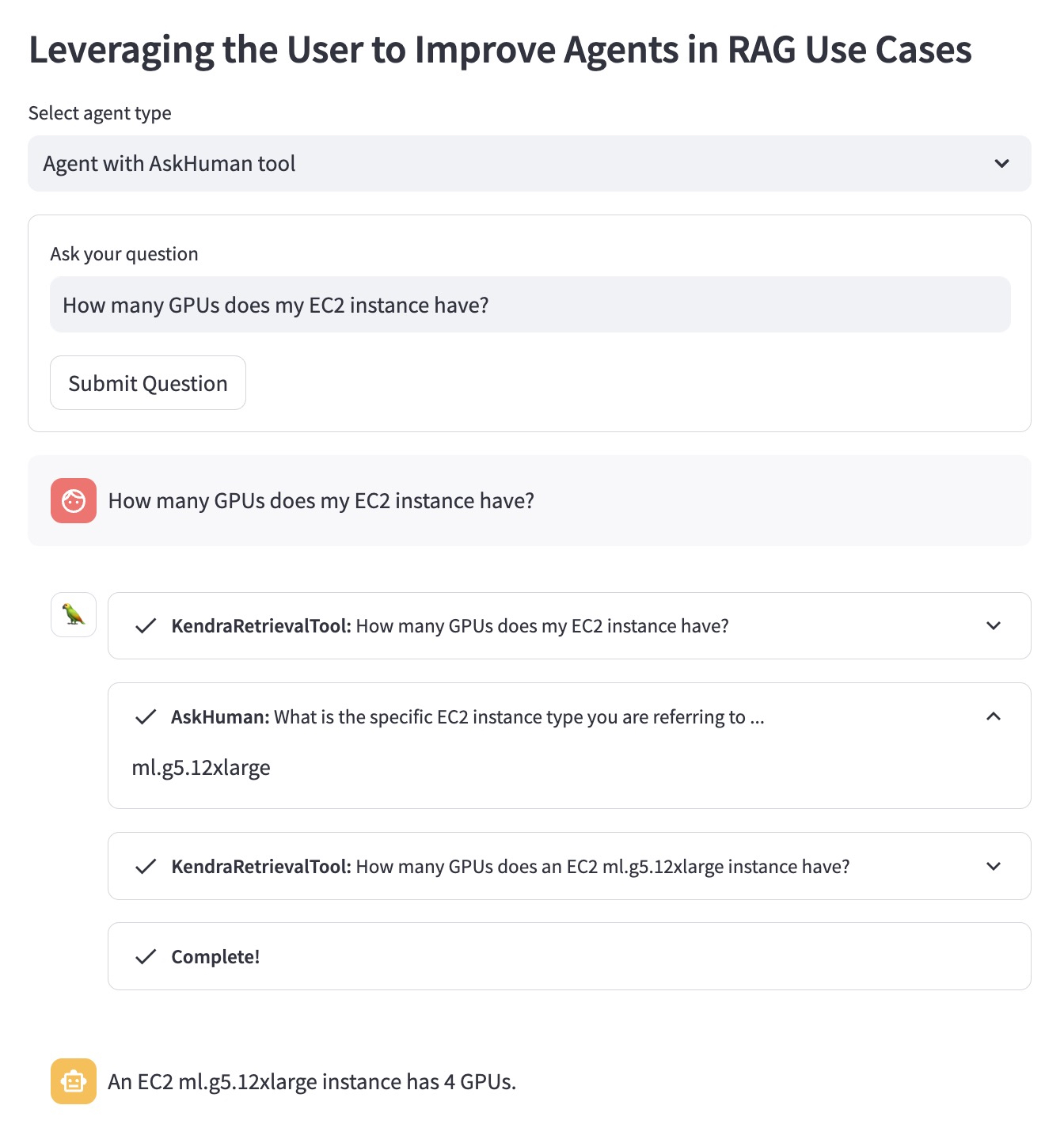

دعونا نوضح الميزة باستخدام مثال السؤال التالي: "كم عدد وحدات معالجة الرسومات الموجودة في مثيل EC2 الخاص بي؟".

لا يعرف وكيل RAG التقليدي مثيل EC2 الذي يفكر فيه المستخدم. ولذلك، فإنه يقدم إجابة ليست مفيدة للغاية:

يقوم عامل RAG المحسّن باستخدام أداة "AskHuman" بتنفيذ خطوتين إضافيتين:

يساعد هذا الوكيل المحسّن على تقديم إجابة محددة ومفيدة:

لتشغيل هذا العرض التوضيحي في حساب AWS الخاص بك، يتعين عليك اتباع الخطوات التالية:

llm المستخدمة في LangChain Agent في demo.py بشهادة LLM مدعومة من LangChain.sh dependencies.sh في الوحدة الطرفية.KENDRA_INDEX_ID الخاص بك في معلمات الاسترداد demo.py .streamlit run demo.py في الوحدة الطرفية. لاحظ أن نشر فهرس Kendra الجديد وتشغيل الإصدار التجريبي قد يضيف رسومًا إضافية إلى فاتورتك. لتجنب تكبد تكاليف غير ضرورية، يرجى حذف Amazon Kendra Index إذا لم تعد تستخدمه وإيقاف تشغيل مثيل SageMaker Studio إذا استخدمته لتشغيل العرض التوضيحي.