KoMiniLM

1.0.0

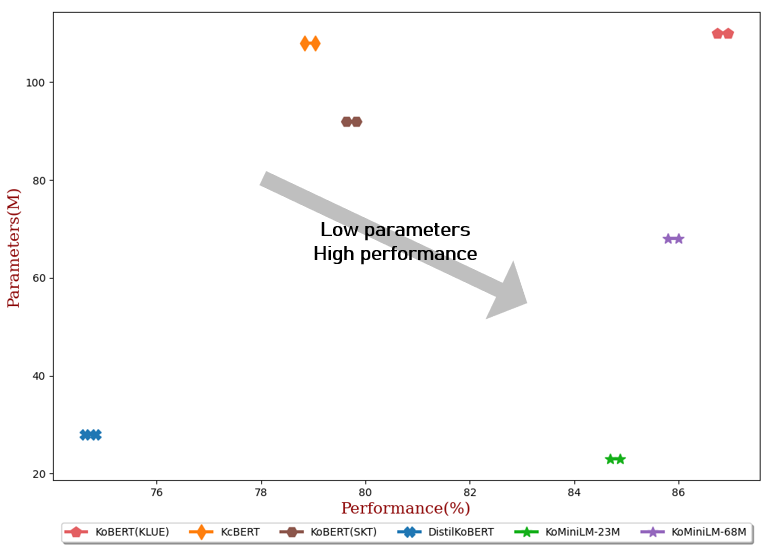

تتكون نماذج اللغة الحالية عادةً من مئات الملايين من المعلمات التي تجلب تحديات للضبط الدقيق والخدمة عبر الإنترنت في تطبيقات الحياة الواقعية بسبب قيود الكمون والقدرة. في هذا المشروع، قمنا بإصدار نموذج لغة كورية خفيف الوزن لمعالجة أوجه القصور المذكورة أعلاه في نماذج اللغة الحالية.

from transformers import AutoTokenizer , AutoModel

tokenizer = AutoTokenizer . from_pretrained ( "BM-K/ KoMiniLM " ) # 23M model

model = AutoModel . from_pretrained ( "BM-K/ KoMiniLM " )

inputs = tokenizer ( "안녕 세상아!" , return_tensors = "pt" )

outputs = model ( ** inputs )** التحديثات بتاريخ 2022.06.20 **

** التحديثات بتاريخ 2022.05.24 **

Teacher Model : كلو بيرت (قاعدة)

تم استخلاص توزيع الاهتمام الذاتي وعلاقة قيمة الاهتمام الذاتي [Wang et al., 2020] من كل طبقة منفصلة من نموذج المعلم إلى نموذج الطالب. وانغ وآخرون. المقطر في الطبقة الأخيرة من المحول، ولكن لم يكن هذا هو الحال في هذا المشروع.

| بيانات | تعليقات الأخبار | مقالة إخبارية |

|---|---|---|

| مقاس | 10 جرام | 10 جرام |

ملحوظة

- يمكن تحسين الأداء بشكل أكبر عن طريق إضافة بيانات الويكي إلى التدريب.

- رمز الزحف والمعالجة المسبقة لمقالة الأخبار موجود هنا.

{

"architectures" : [

" BertForPreTraining "

],

"attention_probs_dropout_prob" : 0.1 ,

"classifier_dropout" : null ,

"hidden_act" : " gelu " ,

"hidden_dropout_prob" : 0.1 ,

"hidden_size" : 384 ,

"initializer_range" : 0.02 ,

"intermediate_size" : 1536 ,

"layer_norm_eps" : 1e-12 ,

"max_position_embeddings" : 512 ,

"model_type" : " bert " ,

"num_attention_heads" : 12 ,

"num_hidden_layers" : 6 ,

"output_attentions" : true ,

"pad_token_id" : 0 ,

"position_embedding_type" : " absolute " ,

"return_dict" : false ,

"torch_dtype" : " float32 " ,

"transformers_version" : " 4.13.0 " ,

"type_vocab_size" : 2 ,

"use_cache" : true ,

"vocab_size" : 32000

}{

"architectures" : [

" BertForPreTraining "

],

"attention_probs_dropout_prob" : 0.1 ,

"classifier_dropout" : null ,

"hidden_act" : " gelu " ,

"hidden_dropout_prob" : 0.1 ,

"hidden_size" : 768 ,

"initializer_range" : 0.02 ,

"intermediate_size" : 3072 ,

"layer_norm_eps" : 1e-12 ,

"max_position_embeddings" : 512 ,

"model_type" : " bert " ,

"num_attention_heads" : 12 ,

"num_hidden_layers" : 6 ,

"output_attentions" : true ,

"pad_token_id" : 0 ,

"position_embedding_type" : " absolute " ,

"return_dict" : false ,

"torch_dtype" : " float32 " ,

"transformers_version" : " 4.13.0 " ,

"type_vocab_size" : 2 ,

"use_cache" : true ,

"vocab_size" : 32000

}

cd KoMiniLM -Finetune

bash scripts/run_all_ KoMiniLM .sh

| #بارام | متوسط | إن إس إم سي (لجنة التنسيق الإدارية) | نيفر نر (F1) | الكفوف (لجنة التنسيق الإدارية) | كورنلي (لجنة التنسيق الإدارية) | كورستس (الرامح) | زوج الأسئلة (لجنة التنسيق الإدارية) | KorQuaD (ديف) (م/F1) | |

|---|---|---|---|---|---|---|---|---|---|

| كوبرت (كلوي) | 110 م | 86.84 | 90.20±0.07 | 87.11 ± 0.05 | 81.36 ± 0.21 | 81.06 ± 0.33 | 82.47 ± 0.14 | 95.03 ± 0.44 | 84.43±0.18 / 93.05±0.04 |

| ككبيرت | 108 م | 78.94 | 89.60±0.10 | 84.34 ± 0.13 | 67.02 ± 0.42 | 74.17 ± 0.52 | 76.57±0.51 | 93.97±0.27 | 60.87±0.27 / 85.01 ± 0.14 |

| كوبرت (SKT) | 92 م | 79.73 | 89.28±0.42 | 87.54±0.04 | 80.93 ± 0.91 | 78.18±0.45 | 75.98±2.81 | 94.37 ± 0.31 | 51.94±0.60 / 79.69±0.66 |

| ديستيلكوبرت | 28 م | 74.73 | 88.39 ± 0.08 | 84.22 ± 0.01 | 61.74±0.45 | 70.22±0.14 | 72.11±0.27 | 92.65±0.16 | 52.52±0.48 / 76.00±0.71 |

| KoMiniLM † | 68 م | 85.90 | 89.84±0.02 | 85.98±0.09 | 80.78±0.30 | 79.28±0.17 | 81.00±0.07 | 94.89 ± 0.37 | 83.27±0.08 / 92.08 ± 0.06 |

| KoMiniLM † | 23 م | 84.79 | 89.67±0.03 | 84.79 ± 0.09 | 78.67±0.45 | 78.10±0.07 | 78.90±0.11 | 94.81±0.12 | 82.11±0.42 / 91.21 ± 0.29 |

تم ترخيص هذا العمل بموجب ترخيص Creative Commons Attribution-ShareAlike 4.0 الدولي.