هل أنت غارق في المعلومات التي تجمعها يوميا؟ هل تجد نفسك غالبًا ضائعًا في بحر من ملفات تخفيض السعر ومقاطع الفيديو وصفحات الويب وملفات PDF؟ ماذا لو كانت هناك طريقة لفهرسة كل هذا المحتوى والبحث عنه وحتى التفاعل معه بسلاسة كما لم يحدث من قبل؟ مرحبًا بكم في مستقبل إدارة المعرفة الشخصية: مشروع وكيل الذكاء الاصطناعي للدماغ الثاني.

لقد أحدثت فكرة تياجو فورتي الرائدة حول الدماغ الثاني ثورة في طريقة تفكيرنا في تدوين الملاحظات. لا يتعلق الأمر فقط بتدوين الأفكار؛ يتعلق الأمر بإنشاء أداة قوية تعزز التعلم والإبداع. تعرف على المزيد حول بناء دماغ ثانٍ بقلم تياجو فورتي هنا.

الفهرسة الآلية: لا مزيد من الفرز اليدوي للملفات! قم بفهرسة محتوى ملفات تخفيض السعر تلقائيًا إلى جانب الروابط المضمنة، مثل مستندات PDF ومقاطع فيديو YouTube وصفحات الويب.

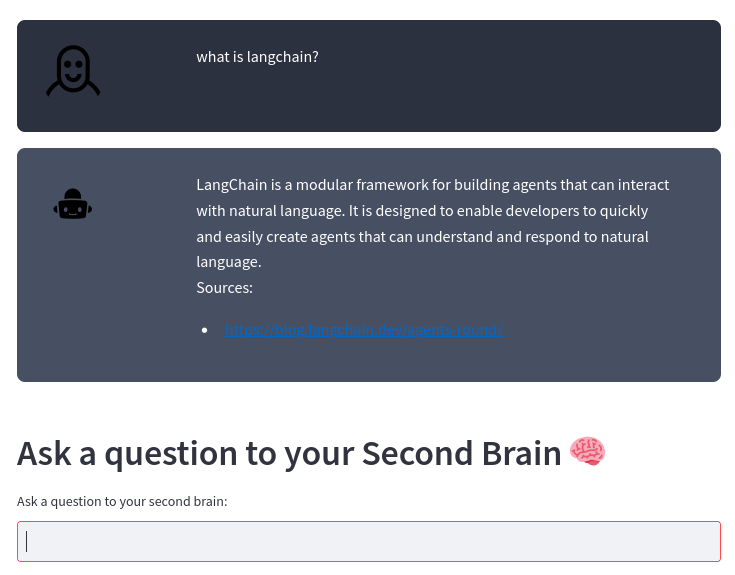

محرك البحث الذكي: اطرح أسئلة حول المحتوى الخاص بك، وسيقدم الذكاء الاصطناعي الخاص بنا إجابات دقيقة، باستخدام نموذج اللغة الكبير OpenAI القوي. إنه مثل وجود مساعد شخصي يعرف المحتوى الخاص بك من الداخل إلى الخارج!

التكامل بدون جهد: سواء كنت تتبع طريقة Second Brain أو لديك طريقتك الفريدة لتدوين الملاحظات، فإن نظامنا يتكامل بسلاسة مع أسلوبك، مما يساعدك على الاستفادة من القوة الحقيقية لمعلوماتك.

إنتاجية محسنة: قضاء وقت أقل في التنظيم ووقت أكثر في الابتكار. ومن خلال الوصول إلى معلوماتك بشكل أسرع وأكثر كفاءة، يمكنك التركيز على ما يهم حقًا.

لا تدع ملاحظاتك ومحتوياتك تطغى عليك. اجعلهم حلفاءك في النمو والابتكار والإنتاجية. انضم إلينا في تغيير الطريقة التي تدير بها معرفتك الشخصية وتأخذ قفزة نحو المستقبل.

إذا قمت بتدوين ملاحظات باستخدام ملفات تخفيض السعر كما هو الحال في طريقة Second Brain أو باستخدام طريقتك الخاصة، فسيقوم هذا المشروع تلقائيًا بفهرسة محتوى ملفات تخفيض السعر والروابط المضمنة (مستندات pdf وفيديو يوتيوب وصفحات الويب) ويسمح لك بطرح سؤال حول المحتوى الخاص بك باستخدام نموذج اللغة الكبير OpenAI.

تم بناء النظام على أساس إطار عمل LangChain ومتجر ناقلات ChromaDB.

يأخذ النظام دليلاً كمدخل حيث تقوم بتخزين ملاحظات تخفيض السعر الخاصة بك. على سبيل المثال، أقوم بتدوين ملاحظاتي مع Obsidian. يقوم النظام بعد ذلك بمعالجة أي تغيير في هذه الملفات تلقائيًا باستخدام المسار التالي:

الرسم البياني TD

A[ملفات تخفيض السعر من المحرر الخاص بك]-->B[ملفات نصية من تخفيض السعر والمؤشرات]-->C[قطع النص]-->D[قاعدة بيانات المتجهات]-->E[عامل الذكاء الاصطناعي للدماغ الثاني]

من ملف تخفيض السعر، يقوم Transform_md.py باستخراج النص من ملف تخفيض السعر، ثم من الروابط الموجودة داخل ملف تخفيض السعر، يقوم باستخراج pdf وurl وفيديو youtube وتحويلها إلى نص. هناك بعض الدعم لاستخراج بيانات السجل من ملفات تخفيض السعر: إذا كان هناك قسم ## History أو كان اسم الملف يحتوي على History ، فسيتم تقسيم الملف إلى أجزاء متعددة وفقًا لأقسام <day> <month> <year> مثل ### 10 Sep 2023 .

من هذه الملفات النصية، يقوم Transform_txt.py بتقسيم هذه الملفات النصية إلى أجزاء، وإنشاء عمليات تضمين المتجهات ثم تخزين عمليات تضمين المتجهات هذه في قاعدة بيانات متجهة.

يستخدم وكيل الدماغ الثاني قاعدة بيانات المتجهات للحصول على سياق لطرح السؤال على نموذج اللغة الكبير. تُسمى هذه العملية بتوليد الاسترجاع المعزز (RAG).

في الواقع، العملية أكثر تعقيدًا من RAG القياسي. يقوم بتحليل السؤال ثم استخدام سلسلة مختلفة وفقًا للقصد:

مخطط انسيابي TD

أ[سؤال] --> ج[/الحصول على النية/]

C --> E[طلب ملخص] --> EA[/استخراج كافة القطع/] --> EB[/تلخيص القطع/]

C --> F[pdf أو بحث URL] --> FA[/استخراج URL/]

ج --> د[تقرير النشاط]

C --> G [سؤال عادي]

D --> DA[/الحصول على بيانات تعريف الفترة/] --> DB[/الحصول على بيانات تعريف الموضوع/] --> DC[/استخراج سؤال بدون وقت/] --> H[/استخراج أقرب المستنداتnمن قاعدة بيانات المتجهات nfiltered بواسطة البيانات الوصفية/]

G --> GA[/Step back question/] --> GB[/استخرج أقرب المستنداتnمن قاعدة بيانات المتجهات/]

H --> I[/ استخدم المستندات كسياقnلطرح السؤال على ماجستير إدارة الأعمال/]

غيغابايت-> أنا

أنت بحاجة إلى مترجم Python 3 poetry inotify-tools مثبتة. تم اختبار كل هذا ضمن نظام Fedora Linux 38 على الكمبيوتر المحمول الخاص بي وأحدث نظام Ubuntu في سير عمل CI. اسمحوا لي أن أعرف إذا كان يعمل على النظام الخاص بك.

احصل على الكود المصدري:

$ git clone https://github.com/flepied/second-brain-agent.gitانسخ ملف .env النموذجي وقم بتحريره ليناسب إعداداتك:

$ cp example.env .envتثبيت التبعيات باستخدام الشعر:

$ poetry installيوجد خطأ بين الشعر والشعلة وpypi، للحل البديل فقط قم بما يلي:

$ poetry run pip install torchثم لاستخدام Virtualenv الذي تم إنشاؤه، قم بما يلي:

$ poetry shellلتثبيت خدمات systemd لإدارة البرامج النصية المختلفة تلقائيًا عند بدء تشغيل نظام التشغيل، استخدم الأمر التالي (بحاجة إلى الوصول إلى sudo):

$ ./install-systemd-services.shلرؤية مخرجات خدمات md وtxt:

$ journalctl --unit=sba-md.service --user

$ journalctl --unit=sba-txt.service --user$ ./similarity.py " What is LangChain? " type=notesاستخدم متجر المتجهات للعثور على اتصالات جديدة بين الملاحظات:

$ ./smart_connections.pyقم بتشغيل هذا الأمر للوصول إلى واجهة مستخدم الويب:

$ streamlit run second_brain_agent.py

You can now view your Streamlit app in your browser.

Local URL: http://localhost:8502

Network URL: http://192.168.121.112:8502هنا مثال:

تثبيت التبعيات الإضافية باستخدام الشعر:

$ poetry install --with testثم قم بإجراء الاختبارات كالتالي:

$ poetry run pytestقبل تقديم طلب العلاقات العامة، تأكد من تفعيل الالتزام المسبق:

poetry run pre-commit install