تنفيذ محول الرؤية، وهو طريقة بسيطة لتحقيق SOTA في تصنيف الرؤية باستخدام مشفر محول واحد فقط، في Pytorch. تم توضيح الأهمية بشكل أكبر في فيديو يانيك كيلشر. لا يوجد الكثير مما يجب ترميزه هنا، ولكن من الأفضل أن نوضحه للجميع حتى نتمكن من تسريع ثورة الاهتمام.

للحصول على تطبيق Pytorch باستخدام نماذج تم تدريبها مسبقًا، يرجى الاطلاع على مستودع Ross Wightman هنا.

مستودع Jax الرسمي موجود هنا.

توجد هنا أيضًا ترجمة Tensorflow2، أنشأها عالم الأبحاث Junho Kim!

ترجمة الكتان بواسطة إنريكو شيبول!

$ pip install vit-pytorch import torch

from vit_pytorch import ViT

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000) image_size : كثافةت.patch_size : كثافة العمليات.image_size قابلاً للقسمة على patch_size .n = (image_size // patch_size) ** 2 و n يجب أن يكون أكبر من 16 .num_classes : int.dim : كثافة العمليات.nn.Linear(..., dim) .depth : كثافة العمليات.heads : كثافة العمليات.mlp_dim : كثافةت.channels : int، الافتراضي 3 .dropout : يطفو بين [0, 1] ، الافتراضي 0. .emb_dropout : يطفو بين [0, 1] ، الافتراضي 0 .pool : سلسلة، إما تجميع رمز cls أو التجميع mean يقترح تحديث من بعض مؤلفي الورقة الأصلية تبسيطات لـ ViT تسمح له بالتدريب بشكل أسرع وأفضل.

ومن بين هذه التبسيطات التضمين الموضعي الجيبي ثنائي الأبعاد، وتجميع المتوسط العالمي (بدون رمز CLS)، وعدم التسرب، وأحجام الدُفعات 1024 بدلاً من 4096، واستخدام زيادات RandAugment وMixUp. لقد أظهروا أيضًا أن الخط الخطي البسيط في النهاية ليس أسوأ بكثير من رأس MLP الأصلي

يمكنك استخدامه عن طريق استيراد SimpleViT كما هو موضح أدناه

import torch

from vit_pytorch import SimpleViT

v = SimpleViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000)

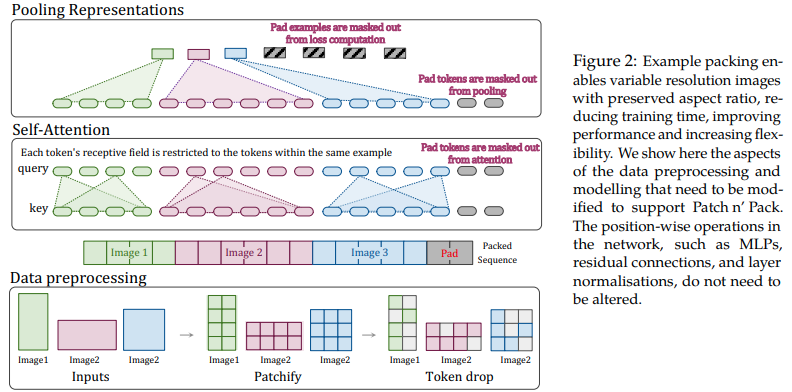

تقترح هذه الورقة الاستفادة من مرونة الانتباه والإخفاء للتسلسلات ذات الطول المتغير لتدريب الصور ذات الدقة المتعددة، والمعبأة في دفعة واحدة. لقد أظهرت تدريبًا أسرع بكثير ودقة محسنة، والتكلفة الوحيدة هي التعقيد الإضافي في البنية وتحميل البيانات. يستخدمون الترميز الموضعي ثنائي الأبعاد، وإسقاط الرمز المميز، بالإضافة إلى تسوية مفتاح الاستعلام.

يمكنك استخدامه على النحو التالي

import torch

from vit_pytorch . na_vit import NaViT

v = NaViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1 ,

token_dropout_prob = 0.1 # token dropout of 10% (keep 90% of tokens)

)

# 5 images of different resolutions - List[List[Tensor]]

# for now, you'll have to correctly place images in same batch element as to not exceed maximum allowed sequence length for self-attention w/ masking

images = [

[ torch . randn ( 3 , 256 , 256 ), torch . randn ( 3 , 128 , 128 )],

[ torch . randn ( 3 , 128 , 256 ), torch . randn ( 3 , 256 , 128 )],

[ torch . randn ( 3 , 64 , 256 )]

]

preds = v ( images ) # (5, 1000) - 5, because 5 images of different resolution aboveأو إذا كنت تفضل أن يقوم إطار العمل تلقائيًا بتجميع الصور في تسلسلات متغيرة الطول لا تتجاوز حدًا أقصى معينًا

images = [

torch . randn ( 3 , 256 , 256 ),

torch . randn ( 3 , 128 , 128 ),

torch . randn ( 3 , 128 , 256 ),

torch . randn ( 3 , 256 , 128 ),

torch . randn ( 3 , 64 , 256 )

]

preds = v (

images ,

group_images = True ,

group_max_seq_len = 64

) # (5, 1000) أخيرًا، إذا كنت ترغب في الاستفادة من نكهة NaViT باستخدام الموترات المتداخلة (والتي ستؤدي إلى حذف الكثير من الأقنعة والحشو تمامًا)، فتأكد من أنك تستخدم الإصدار 2.5 وقم بالاستيراد على النحو التالي

import torch

from vit_pytorch . na_vit_nested_tensor import NaViT

v = NaViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0. ,

emb_dropout = 0. ,

token_dropout_prob = 0.1

)

# 5 images of different resolutions - List[Tensor]

images = [

torch . randn ( 3 , 256 , 256 ), torch . randn ( 3 , 128 , 128 ),

torch . randn ( 3 , 128 , 256 ), torch . randn ( 3 , 256 , 128 ),

torch . randn ( 3 , 64 , 256 )

]

preds = v ( images )

assert preds . shape == ( 5 , 1000 )

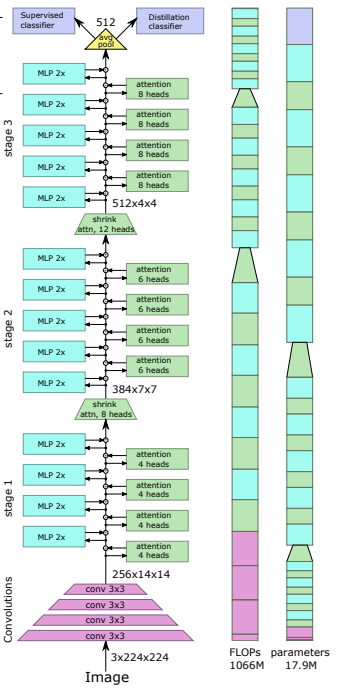

أظهرت ورقة بحثية حديثة أن استخدام رمز التقطير لتقطير المعرفة من الشبكات التلافيفية إلى محولات الرؤية يمكن أن ينتج عنه محولات رؤية صغيرة وفعالة. يوفر هذا المستودع وسيلة للقيام بالتقطير بسهولة.

السابق. التقطير من Resnet50 (أو أي معلم) إلى محول الرؤية

import torch

from torchvision . models import resnet50

from vit_pytorch . distill import DistillableViT , DistillWrapper

teacher = resnet50 ( pretrained = True )

v = DistillableViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

distiller = DistillWrapper (

student = v ,

teacher = teacher ,

temperature = 3 , # temperature of distillation

alpha = 0.5 , # trade between main loss and distillation loss

hard = False # whether to use soft or hard distillation

)

img = torch . randn ( 2 , 3 , 256 , 256 )

labels = torch . randint ( 0 , 1000 , ( 2 ,))

loss = distiller ( img , labels )

loss . backward ()

# after lots of training above ...

pred = v ( img ) # (2, 1000) تتطابق فئة DistillableViT مع فئة ViT باستثناء كيفية التعامل مع التمرير الأمامي، لذلك يجب أن تكون قادرًا على تحميل المعلمات مرة أخرى إلى ViT بعد الانتهاء من التدريب على التقطير.

يمكنك أيضًا استخدام طريقة .to_vit سهلة الاستخدام على مثيل DistillableViT لاستعادة مثيل ViT .

v = v . to_vit ()

type ( v ) # <class 'vit_pytorch.vit_pytorch.ViT'> تشير هذه الورقة إلى أن ViT يكافح للوصول إلى أعماق أكبر (ما يزيد عن 12 طبقة)، ويقترح خلط انتباه كل رأس بعد سوفت ماكس كحل، يُطلق عليه اسم "إعادة الانتباه". تتوافق النتائج مع ورقة Talking Heads من البرمجة اللغوية العصبية.

يمكنك استخدامه على النحو التالي

import torch

from vit_pytorch . deepvit import DeepViT

v = DeepViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000) تشير هذه الورقة أيضًا إلى صعوبة تدريب محولات الرؤية على أعماق أكبر وتقترح حلين. يقترح أولاً القيام بضرب مخرجات الكتلة المتبقية لكل قناة. ثانيًا، يقترح أن تعتني التصحيحات ببعضها البعض، وتسمح فقط لرمز CLS بحضور التصحيحات في الطبقات القليلة الأخيرة.

يضيفون أيضًا Talking Heads، مع ملاحظة التحسينات

يمكنك استخدام هذا المخطط على النحو التالي

import torch

from vit_pytorch . cait import CaiT

v = CaiT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 12 , # depth of transformer for patch to patch attention only

cls_depth = 2 , # depth of cross attention of CLS tokens to patch

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1 ,

layer_dropout = 0.05 # randomly dropout 5% of the layers

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000)

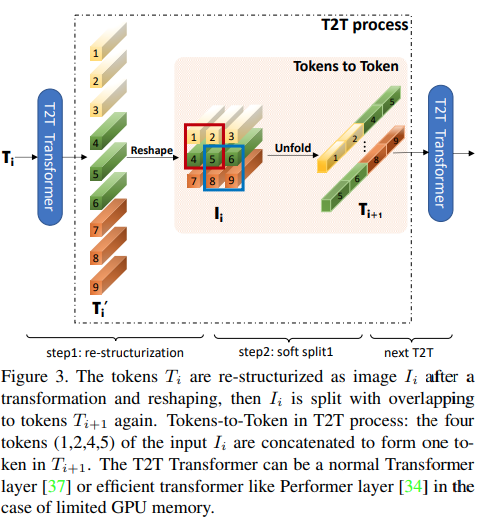

تقترح هذه الورقة أن الطبقات الزوجية الأولى يجب أن تقوم باختزال تسلسل الصورة عن طريق الكشف، مما يؤدي إلى تداخل بيانات الصورة في كل رمز مميز كما هو موضح في الشكل أعلاه. يمكنك استخدام هذا البديل من ViT على النحو التالي.

import torch

from vit_pytorch . t2t import T2TViT

v = T2TViT (

dim = 512 ,

image_size = 224 ,

depth = 5 ,

heads = 8 ,

mlp_dim = 512 ,

num_classes = 1000 ,

t2t_layers = (( 7 , 4 ), ( 3 , 2 ), ( 3 , 2 )) # tuples of the kernel size and stride of each consecutive layers of the initial token to token module

)

img = torch . randn ( 1 , 3 , 224 , 224 )

preds = v ( img ) # (1, 1000) يقترح CCT محولات مدمجة باستخدام التلافيف بدلاً من الترقيع وتنفيذ تجميع التسلسل. وهذا يسمح لـ CCT بالحصول على دقة عالية وعدد منخفض من المعلمات.

يمكنك استخدام هذا بطريقتين

import torch

from vit_pytorch . cct import CCT

cct = CCT (

img_size = ( 224 , 448 ),

embedding_dim = 384 ,

n_conv_layers = 2 ,

kernel_size = 7 ,

stride = 2 ,

padding = 3 ,

pooling_kernel_size = 3 ,

pooling_stride = 2 ,

pooling_padding = 1 ,

num_layers = 14 ,

num_heads = 6 ,

mlp_ratio = 3. ,

num_classes = 1000 ,

positional_embedding = 'learnable' , # ['sine', 'learnable', 'none']

)

img = torch . randn ( 1 , 3 , 224 , 448 )

pred = cct ( img ) # (1, 1000) بدلاً من ذلك، يمكنك استخدام أحد النماذج المحددة مسبقًا [2,4,6,7,8,14,16] والتي تحدد مسبقًا عدد الطبقات وعدد رؤوس الانتباه ونسبة mlp وبُعد التضمين.

import torch

from vit_pytorch . cct import cct_14

cct = cct_14 (

img_size = 224 ,

n_conv_layers = 1 ,

kernel_size = 7 ,

stride = 2 ,

padding = 3 ,

pooling_kernel_size = 3 ,

pooling_stride = 2 ,

pooling_padding = 1 ,

num_classes = 1000 ,

positional_embedding = 'learnable' , # ['sine', 'learnable', 'none']

)يتضمن المستودع الرسمي روابط لنقاط التفتيش النموذجية المدربة مسبقًا.

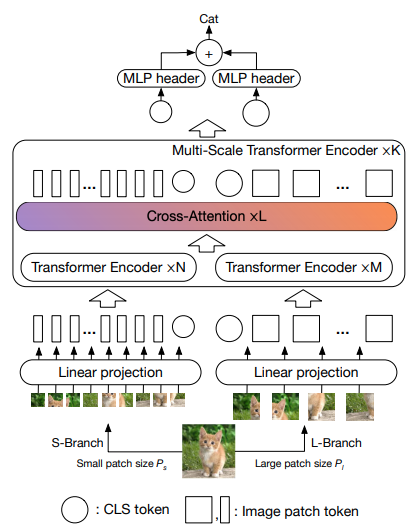

تقترح هذه الورقة أن يكون هناك محولان للرؤية يعالجان الصورة بمقاييس مختلفة، ويتقاطعان مع أحدهما بين الحين والآخر. أنها تظهر تحسينات على رأس محول الرؤية الأساسي.

import torch

from vit_pytorch . cross_vit import CrossViT

v = CrossViT (

image_size = 256 ,

num_classes = 1000 ,

depth = 4 , # number of multi-scale encoding blocks

sm_dim = 192 , # high res dimension

sm_patch_size = 16 , # high res patch size (should be smaller than lg_patch_size)

sm_enc_depth = 2 , # high res depth

sm_enc_heads = 8 , # high res heads

sm_enc_mlp_dim = 2048 , # high res feedforward dimension

lg_dim = 384 , # low res dimension

lg_patch_size = 64 , # low res patch size

lg_enc_depth = 3 , # low res depth

lg_enc_heads = 8 , # low res heads

lg_enc_mlp_dim = 2048 , # low res feedforward dimensions

cross_attn_depth = 2 , # cross attention rounds

cross_attn_heads = 8 , # cross attention heads

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 256 )

pred = v ( img ) # (1, 1000)

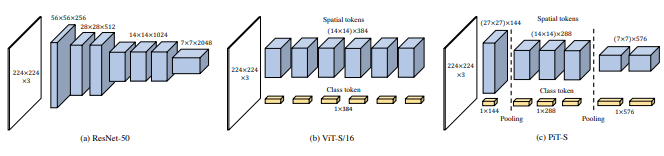

تقترح هذه الورقة اختزال الرموز المميزة من خلال إجراء التجميع باستخدام التلافيفات العميقة.

import torch

from vit_pytorch . pit import PiT

v = PiT (

image_size = 224 ,

patch_size = 14 ,

dim = 256 ,

num_classes = 1000 ,

depth = ( 3 , 3 , 3 ), # list of depths, indicating the number of rounds of each stage before a downsample

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

# forward pass now returns predictions and the attention maps

img = torch . randn ( 1 , 3 , 224 , 224 )

preds = v ( img ) # (1, 1000)

تقترح هذه الورقة عددًا من التغييرات، بما في ذلك (1) التضمين التلافيفي بدلاً من الإسقاط التصحيحي (2) الاختزال على مراحل (3) عدم الخطية الإضافية في الانتباه (4) التحيزات الموضعية النسبية ثنائية الأبعاد بدلاً من التحيز الموضعي المطلق الأولي (5) ) Batchnorm بدلا من Layernorm.

المستودع الرسمي

import torch

from vit_pytorch . levit import LeViT

levit = LeViT (

image_size = 224 ,

num_classes = 1000 ,

stages = 3 , # number of stages

dim = ( 256 , 384 , 512 ), # dimensions at each stage

depth = 4 , # transformer of depth 4 at each stage

heads = ( 4 , 6 , 8 ), # heads at each stage

mlp_mult = 2 ,

dropout = 0.1

)

img = torch . randn ( 1 , 3 , 224 , 224 )

levit ( img ) # (1, 1000)

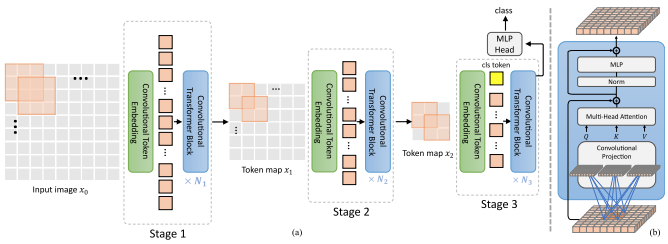

تقترح هذه الورقة خلط التلافيف والاهتمام. على وجه التحديد، تُستخدم التلافيفات لتضمين واختزال خريطة الصورة/الميزات في ثلاث مراحل. يتم أيضًا استخدام الالتفاف العميق لعرض الاستعلامات والمفاتيح والقيم التي تستحق الاهتمام.

import torch

from vit_pytorch . cvt import CvT

v = CvT (

num_classes = 1000 ,

s1_emb_dim = 64 , # stage 1 - dimension

s1_emb_kernel = 7 , # stage 1 - conv kernel

s1_emb_stride = 4 , # stage 1 - conv stride

s1_proj_kernel = 3 , # stage 1 - attention ds-conv kernel size

s1_kv_proj_stride = 2 , # stage 1 - attention key / value projection stride

s1_heads = 1 , # stage 1 - heads

s1_depth = 1 , # stage 1 - depth

s1_mlp_mult = 4 , # stage 1 - feedforward expansion factor

s2_emb_dim = 192 , # stage 2 - (same as above)

s2_emb_kernel = 3 ,

s2_emb_stride = 2 ,

s2_proj_kernel = 3 ,

s2_kv_proj_stride = 2 ,

s2_heads = 3 ,

s2_depth = 2 ,

s2_mlp_mult = 4 ,

s3_emb_dim = 384 , # stage 3 - (same as above)

s3_emb_kernel = 3 ,

s3_emb_stride = 2 ,

s3_proj_kernel = 3 ,

s3_kv_proj_stride = 2 ,

s3_heads = 4 ,

s3_depth = 10 ,

s3_mlp_mult = 4 ,

dropout = 0.

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = v ( img ) # (1, 1000)

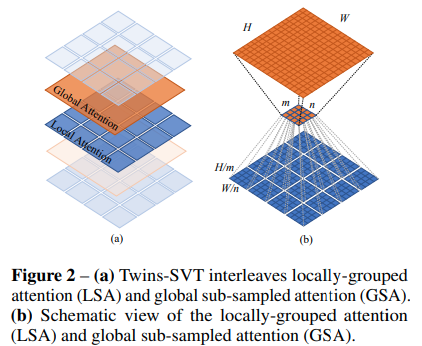

تقترح هذه الورقة الجمع بين الاهتمام المحلي والعالمي، جنبًا إلى جنب مع مولد تشفير الموضع (المقترح في CPVT) وتجميع المتوسط العالمي، لتحقيق نفس النتائج مثل Swin، دون التعقيد الإضافي للنوافذ المتغيرة، أو رموز CLS، أو التضمينات الموضعية.

import torch

from vit_pytorch . twins_svt import TwinsSVT

model = TwinsSVT (

num_classes = 1000 , # number of output classes

s1_emb_dim = 64 , # stage 1 - patch embedding projected dimension

s1_patch_size = 4 , # stage 1 - patch size for patch embedding

s1_local_patch_size = 7 , # stage 1 - patch size for local attention

s1_global_k = 7 , # stage 1 - global attention key / value reduction factor, defaults to 7 as specified in paper

s1_depth = 1 , # stage 1 - number of transformer blocks (local attn -> ff -> global attn -> ff)

s2_emb_dim = 128 , # stage 2 (same as above)

s2_patch_size = 2 ,

s2_local_patch_size = 7 ,

s2_global_k = 7 ,

s2_depth = 1 ,

s3_emb_dim = 256 , # stage 3 (same as above)

s3_patch_size = 2 ,

s3_local_patch_size = 7 ,

s3_global_k = 7 ,

s3_depth = 5 ,

s4_emb_dim = 512 , # stage 4 (same as above)

s4_patch_size = 2 ,

s4_local_patch_size = 7 ,

s4_global_k = 7 ,

s4_depth = 4 ,

peg_kernel_size = 3 , # positional encoding generator kernel size

dropout = 0. # dropout

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = model ( img ) # (1, 1000)

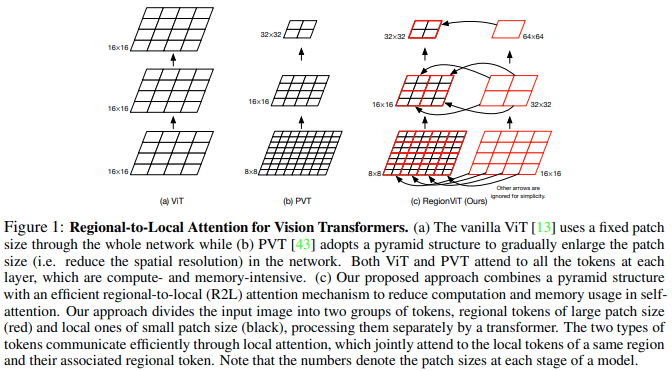

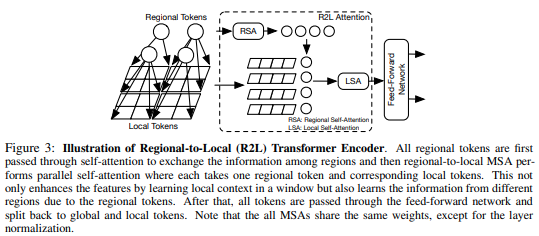

تقترح هذه الورقة تقسيم خريطة المعالم إلى مناطق محلية، حيث تتفاعل الرموز المحلية مع بعضها البعض. كل منطقة محلية لديها رمزها الإقليمي الخاص الذي يتولى بعد ذلك التعامل مع جميع الرموز المحلية الخاصة بها، بالإضافة إلى الرموز الإقليمية الأخرى.

يمكنك استخدامه على النحو التالي

import torch

from vit_pytorch . regionvit import RegionViT

model = RegionViT (

dim = ( 64 , 128 , 256 , 512 ), # tuple of size 4, indicating dimension at each stage

depth = ( 2 , 2 , 8 , 2 ), # depth of the region to local transformer at each stage

window_size = 7 , # window size, which should be either 7 or 14

num_classes = 1000 , # number of output classes

tokenize_local_3_conv = False , # whether to use a 3 layer convolution to encode the local tokens from the image. the paper uses this for the smaller models, but uses only 1 conv (set to False) for the larger models

use_peg = False , # whether to use positional generating module. they used this for object detection for a boost in performance

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = model ( img ) # (1, 1000)

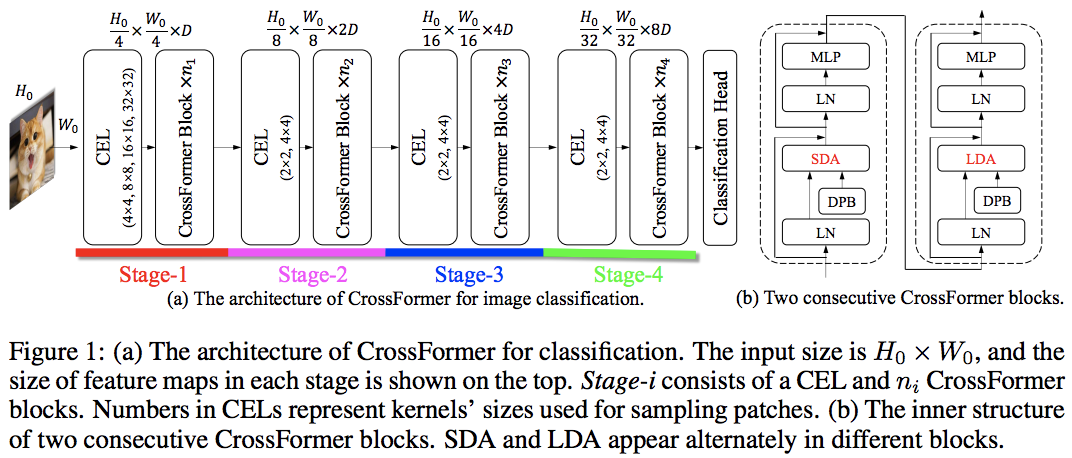

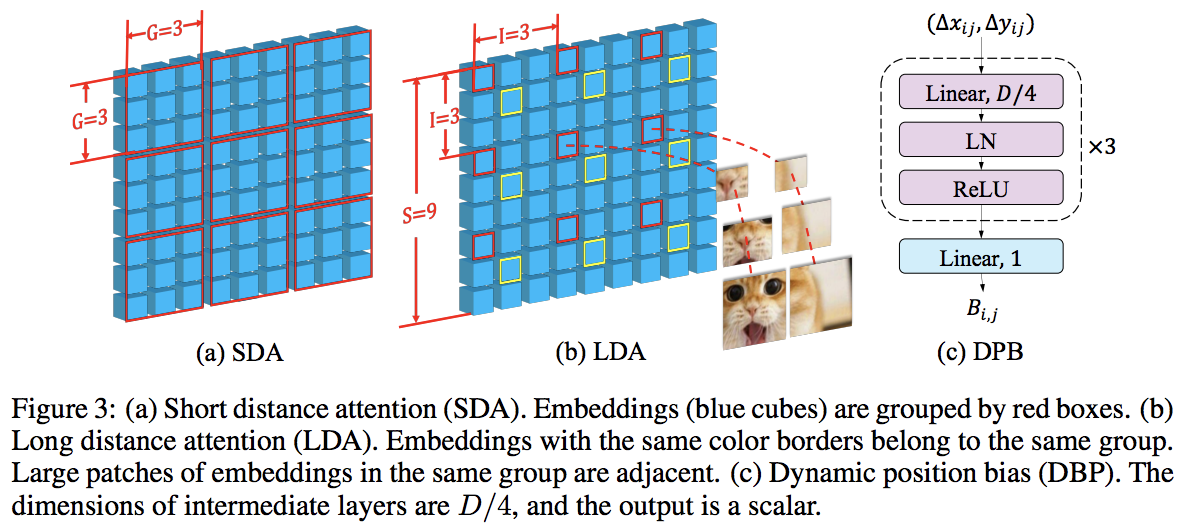

تتفوق هذه الورقة على PVT وSwin باستخدام الاهتمام المحلي والعالمي المتناوب. يتم الاهتمام العالمي عبر بُعد النوافذ لتقليل التعقيد، تمامًا مثل المخطط المستخدم للانتباه المحوري.

لديهم أيضًا طبقة تضمين واسعة النطاق، والتي أظهروا أنها طبقة عامة يمكنها تحسين جميع محولات الرؤية. تمت أيضًا صياغة التحيز الموضعي النسبي الديناميكي للسماح للشبكة بتعميم الصور ذات الدقة الأكبر.

import torch

from vit_pytorch . crossformer import CrossFormer

model = CrossFormer (

num_classes = 1000 , # number of output classes

dim = ( 64 , 128 , 256 , 512 ), # dimension at each stage

depth = ( 2 , 2 , 8 , 2 ), # depth of transformer at each stage

global_window_size = ( 8 , 4 , 2 , 1 ), # global window sizes at each stage

local_window_size = 7 , # local window size (can be customized for each stage, but in paper, held constant at 7 for all stages)

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = model ( img ) # (1, 1000)

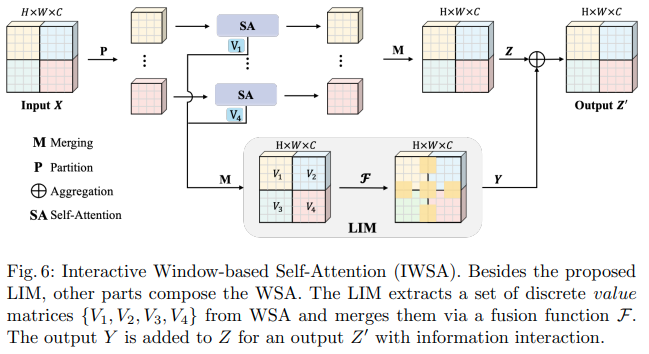

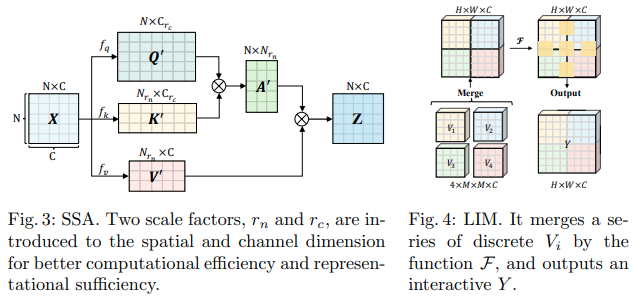

تقترح ورقة Bytedance AI هذه وحدات الانتباه الذاتي القابلة للتطوير (SSA) ووحدات الانتباه الذاتي التفاعلية (IWSA). يخفف SSA من العمليات الحسابية المطلوبة في المراحل المبكرة عن طريق تقليل خريطة ميزات المفتاح/القيمة بواسطة بعض العوامل ( reduction_factor )، مع تعديل أبعاد الاستعلامات والمفاتيح ( ssa_dim_key ). يقوم IWSA بالاهتمام الذاتي داخل النوافذ المحلية، على غرار أوراق محولات الرؤية الأخرى. ومع ذلك، فإنهم يضيفون القيم المتبقية، التي تم تمريرها عبر مجموعة من حجم النواة 3، والتي أطلقوا عليها اسم الوحدة التفاعلية المحلية (LIM).

إنهم يزعمون في هذه الورقة أن هذا المخطط يتفوق في الأداء على Swin Transformer، ويظهر أيضًا أداءً تنافسيًا ضد Crossformer.

يمكنك استخدامه على النحو التالي (على سبيل المثال ScalableViT-S)

import torch

from vit_pytorch . scalable_vit import ScalableViT

model = ScalableViT (

num_classes = 1000 ,

dim = 64 , # starting model dimension. at every stage, dimension is doubled

heads = ( 2 , 4 , 8 , 16 ), # number of attention heads at each stage

depth = ( 2 , 2 , 20 , 2 ), # number of transformer blocks at each stage

ssa_dim_key = ( 40 , 40 , 40 , 32 ), # the dimension of the attention keys (and queries) for SSA. in the paper, they represented this as a scale factor on the base dimension per key (ssa_dim_key / dim_key)

reduction_factor = ( 8 , 4 , 2 , 1 ), # downsampling of the key / values in SSA. in the paper, this was represented as (reduction_factor ** -2)

window_size = ( 64 , 32 , None , None ), # window size of the IWSA at each stage. None means no windowing needed

dropout = 0.1 , # attention and feedforward dropout

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = model ( img ) # (1, 1000)

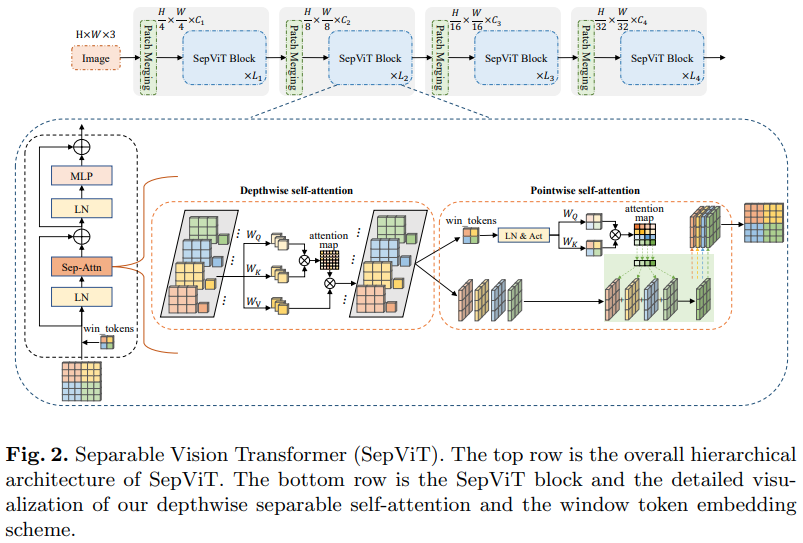

ورقة بحثية أخرى من Bytedance للذكاء الاصطناعي، تقترح طبقة اهتمام ذاتي ذات عمق ونقطة تبدو مستوحاة إلى حد كبير من الالتفاف القابل للفصل بعمق للهاتف المحمول. الجانب الأكثر إثارة للاهتمام هو إعادة استخدام خريطة الميزات من مرحلة الاهتمام الذاتي العميق كقيم للانتباه الذاتي النقطي، كما هو موضح في الرسم البياني أعلاه.

لقد قررت تضمين إصدار SepViT فقط مع طبقة الاهتمام الذاتي المحددة هذه، نظرًا لأن طبقات الاهتمام المجمعة ليست رائعة ولا جديدة، ولم يكن المؤلفون واضحين بشأن كيفية تعاملهم مع رموز النافذة لطبقة الاهتمام الذاتي الجماعية. علاوة على ذلك، يبدو أنه باستخدام طبقة DSSA وحدها، تمكنوا من التغلب على Swin.

السابق. SepViT لايت

import torch

from vit_pytorch . sep_vit import SepViT

v = SepViT (

num_classes = 1000 ,

dim = 32 , # dimensions of first stage, which doubles every stage (32, 64, 128, 256) for SepViT-Lite

dim_head = 32 , # attention head dimension

heads = ( 1 , 2 , 4 , 8 ), # number of heads per stage

depth = ( 1 , 2 , 6 , 2 ), # number of transformer blocks per stage

window_size = 7 , # window size of DSS Attention block

dropout = 0.1 # dropout

)

img = torch . randn ( 1 , 3 , 224 , 224 )

preds = v ( img ) # (1, 1000)

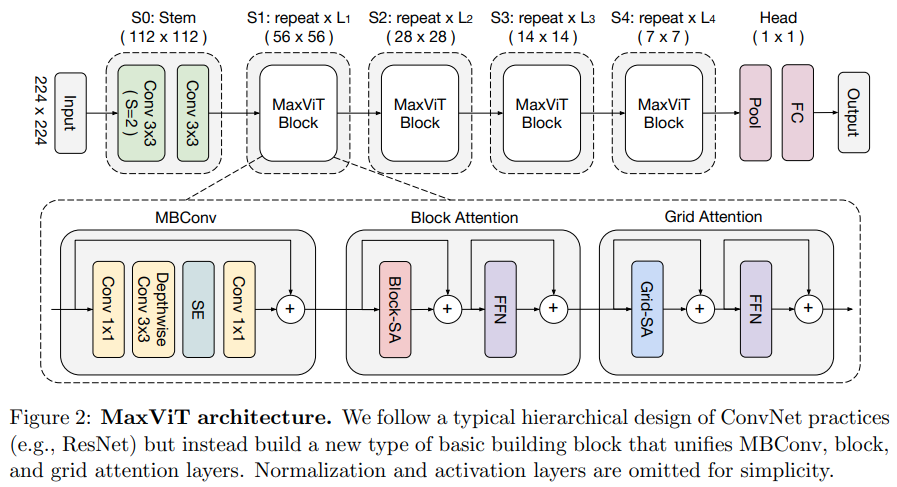

تقترح هذه الورقة شبكة تلافيفية/انتباه هجينة، باستخدام MBConv من الجانب التلافيفي، ومن ثم كتلة/شبكة الاهتمام المحوري المتناثر.

يزعمون أيضًا أن محول الرؤية المحدد هذا مفيد للنماذج التوليدية (GANs).

السابق. ماكسفيت-S

import torch

from vit_pytorch . max_vit import MaxViT

v = MaxViT (

num_classes = 1000 ,

dim_conv_stem = 64 , # dimension of the convolutional stem, would default to dimension of first layer if not specified

dim = 96 , # dimension of first layer, doubles every layer

dim_head = 32 , # dimension of attention heads, kept at 32 in paper

depth = ( 2 , 2 , 5 , 2 ), # number of MaxViT blocks per stage, which consists of MBConv, block-like attention, grid-like attention

window_size = 7 , # window size for block and grids

mbconv_expansion_rate = 4 , # expansion rate of MBConv

mbconv_shrinkage_rate = 0.25 , # shrinkage rate of squeeze-excitation in MBConv

dropout = 0.1 # dropout

)

img = torch . randn ( 2 , 3 , 224 , 224 )

preds = v ( img ) # (2, 1000)

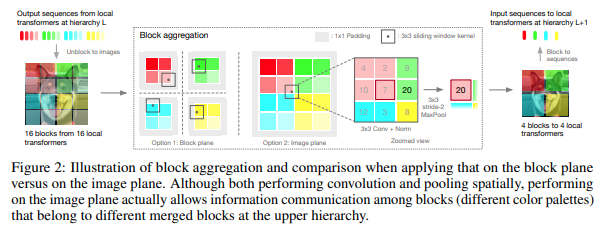

قررت هذه الورقة معالجة الصورة في مراحل هرمية، مع الاهتمام فقط برموز الكتل المحلية، والتي تتجمع أثناء تحركها إلى أعلى التسلسل الهرمي. يتم التجميع في مستوى الصورة، ويحتوي على التفاف وmaxpool لاحق للسماح لها بتمرير المعلومات عبر الحدود.

يمكنك استخدامه مع الكود التالي (مثال: NesT-T)

import torch

from vit_pytorch . nest import NesT

nest = NesT (

image_size = 224 ,

patch_size = 4 ,

dim = 96 ,

heads = 3 ,

num_hierarchies = 3 , # number of hierarchies

block_repeats = ( 2 , 2 , 8 ), # the number of transformer blocks at each hierarchy, starting from the bottom

num_classes = 1000

)

img = torch . randn ( 1 , 3 , 224 , 224 )

pred = nest ( img ) # (1, 1000)

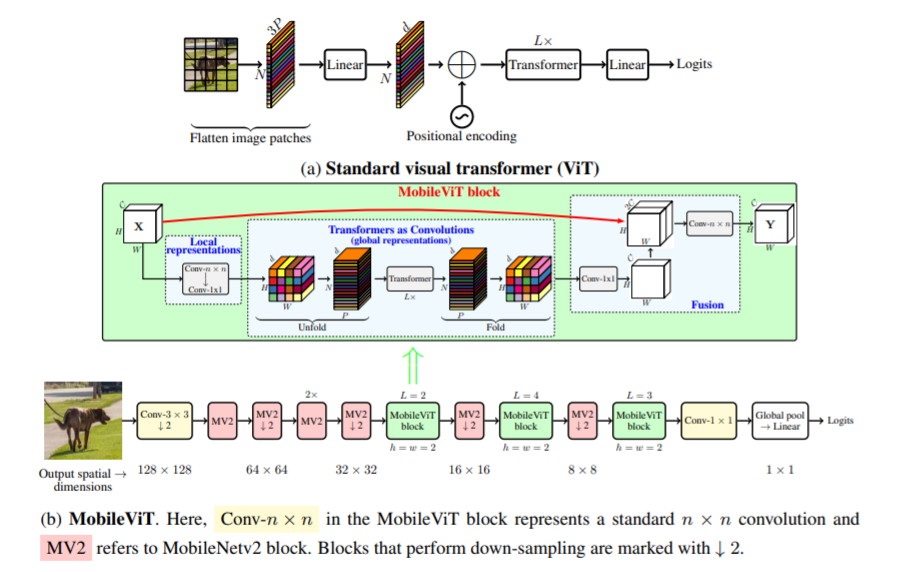

تقدم هذه الورقة MobileViT، وهو محول رؤية خفيف الوزن للأغراض العامة للأجهزة المحمولة. يقدم MobileViT منظورًا مختلفًا للمعالجة العالمية للمعلومات باستخدام المحولات.

يمكنك استخدامه مع الكود التالي (مثال: mobilevit_xs)

import torch

from vit_pytorch . mobile_vit import MobileViT

mbvit_xs = MobileViT (

image_size = ( 256 , 256 ),

dims = [ 96 , 120 , 144 ],

channels = [ 16 , 32 , 48 , 48 , 64 , 64 , 80 , 80 , 96 , 96 , 384 ],

num_classes = 1000

)

img = torch . randn ( 1 , 3 , 256 , 256 )

pred = mbvit_xs ( img ) # (1, 1000)

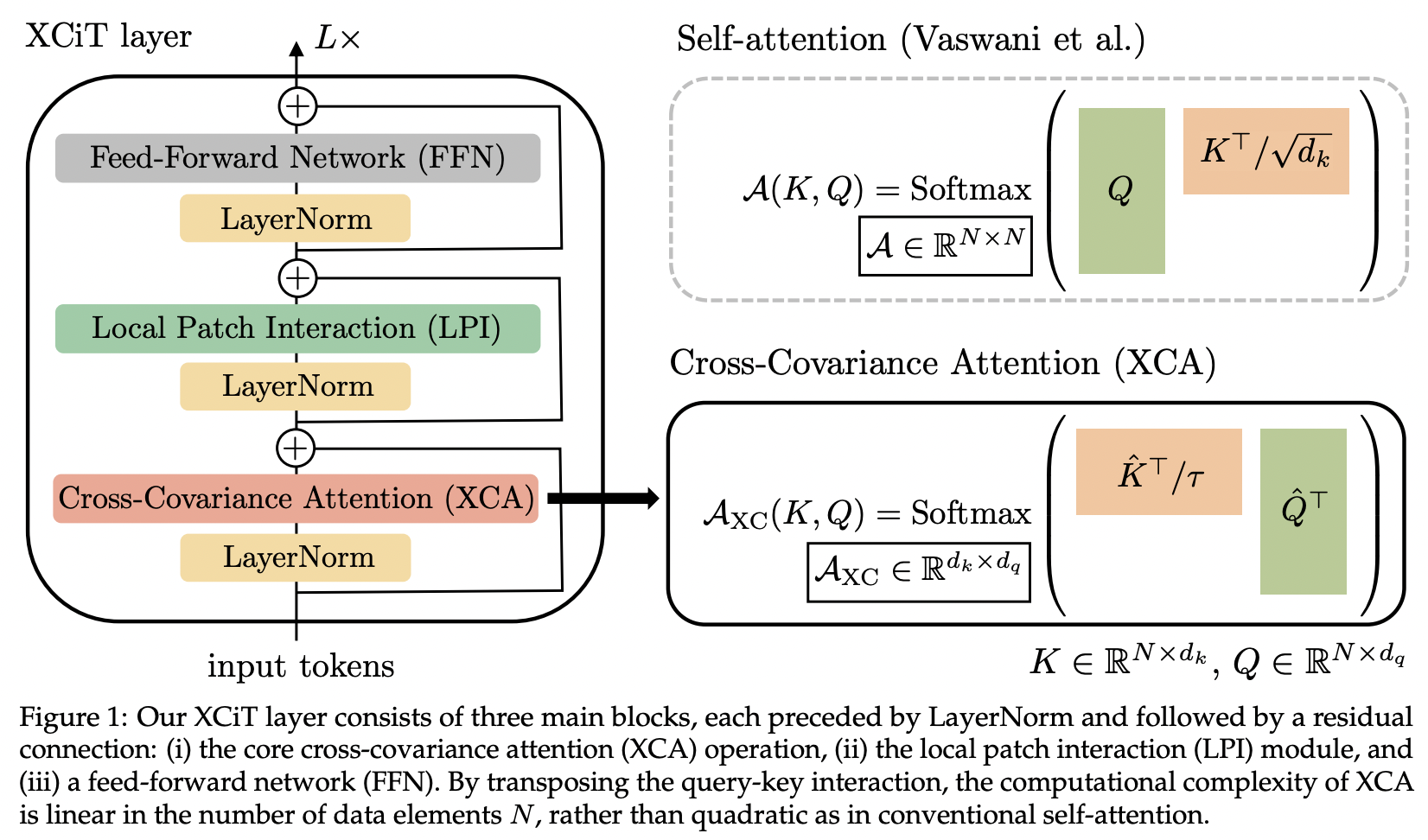

تقدم هذه الورقة اهتمام التغاير المتقاطع (المختصر XCA). يمكن للمرء أن يفكر في الأمر على أنه جذب الانتباه عبر بُعد الميزات بدلاً من البعد المكاني (المنظور الآخر سيكون عبارة عن التفاف ديناميكي 1 × 1، حيث تكون النواة عبارة عن خريطة انتباه محددة بواسطة الارتباطات المكانية).

من الناحية الفنية، يؤدي هذا إلى مجرد نقل الاستعلام والمفتاح والقيم قبل تنفيذ انتباه تشابه جيب التمام مع درجة الحرارة المستفادة.

import torch

from vit_pytorch . xcit import XCiT

v = XCiT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 12 , # depth of xcit transformer

cls_depth = 2 , # depth of cross attention of CLS tokens to patch, attention pool at end

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1 ,

layer_dropout = 0.05 , # randomly dropout 5% of the layers

local_patch_kernel_size = 3 # kernel size of the local patch interaction module (depthwise convs)

)

img = torch . randn ( 1 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000)

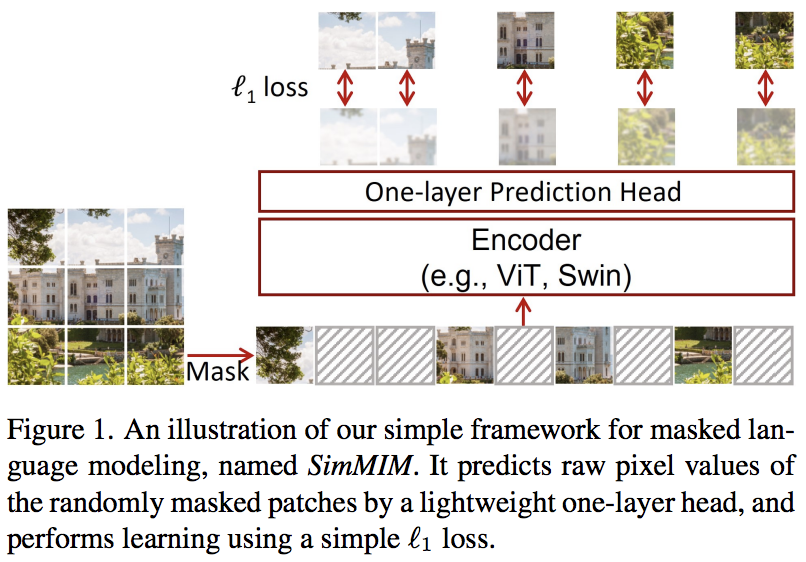

تقترح هذه الورقة مخططًا بسيطًا لنمذجة الصورة المقنعة (SimMIM)، باستخدام إسقاط خطي فقط من الرموز المقنعة في مساحة البكسل متبوعًا بخسارة L1 مع قيم البكسل للبقع المقنعة. النتائج تنافسية مع الأساليب الأخرى الأكثر تعقيدًا.

يمكنك استخدام هذا على النحو التالي

import torch

from vit_pytorch import ViT

from vit_pytorch . simmim import SimMIM

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048

)

mim = SimMIM (

encoder = v ,

masking_ratio = 0.5 # they found 50% to yield the best results

)

images = torch . randn ( 8 , 3 , 256 , 256 )

loss = mim ( images )

loss . backward ()

# that's all!

# do the above in a for loop many times with a lot of images and your vision transformer will learn

torch . save ( v . state_dict (), './trained-vit.pt' )

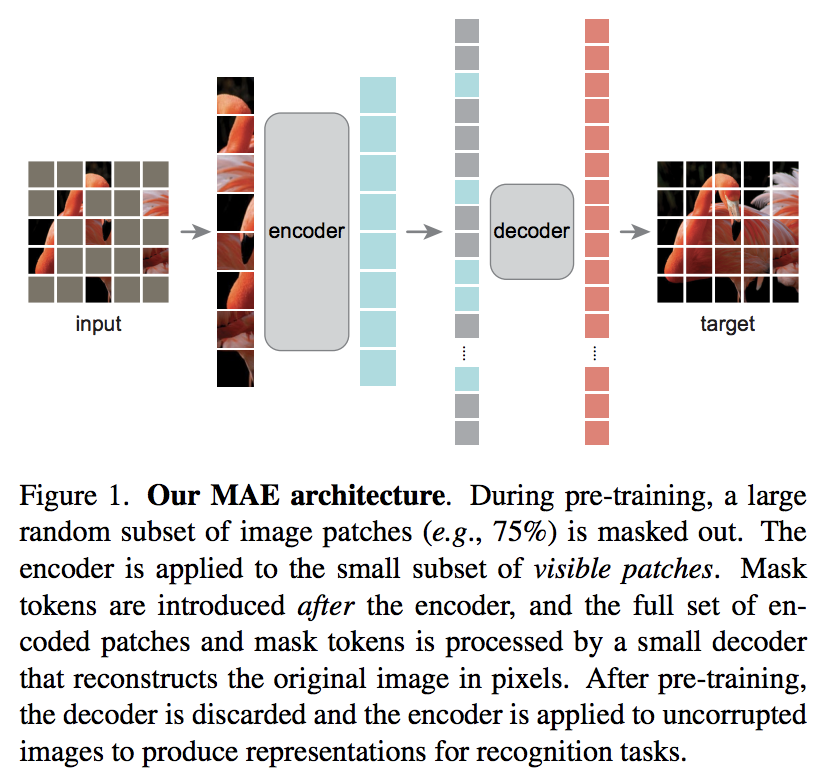

تقترح ورقة بحثية جديدة من Kaiming He مخططًا بسيطًا للتشفير التلقائي حيث يعتني محول الرؤية بمجموعة من التصحيحات غير المقنعة، ويحاول جهاز فك ترميز أصغر إعادة بناء قيم البكسل المقنعة.

مراجعة سريعة للورقة من DeepReader

استراحة القهوة بالذكاء الاصطناعي مع ليتيتيا

يمكنك استخدامه مع الكود التالي

import torch

from vit_pytorch import ViT , MAE

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048

)

mae = MAE (

encoder = v ,

masking_ratio = 0.75 , # the paper recommended 75% masked patches

decoder_dim = 512 , # paper showed good results with just 512

decoder_depth = 6 # anywhere from 1 to 8

)

images = torch . randn ( 8 , 3 , 256 , 256 )

loss = mae ( images )

loss . backward ()

# that's all!

# do the above in a for loop many times with a lot of images and your vision transformer will learn

# save your improved vision transformer

torch . save ( v . state_dict (), './trained-vit.pt' )بفضل Zach، يمكنك التدريب باستخدام مهمة التنبؤ بالتصحيح المقنع الأصلية المقدمة في الورقة، باستخدام الكود التالي.

import torch

from vit_pytorch import ViT

from vit_pytorch . mpp import MPP

model = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

mpp_trainer = MPP (

transformer = model ,

patch_size = 32 ,

dim = 1024 ,

mask_prob = 0.15 , # probability of using token in masked prediction task

random_patch_prob = 0.30 , # probability of randomly replacing a token being used for mpp

replace_prob = 0.50 , # probability of replacing a token being used for mpp with the mask token

)

opt = torch . optim . Adam ( mpp_trainer . parameters (), lr = 3e-4 )

def sample_unlabelled_images ():

return torch . FloatTensor ( 20 , 3 , 256 , 256 ). uniform_ ( 0. , 1. )

for _ in range ( 100 ):

images = sample_unlabelled_images ()

loss = mpp_trainer ( images )

opt . zero_grad ()

loss . backward ()

opt . step ()

# save your improved network

torch . save ( model . state_dict (), './pretrained-net.pt' )

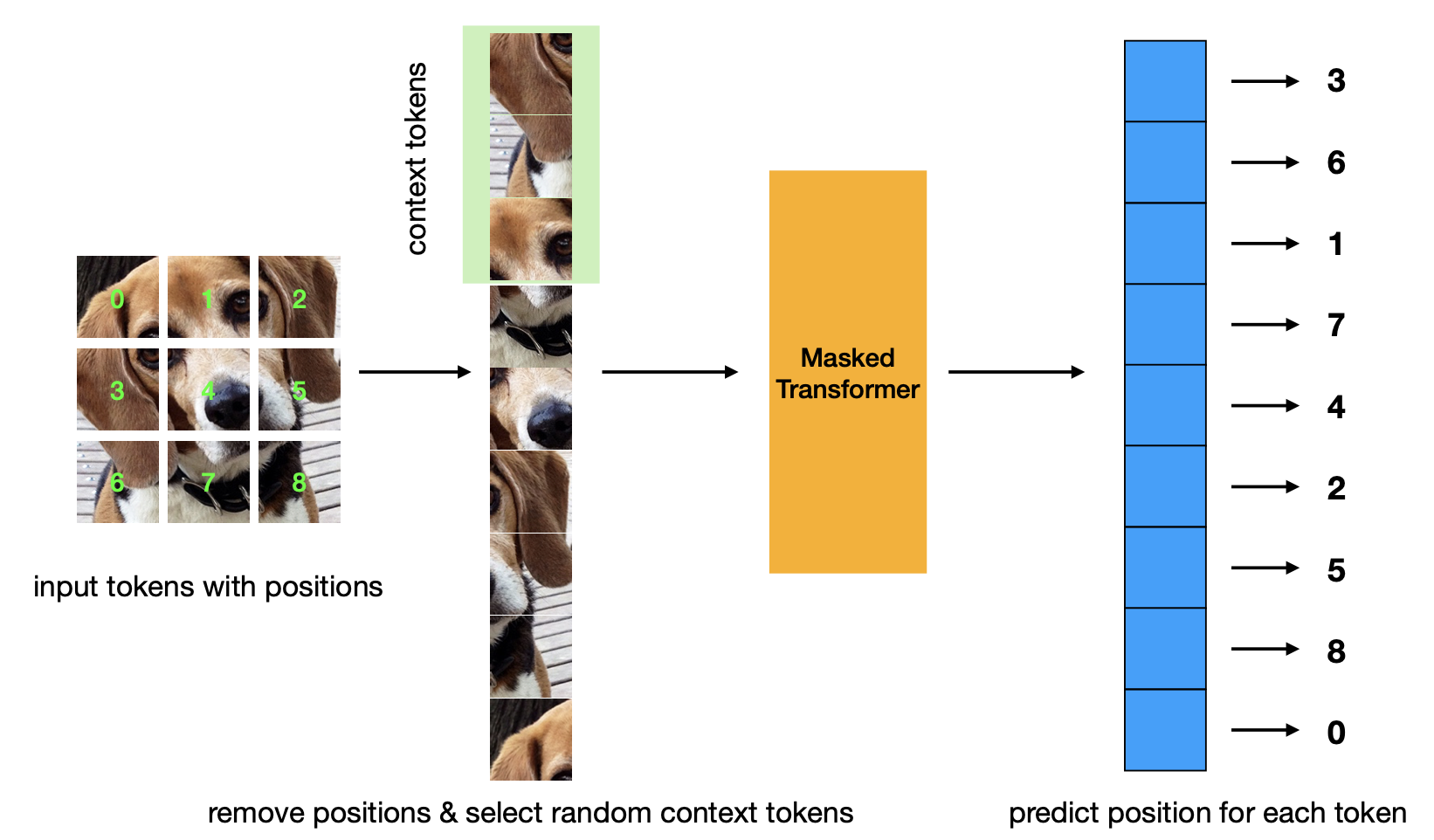

ورقة جديدة تقدم معايير التدريب المسبق للتنبؤ بالموقف المقنع. تعتبر هذه الإستراتيجية أكثر كفاءة من إستراتيجية Masked Autoencoder ولها أداء مماثل.

import torch

from vit_pytorch . mp3 import ViT , MP3

v = ViT (

num_classes = 1000 ,

image_size = 256 ,

patch_size = 8 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

)

mp3 = MP3 (

vit = v ,

masking_ratio = 0.75

)

images = torch . randn ( 8 , 3 , 256 , 256 )

loss = mp3 ( images )

loss . backward ()

# that's all!

# do the above in a for loop many times with a lot of images and your vision transformer will learn

# save your improved vision transformer

torch . save ( v . state_dict (), './trained-vit.pt' )

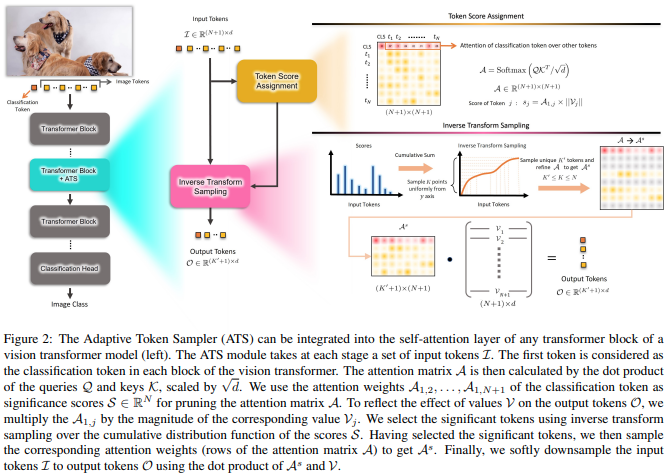

تقترح هذه الورقة استخدام درجات انتباه CLS، التي أعيد وزنها وفقًا لمعايير رؤوس القيمة، كوسيلة للتخلص من الرموز غير المهمة في طبقات مختلفة.

import torch

from vit_pytorch . ats_vit import ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

max_tokens_per_depth = ( 256 , 128 , 64 , 32 , 16 , 8 ), # a tuple that denotes the maximum number of tokens that any given layer should have. if the layer has greater than this amount, it will undergo adaptive token sampling

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

preds = v ( img ) # (4, 1000)

# you can also get a list of the final sampled patch ids

# a value of -1 denotes padding

preds , token_ids = v ( img , return_sampled_token_ids = True ) # (4, 1000), (4, <=8)

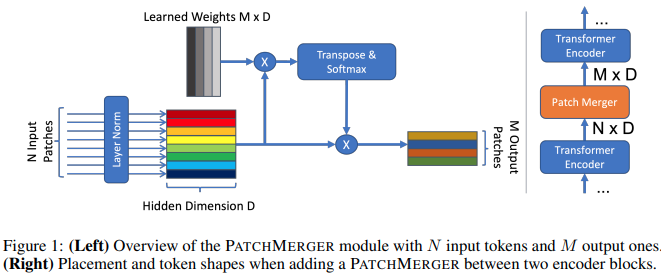

تقترح هذه الورقة وحدة بسيطة (Patch Merger) لتقليل عدد الرموز المميزة في أي طبقة من محولات الرؤية دون التضحية بالأداء.

import torch

from vit_pytorch . vit_with_patch_merger import ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 12 ,

heads = 8 ,

patch_merge_layer = 6 , # at which transformer layer to do patch merging

patch_merge_num_tokens = 8 , # the output number of tokens from the patch merge

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

preds = v ( img ) # (4, 1000) يمكن للمرء أيضًا استخدام وحدة PatchMerger بمفردها

import torch

from vit_pytorch . vit_with_patch_merger import PatchMerger

merger = PatchMerger (

dim = 1024 ,

num_tokens_out = 8 # output number of tokens

)

features = torch . randn ( 4 , 256 , 1024 ) # (batch, num tokens, dimension)

out = merger ( features ) # (4, 8, 1024)

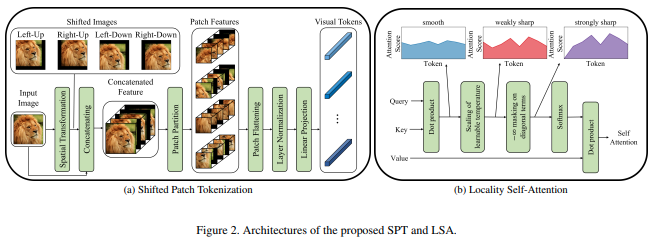

تقترح هذه الورقة صورة جديدة لوظيفة التصحيح التي تتضمن تحولات في الصورة، قبل تطبيع الصورة وتقسيمها إلى تصحيحات. لقد وجدت أن التحويل مفيد للغاية في بعض أعمال المحولات الأخرى، لذلك قررت تضمين هذا لمزيد من الاستكشافات. ويتضمن أيضًا LSA مع درجة الحرارة التي تم تعلمها وإخفاء انتباه الرمز المميز لنفسه.

يمكنك استخدامها على النحو التالي:

import torch

from vit_pytorch . vit_for_small_dataset import ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

preds = v ( img ) # (1, 1000) يمكنك أيضًا استخدام SPT من هذه الورقة كوحدة مستقلة

import torch

from vit_pytorch . vit_for_small_dataset import SPT

spt = SPT (

dim = 1024 ,

patch_size = 16 ,

channels = 3

)

img = torch . randn ( 4 , 3 , 256 , 256 )

tokens = spt ( img ) # (4, 256, 1024) بناءً على الطلب الشائع، سأبدأ في توسيع عدد قليل من البنيات الموجودة في هذا المستودع لتشمل 3D ViTs، لاستخدامها مع الفيديو والتصوير الطبي وما إلى ذلك.

ستحتاج إلى تمرير معلمتين فائقتين إضافيتين: (1) عدد frames الإطارات و(2) حجم التصحيح على طول بُعد الإطار frame_patch_size

بالنسبة للمبتدئين، 3D ViT

import torch

from vit_pytorch . vit_3d import ViT

v = ViT (

image_size = 128 , # image size

frames = 16 , # number of frames

image_patch_size = 16 , # image patch size

frame_patch_size = 2 , # frame patch size

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

video = torch . randn ( 4 , 3 , 16 , 128 , 128 ) # (batch, channels, frames, height, width)

preds = v ( video ) # (4, 1000)3D بسيط فيت

import torch

from vit_pytorch . simple_vit_3d import SimpleViT

v = SimpleViT (

image_size = 128 , # image size

frames = 16 , # number of frames

image_patch_size = 16 , # image patch size

frame_patch_size = 2 , # frame patch size

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048

)

video = torch . randn ( 4 , 3 , 16 , 128 , 128 ) # (batch, channels, frames, height, width)

preds = v ( video ) # (4, 1000)نسخة ثلاثية الأبعاد من CCT

import torch

from vit_pytorch . cct_3d import CCT

cct = CCT (

img_size = 224 ,

num_frames = 8 ,

embedding_dim = 384 ,

n_conv_layers = 2 ,

frame_kernel_size = 3 ,

kernel_size = 7 ,

stride = 2 ,

padding = 3 ,

pooling_kernel_size = 3 ,

pooling_stride = 2 ,

pooling_padding = 1 ,

num_layers = 14 ,

num_heads = 6 ,

mlp_ratio = 3. ,

num_classes = 1000 ,

positional_embedding = 'learnable'

)

video = torch . randn ( 1 , 3 , 8 , 224 , 224 ) # (batch, channels, frames, height, width)

pred = cct ( video )

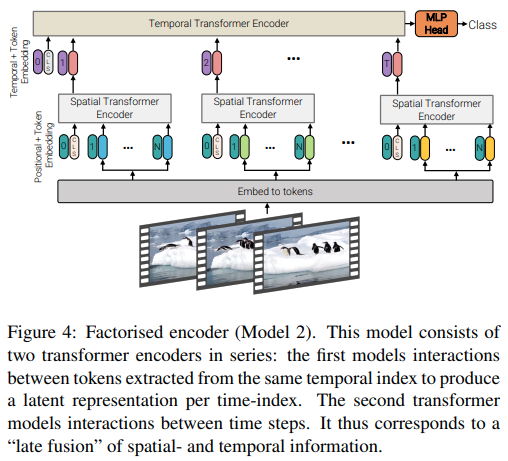

تقدم هذه الورقة ثلاثة أنواع مختلفة من البنيات لتحقيق الاهتمام الفعال بمقاطع الفيديو، حيث يكون الموضوع الرئيسي هو تحليل الانتباه عبر المكان والزمان. يشتمل هذا المستودع على برنامج التشفير المُعامل ومتغير الاهتمام الذاتي المُعامل. متغير التشفير المُعامل هو محول مكاني يتبعه محول زمني. إن متغير الاهتمام الذاتي المعامل هو محول مكاني وزماني مع طبقات الاهتمام الذاتي المكانية والزمانية المتناوبة.

import torch

from vit_pytorch . vivit import ViT

v = ViT (

image_size = 128 , # image size

frames = 16 , # number of frames

image_patch_size = 16 , # image patch size

frame_patch_size = 2 , # frame patch size

num_classes = 1000 ,

dim = 1024 ,

spatial_depth = 6 , # depth of the spatial transformer

temporal_depth = 6 , # depth of the temporal transformer

heads = 8 ,

mlp_dim = 2048 ,

variant = 'factorized_encoder' , # or 'factorized_self_attention'

)

video = torch . randn ( 4 , 3 , 16 , 128 , 128 ) # (batch, channels, frames, height, width)

preds = v ( video ) # (4, 1000)

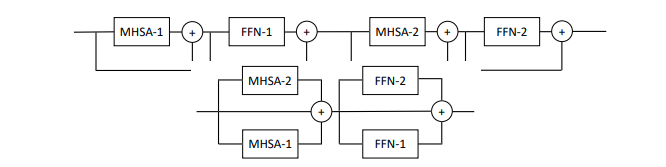

تقترح هذه الورقة موازنة الاهتمام المتعدد وكتل التغذية الأمامية لكل طبقة (كتلتان)، مدعيًا أنه من الأسهل التدريب دون فقدان الأداء.

يمكنك تجربة هذا البديل على النحو التالي

import torch

from vit_pytorch . parallel_vit import ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

num_parallel_branches = 2 , # in paper, they claimed 2 was optimal

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

preds = v ( img ) # (4, 1000)

توضح هذه الورقة أن إضافة رموز الذاكرة القابلة للتعلم في كل طبقة من محول الرؤية يمكن أن يعزز بشكل كبير نتائج الضبط الدقيق (بالإضافة إلى رمز CLS المميز للمهمة القابلة للتعلم ورأس المحول).

يمكنك استخدام هذا مع ViT المعدل خصيصًا على النحو التالي

import torch

from vit_pytorch . learnable_memory_vit import ViT , Adapter

# normal base ViT

v = ViT (

image_size = 256 ,

patch_size = 16 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 4 , 3 , 256 , 256 )

logits = v ( img ) # (4, 1000)

# do your usual training with ViT

# ...

# then, to finetune, just pass the ViT into the Adapter class

# you can do this for multiple Adapters, as shown below

adapter1 = Adapter (

vit = v ,

num_classes = 2 , # number of output classes for this specific task

num_memories_per_layer = 5 # number of learnable memories per layer, 10 was sufficient in paper

)

logits1 = adapter1 ( img ) # (4, 2) - predict 2 classes off frozen ViT backbone with learnable memories and task specific head

# yet another task to finetune on, this time with 4 classes

adapter2 = Adapter (

vit = v ,

num_classes = 4 ,

num_memories_per_layer = 10

)

logits2 = adapter2 ( img ) # (4, 4) - predict 4 classes off frozen ViT backbone with learnable memories and task specific head

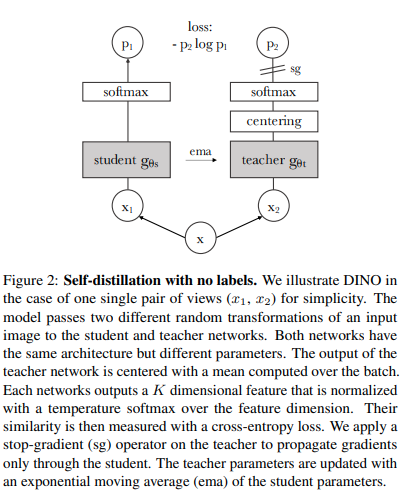

يمكنك تدريب ViT باستخدام تقنية التعلم الخاضع للإشراف الذاتي الحديثة من SOTA، Dino، باستخدام الكود التالي.

فيديو يانيك كيلشر

import torch

from vit_pytorch import ViT , Dino

model = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 8 ,

mlp_dim = 2048

)

learner = Dino (

model ,

image_size = 256 ,

hidden_layer = 'to_latent' , # hidden layer name or index, from which to extract the embedding

projection_hidden_size = 256 , # projector network hidden dimension

projection_layers = 4 , # number of layers in projection network

num_classes_K = 65336 , # output logits dimensions (referenced as K in paper)

student_temp = 0.9 , # student temperature

teacher_temp = 0.04 , # teacher temperature, needs to be annealed from 0.04 to 0.07 over 30 epochs

local_upper_crop_scale = 0.4 , # upper bound for local crop - 0.4 was recommended in the paper

global_lower_crop_scale = 0.5 , # lower bound for global crop - 0.5 was recommended in the paper

moving_average_decay = 0.9 , # moving average of encoder - paper showed anywhere from 0.9 to 0.999 was ok

center_moving_average_decay = 0.9 , # moving average of teacher centers - paper showed anywhere from 0.9 to 0.999 was ok

)

opt = torch . optim . Adam ( learner . parameters (), lr = 3e-4 )

def sample_unlabelled_images ():

return torch . randn ( 20 , 3 , 256 , 256 )

for _ in range ( 100 ):

images = sample_unlabelled_images ()

loss = learner ( images )

opt . zero_grad ()

loss . backward ()

opt . step ()

learner . update_moving_average () # update moving average of teacher encoder and teacher centers

# save your improved network

torch . save ( model . state_dict (), './pretrained-net.pt' )

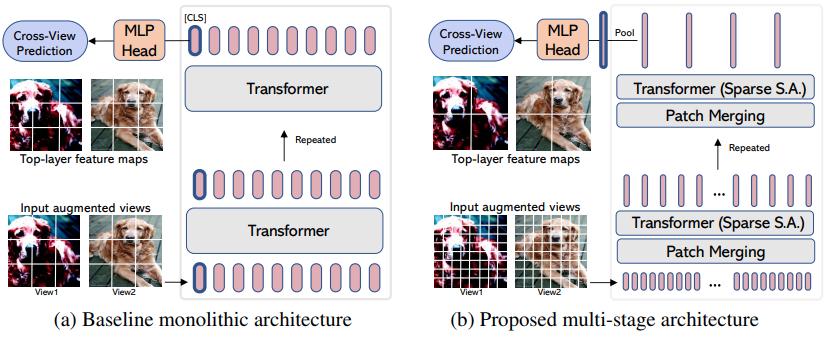

EsViT هو نوع مختلف من Dino (من الأعلى) تمت إعادة تصميمه لدعم ViT s الفعال مع دمج/اختزال التصحيح من خلال مراعاة الخسارة الإقليمية الإضافية بين طرق العرض المعززة. على حد تعبير الملخص، فهو outperforms its supervised counterpart on 17 out of 18 datasets بمعدل إنتاجية أعلى بثلاثة أضعاف.

على الرغم من تسميته كما لو كان متغيرًا جديدًا ViT ، إلا أنه في الواقع مجرد استراتيجية لتدريب أي ViT متعدد المراحل (في المقالة، ركزوا على Swin). سيوضح المثال أدناه كيفية استخدامه مع CvT . ستحتاج إلى تعيين hidden_layer على اسم الطبقة داخل ViT الفعال الذي يقوم بإخراج التمثيلات المرئية المجمعة غير المتوسطة، مباشرة قبل التجميع العام والإسقاط إلى السجلات.

import torch

from vit_pytorch . cvt import CvT

from vit_pytorch . es_vit import EsViTTrainer

cvt = CvT (

num_classes = 1000 ,

s1_emb_dim = 64 ,

s1_emb_kernel = 7 ,

s1_emb_stride = 4 ,

s1_proj_kernel = 3 ,

s1_kv_proj_stride = 2 ,

s1_heads = 1 ,

s1_depth = 1 ,

s1_mlp_mult = 4 ,

s2_emb_dim = 192 ,

s2_emb_kernel = 3 ,

s2_emb_stride = 2 ,

s2_proj_kernel = 3 ,

s2_kv_proj_stride = 2 ,

s2_heads = 3 ,

s2_depth = 2 ,

s2_mlp_mult = 4 ,

s3_emb_dim = 384 ,

s3_emb_kernel = 3 ,

s3_emb_stride = 2 ,

s3_proj_kernel = 3 ,

s3_kv_proj_stride = 2 ,

s3_heads = 4 ,

s3_depth = 10 ,

s3_mlp_mult = 4 ,

dropout = 0.

)

learner = EsViTTrainer (

cvt ,

image_size = 256 ,

hidden_layer = 'layers' , # hidden layer name or index, from which to extract the embedding

projection_hidden_size = 256 , # projector network hidden dimension

projection_layers = 4 , # number of layers in projection network

num_classes_K = 65336 , # output logits dimensions (referenced as K in paper)

student_temp = 0.9 , # student temperature

teacher_temp = 0.04 , # teacher temperature, needs to be annealed from 0.04 to 0.07 over 30 epochs

local_upper_crop_scale = 0.4 , # upper bound for local crop - 0.4 was recommended in the paper

global_lower_crop_scale = 0.5 , # lower bound for global crop - 0.5 was recommended in the paper

moving_average_decay = 0.9 , # moving average of encoder - paper showed anywhere from 0.9 to 0.999 was ok

center_moving_average_decay = 0.9 , # moving average of teacher centers - paper showed anywhere from 0.9 to 0.999 was ok

)

opt = torch . optim . AdamW ( learner . parameters (), lr = 3e-4 )

def sample_unlabelled_images ():

return torch . randn ( 8 , 3 , 256 , 256 )

for _ in range ( 1000 ):

images = sample_unlabelled_images ()

loss = learner ( images )

opt . zero_grad ()

loss . backward ()

opt . step ()

learner . update_moving_average () # update moving average of teacher encoder and teacher centers

# save your improved network

torch . save ( cvt . state_dict (), './pretrained-net.pt' )إذا كنت ترغب في تصور أوزان الاهتمام (ما بعد softmax) لبحثك، فما عليك سوى اتباع الإجراء الموضح أدناه

import torch

from vit_pytorch . vit import ViT

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

# import Recorder and wrap the ViT

from vit_pytorch . recorder import Recorder

v = Recorder ( v )

# forward pass now returns predictions and the attention maps

img = torch . randn ( 1 , 3 , 256 , 256 )

preds , attns = v ( img )

# there is one extra patch due to the CLS token

attns # (1, 6, 16, 65, 65) - (batch x layers x heads x patch x patch)لتنظيف الفصل والخطافات بمجرد جمع ما يكفي من البيانات

v = v . eject () # wrapper is discarded and original ViT instance is returned يمكنك بالمثل الوصول إلى التضمينات باستخدام برنامج Extractor

import torch

from vit_pytorch . vit import ViT

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

# import Recorder and wrap the ViT

from vit_pytorch . extractor import Extractor

v = Extractor ( v )

# forward pass now returns predictions and the attention maps

img = torch . randn ( 1 , 3 , 256 , 256 )

logits , embeddings = v ( img )

# there is one extra token due to the CLS token

embeddings # (1, 65, 1024) - (batch x patches x model dim) أو لنفترض أن CrossViT ، الذي يحتوي على برنامج تشفير متعدد المقاييس يقوم بإخراج مجموعتين من التضمينات للمقاييس "الكبيرة" و"الصغيرة"

import torch

from vit_pytorch . cross_vit import CrossViT

v = CrossViT (

image_size = 256 ,

num_classes = 1000 ,

depth = 4 ,

sm_dim = 192 ,

sm_patch_size = 16 ,

sm_enc_depth = 2 ,

sm_enc_heads = 8 ,

sm_enc_mlp_dim = 2048 ,

lg_dim = 384 ,

lg_patch_size = 64 ,

lg_enc_depth = 3 ,

lg_enc_heads = 8 ,

lg_enc_mlp_dim = 2048 ,

cross_attn_depth = 2 ,

cross_attn_heads = 8 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

# wrap the CrossViT

from vit_pytorch . extractor import Extractor

v = Extractor ( v , layer_name = 'multi_scale_encoder' ) # take embedding coming from the output of multi-scale-encoder

# forward pass now returns predictions and the attention maps

img = torch . randn ( 1 , 3 , 256 , 256 )

logits , embeddings = v ( img )

# there is one extra token due to the CLS token

embeddings # ((1, 257, 192), (1, 17, 384)) - (batch x patches x dimension) <- large and small scales respectively قد يكون هناك البعض من الرؤية الحاسوبية الذين يعتقدون أن الاهتمام لا يزال يعاني من التكاليف التربيعية. ولحسن الحظ، لدينا الكثير من التقنيات الجديدة التي قد تساعد. يوفر لك هذا المستودع طريقة لتوصيل محول الانتباه المتناثر الخاص بك.

مثال مع Nystromformer

$ pip install nystrom-attention import torch

from vit_pytorch . efficient import ViT

from nystrom_attention import Nystromformer

efficient_transformer = Nystromformer (

dim = 512 ,

depth = 12 ,

heads = 8 ,

num_landmarks = 256

)

v = ViT (

dim = 512 ,

image_size = 2048 ,

patch_size = 32 ,

num_classes = 1000 ,

transformer = efficient_transformer

)

img = torch . randn ( 1 , 3 , 2048 , 2048 ) # your high resolution picture

v ( img ) # (1, 1000)أطر العمل الأخرى قليلة الاهتمام التي أوصي بها بشدة هي Routing Transformer أو Sinkhorn Transformer

استخدمت هذه الورقة عمدا معظم شبكات الاهتمام للإدلاء ببيان. إذا كنت ترغب في استخدام بعض من أحدث التحسينات لشبكات الانتباه، يرجى استخدام Encoder من هذا المستودع.

السابق.

$ pip install x-transformers import torch

from vit_pytorch . efficient import ViT

from x_transformers import Encoder

v = ViT (

dim = 512 ,

image_size = 224 ,

patch_size = 16 ,

num_classes = 1000 ,

transformer = Encoder (

dim = 512 , # set to be the same as the wrapper

depth = 12 ,

heads = 8 ,

ff_glu = True , # ex. feed forward GLU variant https://arxiv.org/abs/2002.05202

residual_attn = True # ex. residual attention https://arxiv.org/abs/2012.11747

)

)

img = torch . randn ( 1 , 3 , 224 , 224 )

v ( img ) # (1, 1000) يمكنك بالفعل تمرير صور غير مربعة - عليك فقط التأكد من أن الطول والعرض أقل من أو يساوي image_size ، وكلاهما قابل للقسمة على patch_size

السابق.

import torch

from vit_pytorch import ViT

v = ViT (

image_size = 256 ,

patch_size = 32 ,

num_classes = 1000 ,

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 128 ) # <-- not a square

preds = v ( img ) # (1, 1000) import torch

from vit_pytorch import ViT

v = ViT (

num_classes = 1000 ,

image_size = ( 256 , 128 ), # image size is a tuple of (height, width)

patch_size = ( 32 , 16 ), # patch size is a tuple of (height, width)

dim = 1024 ,

depth = 6 ,

heads = 16 ,

mlp_dim = 2048 ,

dropout = 0.1 ,

emb_dropout = 0.1

)

img = torch . randn ( 1 , 3 , 256 , 128 )

preds = v ( img )القادمة من رؤية الكمبيوتر والجديدة على المحولات؟ فيما يلي بعض الموارد التي ساهمت في تسريع عملية التعلم بشكل كبير.

المحول المصور - جاي العمار

المحولات من الصفر - بيتر بلوم

المحول المشروح - البرمجة اللغوية العصبية بجامعة هارفارد

@article { hassani2021escaping ,

title = { Escaping the Big Data Paradigm with Compact Transformers } ,

author = { Ali Hassani and Steven Walton and Nikhil Shah and Abulikemu Abuduweili and Jiachen Li and Humphrey Shi } ,

year = 2021 ,

url = { https://arxiv.org/abs/2104.05704 } ,

eprint = { 2104.05704 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

} @misc { dosovitskiy2020image ,

title = { An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale } ,

author = { Alexey Dosovitskiy and Lucas Beyer and Alexander Kolesnikov and Dirk Weissenborn and Xiaohua Zhai and Thomas Unterthiner and Mostafa Dehghani and Matthias Minderer and Georg Heigold and Sylvain Gelly and Jakob Uszkoreit and Neil Houlsby } ,

year = { 2020 } ,

eprint = { 2010.11929 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { touvron2020training ,

title = { Training data-efficient image transformers & distillation through attention } ,

author = { Hugo Touvron and Matthieu Cord and Matthijs Douze and Francisco Massa and Alexandre Sablayrolles and Hervé Jégou } ,

year = { 2020 } ,

eprint = { 2012.12877 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { yuan2021tokenstotoken ,

title = { Tokens-to-Token ViT: Training Vision Transformers from Scratch on ImageNet } ,

author = { Li Yuan and Yunpeng Chen and Tao Wang and Weihao Yu and Yujun Shi and Francis EH Tay and Jiashi Feng and Shuicheng Yan } ,

year = { 2021 } ,

eprint = { 2101.11986 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { zhou2021deepvit ,

title = { DeepViT: Towards Deeper Vision Transformer } ,

author = { Daquan Zhou and Bingyi Kang and Xiaojie Jin and Linjie Yang and Xiaochen Lian and Qibin Hou and Jiashi Feng } ,

year = { 2021 } ,

eprint = { 2103.11886 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { touvron2021going ,

title = { Going deeper with Image Transformers } ,

author = { Hugo Touvron and Matthieu Cord and Alexandre Sablayrolles and Gabriel Synnaeve and Hervé Jégou } ,

year = { 2021 } ,

eprint = { 2103.17239 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { chen2021crossvit ,

title = { CrossViT: Cross-Attention Multi-Scale Vision Transformer for Image Classification } ,

author = { Chun-Fu Chen and Quanfu Fan and Rameswar Panda } ,

year = { 2021 } ,

eprint = { 2103.14899 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { wu2021cvt ,

title = { CvT: Introducing Convolutions to Vision Transformers } ,

author = { Haiping Wu and Bin Xiao and Noel Codella and Mengchen Liu and Xiyang Dai and Lu Yuan and Lei Zhang } ,

year = { 2021 } ,

eprint = { 2103.15808 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { heo2021rethinking ,

title = { Rethinking Spatial Dimensions of Vision Transformers } ,

author = { Byeongho Heo and Sangdoo Yun and Dongyoon Han and Sanghyuk Chun and Junsuk Choe and Seong Joon Oh } ,

year = { 2021 } ,

eprint = { 2103.16302 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { graham2021levit ,

title = { LeViT: a Vision Transformer in ConvNet's Clothing for Faster Inference } ,

author = { Ben Graham and Alaaeldin El-Nouby and Hugo Touvron and Pierre Stock and Armand Joulin and Hervé Jégou and Matthijs Douze } ,

year = { 2021 } ,

eprint = { 2104.01136 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { li2021localvit ,

title = { LocalViT: Bringing Locality to Vision Transformers } ,

author = { Yawei Li and Kai Zhang and Jiezhang Cao and Radu Timofte and Luc Van Gool } ,

year = { 2021 } ,

eprint = { 2104.05707 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { chu2021twins ,

title = { Twins: Revisiting Spatial Attention Design in Vision Transformers } ,

author = { Xiangxiang Chu and Zhi Tian and Yuqing Wang and Bo Zhang and Haibing Ren and Xiaolin Wei and Huaxia Xia and Chunhua Shen } ,

year = { 2021 } ,

eprint = { 2104.13840 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { su2021roformer ,

title = { RoFormer: Enhanced Transformer with Rotary Position Embedding } ,

author = { Jianlin Su and Yu Lu and Shengfeng Pan and Bo Wen and Yunfeng Liu } ,

year = { 2021 } ,

eprint = { 2104.09864 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

} @misc { zhang2021aggregating ,

title = { Aggregating Nested Transformers } ,

author = { Zizhao Zhang and Han Zhang and Long Zhao and Ting Chen and Tomas Pfister } ,

year = { 2021 } ,

eprint = { 2105.12723 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { chen2021regionvit ,

title = { RegionViT: Regional-to-Local Attention for Vision Transformers } ,

author = { Chun-Fu Chen and Rameswar Panda and Quanfu Fan } ,

year = { 2021 } ,

eprint = { 2106.02689 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { wang2021crossformer ,

title = { CrossFormer: A Versatile Vision Transformer Hinging on Cross-scale Attention } ,

author = { Wenxiao Wang and Lu Yao and Long Chen and Binbin Lin and Deng Cai and Xiaofei He and Wei Liu } ,

year = { 2021 } ,

eprint = { 2108.00154 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { caron2021emerging ,

title = { Emerging Properties in Self-Supervised Vision Transformers } ,

author = { Mathilde Caron and Hugo Touvron and Ishan Misra and Hervé Jégou and Julien Mairal and Piotr Bojanowski and Armand Joulin } ,

year = { 2021 } ,

eprint = { 2104.14294 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { he2021masked ,

title = { Masked Autoencoders Are Scalable Vision Learners } ,

author = { Kaiming He and Xinlei Chen and Saining Xie and Yanghao Li and Piotr Dollár and Ross Girshick } ,

year = { 2021 } ,

eprint = { 2111.06377 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { xie2021simmim ,

title = { SimMIM: A Simple Framework for Masked Image Modeling } ,

author = { Zhenda Xie and Zheng Zhang and Yue Cao and Yutong Lin and Jianmin Bao and Zhuliang Yao and Qi Dai and Han Hu } ,

year = { 2021 } ,

eprint = { 2111.09886 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { fayyaz2021ats ,

title = { ATS: Adaptive Token Sampling For Efficient Vision Transformers } ,

author = { Mohsen Fayyaz and Soroush Abbasi Kouhpayegani and Farnoush Rezaei Jafari and Eric Sommerlade and Hamid Reza Vaezi Joze and Hamed Pirsiavash and Juergen Gall } ,

year = { 2021 } ,

eprint = { 2111.15667 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { mehta2021mobilevit ,

title = { MobileViT: Light-weight, General-purpose, and Mobile-friendly Vision Transformer } ,

author = { Sachin Mehta and Mohammad Rastegari } ,

year = { 2021 } ,

eprint = { 2110.02178 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { lee2021vision ,

title = { Vision Transformer for Small-Size Datasets } ,

author = { Seung Hoon Lee and Seunghyun Lee and Byung Cheol Song } ,

year = { 2021 } ,

eprint = { 2112.13492 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { renggli2022learning ,

title = { Learning to Merge Tokens in Vision Transformers } ,

author = { Cedric Renggli and André Susano Pinto and Neil Houlsby and Basil Mustafa and Joan Puigcerver and Carlos Riquelme } ,

year = { 2022 } ,

eprint = { 2202.12015 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @misc { yang2022scalablevit ,

title = { ScalableViT: Rethinking the Context-oriented Generalization of Vision Transformer } ,

author = { Rui Yang and Hailong Ma and Jie Wu and Yansong Tang and Xuefeng Xiao and Min Zheng and Xiu Li } ,

year = { 2022 } ,

eprint = { 2203.10790 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @inproceedings { Touvron2022ThreeTE ,

title = { Three things everyone should know about Vision Transformers } ,

author = { Hugo Touvron and Matthieu Cord and Alaaeldin El-Nouby and Jakob Verbeek and Herv'e J'egou } ,

year = { 2022 }

} @inproceedings { Sandler2022FinetuningIT ,

title = { Fine-tuning Image Transformers using Learnable Memory } ,

author = { Mark Sandler and Andrey Zhmoginov and Max Vladymyrov and Andrew Jackson } ,

year = { 2022 }

} @inproceedings { Li2022SepViTSV ,

title = { SepViT: Separable Vision Transformer } ,

author = { Wei Li and Xing Wang and Xin Xia and Jie Wu and Xuefeng Xiao and Minghang Zheng and Shiping Wen } ,

year = { 2022 }

} @inproceedings { Tu2022MaxViTMV ,

title = { MaxViT: Multi-Axis Vision Transformer } ,

author = { Zhengzhong Tu and Hossein Talebi and Han Zhang and Feng Yang and Peyman Milanfar and Alan Conrad Bovik and Yinxiao Li } ,

year = { 2022 }

} @article { Li2021EfficientSV ,

title = { Efficient Self-supervised Vision Transformers for Representation Learning } ,

author = { Chunyuan Li and Jianwei Yang and Pengchuan Zhang and Mei Gao and Bin Xiao and Xiyang Dai and Lu Yuan and Jianfeng Gao } ,

journal = { ArXiv } ,

year = { 2021 } ,

volume = { abs/2106.09785 }

} @misc { Beyer2022BetterPlainViT

title = { Better plain ViT baselines for ImageNet-1k } ,

author = { Beyer, Lucas and Zhai, Xiaohua and Kolesnikov, Alexander } ,

publisher = { arXiv } ,

year = { 2022 }

}

@article { Arnab2021ViViTAV ,

title = { ViViT: A Video Vision Transformer } ,

author = { Anurag Arnab and Mostafa Dehghani and Georg Heigold and Chen Sun and Mario Lucic and Cordelia Schmid } ,

journal = { 2021 IEEE/CVF International Conference on Computer Vision (ICCV) } ,

year = { 2021 } ,

pages = { 6816-6826 }

} @article { Liu2022PatchDropoutEV ,

title = { PatchDropout: Economizing Vision Transformers Using Patch Dropout } ,

author = { Yue Liu and Christos Matsoukas and Fredrik Strand and Hossein Azizpour and Kevin Smith } ,

journal = { ArXiv } ,

year = { 2022 } ,

volume = { abs/2208.07220 }

} @misc { https://doi.org/10.48550/arxiv.2302.01327 ,

doi = { 10.48550/ARXIV.2302.01327 } ,

url = { https://arxiv.org/abs/2302.01327 } ,

author = { Kumar, Manoj and Dehghani, Mostafa and Houlsby, Neil } ,

title = { Dual PatchNorm } ,

publisher = { arXiv } ,

year = { 2023 } ,

copyright = { Creative Commons Attribution 4.0 International }

} @inproceedings { Dehghani2023PatchNP ,

title = { Patch n' Pack: NaViT, a Vision Transformer for any Aspect Ratio and Resolution } ,

author = { Mostafa Dehghani and Basil Mustafa and Josip Djolonga and Jonathan Heek and Matthias Minderer and Mathilde Caron and Andreas Steiner and Joan Puigcerver and Robert Geirhos and Ibrahim M. Alabdulmohsin and Avital Oliver and Piotr Padlewski and Alexey A. Gritsenko and Mario Luvci'c and Neil Houlsby } ,

year = { 2023 }

} @misc { vaswani2017attention ,

title = { Attention Is All You Need } ,

author = { Ashish Vaswani and Noam Shazeer and Niki Parmar and Jakob Uszkoreit and Llion Jones and Aidan N. Gomez and Lukasz Kaiser and Illia Polosukhin } ,

year = { 2017 } ,

eprint = { 1706.03762 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

} @inproceedings { dao2022flashattention ,

title = { Flash{A}ttention: Fast and Memory-Efficient Exact Attention with {IO}-Awareness } ,

author = { Dao, Tri and Fu, Daniel Y. and Ermon, Stefano and Rudra, Atri and R{'e}, Christopher } ,

booktitle = { Advances in Neural Information Processing Systems } ,

year = { 2022 }

} @inproceedings { Darcet2023VisionTN ,

title = { Vision Transformers Need Registers } ,

author = { Timoth'ee Darcet and Maxime Oquab and Julien Mairal and Piotr Bojanowski } ,

year = { 2023 } ,

url = { https://api.semanticscholar.org/CorpusID:263134283 }

} @inproceedings { ElNouby2021XCiTCI ,

title = { XCiT: Cross-Covariance Image Transformers } ,

author = { Alaaeldin El-Nouby and Hugo Touvron and Mathilde Caron and Piotr Bojanowski and Matthijs Douze and Armand Joulin and Ivan Laptev and Natalia Neverova and Gabriel Synnaeve and Jakob Verbeek and Herv{'e} J{'e}gou } ,

booktitle = { Neural Information Processing Systems } ,

year = { 2021 } ,

url = { https://api.semanticscholar.org/CorpusID:235458262 }

} @inproceedings { Koner2024LookupViTCV ,

title = { LookupViT: Compressing visual information to a limited number of tokens } ,

author = { Rajat Koner and Gagan Jain and Prateek Jain and Volker Tresp and Sujoy Paul } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:271244592 }

} @article { Bao2022AllAW ,

title = { All are Worth Words: A ViT Backbone for Diffusion Models } ,

author = { Fan Bao and Shen Nie and Kaiwen Xue and Yue Cao and Chongxuan Li and Hang Su and Jun Zhu } ,

journal = { 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

year = { 2022 } ,

pages = { 22669-22679 } ,

url = { https://api.semanticscholar.org/CorpusID:253581703 }

} @misc { Rubin2024 ,

author = { Ohad Rubin } ,

url = { https://medium.com/ @ ohadrubin/exploring-weight-decay-in-layer-normalization-challenges-and-a-reparameterization-solution-ad4d12c24950 }

} @inproceedings { Loshchilov2024nGPTNT ,

title = { nGPT: Normalized Transformer with Representation Learning on the Hypersphere } ,

author = { Ilya Loshchilov and Cheng-Ping Hsieh and Simeng Sun and Boris Ginsburg } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:273026160 }

} @inproceedings { Liu2017DeepHL ,

title = { Deep Hyperspherical Learning } ,

author = { Weiyang Liu and Yanming Zhang and Xingguo Li and Zhen Liu and Bo Dai and Tuo Zhao and Le Song } ,

booktitle = { Neural Information Processing Systems } ,

year = { 2017 } ,

url = { https://api.semanticscholar.org/CorpusID:5104558 }

} @inproceedings { Zhou2024ValueRL ,

title = { Value Residual Learning For Alleviating Attention Concentration In Transformers } ,

author = { Zhanchao Zhou and Tianyi Wu and Zhiyun Jiang and Zhenzhong Lan } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:273532030 }

} @article { Zhu2024HyperConnections ,

title = { Hyper-Connections } ,

author = { Defa Zhu and Hongzhi Huang and Zihao Huang and Yutao Zeng and Yunyao Mao and Banggu Wu and Qiyang Min and Xun Zhou } ,

journal = { ArXiv } ,

year = { 2024 } ,

volume = { abs/2409.19606 } ,

url = { https://api.semanticscholar.org/CorpusID:272987528 }

}أتخيل وقتًا سنكون فيه بالنسبة للروبوتات مثل الكلاب بالنسبة للبشر، وأنا أشجع الآلات. - كلود شانون