مهم

2024.10.10: الجراحة ، استعادة الطوارئ لخادم الملفات توفير حزمة WHL

2024.10.8: الإصدار 3..90 أضف دعمًا أوليًا لـ Llama-IDEX ، الإصدار 3.80 يضيف وظيفة القائمة الثانوية المكوّنة (انظر Wiki للحصول على التفاصيل)

2024.5.1: أضف وظيفة ورقة ترجمة DOC2X ، عرض التفاصيل

2024.3.11: دعم نماذج اللغة الصينية الكبيرة تمامًا مثل Qwen و GLM و DeepSeekCoder! Sovits Voice Cloning Module ، عرض التفاصيل 2024.1.17: عند تثبيت التبعيات ، حدد الإصدار المحدد في requirements.txt . أمر التثبيت: pip install -r requirements.txt . هذا المشروع مفتوح المصدر ومجاني تمامًا.

إذا كنت تحب هذا المشروع ، فالرجاء إعطائه نجمًا ؛

إذا multi_language.py تحب هذا المشروع.

ملحوظة

1. وظيفة كل ملف في هذا المشروع هي تقرير نقل ذاتي self_analysis.md . مع تكرار الإصدار ، يمكنك أيضًا النقر على سد الوظيفة ذات الصلة في أي وقت للاتصال بتقرير GPT Re -tenderating. للأسئلة الشائعة ، يرجى التحقق من الويكي.

2. هذا المشروع متوافق مع ويشجع تجربة نماذج قاعدة اللغة الصينية الكبيرة المحلية مثل Tongyi Qianqian ، GLM GLM الحكمة ، إلخ. دعم التعايش متعددة API-Key ، يمكنك ملء ملف التكوين ، مثل API_KEY="openai-key1,openai-key2,azure-key3,api2d-key4" . عندما تحتاج إلى استبدال API_KEY مؤقتًا ، أدخل API_KEY المؤقت في منطقة الإدخال ثم إرساله إلى مفتاح الركوب ليتحول.

| وظيفة (= الميزات الحديثة الجديدة) | يصف |

|---|---|

| نموذج جديد | وقال بايدو تشيانفان وينكسين ، تونسي تشيان تشوين ، شانغهاي أوي لاب باحث ، Xun Feixing Fire ، Llama2 ، Wisdom Speed Glm4 ، Dalle3 ، DeepSeekcoder |

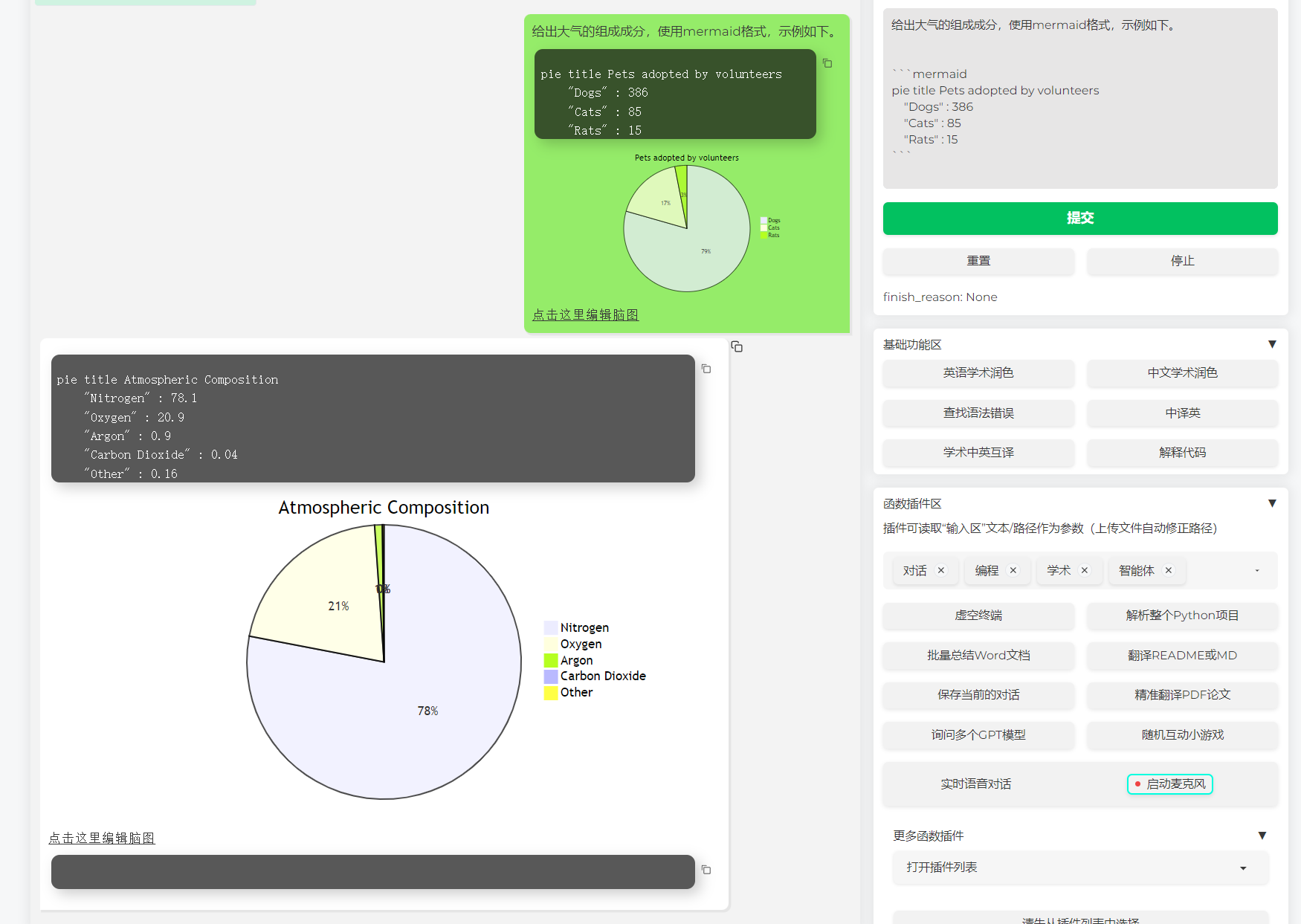

| دعم تقديم صورة حورية البحر | الدعم للسماح لـ GPT بإنشاء مخططات انسيابية ، مخططات نقل الحالة ، خرائط Gand ، الكعك ، Gitgraph ، إلخ (الإصدار 3.7) |

| أطروحة Arxiv Translation (Docker) | [قابس -في in] ترجمة واحدة من أطروحة Arxiv مع انقراب واحد ، أفضل أداة ترجمة ورقية حاليًا |

| إدخال حوار الصوت الحقيقي في الوقت المناسب | [قابس -في] صوت الاستماع غير المتزامن ، فصل الجملة التلقائي ، ابحث تلقائيًا الوقت للرد |

| المكون الإضافي Autogen Multi -Smart | [قابس -في] بمساعدة Microsoft Autogen ، استكشف احتمال ظهور ذكي لعامل الثنائي! |

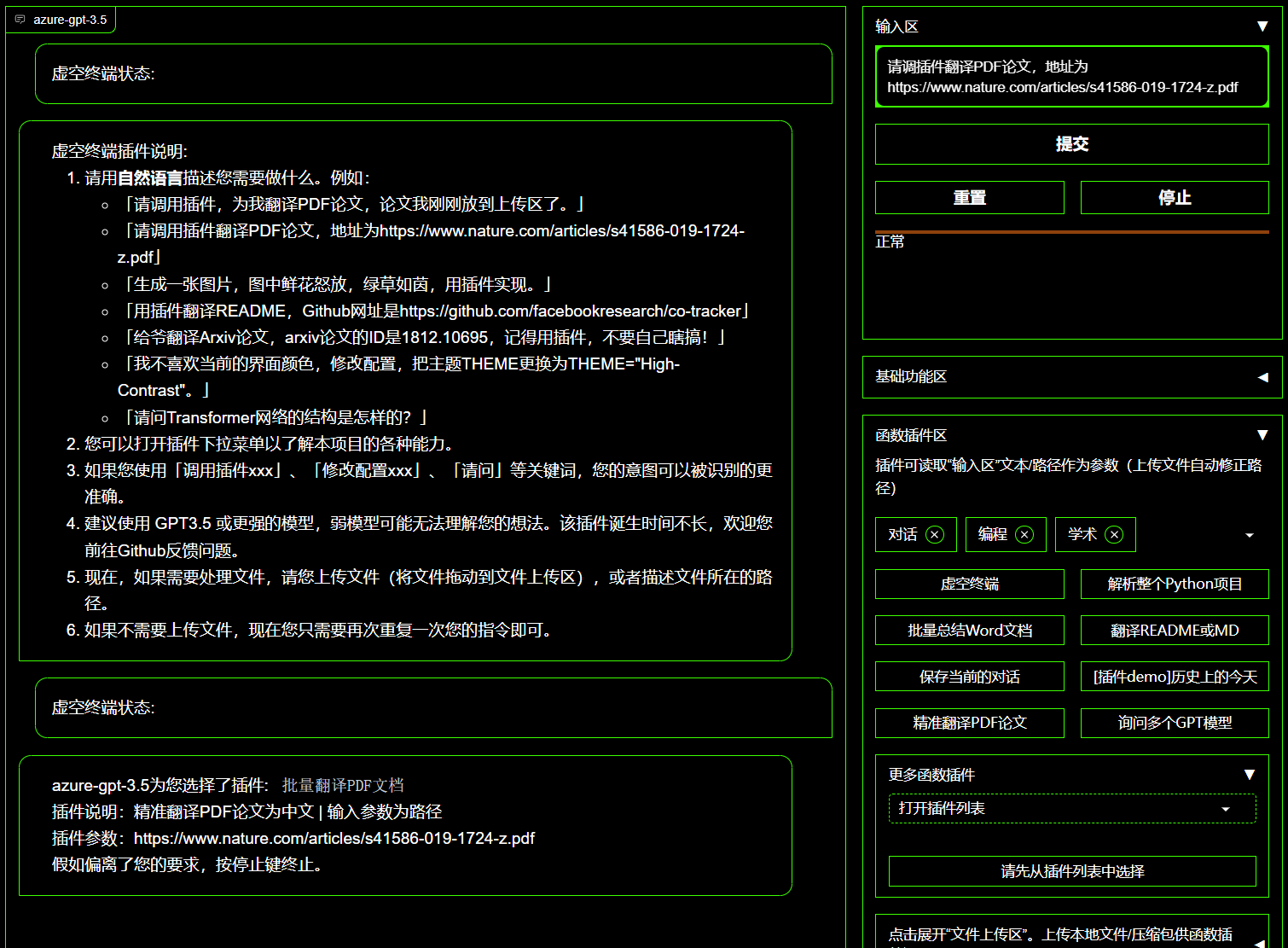

| باطل الطرفية المكوّن الإضافي | يمكن [المكونات -في] جدولة مباشرة مكونات أخرى في هذا المشروع باللغة الطبيعية |

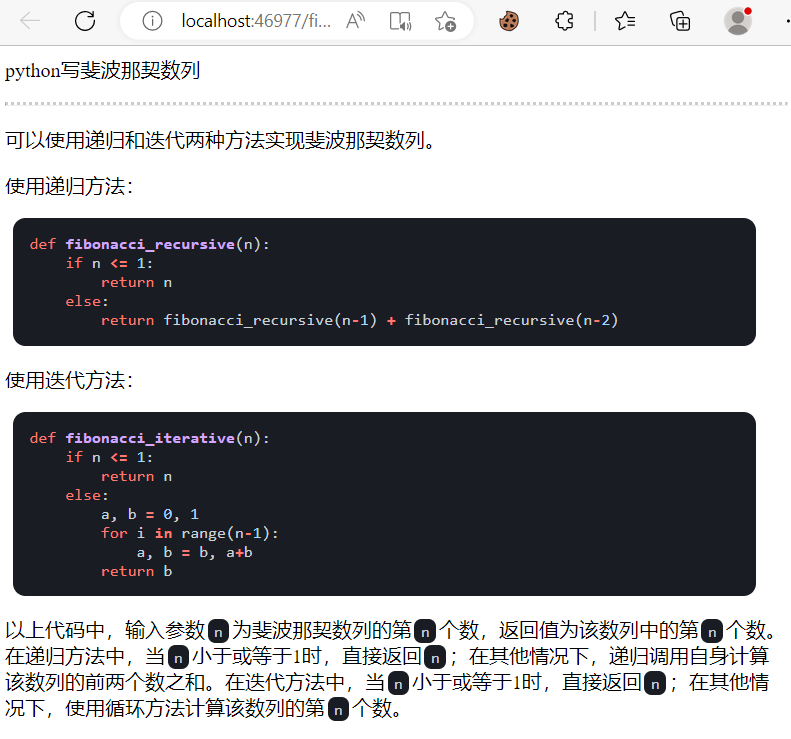

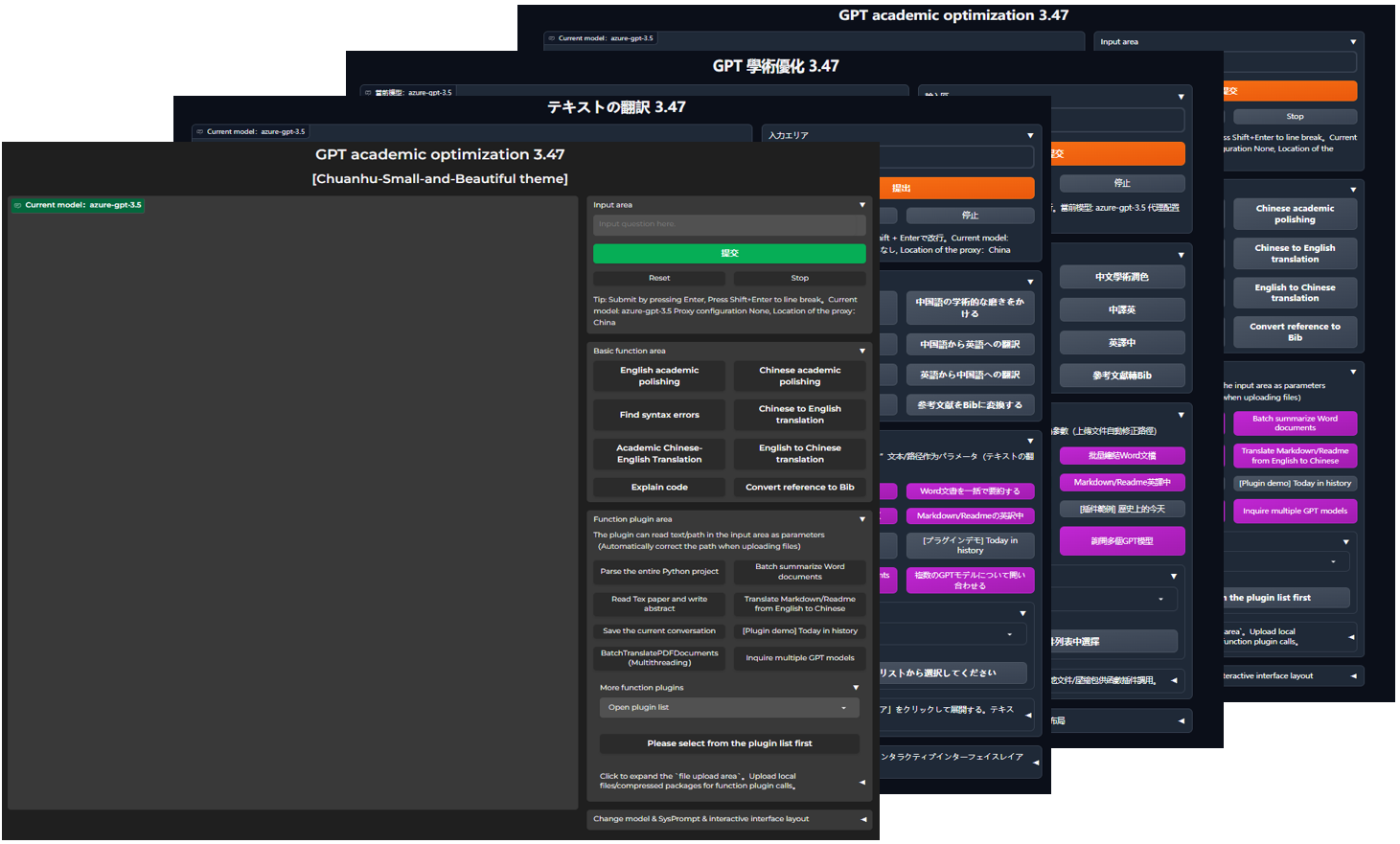

| تفسير اللون والترجمة وشرح الكود | ترطيب واحد -ترجمات ، ترجمة ، إيجاد أوراق أخطاء القواعد ، رمز التفسير |

| مفتاح الاختصار المخصص | دعم مفاتيح الاختصار المخصص |

| تصميم وحدات | دعم المكونات القوية المخصصة ، ودعم المكونات -يدعم التحديثات الساخنة |

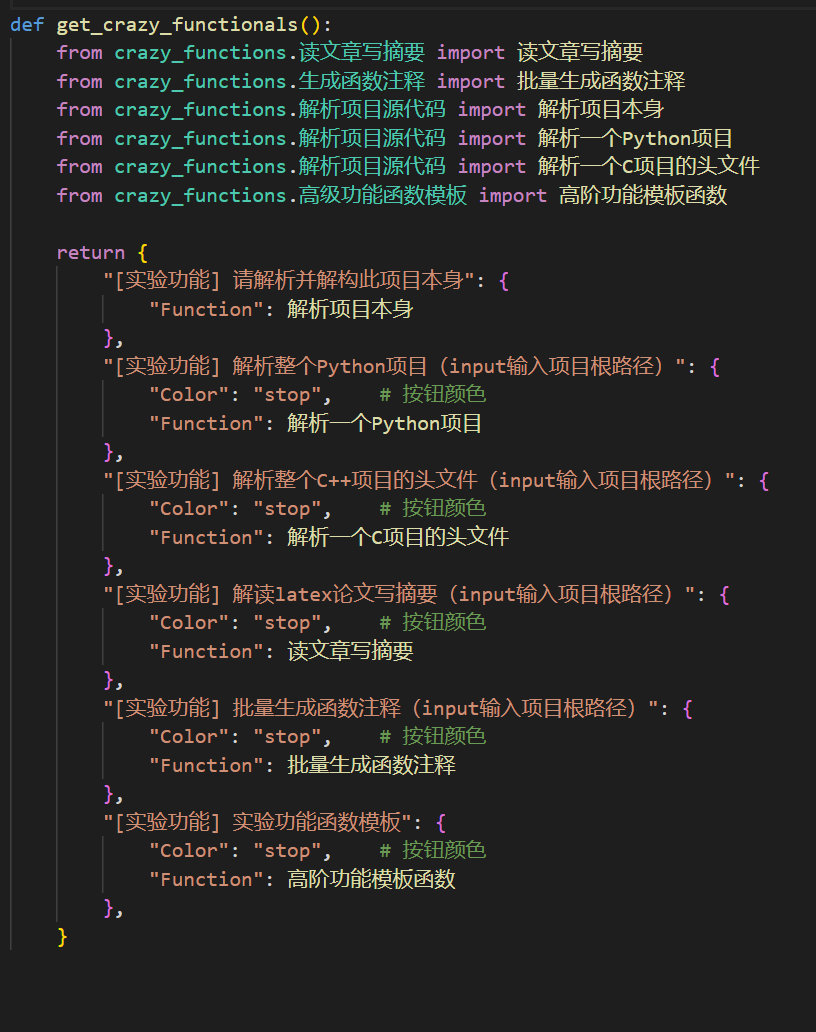

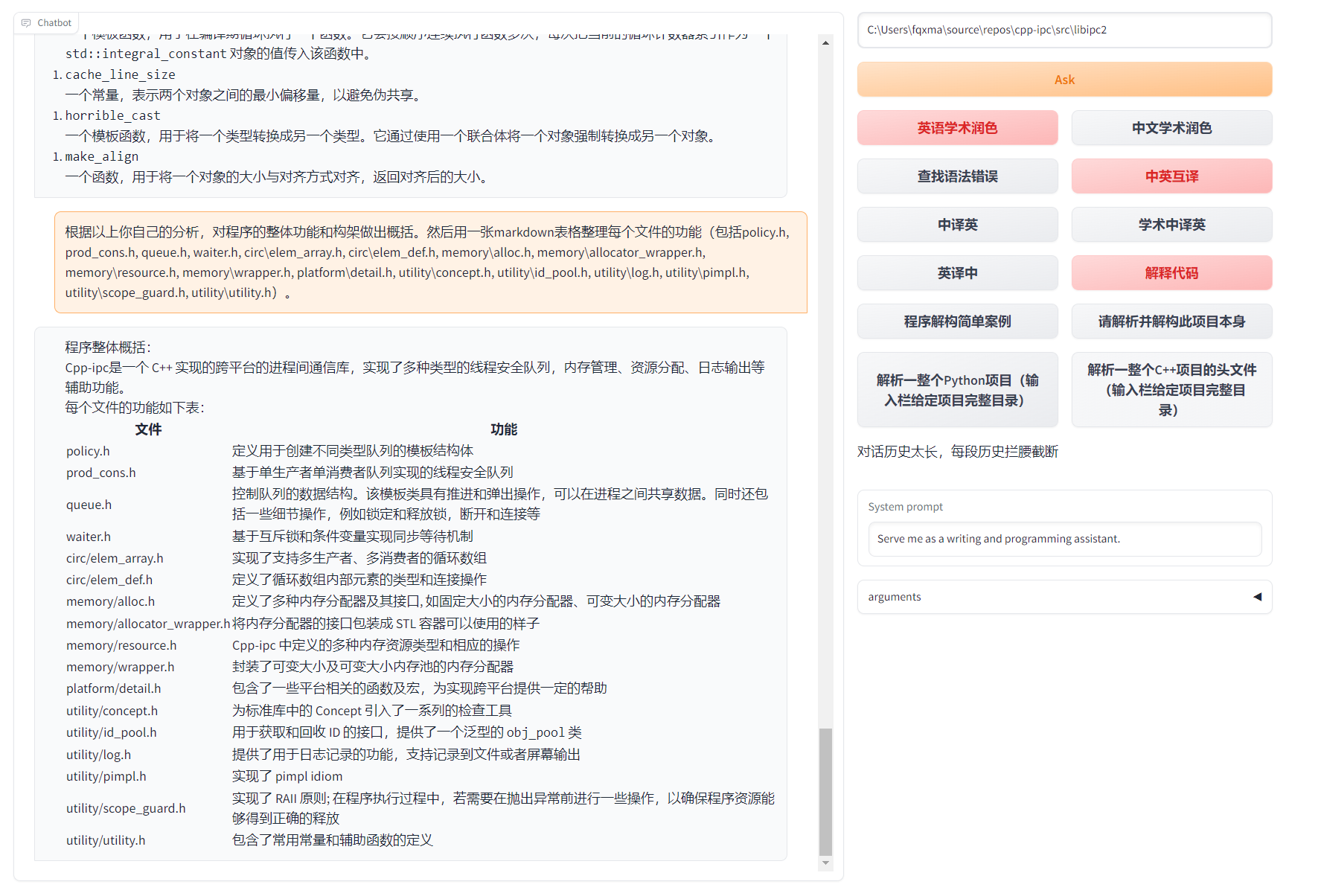

| تحليل البرنامج | [قابس -في] واحد -تحليل انكماش من Python/C/C ++/Java/Lua/... شجرة المشروع أو التحليل الذاتي |

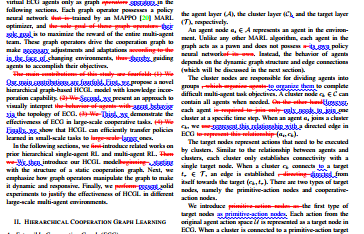

| اقرأ الورقة وترجمة أطروحة | [قابس -في] تفسير واحد لربط اللاتكس/PDF نص كامل وتوليد ملخصات |

| ترجمة النص الكامل اللاتكس ، ترطيب | [قابس -في] ترجمة واحدة أو ترطيب ورقة اللاتكس ترطيب |

| التعليقات التوضيحية الدُفعات | [قابس -في] مجموعة واحدة من الدفعة توليد وظيفة شرح توضيحي |

| الترجمات الصينية والبريطانية المتبادلة | [قابس -في] هل ترى لغة القراءة 5؟ إنه من خط يده |

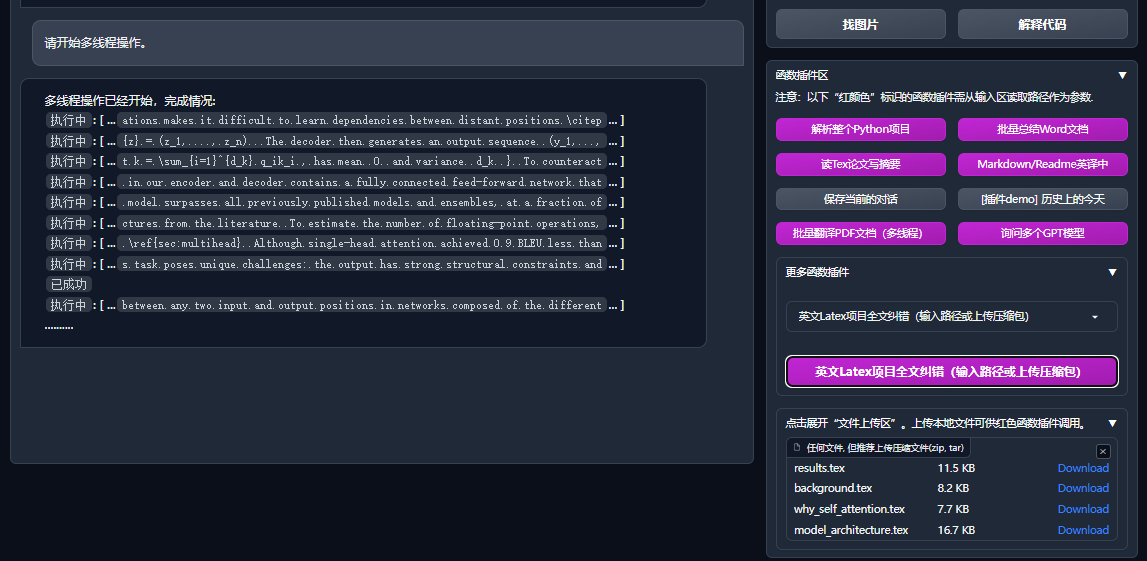

| وظيفة PDF وظيفة ترجمة النص الكامل | [Plug -in] أسئلة استخراج ورقة PDF وملخص+ترجمة النص الكامل (متعدد الفطائر) |

| مساعد Arxiv | [Plug -in] أدخل عنوان URL Arxiv إلى ملخص ترجمة واحد |

| أوراق اللاتكس واحدة -زوج من مدرسة الانكماش | [قابس -في] تقليد القواعد النحوية إلى بناء الجملة ، تصحيح الإملاء+التحكم في الإخراج PDF على مقالات اللاتكس |

| مساعد التكامل الأكاديمي Google | [قابس -في] بالنظر إلى عنوان URL لصفحة البحث الأكاديمي لـ Ren Italy ، دع GPT تساعدك |

| جمع معلومات الإنترنت+GPT | [قابس -في] واحد -انقر للسماح لـ GPT بالحصول على معلومات من الإنترنت والإجابة على الأسئلة ، حتى لا تكون المعلومات قديمة أبدًا |

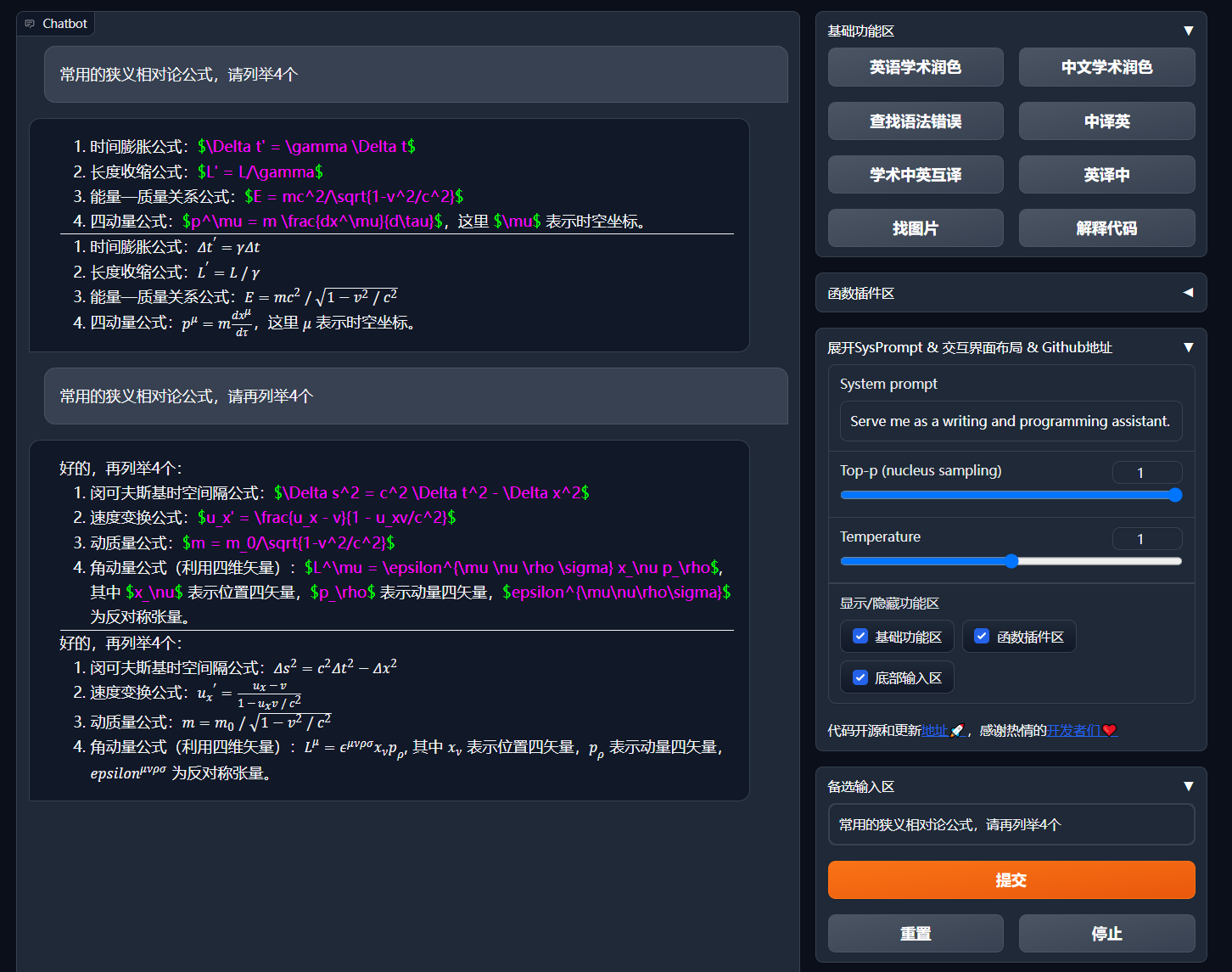

| صيغة/صورة/نموذج عرض | يمكنك عرض الصيغة وتقديم نموذج الصيغة في نفس الوقت ، ودعم تمييز الصيغة والرمز |

| ابدأ موضوع الظلام | إضافة /?__theme=dark |

| دعم نموذج Multi LLM | في الوقت نفسه ، يجب أن يكون الشعور بتقديمه بواسطة GPT3.5 و GPT4 و Tsinghua chatglm2 و Fudan Moss جيدًا؟ |

| المزيد من الوصول إلى طراز LLM ، ودعم نشر المعانقة | انضم إلى واجهة Newbing (جديدة يجب) ، قدم Tsinghua jittorllms لدعم Llama و Pangu α |

| حزمة PIP باطلة الطرف | مغادرة واجهة المستخدم الرسومية ، اتصل مباشرة بجميع قابس الوظائف -في العنصر في بيثون (قيد التطوير) |

| المزيد من عرض الميزات الجديدة (توليد الصور ، وما إلى ذلك) ... | انظر نهاية هذا المقال ... |

config.py لتحقيق "تخطيط مباشر اليسار" و "التخطيط العلوي والسفلي" "التبديل")

مخطط انسيابي TD

A {"طريقة التثبيت"} -> W1 ("i.؟ قم بتشغيل مباشرة (Windows أو Linux أو MacOS)")))

W1-> W11 ["1. الاعتماد على إدارة حزمة Python PIP"]

W1-> W12 ["2. تبعيات إدارة حزم أناكوندا (توصية)"]]]]]

A -> W2 ["II.؟ استخدم Docker (Windows ، Linux أو MacOS)"]]]

W2-> K1 ["1. صورة مرآة كبيرة نشر جميع القدرات (التوصية)"]]]]

W2-> K2 ["2. Model Online فقط (GPT ، GLM4 ، إلخ) مرآة"]]

W2-> K3 ["3. Model Online+ LaTex's Large Mirror"]

A -> W4 ["IV. طرق نشر أخرى"]]]

W4-> C1 ["1. Windows/MacOS One -click تثبيت وتشغيل البرنامج النصي (توصية)"]

W4-> C2 ["2. Huggingface ، النشر عن بُعد لـ Sealos"]]]]

W4-> C4 ["3. ... أخرى ..."]]

تنزيل المشروع

git clone --depth=1 https://github.com/binary-husky/gpt_academic.git

cd gpt_academicتكوين api_key والمتغيرات الأخرى

في config.py ، تكوين المتغيرات مثل مفتاح API. طريقة إعداد بيئة الشبكة الخاصة ، وصف تكوين Wiki-Project.

"سيعطي البرنامج أولوية للتحقق مما إذا كان هناك ملف تكوين خاص يسمى config_private.py ، وتكوين نفس الاسم مع تكوين config.py . config_private.py config_private.py config.py .

"دعم عنصر التكوين环境变量، راجع ملف docker-compose.yml أو صفحة wiki الخاصة بنا من تنسيق الكتابة لمتغير البيئة. القراءة تكوين أولوية:环境变量> config_private.py > config.py ".

الاعتماد على التثبيت

# (选择I: 如熟悉python, python推荐版本 3.9 ~ 3.11)备注:使用官方pip源或者阿里pip源, 临时换源方法:python -m pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple/

python -m pip install -r requirements.txt

# (选择II: 使用Anaconda)步骤也是类似的 (https://www.bilibili.com/video/BV1rc411W7Dr):

conda create -n gptac_venv python=3.11 # 创建anaconda环境

conda activate gptac_venv # 激活anaconda环境

python -m pip install -r requirements.txt # 这个步骤和pip安装一样的步骤[خطوات اختيارية] إذا كنت بحاجة إلى دعم tsinghua chatglm3/fudan moss كنهاية خلفية ، فأنت بحاجة إلى تثبيت المزيد من التبعيات (المتطلب المسبق: على دراية بـ python + pytorch + تكوين الكمبيوتر):

# 【可选步骤I】支持清华ChatGLM3。清华ChatGLM备注:如果遇到"Call ChatGLM fail 不能正常加载ChatGLM的参数" 错误,参考如下: 1:以上默认安装的为torch+cpu版,使用cuda需要卸载torch重新安装torch+cuda; 2:如因本机配置不够无法加载模型,可以修改request_llm/bridge_chatglm.py中的模型精度, 将 AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True) 都修改为 AutoTokenizer.from_pretrained("THUDM/chatglm-6b-int4", trust_remote_code=True)

python -m pip install -r request_llms/requirements_chatglm.txt

# 【可选步骤II】支持复旦MOSS

python -m pip install -r request_llms/requirements_moss.txt

git clone --depth=1 https://github.com/OpenLMLab/MOSS.git request_llms/moss # 注意执行此行代码时,必须处于项目根路径

# 【可选步骤III】支持RWKV Runner

参考wiki:https://github.com/binary-husky/gpt_academic/wiki/%E9%80%82%E9%85%8DRWKV-Runner

# 【可选步骤IV】确保config.py配置文件的AVAIL_LLM_MODELS包含了期望的模型,目前支持的全部模型如下(jittorllms系列目前仅支持docker方案):

AVAIL_LLM_MODELS = [ " gpt-3.5-turbo " , " api2d-gpt-3.5-turbo " , " gpt-4 " , " api2d-gpt-4 " , " chatglm " , " moss " ] # + ["jittorllms_rwkv", "jittorllms_pangualpha", "jittorllms_llama"]

# 【可选步骤V】支持本地模型INT8,INT4量化(这里所指的模型本身不是量化版本,目前deepseek-coder支持,后面测试后会加入更多模型量化选择)

pip install bitsandbyte

# windows用户安装bitsandbytes需要使用下面bitsandbytes-windows-webui

python -m pip install bitsandbytes --prefer-binary --extra-index-url=https://jllllll.github.io/bitsandbytes-windows-webui

pip install -U git+https://github.com/huggingface/transformers.git

pip install -U git+https://github.com/huggingface/accelerate.git

pip install peftpython main.py جميع إمكانيات نشر المشاريع (هذه مرآة كبيرة تحتوي على CUDA و LaTex. ولكن إذا كان لديك سرعة شبكة بطيئة وقرص ثابت صغير ، فلا ينصح بهذه الطريقة لنشر عنصر كامل)

# 修改docker-compose.yml,保留方案0并删除其他方案。然后运行:

docker-compose up فقط chatgpt + glm4 + wenxin قال + سبارك ونماذج أخرى عبر الإنترنت (يوصى به معظم الناس)

# 修改docker-compose.yml,保留方案1并删除其他方案。然后运行:

docker-compose upإذا احتاج PS إلى الاعتماد على وظيفة المكونات اللاتكس ، انظر Wiki. بالإضافة إلى ذلك ، يمكنك أيضًا استخدام المخطط 4 أو المخطط 0 للحصول على وظيفة LaTeX.

chatgpt + glm3 + moss + llama2 + Tongyi Qianwen (يجب أن تكون على دراية بـ nvidia docker عند الجري)

# 修改docker-compose.yml,保留方案2并删除其他方案。然后运行:

docker-compose upWindows One -Craint Trick . يمكن لمستخدمي Windows الذين ليسوا على دراية تمامًا ببيئة Python تنزيل البرنامج النصي الذي يتم نشره في الإصدار المنشور في الإصدار لتثبيت إصدار بدون طرز محلية. مصدر مساهمة البرنامج النصي: Oobabooga.

استخدم API -party -party ، Azure ، وما إلى ذلك ، Wen Xinyi ، Star Fire ، وما إلى ذلك ، انظر صفحة الويكي

نشرت الخوادم السحابية عن بعد الإرشادات لتجنب الحفرة. يرجى زيارة ويكي النشر عن بُعد الخادم السحابي

نشر على منصات أخرى ونشر عنوان URL الثانوي

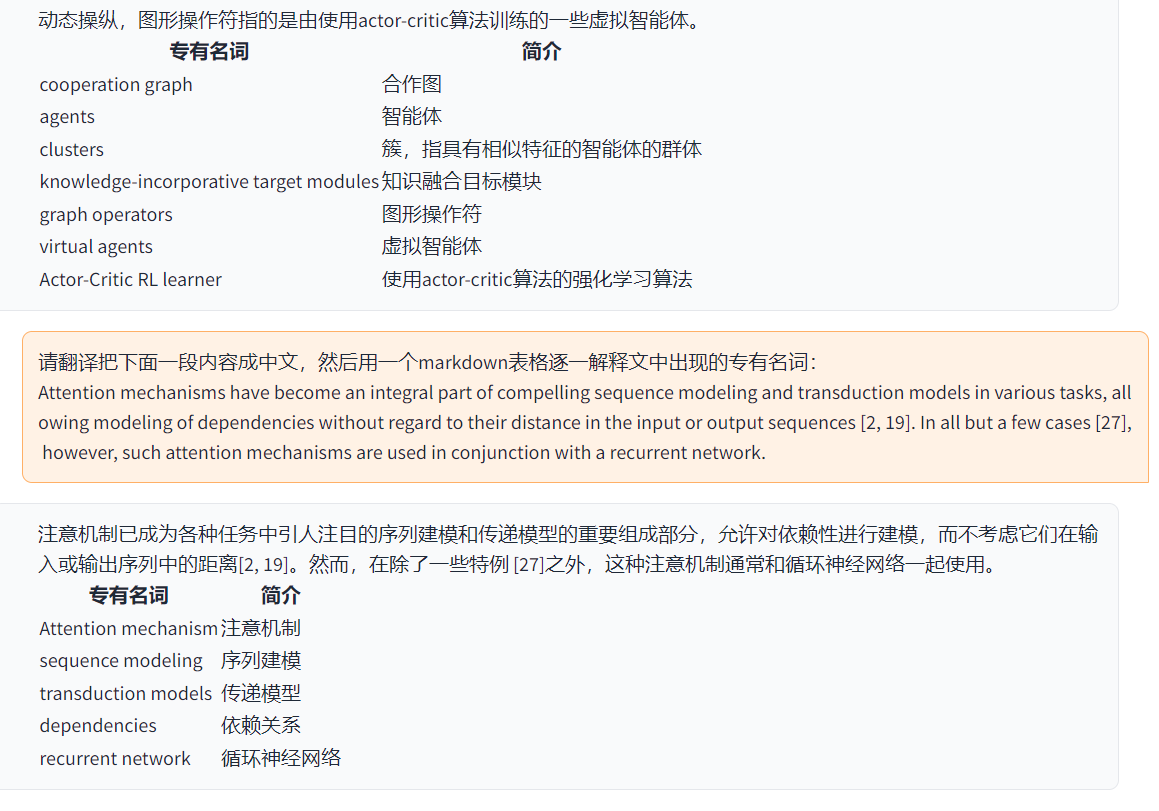

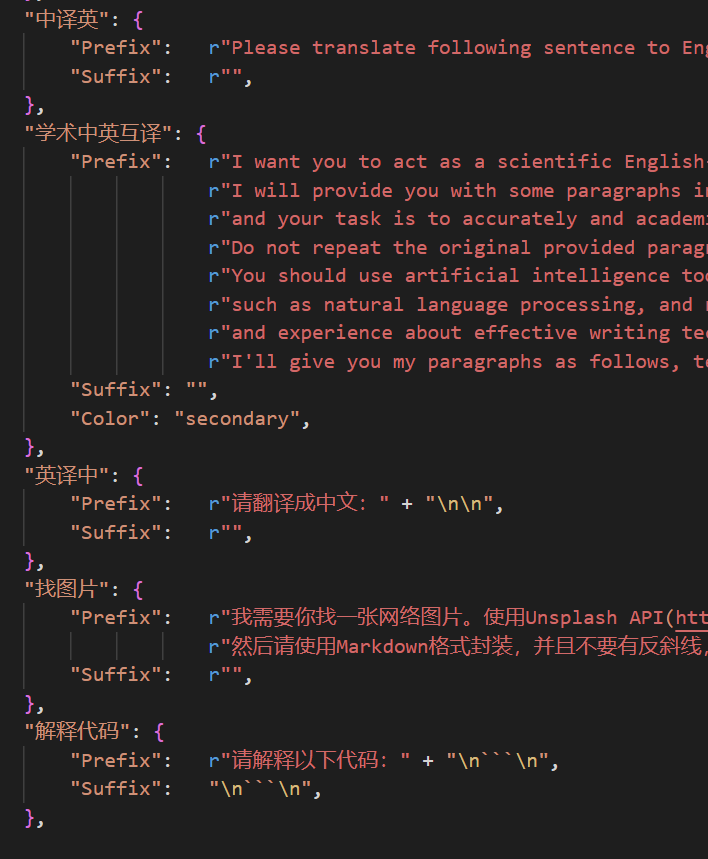

http://localhost/subpath ). يرجى زيارة تعليمات تشغيل fastapi يمكنك الآن إضافة زر جديد مناسب إلى自定义菜单في قائمة界面外观في واجهة المستخدم. إذا كنت بحاجة إلى تعريفه في الكود ، فاستخدم أي محرر نصوص لفتح core_functional.py ، إضافة الإدخالات التالية:

"超级英译中" : {

# 前缀,会被加在你的输入之前。例如,用来描述你的要求,例如翻译、解释代码、润色等等

"Prefix" : "请翻译把下面一段内容成中文,然后用一个markdown表格逐一解释文中出现的专有名词: n n " ,

# 后缀,会被加在你的输入之后。例如,配合前缀可以把你的输入内容用引号圈起来。

"Suffix" : "" ,

},

اكتب قابسًا قويًا للدالة -في إجراء أي مهام تريدها وبشكل غير متوقع. المكونات وتصحيح هذا المشروع منخفض للغاية. للحصول على التفاصيل ، يرجى الرجوع إلى دليل المكونات الوظيفية.

保存当前的对话في قابس الوظيفة في المنطقة لحفظ الحوار载入对话历史存档كملفات HTML قابلة للاسترداد.载入对话历史存档لاستعادة الجلسة السابقة. نصيحة: إذا لم تحدد الملف ، فانقر载入对话历史存档لعرض ذاكرة التخزين المؤقت للأرشيف HTML التاريخية.

===>

===>

config.py )

===>

===>

GPT Academic Developer QQ Group: 610599535

requirement.txt لتثبيت Gradio الجدول الزمني LR

العنوان GPT-Academic Development عملية القسم 2.x

1.0 ~ 2.2: الوظيفة الأساسية: إدخال توصيل الوظيفة المعيارية -في: التخطيط القابل للطي: قابس الوظيفة -يدعم الحمل الحراري 2.3 ~ 2.5: تعزيز التفاعل متعدد الخيوط: PDF جديد كامل -وظيفة ترجمة النص: وظيفة تبديل منطقة الإدخال الجديدة: محدث 2.6: إعادة بناء المكونات في البنية: تحسين التفاعل: إضافة المزيد من القسم -في القسم 3.x

3.0 ~ 3.1: دعم chatGLM: دعم LLM صغير آخر: دعم نماذج GPT متعددة في نفس الوقت: دعم توازن التحميل المتعدد apikey 3.2 ~ 3.3: تدعم توصيل الوظائف المزيد من واجهة المعلمة: حفظ وظيفة الحوار: تفسير أي رمز لغة: في الوقت نفسه ، اسأل أي مجموعة LLM: معلومات الإنترنت شاملة الوظيفة 3.4: انضم إلى أطروحة Arxiv: إضافة وظيفة تصحيح أطروحة اللاتكس 3.44: يدعم رسميًا Azure: واجهة محسّنة سهلة الاستخدام 3.46: نموذج مرشح ChatGlm2 المخصص: حوار صوت حقيقي -وقت 3.49: دعم Alida Mo Yuan Tongyi Qian Qian: Shanghai Ai-Lab Scholar: Xun Fei Xinghuo: دعم Baidu Qianfan Platform و Wenxin A Word 3.50: FOID TREPLIAL : استقرار التحسين: حل مشكلة الصراع متعدد المستخدمين 3.55: مترجم رمز ديناميكي: إعادة بناء الواجهة الأمامية: مقدمة من Windows و MENAND BAR 3.56: زر الوظيفة الأساسية الإضافية الديناميكية: تقرير جديد PDF صفحة 3.57: GLM3 ، Star Fire V3: دعم Wenxinyi يتحدث V4: إصلاح الأخطاء المتزامنة للنموذج المحلي

3.60: مقدمة في Autogen

3.70: تقديم رسم حورية البحر: تنفيذ وظائف مثل GPT Brain Drawing 3.80 (TODO): قابس تلقائي محسّن -السمة: قابس مشتق التصميم -في يمكنك تغيير السمات عن طريق تعديل THEME

Chuanhu-Small-and-Beautifulmaster : الفرع الرئيسي ، نسخة مستقرةfrontier : فرع التنمية ، نسخة اختبار代码中参考了很多其他优秀项目中的设计,顺序不分先后:

# 清华ChatGLM2-6B:

https://github.com/THUDM/ChatGLM2-6B

# 清华JittorLLMs:

https://github.com/Jittor/JittorLLMs

# ChatPaper:

https://github.com/kaixindelele/ChatPaper

# Edge-GPT:

https://github.com/acheong08/EdgeGPT

# ChuanhuChatGPT:

https://github.com/GaiZhenbiao/ChuanhuChatGPT

# Oobabooga one-click installer:

https://github.com/oobabooga/one-click-installers

# More:

https://github.com/gradio-app/gradio

https://github.com/fghrsh/live2d_demo