ComfyUI NSFW Detection

1.0.0

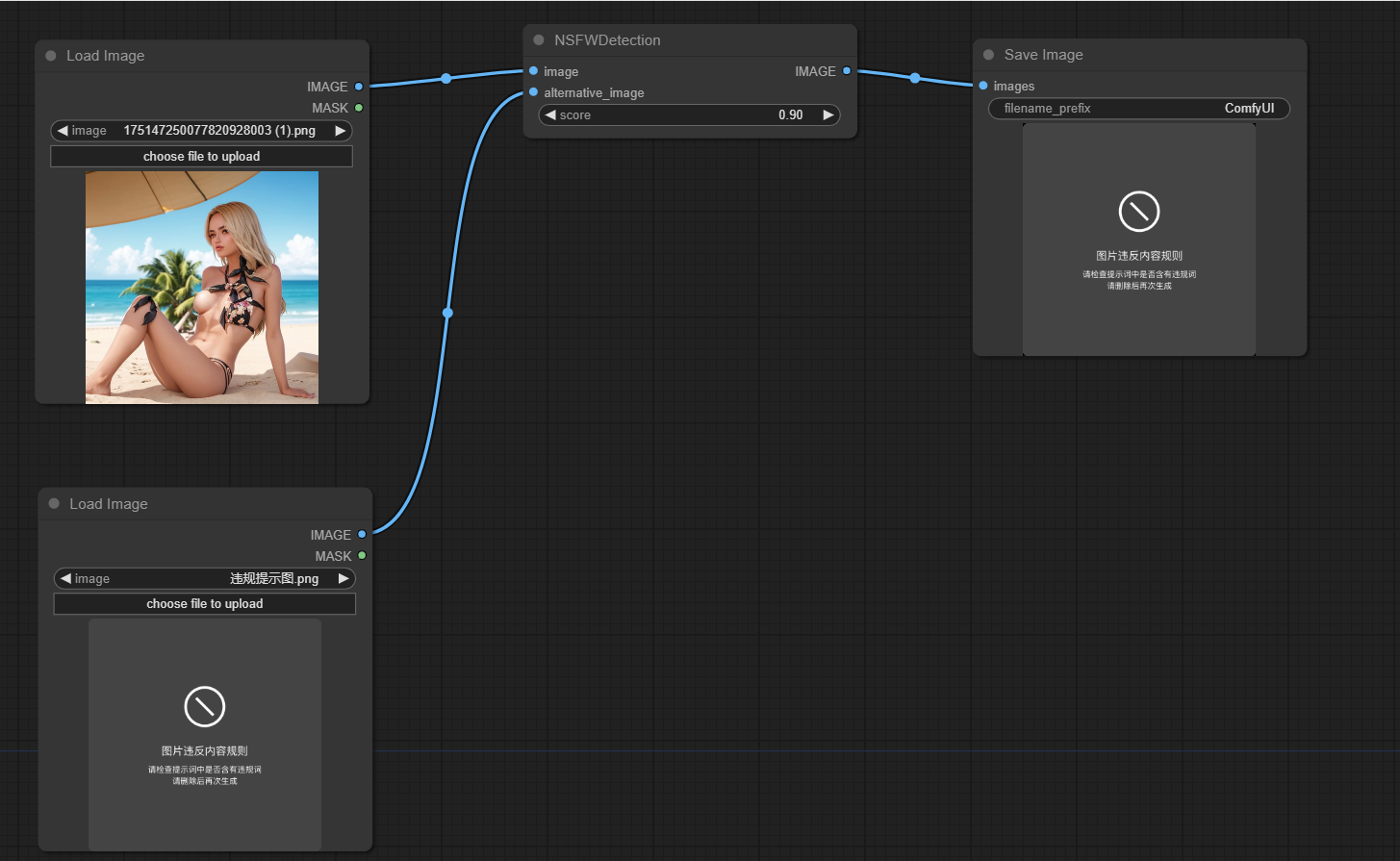

تم تصميم هذا المشروع لاكتشاف ما إذا كانت الصور التي تم إنشاؤها بواسطة Comfyui ليست آمنة للعمل (NSFW). يستخدم نموذج تعلم الآلة لتصنيف الصور إما على أنها آمنة أو غير آمنة للعمل. إذا تم تصنيف صورة على أنها NSFW ، يتم إرجاع صورة بديلة.

استنساخ هذا الريبو في دليل custom_nodes لموقع comfyui

تشغيل PIP تثبيت -r متطلبات. txt

يتم تغليف الوظيفة الرئيسية للمشروع في فئة NSFWDetection في ملف node.py تحتوي هذه الفئة على طريقة run تأخذ ثلاث معلمات:

image : الصورة المراد تصنيفها.score : درجة العتبة لتصنيف صورة على أنها NSFW.alternative_image : الصورة المراد إرجاعها إذا تم تصنيف صورة الإدخال على أنها NSFW.

https://github.com/trumanwong/comfyui-nsfw-detection/blob/main/workflow.json

المساهمات موضع ترحيب. يرجى إرسال طلب سحب إذا كان لديك أي تحسينات أو إصلاحات الأخطاء.

هذا المشروع مرخص بموجب شروط ترخيص معهد ماساتشوستس للتكنولوجيا.