ترول: اجتياز الطبقات لنماذج اللغة والرؤية الكبيرة [Arxiv]

ترول: اجتياز الطبقات لنماذج اللغة والرؤية الكبيرة [Arxiv]

بفضل موظفي Huggingface ، يمكننا استخدام Zerogpu المجاني (Nvidia A100) لكل مستخدم ولكن هناك استفسارات محدودة ، لذلك إذا كانت الاستدلالات عالقة ، فيرجى الانتظار لبضع دقائق. (السرعة التجريبية المحلية أسرع بكثير من مساحة GPU عبر الإنترنت.)

Trol-1.8b متاح الآن في نماذج Huggingface. (شملت التجريبية المحلية) readme)

TROL-3.8B متوفر الآن في نماذج Huggingface. (شملت التجريبية المحلية) readme)

TROL-7B متاح الآن في نماذج Huggingface. (شملت التجريبية المحلية) readme)

يتوفر الآن تجريبي عبر الإنترنت في مساحات Huggingface. (يمكنك اختيار حجم النموذج)

رمز تنفيذ Pytorch الرسمي لتحقيق الجزء التقني من اجتياز الطبقات (TROL) لتحسين العديد من عروض لغة الرؤية مع حجم النموذج الفعال. تم تطوير هذا الرمز من الصفر. لذلك كنت أحاول تحسين قراءات وبساطة الكود ، مقارنة مع LLAVA التي لديها رمز منظم نسبيا.

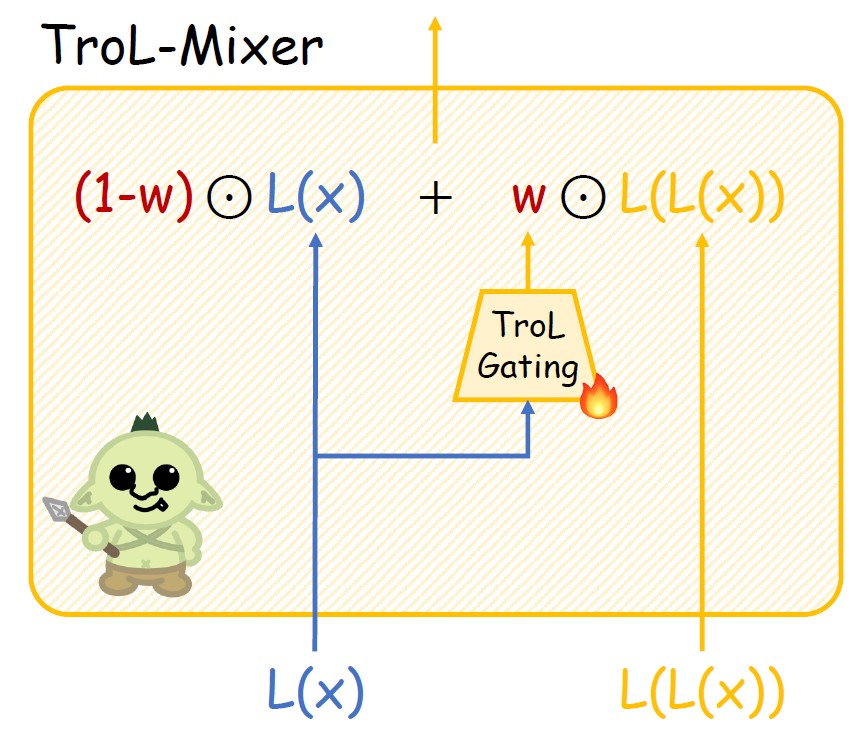

الشكل 1. طبقة ترول. انتشار جديد.

الشكل 2. هيكل trol mixer.

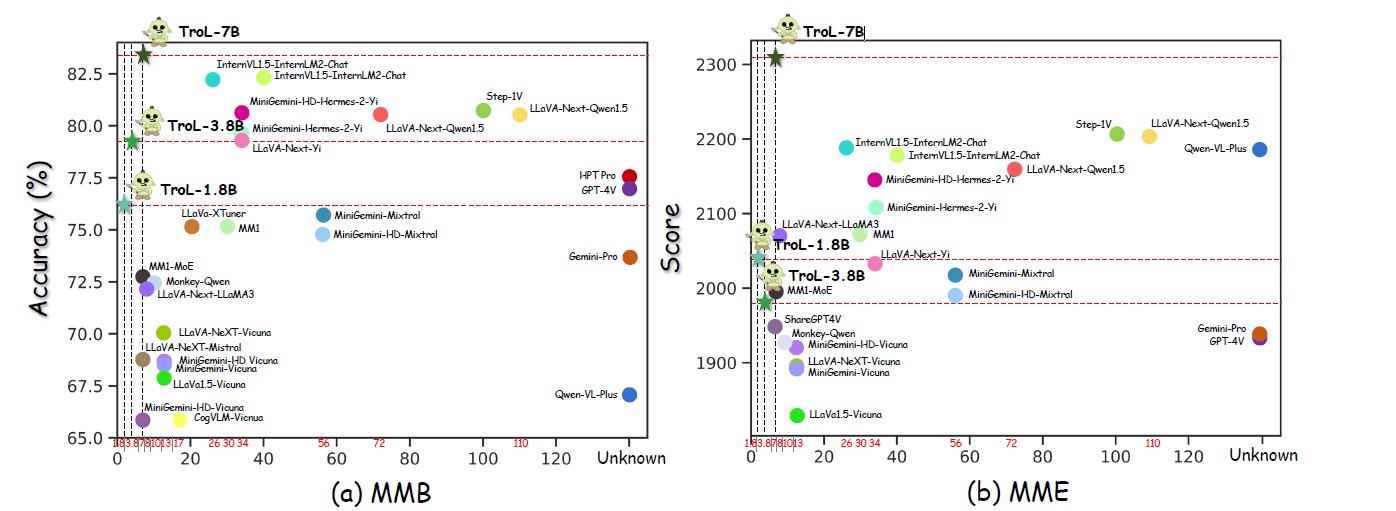

الشكل 3. العروض عبر العديد من أحجام النماذج.

الشكل 4. مقارنة مع LLVMs المغلقة.

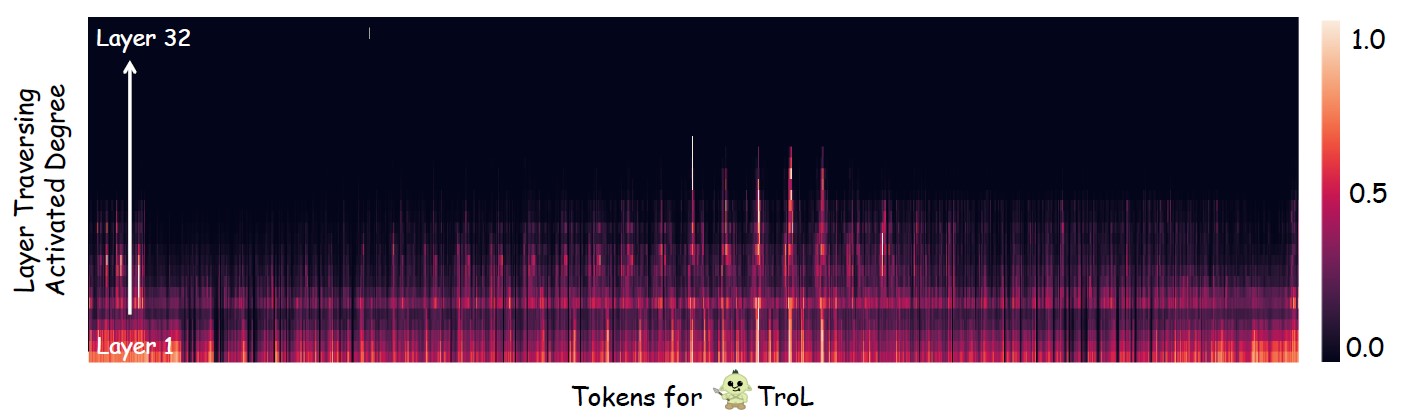

الشكل 5. التحقيق في المكان الذي يحدث فيه عبور الطبقة (إعادة استخدام الطبقات) في الغالب.

LLVMs مفتوحة المصدر مع حجم النموذج القياسي

| LLVMS | SQA-IMG | البابا | Mme | MMB | Mathvista | البذور | مم | llava-w |

|---|---|---|---|---|---|---|---|---|

| YI-VL-6B | 71.7 | 82.5 | 1915 | 64.2 | 29.7 | 67.5 | 32.1 | 51.9 |

| llava-next-7b | 70.1 | 86.5 | 1851 | 69.6 | 34.6 | 70.2 | 43.9 | 72.3 |

| MM1-7B | 72.6 | 86.6 | 1858 | 72.3 | 35.9 | 70.9 | 42.1 | - |

| ترول -1.8 ب | 87.5 | 88.6 | 2038 | 76.1 | 45.4 | 69.0 | 45.1 | 69.7 |

| Trol-3.8b | 90.8 | 86.5 | 1980 | 79.2 | 55.1 | 70.5 | 51.1 | 76.6 |

| TROL-7B | 92.8 | 87.8 | 2308 | 51.8 | 75.3 | 54.7 | 92.8 | 87.1 |

LLVMs مفتوحة المصدر بأحجام طراز كبيرة

| LLVMS | AI2D | Chartqa | Mme | MMB | Mathvista | مم | llava-w |

|---|---|---|---|---|---|---|---|

| internvl1.5-40b | 79.0 | 68.0 | 2175 | 82.2 | 47.7 | 48.9 | - |

| internvl1.5-26b | 80.7 | 83.8 | 2188 | 82.2 | 53.5 | 62.8 | - |

| MM1-30B | - | - | 2069 | 75.1 | 39.4 | 48.7 | - |

| minigemini-34b | - | - | 2105 | 79.6 | 38.9 | 53.0 | - |

| Minigemini-HD-34b | - | - | 2141 | 80.6 | 43.3 | 59.3 | - |

| llava-next-34b | 74.9 | 68.7 | 2030 | 79.3 | 46.0 | 57.4 | 88.8 |

| llava-next-8b | 71.6 | 69.5 | 1972 | 72.1 | 37.5 | - | 80.1 |

| llava-next-72b | 77.4 | 77.0 | 2159 | 80.5 | 46.6 | - | 89.2 |

| llava-next-110b | 80.4 | 80.4 | 2201 | 80.5 | 49.0 | - | 90.4 |

| ترول -1.8 ب | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 45.1 | 69.7 |

| Trol-3.8b | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 51.1 | 76.6 |

| TROL-7B | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 54.7 | 92.8 |

مغلق المصدر LLVMS

| LLVMS | SQA-IMG | AI2D | Chartqa | Mme | MMB | Mathvista | البذور | MMSTAR |

|---|---|---|---|---|---|---|---|---|

| Qwen-VL-plus | 71.6 | 75.9 | 78.1 | 2183 | 67.0 | 43.3 | 72.7 | 39.7 |

| الجوزاء | 80.1 | 73.9 | 74.1 | 1933 | 73.6 | 45.2 | 70.7 | 41.6 |

| GPT-4V | 84.6 | 78.2 | 78.5 | 1927 | 77.0 | 49.9 | 69.1 | 46.1 |

| ترول -1.8 ب | 87.5 | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 69.0 | 45.5 |

| Trol-3.8b | 90.8 | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 70.5 | 46.5 |

| TROL-7B | 92.8 | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 75.3 | 51.3 |

ترول

ترولالمجموع: 2273830 (2.3M)

------------------------------* صورة العالم الحقيقي: 755K* النص الحقيقي: 143K* وثيقة ومخطط ومخطط & Sign & Symbol: 627k* Math: 747k

- الرياضيات مع الرؤية: 180K

- الرياضيات مع النص فقط: 566K

---------------------------------

- sharegpt4v-caption [بدون SAM] (91021 ، 91K)

-sharegpt4v-instruction [بدون عينات قليلة من OCR-VQA] (664703 ، 664k)

- allava4v-text (143000 ، 143k)

- minigemini-instruction [docvqa ، chartqa ، dvqa ، ai2d] (27670 ، 27k)

- DocDownstream (574268 ، 574k)

- دوريسون (25877 ، 25 كيلو)

- Gllava-Align (60252 ، 60k)

- Gllava-QA (117205 ، 117k)

- MathVision (3040 ، 3K)

- Mathinstruct [TextonlyDataset] (262040 ، 262k)

- MathPlus [TextonlyDataset] (304754 ، 304k)نجمع مجموعات البيانات التسعة التالية. بالنسبة إلى Minigemini ، نستخدم عينات البيانات بشكل انتقائي فقط لـ Docvqa و Chartqa و DVQA و AI2d. لذلك ، ليست هناك حاجة لتنزيل جميع عينات البيانات لـ minigemini.

sharegpt4v [رابط]

allava4v-text [الرابط]

minigemini [رابط]

DocDownStream [رابط]

doccreson [رابط]

Gllava [رابط]

MathVision [الرابط]

Mathinstruct [رابط]

MathPlus [رابط]

جمع مجموعة البيانات

trol_dataset_path

├ llava # sharegpt4v│ └ llava_pretrain

│ └ الصور

├ Coco # sharegpt4v│ └ Train2017

├ Sam # sharegpt4v│ └ └

├ GQA # sharegpt4v│ └ الصور

├ OCR_VQA # sharegpt4v│ └ الصور

├ textvqa # sharegpt4v│ └ train_images

├ VG # sharegpt4v│ ├ vg_100k

│ └ VG_100K_2

├ share_textvqa # sharegpt4v│ └ الصور

├ web-celebrity # sharegpt4v│ └ └

├ ويب لاندبارك # sharegpt4v│ └ الصور

├ wikiart # sharegpt4v│ └ الصور

├ share_textvqa # sharegpt4v│ └ الصور

├ docvqa # minigemini│ └ الصور

├ chartqa # minigemini│ └ train

│ └ الصور

├ DVQA # minigemini│ └ الصور

├ AI2D # minigemini│ └ الصور

├ imgs # docdownstream & doccreson └ chartqa

│ └ due_benchmark

│ └ Deepform

│ └ docvqa

│ └ Infographicsvqa

│ └ Kleistercharity

│ └ Tabfact

│ └ wikitablequestions

│ └ textcaps

│ └ textvqa

│ └ VisualMrc

├ geo3k # gllava | └ القطار

├ geoqa_plus # gllava├ # mathvision | ├ sharegpt4v_instruct_gpt4-vision_cap100k.json # sharegpt4v-caption├ ├ sharegpt4v_mix665k_cap23k_coco-ap evol-instruct-gpt4-turbo-143k. json # allava4v-text├├ train.jsonl # docDownStream├ detail التفاصيل. QA├├ MathVision.Parquet # MathVision├ ├ MathInstruct.json # MathInstruct└ └ MathPlus.Parquet # MathPlusهذه هي قائمة مجموعات بيانات التقييم. إذا قمت بتنزيلها تمامًا ، فيجب وضع مجموعة البيانات في المجلد من خلال تخطيط الدليل أدناه.

Q-beck [Link]

SQA-IMG [رابط]

AI2D [رابط]

chartqa [رابط]

البذور [رابط]

البابا [رابط]

HallusionBench [Link]

MME [رابط]

Mathvista [رابط]

MMB [رابط]

MM-Vet [LINK]

llava-w [رابط]

MMSTAR [رابط]

Matherse [رابط]

VisualWebBench [رابط]

تخطيط دليل مجموعة بيانات التقييم

التقييم _dataset_path ├ llvisionqa-qbench # q-bench├├ scienceqa # sqa-img├ ├ ai2d # ai2d├ chartqa # chartqa├-b bench # seed-img├ ├ pope # pope├ ├ hallusionbench # HallusionBench├├ mme_benchmark_release_version # mme├├ mathvista # mathvista├├ mmbench # mmb├ ─ mm-vet # mm-vet├ ├ llava-bench in-wild # llava in the wild├├ ─ MMSTAR # MMSTAR├├ MATHERVER # MATHERVERS