إنشاء الألعاب والبرامج باستخدام وكلاء Openai. بنيت على قمة Microsoft Autogen.

️ العمل قيد التقدم

الرمز الحالي يعمل ولكن:

- هناك ، وسيكون هناك تغييرات كسر:

- تحقق دائمًا من أن ملفك

.env.jsoncenv.sample.jsonc- قم دائمًا بتحديث تبعياتك عبر

poetry install.- يجب أن يتم تحسين الكثير من الأشياء من أجل تقليل استخدام الرموز الرمزية بشكل كبير: التخزين المؤقت ، وعملية خطوة على حدة ، وتقسيم المحادثة ، ومطالبات أفضل.

- الرمز يحتاج إلى بعض التنظيف.

- لا يزال Microsoft Autogen في المرحلة المبكرة ويحتوي على بعض الأخطاء.

- يمكن تخصيص الكثير من الأشياء المرمزة من خلال ملفات التكوين.

- سأركز فقط على بعض لغات البرمجة في البداية.

هناك بعض المشاريع المذهلة التي تقوم بأشياء مماثلة ، لكنني آمل أن أجد طريقة لحل توليد البرامج الطموحة.

تحتاج إما إلى مفتاح Openai API أو مفتاح Azure Openai API.

لا تعتمد على GPT-3.5 ، سواء كانت turbo أو قياسية ، لأكثر من مجرد برامج "عينة". إذا كنت تهدف إلى تطبيقات أكثر تعقيدًا ، فإن GPT-4 أمر لا بد منه ، ويفضل حتى GPT-4-32k .

قد يؤدي استخدام API Openai إلى استنفاد حد الرمز المميز بسرعة. لمزيد من المشاريع واسعة النطاق ، يوصى Azure Openai API.

كن على دراية بالتكاليف إذا كان لديك أهداف طموحة! راقب دائمًا استخدام الرموز وما يفعله وكلاءك. على الرغم من أن الذكاء الاصطناعي يمكن أن يكون أداة قوية ، إلا أنها ليست بالضرورة أرخص من توظيف مطورين حقيقيين - حتى الآن؟

conda create -n autogen python=3.10

conda activate autogen

pip install poetry

poetry install

cp env.sample.jsonc env.jsonc قم بتحرير env.json لإضافة مفاتيح API وتخصيص التثبيت.

فقط:

make run ستقوم OADS بإنشاء رمز مصدر البرنامج تلقائيًا في دليل ./project .

يمكنك تنظيفه عبر:

make cleanهام: الوظائف لن تعمل.

من ما قمت باختباره ، يبدو أن Autogen يعمل مع أي LLM مفتوح المصدر مدعوم من قبل توليد النص ويب واجهة المستخدم.

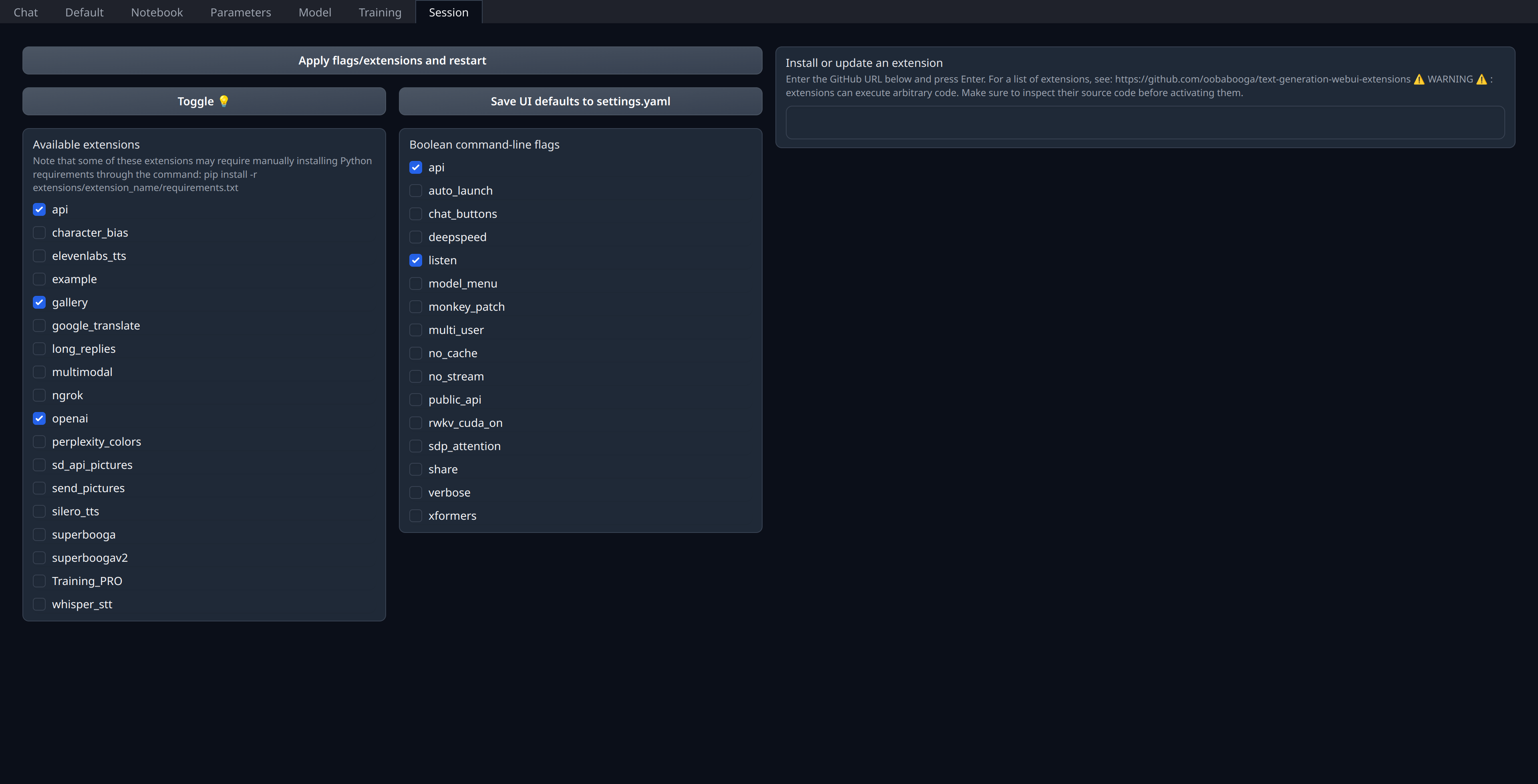

عليك فقط تمكين تمديد openai في علامة التبويب "Session" من واجهة المستخدم على الويب:

تأكد من فتح منفذ 5001 الخاص بك أو الازدحام إذا كان خادمًا عن بُعد لأن هذا هو المكان الذي سيتم فيه كشف واجهة برمجة التطبيقات الشبيهة بـ Openai.

أنا شخصياً نشر نماذجاتي الحالية على Runpod (غير تابعة) وأستخدم thebloke/cuda11.8.0-ubuntu22.04-oneclick:latest صورة على الرغم من أنني أعتقد أنها تبدو قديمة بعض الشيء فيما يتعلق llama.cpp & co.

"models" : [

// Custom deployment of (for example) `Open-Orca/Mistral-7B-OpenOrca`

// using "Text generation web UI" with `OpenAI` extension enabled:

// https://github.com/oobabooga/text-generation-webui/tree/main/extensions/openai#an-openedai-api-openai-like

// This can be any inference endpoint compatible following OpenAI API specs,

// regardless of the model you use behind it.

{

"model" : "Open-Orca/LlongOrca-13B-16k" ,

"api_base" : "http://localhost:5001" , // Or your remote server URL

"api_key" : "sk-111111111111111111111111111111111111111111111111" ,

"api_type" : "open_ai"

}

] ,