Ein einfaches und benutzerfreundliches Sprachänderungs-Framework basierend auf VITS

Protokoll aktualisieren | . AutoDL·5 Cent zum Trainieren von KI- Sängern |

Englisch |中文简体|日本语( Koreanisch ) |

Das Basismodell wird mit fast 50 Stunden hochwertigem Open-Source-VCTK-Trainingsset trainiert. Es bestehen keine Urheberrechtsbedenken.

Bitte freuen Sie sich auf das untere Modell von RVCv3, das größere Parameter, größere Daten, bessere Ergebnisse, grundsätzlich die gleiche Inferenzgeschwindigkeit und weniger Trainingsdaten erfordert.

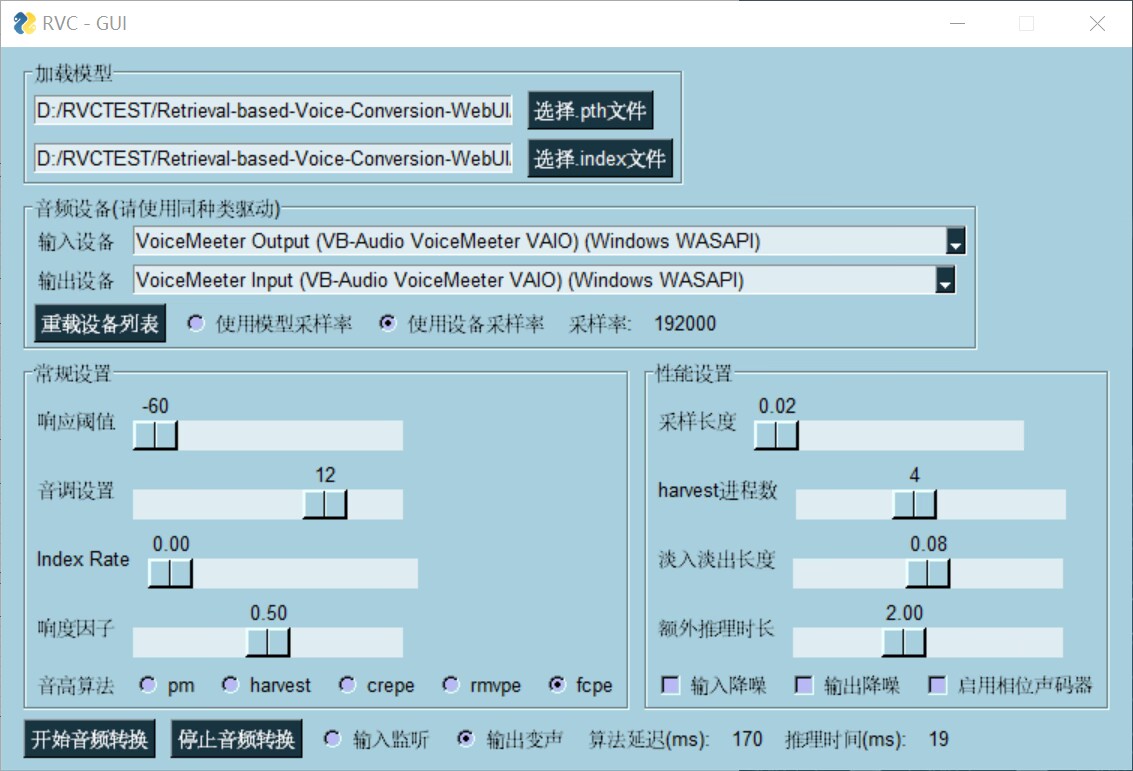

| Trainingsinferenzschnittstelle | Schnittstelle zur Sprachänderung in Echtzeit |

|  |

| go-web.bat | go-realtime-gui.bat |

| Sie können frei wählen, was Sie tun möchten. | Wir haben eine End-to-End-Latenz von 170 ms erreicht. Wenn Sie ASIO-Eingabe- und Ausgabegeräte verwenden, können Sie eine durchgängige Latenz von 90 ms erreichen, dies hängt jedoch stark von der Hardware-Treiberunterstützung ab. |

Dieses Lager weist die folgenden Eigenschaften auf

Verwenden Sie die Top1-Suche, um Eingabequellenfunktionen durch Trainingssatzfunktionen zu ersetzen und so Klangverluste zu verhindern

Schnelles Training auch auf relativ schlechten Grafikkarten

Auch die Verwendung einer kleinen Datenmenge für das Training kann zu besseren Ergebnissen führen (es wird empfohlen, mindestens 10 Minuten rauscharme Sprachdaten zu sammeln).

Die Klangfarbe kann durch Modellfusion geändert werden (mit Hilfe von ckpt-merge im Reiter „ckpt processing“).

Einfache und benutzerfreundliche Weboberfläche

Das UVR5-Modell kann aufgerufen werden, um Gesang und Begleitung schnell zu trennen

Verwenden Sie den fortschrittlichsten Algorithmus zur Tonhöhenextraktion menschlicher Stimmen, InterSpeech2023-RMVPE, um das Problem stummer Töne zu beseitigen. Funktioniert (erheblich) am besten, ist aber schneller und kleiner als crepe_full

Eine Karte mit Unterstützung für die Kartenbeschleunigung

Klicken Sie hier, um unser Demonstrationsvideo anzusehen!

Die folgenden Anweisungen müssen in einer Umgebung mit einer Python-Version größer als 3.8 ausgeführt werden.

Wählen Sie eine der folgenden Methoden.

Installieren Sie Pytorch und seine Kernabhängigkeiten. Überspringen Sie den Vorgang, falls bereits installiert. Referenz von: https://pytorch.org/get-started/locally/

Pip-Install Torch Torchvision Torchaudio

Wenn es sich um ein Win-System + Nvidia Ampere-Architektur (RTX30xx) handelt, müssen Sie gemäß der Erfahrung von #21 die Cuda-Version angeben, die Pytorch entspricht

pip install Torch Torchvision Torchaudio --index-url https://download.pytorch.org/whl/cu117

Installieren Sie die entsprechenden Abhängigkeiten entsprechend Ihrer eigenen Grafikkarte

N-Karte

pip install -r Anforderungen.txt

Eine Karte/I-Karte

pip install -r Anforderungen-dml.txt

Eine ROCM-Karte (Linux)

pip install -r Anforderungen-amd.txt

I-KarteIPEX(Linux)

pip install -r Anforderungen-ipex.txt

Installieren Sie das Poetry-Abhängigkeitsverwaltungstool. Überspringen Sie es, wenn es bereits installiert ist. Referenz von: https://python-poetry.org/docs/#installation

curl -sSL https://install.python-poetry.org |.

Bei der Installation von Abhängigkeiten über Poetry wird die Verwendung der Python-Versionen 3.7–3.10 empfohlen. Bei der Installation von llvmlite==0.39.0 kommt es zu Konflikten

Poesie init -n poety env verwende „Pfad zu deiner python.exe“poetry run pip install -r require.txt

Abhängigkeiten können über run.sh installiert werden

sh ./run.sh

RVC erfordert einige andere Vormodelle für Inferenz und Training.

Sie können diese Modelle aus unserem Hugging Face-Bereich herunterladen.

Nachfolgend finden Sie eine Liste mit den Namen aller Vormodelle und anderen für RVC erforderlichen Dateien. Die Skripte zum Herunterladen finden Sie im tools Ordner.

./assets/hubert/hubert_base.pt

./assets/pretrained

./assets/uvr5_weights

Wenn Sie das Versionsmodell v2 verwenden möchten, müssen Sie es zusätzlich herunterladen.

./assets/pretrained_v2

Überspringen, wenn ffmpeg und ffprobe bereits installiert sind.

sudo apt install ffmpeg

brew installiere ffmpeg

Legen Sie es nach dem Herunterladen im Stammverzeichnis ab.

Laden Sie ffmpeg.exe herunter

Laden Sie ffprobe.exe herunter

Wenn Sie den neuesten RMVPE-Algorithmus zur Tonhöhenextraktion verwenden möchten, müssen Sie die Parameter des Tonhöhenextraktionsmodells herunterladen und im RVC-Stammverzeichnis ablegen.

downloadrmvpe.pt

Laden Sie rmvpe.onnx herunter

Wenn Sie RVC auf einem Linux-System basierend auf der Rocm-Technologie von AMD ausführen möchten, installieren Sie bitte zuerst die erforderlichen Treiber hier.

Wenn Sie Arch Linux verwenden, können Sie Pacman verwenden, um die erforderlichen Treiber zu installieren:

pacman -S rocm-hip-sdk rocm-opencl-sdk

Bei einigen Grafikkartenmodellen müssen Sie möglicherweise zusätzlich die folgenden Umgebungsvariablen konfigurieren (z. B. RX6700XT):

export ROCM_PATH=/opt/rocm export HSA_OVERRIDE_GFX_VERSION=10.3.0

Stellen Sie außerdem sicher, dass Ihr aktueller Benutzer zu render und video gehört:

sudo usermod -aG render $USERNAME sudo usermod -aG video $USERNAME

Verwenden Sie den folgenden Befehl, um WebUI zu starten

Python infer-web.py

Wenn Sie zuvor Poetry zum Installieren von Abhängigkeiten verwendet haben, können Sie WebUI wie folgt starten

Poesie führt Python infer-web.py aus

Laden Sie RVC-beta.7z herunter und entpacken Sie es

Doppelklicken Sie auf go-web.bat

sh ./run.sh

Quelle /opt/intel/oneapi/setvars.sh