· Papier · Benchmark · Homepage · Dokument ·

✅ [25.07.2024] Visual PEFT Benchmark beginnt mit der Veröffentlichung von Datensätzen, Code usw.

✅ [20.06.2024] Die Visual PEFT Benchmark-Homepage wurde erstellt.

✅ [01.06.2024] Visual PEFT Benchmark-Repo wird erstellt.

Einführung

Erste Schritte

Codestruktur

Schnellstart

Ergebnisse und Kontrollpunkte

Gemeinschaft und Kontakt

Zitat

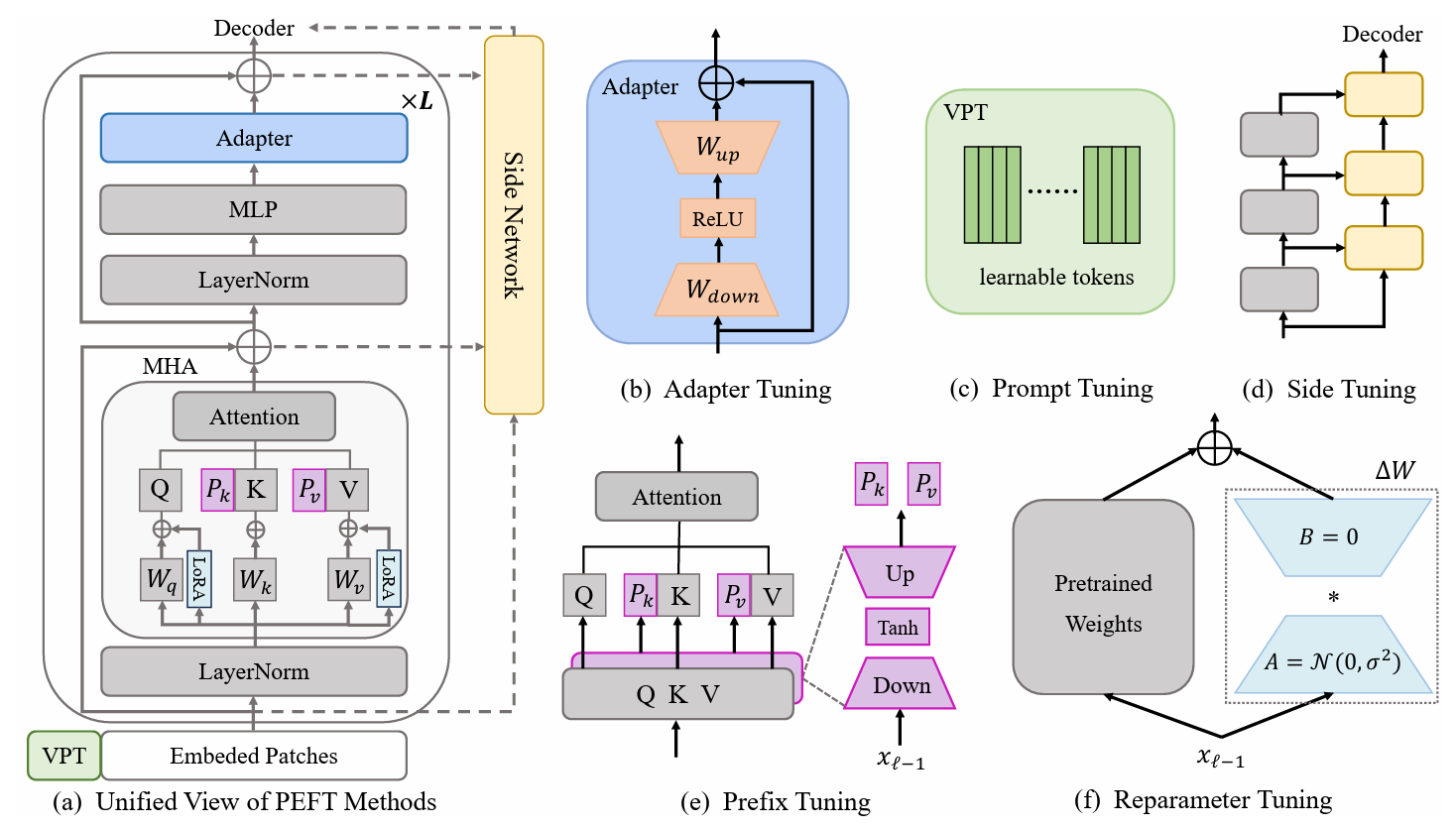

Methoden des Parametereffizienten Transferlernens (PETL) erweisen sich als vielversprechend, wenn es darum geht, ein vorab trainiertes Modell an verschiedene nachgelagerte Aufgaben anzupassen und dabei nur wenige Parameter zu trainieren. Im Bereich Computer Vision (CV) wurden zahlreiche PETL-Algorithmen vorgeschlagen, deren direkter Einsatz oder Vergleich bleibt jedoch unbequem. Um dieser Herausforderung zu begegnen, erstellen wir einen Unified Visual PETL Benchmark (V-PETL Bench) für den CV-Bereich, indem wir 30 verschiedene, anspruchsvolle und umfassende Datensätze aus den Bereichen Bilderkennung, Videoaktionserkennung und dichte Vorhersageaufgaben auswählen. Anhand dieser Datensätze evaluieren wir systematisch 25 vorherrschende PETL-Algorithmen und stellen als Open Source eine modulare und erweiterbare Codebasis für eine faire Bewertung dieser Algorithmen zur Verfügung.

Feinkörnige visuelle Klassifizierungsaufgaben (FGVC)

FGVC umfasst 5 feinkörnige visuelle Klassifizierungsdatensätze. Die Datensätze können über die offiziellen Links heruntergeladen werden. Wir teilen die Trainingsdaten auf, wenn der öffentliche Validierungssatz nicht verfügbar ist. Den aufgeteilten Datensatz finden Sie hier: Download-Link.

CUB200 2011

NABirds

Oxford-Blumen

Stanford-Hunde

Stanford-Autos

Visual Task Adaptation Benchmark (VTAB)

VTAB umfasst 19 verschiedene visuelle Klassifizierungsdatensätze. Wir haben den gesamten Datensatz verarbeitet und die Daten können hier heruntergeladen werden: Download-Link. Spezifische Verarbeitungsverfahren und Tipps finden Sie unter VTAB_SETUP.

Kinetik-400

Laden Sie den Datensatz über Download-Link oder Download-Link herunter.

Verarbeiten Sie den Datensatz vor, indem Sie die Größe der kurzen Kante des Videos auf 320 Pixel ändern. Sie können sich auf MMAction2 Data Benchmark beziehen.

Generieren Sie für den Datenlader benötigte Anmerkungen („train.csv , val.csv und test.csv . Das Format der *.csv Datei ist wie folgt:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

Etwas-Etwas V2 (SSv2)

Laden Sie den Datensatz über den Download-Link herunter.

Verarbeiten Sie den Datensatz vor, indem Sie die Videoerweiterung von webm in .mp4 mit der ursprünglichen Höhe von 240 Pixel ändern. Sie können sich auf MMAction2 Data Benchmark beziehen.

Generieren Sie für den Datenlader benötigte Anmerkungen („train.csv , val.csv und test.csv . Das Format der *.csv Datei ist wie folgt:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

MS-COCO

MS-COCO sind über diesen Download-Link verfügbar.

ADE20K

Der Trainings- und Validierungssatz von ADE20K kann über diesen Download-Link heruntergeladen werden. Wir können das Testset auch über den Download-Link herunterladen.

PASCAL VOC

Pascal VOC 2012 kann über den Download-Link heruntergeladen werden. Darüber hinaus nutzen die neuesten Arbeiten zum Pascal VOC-Datensatz normalerweise zusätzliche Erweiterungsdaten, die über den Download-Link zu finden sind.

Laden Sie das vorab trainierte ViT-B/16-Modell herunter und platzieren Sie es unter /path/to/pretrained_models .

mkdir pretrained_models wget https://storage.googleapis.com/vit_models/imagenet21k/ViT-B_16.npz

Alternativ können Sie das vorab trainierte Swin-B-Modell herunterladen. Beachten Sie, dass Sie auch das heruntergeladene Swin-B-ckpt von swin_base_patch4_window7_224_22k.pth in Swin-B_16.pth umbenennen müssen.

mkdir pretrained_models wget https://github.com/SwinTransformer/storage/releases/download/v1.0.0/swin_base_patch4_window7_224_22k.pth mv swin_base_patch4_window7_224_22k.pth Swin_B_16.pth

Eine andere Möglichkeit besteht darin, vorab trainierte Modelle über den folgenden Link herunterzuladen und in /path/to/pretrained_models einzufügen.

| Vortrainiertes Backbone | Vorab trainiertes Ziel | Vorab trainierter Datensatz | Kontrollpunkt |

|---|---|---|---|

| ViT-B/16 | Beaufsichtigt | ImageNet-21K | Download-Link |

| ViT-L/16 | Beaufsichtigt | ImageNet-21K | Download-Link |

| ViT-H/16 | Beaufsichtigt | ImageNet-21K | Download-Link |

| Swin-B | Beaufsichtigt | ImageNet-22K | Download-Link |

| Swin-L | Beaufsichtigt | ImageNet-22K | Download-Link |

| ViT-B (VideoMAE) | Selbstüberwacht | Kinetik-400 | Download-Link |

| Video Swin-B | Beaufsichtigt | Kinetik-400 | Download-Link |

ImageClassification/configs : verwaltet Konfigurationsparameter für die Experimente.

ImageClassification/config/vtab/cifar100.yaml : Hauptkonfigurationseinstellungen für Experimente und Erklärungen für jeden Datensatz.

.....

ImageClassification/dataloader : Eingabedatensätze laden und einrichten.

ImageClassification/dataloader/transforms : Bildtransformationen.

ImageClassification/dataloader/loader : Konstruiert den Datenlader für den angegebenen Datensatz.

ImageClassification/models : Behandelt Backbone-Bögen und -Köpfe für verschiedene Feinabstimmungsprotokolle

ImageClassification/models/vision_transformer_adapter.py : Ein Ordner enthält dieselben Backbones im Ordner vit_backbones , der für Adapter angegeben wurde.

ImageClassification/models/vision_transformer_sct.py : Ein Ordner enthält dieselben Backbones im Ordner vit_backbones , der für SCT angegeben ist.

.....

ImageClassification/train : Ein Ordner enthält den training file .

ImageClassification/train/train_model_adapter.py : Rufen Sie dieses zum Trainieren und Bewerten eines Modells mit einem angegebenen Übertragungstyp auf, der für Adapter angegeben ist.

ImageClassification/train/train_model_sct.py : Rufen Sie dieses zum Trainieren und Bewerten eines Modells mit einem angegebenen Übertragungstyp auf, der für SCT angegeben ist.

.....

ImageClassification/scripts : Ein Ordner enthält den scripts file .

ImageClassification/scripts/run_vit_adapter.sh : Sie können die Adapter-Methode für alle Datensätze gleichzeitig ausführen.

ImageClassification/scripts/run_vit_sct.sh : Sie können die Adapter-Methode für alle Datensätze gleichzeitig ausführen.

.....

ImageClassification/Visualize : Visualisierungstools.

ImageClassification/Visualize/AttentionMap.py : Visualisierung der Aufmerksamkeitskarte.

ImageClassification/Visualize/TSNE.py : T-SNE-Visualisierung.

ImageClassification/utils : Logger erstellen, Seed festlegen usw.

❗️Hinweis❗️: Wenn Sie Ihren eigenen PETL-Algorithmus erstellen möchten, achten Sie auf „ImageClassification/models“.

Dies ist ein Beispiel für die lokale Einrichtung der V-PETL-Bank.

Um eine lokale Kopie zu erstellen, befolgen Sie diese einfachen Beispielschritte.

Git-Klon https://github.com/synbol/Parameter-Efficient-Transfer-Learning-Benchmark.git

Die V-PETL-Bank ist auf Pytorch aufgebaut und verfügt über Torchvision, Torchaudio und Timm usw.

Um die erforderlichen Pakete zu installieren, können Sie eine Conda-Umgebung erstellen.

conda create --name v-petl-bench python=3.8

Conda-Umgebung aktivieren.

Conda aktiviert V-Petl-Bank

Verwenden Sie pip, um erforderliche Pakete zu installieren.

cd Parameter-Efficient-Transfer-Learning-Benchmark pip install -r Anforderungen.txt

Wir bieten eine spezifische Schulungs- und Evaluierungsdemo am Beispiel von LoRA auf VTAB Cifar100 an.

Importsystem

sys.path.append("Parameter-Efficient-Transfer-Learning-Benchmark")

Taschenlampe importieren

aus ImageClassification-Importdienstprogrammen

aus ImageClassification.dataloader vtab importieren

aus ImageClassification.train import train# get lora-Methoden aus timm.scheduler.cosine_lr import CosineLRScheduler

aus ImageClassification.models import vision_transformer_lora

import timm# Pfad zum Speichern des Modells und logsexp_base_path = '../output'utils.mkdirss(exp_base_path)# create loggerlogger = utils.create_logger(log_path=exp_base_path, log_name='training')# dataset config parameterconfig = utils.get_config(' model_lora', 'vtab', 'cifar100')# get vtab datasetdata_path = '/home/ma-user/work/haozhe/synbol/vtab-1k'train_dl, test_dl = vtab.get_data(data_path, 'cifar100', logger, evaluieren=Falsch, train_aug=config['train_aug'], batch_size=config['batch_size'])# get pretrained modelmodel = timm.models.create_model('vit_base_patch16_224_in21k_lora', checkpoint_path='./released_models/ViT-B_16.npz' , drop_path_rate=0.1, tuning_mode='lora')

model.reset_classifier(config['class_num'])# Trainingsparametertrainable = []für n, p in model.named_parameters(): wenn 'linear_a' in n oder 'linear_b' in n oder 'head' in n:

trainable.append(p)

logger.info(str(n))

anders:

p.requires_grad = Falsch

opt = Torch.optim.AdamW(trainable, lr=1e-4, Weight_decay=5e-2)

Scheduler = CosineLRScheduler(opt, t_initial=config['epochs'], warmup_t=config['warmup_epochs'], lr_min=1e-5, warmup_lr_init=1e-6,cycle_decay = 0.1)# crossEntropyLoss functioncriterion = Torch.nn.CrossEntropyLoss( )# trainingmodel = train.train(config, modell, Kriterium, train_dl, opt, Scheduler, Logger, config['epochs'], 'vtab', 'cifar100')# Evaluationeval_acc = train.test(model, test_dl, 'vtab ')Sie können mit einem PETL-Algorithmus an einem Datensatz trainieren.

python python train/train_model_sct.py --dataset cifar100 --task vtab --lr 0.012 --wd 0.6 --eval True --dpr 0.1 --tuning_mode $tuning_mode --model_type $model_type --model $model --model_checkpoint $ model_checkpoint

Oder Sie können mit einem PETL-Algorithmus für alle Datensätze trainieren

Bash-Skripte/run_model_sct.sh

Wir evaluieren 13 PETL-Algorithmen anhand von fünf Datensätzen mit ViT-B/16-Modellen, die auf ImageNet-21K vorab trainiert wurden.

Um den Checkpoint zu erhalten, laden Sie ihn bitte unter Download Link herunter.

| Verfahren | CUB-200-2011 | NABirds | Oxford-Blumen | Stanford-Hunde | Stanford-Autos | Bedeuten | Parameter. | PPT |

|---|---|---|---|---|---|---|---|---|

| Volle Feinabstimmung | 87,3 | 82,7 | 98,8 | 89,4 | 84,5 | 88,54 | 85,8 Mio | - |

| Lineare Sondierung | 85,3 | 75,9 | 97,9 | 86,2 | 51.3 | 79,32 | 0 M | 0,79 |

| Adapter | 87.1 | 84,3 | 98,5 | 89,8 | 68,6 | 85,66 | 0,41 Mio | 0,84 |

| AdaptFormer | 88,4 | 84,7 | 99,2 | 88,2 | 81,9 | 88,48 | 0,46 Mio | 0,87 |

| Präfix-Tuning | 87,5 | 82,0 | 98,0 | 74.2 | 90,2 | 86,38 | 0,36 Mio | 0,85 |

| U-Tuning | 89,2 | 85,4 | 99,2 | 84.1 | 92.1 | 90,00 | 0,36 Mio | 0,89 |

| BitFit | 87,7 | 85,2 | 99,2 | 86,5 | 81,5 | 88.02 | 0,10 Mio | 0,88 |

| VPT-Flach | 86,7 | 78,8 | 98,4 | 90,7 | 68,7 | 84,66 | 0,25 Mio | 0,84 |

| VPT-Deep | 88,5 | 84.2 | 99,0 | 90,2 | 83,6 | 89.10 | 0,85 Mio | 0,86 |

| SSF | 89,5 | 85,7 | 99,6 | 89,6 | 89,2 | 90,72 | 0,39 Mio | 0,89 |

| LoRA | 85,6 | 79,8 | 98,9 | 87,6 | 72,0 | 84,78 | 0,77 Mio | 0,82 |

| GPS | 89,9 | 86,7 | 99,7 | 92,2 | 90,4 | 91,78 | 0,66 Mio | 0,90 |

| HST | 89,2 | 85,8 | 99,6 | 89,5 | 88,2 | 90,46 | 0,78 Mio | 0,88 |

| ZULETZT | 88,5 | 84,4 | 99,7 | 86,0 | 88,9 | 89,50 | 0,66 Mio | 0,87 |

| SNF | 90,2 | 87,4 | 99,7 | 89,5 | 86,9 | 90,74 | 0,25 Mio | 0,90 |

Benchmark-Ergebnisse auf VTAB. Wir evaluieren 18 PETL-Algorithmen anhand von 19 Datensätzen mit ViT-B/16-Modellen, die auf ImageNet-21K vorab trainiert wurden.

Um den Checkpoint zu erhalten, laden Sie ihn bitte unter Download Link herunter.

| Verfahren | CIFAR-100 | Caltech101 | DTD | Blumen102 | Haustiere | SVHN | Sun397 | Patch Camelyon | EuroSAT | Resisc45 | Retinopathie | Clevr/Count | Schlüssel/Entfernung | DMLab | KITTI/Entfernung | dSprites/loc | dSprites/ori | SmallNORB/azi | SmallNORB/ele | Bedeuten | Parameter. | PPT |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Volle Feinabstimmung | 68,9 | 87,7 | 64.3 | 97,2 | 86,9 | 87,4 | 38.8 | 79,7 | 95,7 | 84.2 | 73,9 | 56.3 | 58,6 | 41.7 | 65,5 | 57,5 | 46,7 | 25.7 | 29.1 | 65,57 | 85,8 Mio | - |

| Lineare Sondierung | 63,4 | 85,0 | 63.2 | 97,0 | 86,3 | 36.6 | 51,0 | 78,5 | 87,5 | 68,6 | 74,0 | 34.3 | 30.6 | 33.2 | 55.4 | 12.5 | 20.0 | 9.6 | 19.2 | 52,94 | 0M | 0,53 |

| Adapter | 69.2 | 90.1 | 68,0 | 98,8 | 89,9 | 82,8 | 54.3 | 84,0 | 94,9 | 81,9 | 75,5 | 80,9 | 65,3 | 48,6 | 78,3 | 74,8 | 48,5 | 29.9 | 41.6 | 71,44 | 0,16 Mio | 0,71 |

| VPT-Flach | 77,7 | 86,9 | 62,6 | 97,5 | 87,3 | 74,5 | 51.2 | 78,2 | 92,0 | 75,6 | 72,9 | 50,5 | 58,6 | 40,5 | 67.1 | 68,7 | 36.1 | 20.2 | 34.1 | 64,85 | 0,08 Mio | 0,65 |

| VPT-Deep | 78,8 | 90,8 | 65,8 | 98,0 | 88,3 | 78.1 | 49,6 | 81,8 | 96,1 | 83,4 | 68,4 | 68,5 | 60,0 | 46,5 | 72,8 | 73,6 | 47.9 | 32.9 | 37.8 | 69,43 | 0,56 Mio | 0,68 |

| BitFit | 72,8 | 87,0 | 59.2 | 97,5 | 85,3 | 59.9 | 51.4 | 78,7 | 91,6 | 72,9 | 69,8 | 61,5 | 55,6 | 32.4 | 55.9 | 66,6 | 40,0 | 15.7 | 25.1 | 62.05 | 0,10 Mio | 0,61 |

| LoRA | 67.1 | 91,4 | 69,4 | 98,8 | 90,4 | 85,3 | 54,0 | 84,9 | 95,3 | 84,4 | 73,6 | 82,9 | 69.2 | 49,8 | 78,5 | 75,7 | 47.1 | 31.0 | 44,0 | 72,25 | 0,29 Mio | 0,71 |

| AdaptFormer | 70,8 | 91,2 | 70,5 | 99,1 | 90,9 | 86,6 | 54,8 | 83,0 | 95,8 | 84,4 | 76,3 | 81,9 | 64.3 | 49.3 | 80,3 | 76,3 | 45,7 | 31.7 | 41.1 | 72,32 | 0,16 Mio | 0,72 |

| SSF | 69,0 | 92,6 | 75.1 | 99,4 | 91,8 | 90,2 | 52.9 | 87,4 | 95,9 | 87,4 | 75,5 | 75,9 | 62.3 | 53.3 | 80,6 | 77,3 | 54.9 | 29.5 | 37.9 | 73.10 | 0,21 Mio | 0,72 |

| NOAH | 69,6 | 92,7 | 70.2 | 99,1 | 90,4 | 86.1 | 53,7 | 84,4 | 95,4 | 83,9 | 75,8 | 82,8 | 68,9 | 49.9 | 81,7 | 81,8 | 48.3 | 32.8 | 44.2 | 73,25 | 0,43 Mio | 0,72 |

| SCT | 75,3 | 91,6 | 72.2 | 99,2 | 91.1 | 91,2 | 55,0 | 85,0 | 96,1 | 86,3 | 76,2 | 81,5 | 65.1 | 51.7 | 80.2 | 75,4 | 46.2 | 33.2 | 45,7 | 73,59 | 0,11 Mio | 0,73 |

| Tatsache | 70.6 | 90,6 | 70,8 | 99,1 | 90,7 | 88,6 | 54.1 | 84,8 | 96,2 | 84,5 | 75,7 | 82,6 | 68.2 | 49,8 | 80,7 | 80,8 | 47.4 | 33.2 | 43,0 | 73,23 | 0,07 Mio | 0,73 |

| RepAdapter | 72,4 | 91,6 | 71,0 | 99,2 | 91,4 | 90,7 | 55.1 | 85,3 | 95,9 | 84,6 | 75,9 | 82,3 | 68,0 | 50.4 | 79,9 | 80,4 | 49.2 | 38.6 | 41,0 | 73,84 | 0,22 Mio | 0,72 |

| Hydra | 72,7 | 91,3 | 72,0 | 99,2 | 91,4 | 90,7 | 55,5 | 85,8 | 96,0 | 86.1 | 75,9 | 83,2 | 68.2 | 50.9 | 82,3 | 80,3 | 50.8 | 34.5 | 43.1 | 74.21 | 0,28 Mio | 0,73 |

| LST | 59,5 | 91,5 | 69,0 | 99,2 | 89,9 | 79,5 | 54.6 | 86,9 | 95,9 | 85,3 | 74.1 | 81,8 | 61,8 | 52.2 | 81,0 | 71,7 | 49,5 | 33.7 | 45.2 | 71,70 | 2,38 Millionen | 0,65 |

| DTL | 69,6 | 94,8 | 71.3 | 99,3 | 91,3 | 83,3 | 56.2 | 87.1 | 96,2 | 86.1 | 75,0 | 82,8 | 64.2 | 48,8 | 81,9 | 93,9 | 53.9 | 34.2 | 47.1 | 74,58 | 0,04 Mio | 0,75 |

| HST | 76,7 | 94.1 | 74,8 | 99,6 | 91.1 | 91,2 | 52.3 | 87.1 | 96,3 | 88,6 | 76,5 | 85,4 | 63,7 | 52.9 | 81,7 | 87,2 | 56,8 | 35.8 | 52.1 | 75,99 | 0,78 Mio | 0,74 |

| GPS | 81.1 | 94,2 | 75,8 | 99,4 | 91,7 | 91,6 | 52.4 | 87,9 | 96,2 | 86,5 | 76,5 | 79,9 | 62,6 | 55,0 | 82,4 | 84,0 | 55.4 | 29.7 | 46.1 | 75,18 | 0,22 Mio | 0,74 |

| ZULETZT | 66,7 | 93,4 | 76.1 | 99,6 | 89,8 | 86.1 | 54.3 | 86,2 | 96,3 | 86,8 | 75,4 | 81,9 | 65,9 | 49.4 | 82,6 | 87,9 | 46,7 | 32.3 | 51,5 | 74,15 | 0,66 Mio | 0,72 |

| SNF | 84,0 | 94,0 | 72,7 | 99,3 | 91,3 | 90,3 | 54.9 | 87,2 | 97,3 | 85,5 | 74,5 | 82,3 | 63,8 | 49,8 | 82,5 | 75,8 | 49.2 | 31.4 | 42.1 | 74.10 | 0,25 Mio | 0,73 |

Benchmark-Ergebnisse für SSv2 und HMDB51. Wir evaluieren 5 PETL-Algorithmen mit ViT-B von VideoMAE und Video Swin Transformer.

Um den Checkpoint zu erhalten, laden Sie ihn bitte unter Download Link herunter.

| Verfahren | Modell | Vorschulung | Parameter. | SSv2 (Top1) | SSv2 (PPT) | HMDB51 (Top1) | HMDB51 (PPT) |

|---|---|---|---|---|---|---|---|

| Volle Feinabstimmung | ViT-B | Kinetik 400 | 85,97 Mio | 53,97 % | - | 46,41 % | - |

| Gefroren | ViT-B | Kinetik 400 | 0 M | 29,23 % | 0,29 | 49,84 % | 0,50 |

| AdaptFormer | ViT-B | Kinetik 400 | 1,19 Mio | 59,02 % | 0,56 | 55,69 % | 0,53 |

| BAPAT | ViT-B | Kinetik 400 | 2,06 Mio | 57,78 % | 0,53 | 57,18 % | 0,53 |

| Volle Feinabstimmung | Video Swin-B | Kinetik 400 | 87,64 Mio | 50,99 % | - | 68,07 % | - |

| Gefroren | Video Swin-B | Kinetik 400 | 0 M | 24,13 % | 0,24 | 71,28 % | 0,71 |

| LoRA | Video Swin-B | Kinetik 400 | 0,75 Mio | 38,34 % | 0,37 | 62,12 % | 0,60 |

| BitFit | Video Swin-B | Kinetik 400 | 1,09 Mio | 45,94 % | 0,44 | 68,26 % | 0,65 |

| AdaptFormer | Video Swin-B | Kinetik 400 | 1,56 Mio | 40,80 % | 0,38 | 68,66 % | 0,64 |

| Präfix-Tuning | Video Swin-B | Kinetik 400 | 6,37 Mio | 39,46 % | 0,32 | 56,13 % | 0,45 |

| BAPAT | Video Swin-B | Kinetik 400 | 6,18 Mio | 53,36 % | 0,43 | 71,93 % | 0,58 |

Benchmark-Ergebnisse zu COCO. Wir evaluieren 9 PETL-Algorithmen mit Swin-B-Modellen, die auf ImageNet-22K vorab trainiert wurden.

Um den Checkpoint zu erhalten, laden Sie ihn bitte unter „Coming Soon“ herunter.

| Swin-B | Parameter. | Erinnerung | COCO ( | COCO (PPT) | COCO ( | COCO (PPT) |

|---|---|---|---|---|---|---|

| Volle Feinabstimmung | 86,75 Mio | 17061 MB | 51,9 % | - | 45,0 % | - |

| Gefroren | 0,00 M | 7137 MB | 43,5 % | 0,44 | 38,6 % | 0,39 |

| Bitfit | 0,20 Mio | 13657 MB | 47,9 % | 0,47 | 41,9 % | 0,42 |

| LN TUNE | 0,06 Mio | 12831 MB | 48,0 % | 0,48 | 41,4 % | 0,41 |

| Teilweise-1 | 12,60 Mio | 7301 MB | 49,2 % | 0,35 | 42,8 % | 0,30 |

| Adapter | 3,11 Mio | 12557 MB | 50,9 % | 0,45 | 43,8 % | 0,39 |

| LoRA | 3,03 Mio | 11975 MB | 51,2 % | 0,46 | 44,3 % | 0,40 |

| AdaptFormer | 3,11 Mio | 13186 MB | 51,4 % | 0,46 | 44,5 % | 0,40 |

| LoRand | 1,20 Mio | 13598 MB | 51,0 % | 0,49 | 43,9 % | 0,42 |

| E$^3$VA | 1,20 Mio | 7639 MB | 50,5 % | 0,48 | 43,8 % | 0,42 |

| Mona | 4,16 M | 13996 MB | 53,4 % | 0,46 | 46,0 % | 0,40 |

Benchmark-Ergebnisse für PASCAL VOC und ADE20K. Wir evaluieren 9 PETL-Algorithmen mit Swin-L-Modellen, die auf ImageNet-22K vorab trainiert wurden.

Um den Checkpoint zu erhalten, laden Sie ihn bitte unter „Coming Soon“ herunter.

| Swin-L | Parameter. | Speicher (VOC) | Pascal VOC ( | Pascal VOC (PPT) | ADE20K ( | ADE20K (PPT) |

|---|---|---|---|---|---|---|

| Volle Feinabstimmung | 198,58 Mio | 15679 MB | 83,5 % | - | 52,10 % | - |

| Gefroren | 0,00 M | 3967 MB | 83,6 % | 0,84 | 46,84 % | 0,47 |

| Bitfit | 0,30 Mio | 10861 MB | 85,7 % | 0,85 | 48,37 % | 0,48 |

| LN TUNE | 0,09 Mio | 10123 MB | 85,8 % | 0,86 | 47,98 % | 0,48 |

| Teilweise-1 | 28,34 Mio | 3943 MB | 85,4 % | 0,48 | 47,44 % | 0,27 |

| Adapter | 4,66 Mio | 10793 MB | 87,1 % | 0,74 | 50,78 % | 0,43 |

| LoRA | 4,57 Mio | 10127 MB | 87,5 % | 0,74 | 50,34 % | 0,43 |

| AdaptFormer | 4,66 Mio | 11036 MB | 87,3 % | 0,74 | 50,83 % | 0,43 |

| LoRand | 1,31 Mio | 11572 MB | 86,8 % | 0,82 | 50,76 % | 0,48 |

| E$^3$VA | 1,79 Mio | 4819 MB | 86,5 % | 0,81 | 49,64 % | 0,46 |

| Mona | 5,08 Mio | 11958 MB | 87,3 % | 0,73 | 51,36 % | 0,43 |

Die V-PETL Bench-Community wird gepflegt von:

Yi Xin ([email protected]), Universität Nanjing.

Siqi Luo ([email protected]), Shanghai Jiao Tong University.

Wenn Sie unsere Umfrage und unser Repository für Ihre Forschung nützlich finden, zitieren Sie sie bitte unten:

@article{xin2024bench, title={V-PETL Bench: A Unified Visual Parameter-Efficient Transfer Learning Benchmark}, Autor={Yi Xin, Siqi Luo, Xuyang Liu, Haodi Zhou, Xinyu Cheng, Christina Luoluo Lee, Junlong Du, Yuntao Du., Haozhe Wang, MingCai Chen, Ting Liu, Guimin Hu, Zhongwei Wan, Rongchao Zhang, Aoxue Li, Mingyang Yi, Xiaohong Liu}, Jahr={2024}}