Holen Sie sich Hilfe – FAQ-Diskussionen, Discord-Dokumentations-Website

Schnellstart-Modell-Roadmap? Demo? Entdecker? Beispiele

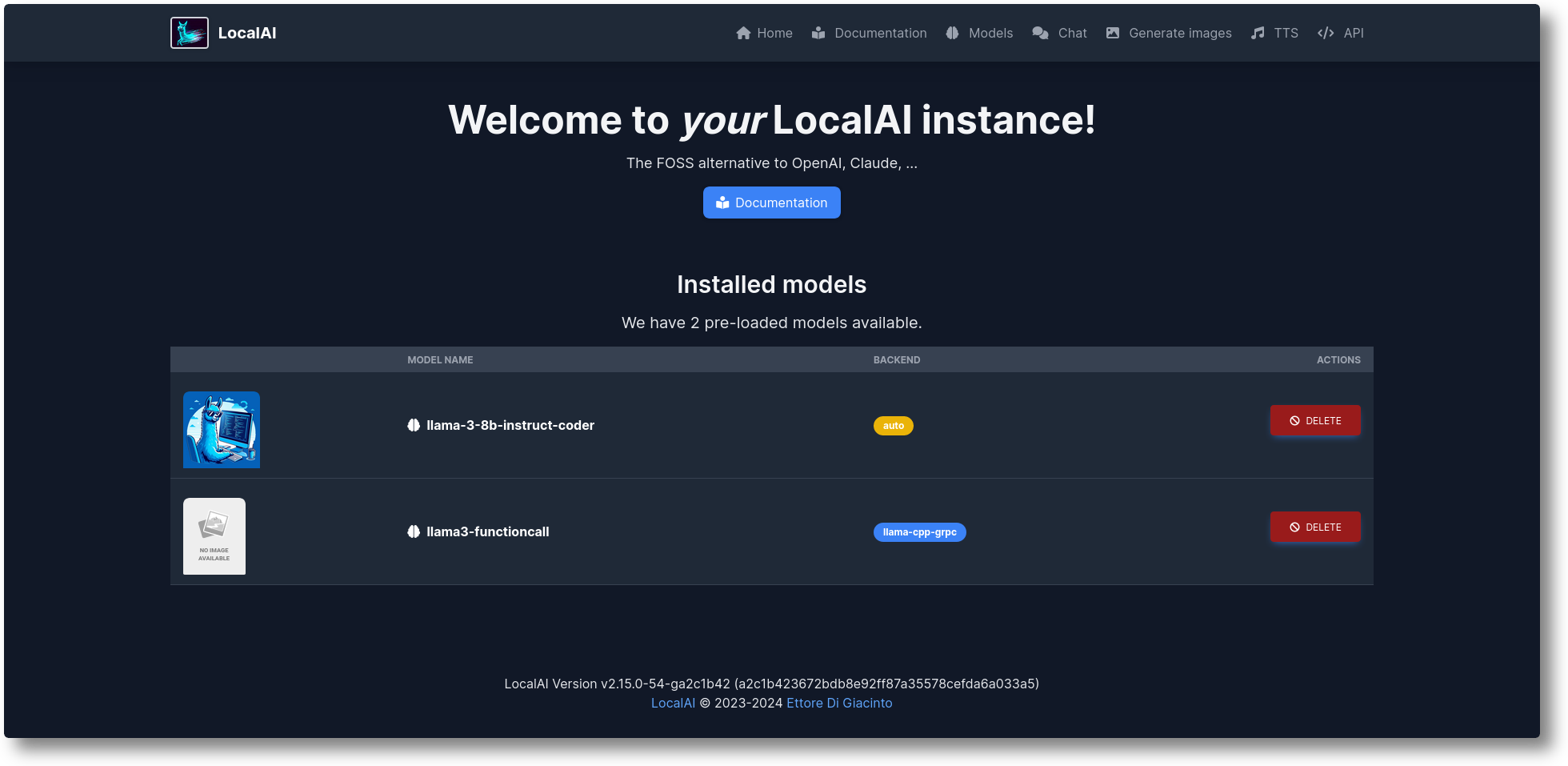

LocalAI ist die kostenlose Open-Source-OpenAI-Alternative. LocalAI fungiert als Drop-in-Ersatz-REST-API, die mit den API-Spezifikationen von OpenAI (Elevenlabs, Anthropic...) für lokale KI-Inferenzierung kompatibel ist. Es ermöglicht Ihnen, LLMs auszuführen, Bilder und Audio (und nicht nur) lokal oder vor Ort mit Consumer-Hardware zu generieren und mehrere Modellfamilien zu unterstützen. Erfordert keine GPU. Es wird von Ettore Di Giacinto erstellt und gepflegt.

Führen Sie das Installationsskript aus:

Curl https://localai.io/install.sh | sh

Oder mit Docker ausführen:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu# Alternative Bilder:# – wenn Sie eine Nvidia-GPU haben:# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12# – ohne vorkonfigurierte Modelle# docker run -ti --name local-ai -p 8080:8080 localai/localai:latest# – ohne vorkonfigurierte Modelle für Nvidia-GPUs# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/ localai:latest-gpu-nvidia-cuda-12

So laden Sie Modelle:

# Aus der Modellgalerie (siehe verfügbare Modelle mit „local-ai-Modellliste“, in der WebUI über die Registerkarte „Modell“ oder unter https://models.localai.io) führt local-ai llama-3.2-1b-instruct aus: q4_k_m# Starten Sie LocalAI mit dem Phi-2-Modell direkt aus Huggingfacelocal-ai und führen Sie Huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf# aus und führen Sie ein Modell aus der Ollama OCI-Registrierung aus. Local-ai führt ollama://gemma:2b# aus. Führen Sie ein Modell aus einer Konfigurationsdatei aus. Local-ai führt https://gist.githubusercontent.com/.../phi-2.yaml# aus. Installieren Sie ein Modell aus einer Standard-OCI-Registrierung (z. B. Docker Hub) und führen Sie es aus. local-ai führt oci://localai/phi-2:latest aus

Erste Schritte

Okt. 2024: Beispiele nach LocalAI-examples verschoben

August 2024: ? FLUX-1, P2P-Explorer

Juli 2024: ? P2P-Dashboard, LocalAI Federated-Modus und AI Swarms: #2723

Juni 2024: ? Sie können die Modellgalerie jetzt auch ohne LocalAI durchsuchen! Schauen Sie sich https://models.localai.io an

Juni 2024: Unterstützung für Modelle aus OCI-Registern: #2628

Mai 2024: Dezentrales P2P llama.cpp: #2343 (peer2peer llama.cpp!) Dokumente https://localai.io/features/distribute/

Mai 2024: Openvoice: #2334

Mai 2024: ? Funktionsaufrufe ohne Grammatiken und gemischten Modus: #2328

Mai 2024: Verteilte Inferenz: #2324

Mai 2024: Chat, TTS und Bildgenerierung in der WebUI: #2222

April 2024: Reranker-API: #2121

Roadmap-Elemente: Liste der Probleme

Multimodal mit vLLM und Videoverständnis: #3729

Echtzeit-API #3714

Verteilte, globale P2P-Community-Pools: #3113

WebUI-Verbesserungen: #2156

Backends v2: #1126

Verbesserung von UX v2: #1373

Assistenten-API: #1273

Moderationsendpunkt: #999

Vulkan: #1647

Anthropic API: #1808

Wenn Sie helfen und einen Beitrag leisten möchten, stehen Ihnen folgende Themen zur Verfügung: https://github.com/mudler/LocalAI/issues?q=is%3Aissue+is%3Aopen+label%3A%22up+for+grabs%22

Textgenerierung mit GPTs ( llama.cpp , gpt4all.cpp , ... und mehr)

Text zu Audio

Audio zu Text (Audiotranskription mit whisper.cpp )

Bilderzeugung mit stabiler Diffusion

OpenAI-ähnliche Tools-API

Generierung von Einbettungen für Vektordatenbanken

Eingeschränkte Grammatiken

Laden Sie Modelle direkt von Huggingface herunter

Vision-API

Reranker-API

P2P-Inferenz

Integrierte WebUI!

Sehen Sie sich den Abschnitt „Erste Schritte“ in unserer Dokumentation an.

Benutzerdefinierte Container erstellen und bereitstellen:

https://github.com/sozercan/aikit

WebUIs:

https://github.com/Jirubizu/localai-admin

https://github.com/go-skynet/LocalAI-frontend

QA-Pilot (Ein interaktives Chat-Projekt, das LocalAI-LLMs für ein schnelles Verständnis und eine schnelle Navigation im GitHub-Code-Repository nutzt) https://github.com/reid41/QA-Pilot

Modellgalerien

https://github.com/go-skynet/model-gallery

Andere:

Helmdiagramm https://github.com/go-skynet/helm-charts

VSCode-Erweiterung https://github.com/badgooooor/localai-vscode-plugin

Terminal-Dienstprogramm https://github.com/djcopley/ShellOracle

Lokaler Smart-Assistent https://github.com/mudler/LocalAGI

Heimassistent https://github.com/sammcj/homeassistant-localai / https://github.com/drndos/hass-openai-custom-conversation / https://github.com/valentinfrlch/ha-gpt4vision

Discord-Bot https://github.com/mudler/LocalAGI/tree/main/examples/discord

Slack-Bot https://github.com/mudler/LocalAGI/tree/main/examples/slack

Shell-Pilot (Interagieren Sie mit LLM mithilfe von LocalAI-Modellen über reine Shell-Skripte auf Ihrem Linux- oder MacOS-System) https://github.com/reid41/shell-pilot

Telegram-Bot https://github.com/mudler/LocalAI/tree/master/examples/telegram-bot

Github-Aktionen: https://github.com/marketplace/actions/start-localai

Beispiele: https://github.com/mudler/LocalAI/tree/master/examples/

LLM-Feinabstimmungsleitfaden

So bauen Sie lokal

So installieren Sie in Kubernetes

Projekte, die LocalAI integrieren

Anleitungsbereich (von unserer Community kuratiert)

Führen Sie Visual Studio-Code mit LocalAI (SUSE) aus.

Führen Sie LocalAI auf dem Jetson Nano Devkit aus

Führen Sie LocalAI auf AWS EKS mit Pulumi aus

Führen Sie LocalAI auf AWS aus

Erstellen Sie einen Slackbot für Teams und OSS-Projekte, die auf Dokumentation reagieren

LocalAI trifft auf k8sgpt

Lokale Beantwortung von Fragen zu Dokumenten mit LangChain, LocalAI, Chroma und GPT4All

Tutorial zur Verwendung von k8sgpt mit LocalAI

Wenn Sie diese Repository-Daten in einem nachgelagerten Projekt verwenden, denken Sie bitte darüber nach, sie zu zitieren mit:

@misc{localai,

author = {Ettore Di Giacinto},

title = {LocalAI: The free, Open source OpenAI alternative},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/go-skynet/LocalAI}},Finden Sie LocalAI nützlich?

Unterstützen Sie das Projekt, indem Sie Unterstützer oder Sponsor werden. Hier erscheint Ihr Logo mit einem Link zu Ihrer Website.

Ein großes Dankeschön an unsere großzügigen Sponsoren, die dieses Projekt unterstützen und die CI-Kosten decken, sowie an unsere Sponsorenliste:

LocalAI ist ein von der Community getragenes Projekt von Ettore Di Giacinto.

MIT – Autor Ettore Di Giacinto [email protected]

LocalAI hätte ohne die Hilfe großartiger Software, die bereits in der Community verfügbar ist, nicht erstellt werden können. Danke schön!

lama.cpp

https://github.com/tatsu-lab/stanford_alpaca

https://github.com/cornelk/llama-go für die ersten Ideen

https://github.com/antimatter15/alpaca.cpp

https://github.com/EdVince/Stable-Diffusion-NCNN

https://github.com/ggerganov/whisper.cpp

https://github.com/saharNooby/rwkv.cpp

https://github.com/rhasspy/piper

Dies ist ein Gemeinschaftsprojekt, ein besonderer Dank geht an unsere Mitwirkenden! ?