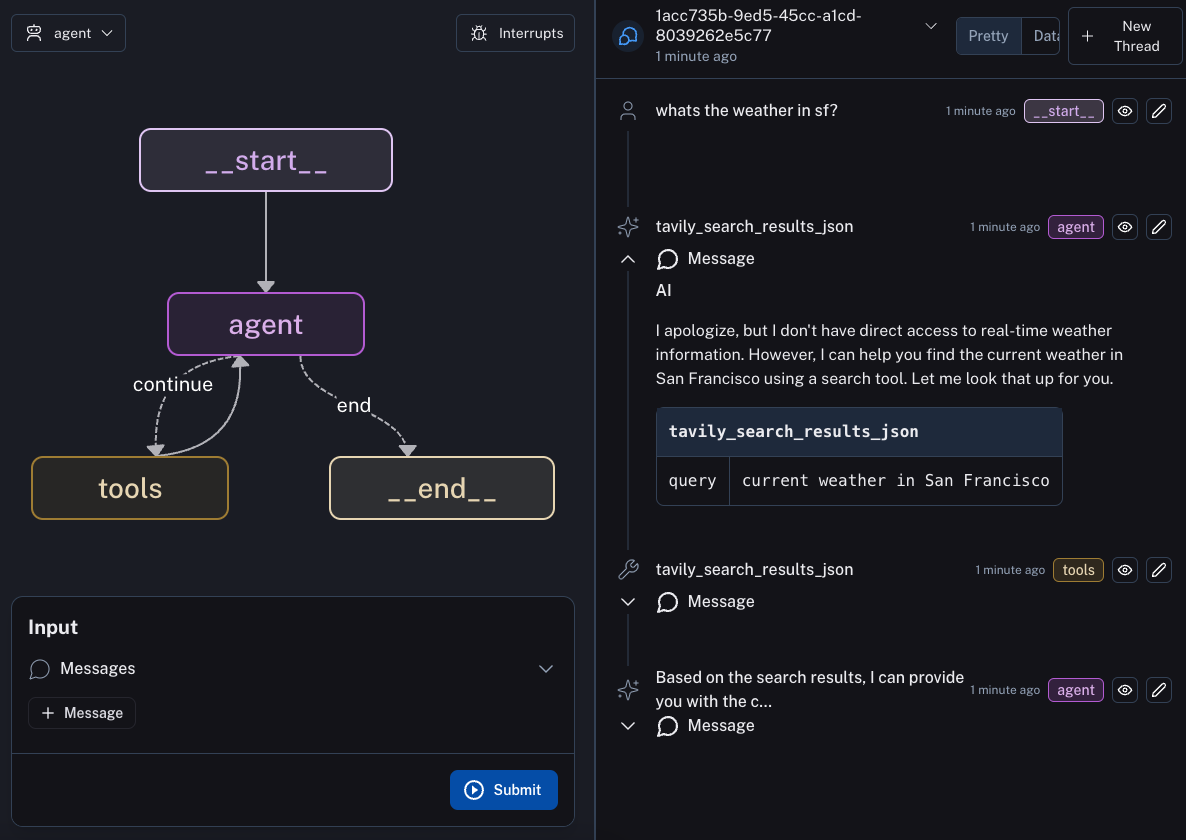

Dies ist ein Beispielagent für die Bereitstellung mit LangGraph Cloud.

Tipp

Wenn Sie lieber pyproject.toml zum Verwalten von Abhängigkeiten in Ihrem LangGraph Cloud-Projekt verwenden möchten, sehen Sie sich bitte dieses Repository an.

LangGraph ist eine Bibliothek zum Erstellen zustandsbehafteter Multi-Akteur-Anwendungen mit LLMs. Die Hauptanwendungsfälle für LangGraph sind Konversationsagenten und lang laufende, mehrstufige LLM-Anwendungen oder jede LLM-Anwendung, die von der integrierten Unterstützung für dauerhafte Prüfpunkte, Zyklen und Human-in-the-Loop-Interaktionen (d. h. LLM) profitieren würde und menschliche Zusammenarbeit).

LangGraph verkürzt die Markteinführungszeit für Entwickler, die LangGraph verwenden, mit einem einzeiligen Befehl zum Starten eines produktionsbereiten HTTP-Microservices für Ihre LangGraph-Anwendungen mit integrierter Persistenz. Dadurch können Sie sich auf die Logik Ihres LangGraph-Diagramms konzentrieren und uns die Skalierung und das API-Design überlassen. Die API ist von der OpenAI-Assistenten-API inspiriert und so konzipiert, dass sie sich in Ihre bestehenden Dienste einfügt.

Um diesen Agenten in LangGraph Cloud bereitzustellen, müssen Sie zunächst dieses Repo forken. Anschließend können Sie den Anweisungen hier folgen, um die Bereitstellung in LangGraph Cloud durchzuführen.