Tolle AGI-Umfrage

Unverzichtbare Artikel über künstliche allgemeine Intelligenz

? Nachricht

- [2024-10] ? Unser Beitrag wurde von TMLR 2024 angenommen.

- [2024-05] ? Wir organisieren einen AGI-Workshop beim ICLR 2024 und haben unser Positionspapier „How Far Are We From AGI?“ veröffentlicht.

Unser Projekt ist eine fortlaufende, offene Initiative, die sich parallel zu den Fortschritten in der AGI weiterentwickeln wird. Wir freuen uns über Rückmeldungen und Anfragen aus der Community und planen, unser Papier jährlich zu aktualisieren. Den Mitwirkenden auf der Projektwebsite wird in zukünftigen Überarbeitungen dankbar gedankt.

BibTex-Zitat, wenn Sie unsere Arbeit/Ressourcen nützlich finden:

@article { feng2024far ,

title = { How Far Are We From AGI } ,

author = { Feng, Tao and Jin, Chuanyang and Liu, Jingyu and Zhu, Kunlun and Tu, Haoqin and Cheng, Zirui and Lin, Guanyu and You, Jiaxuan } ,

journal = { arXiv preprint arXiv:2405.10313 } ,

year = { 2024 }

} Inhalt

- Inhalt

- 1. Einführung

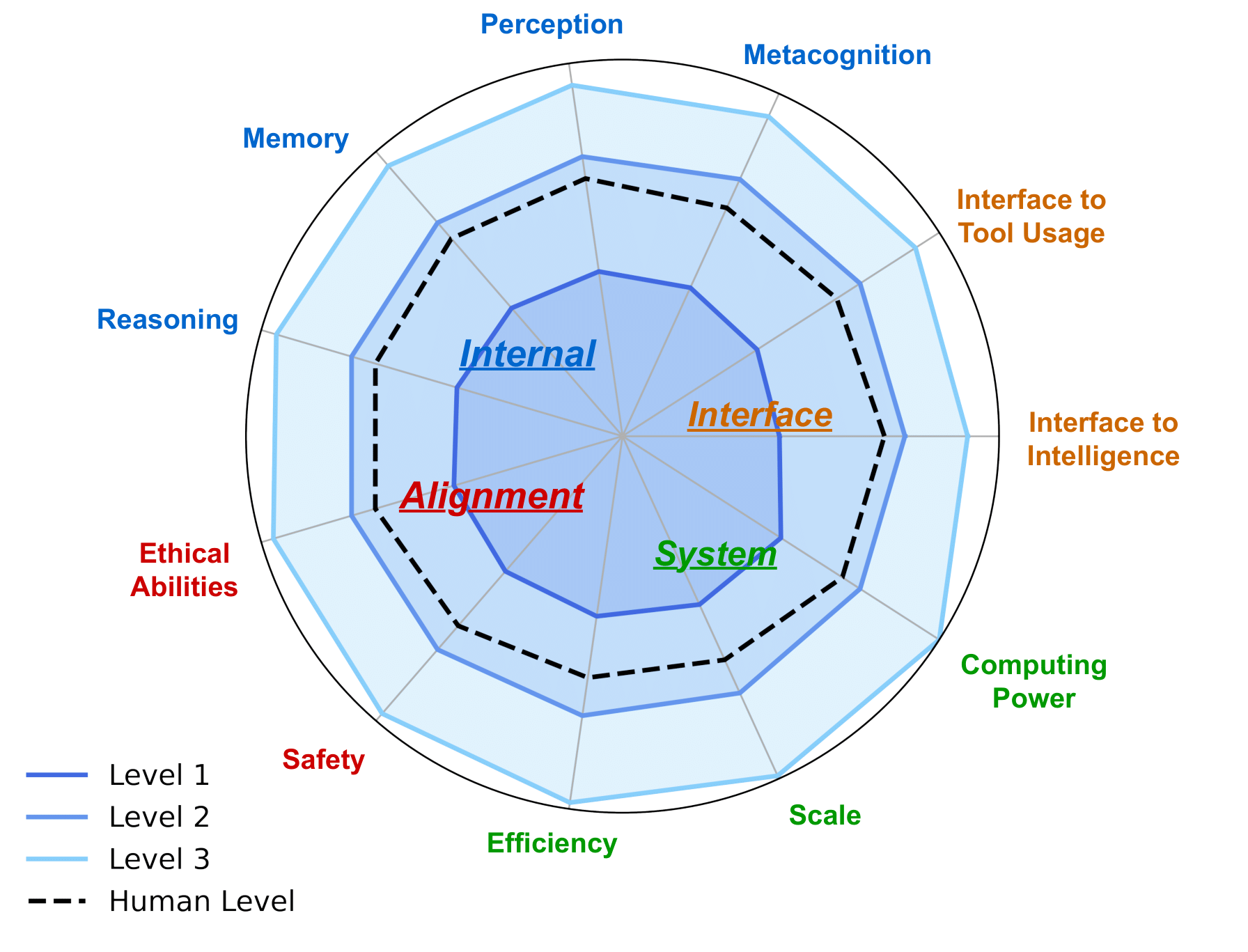

- 2. AGI Internal: Enthüllung des Geistes von AGI

- 2.1 KI-Wahrnehmung

- 2.2 KI-Argumentation

- 2.3 KI-Speicher

- 2.4 KI-Metakognition

- 3. AGI-Schnittstelle: Die Welt mit AGI verbinden

- 3.1 KI-Schnittstellen zur digitalen Welt

- 3.2 KI-Schnittstellen zur physischen Welt

- 3.3 KI-Schnittstellen zur Intelligenz

- 3.3.1 KI-Schnittstellen zu KI-Agenten

- 3.3.2 KI-Schnittstellen zum Menschen

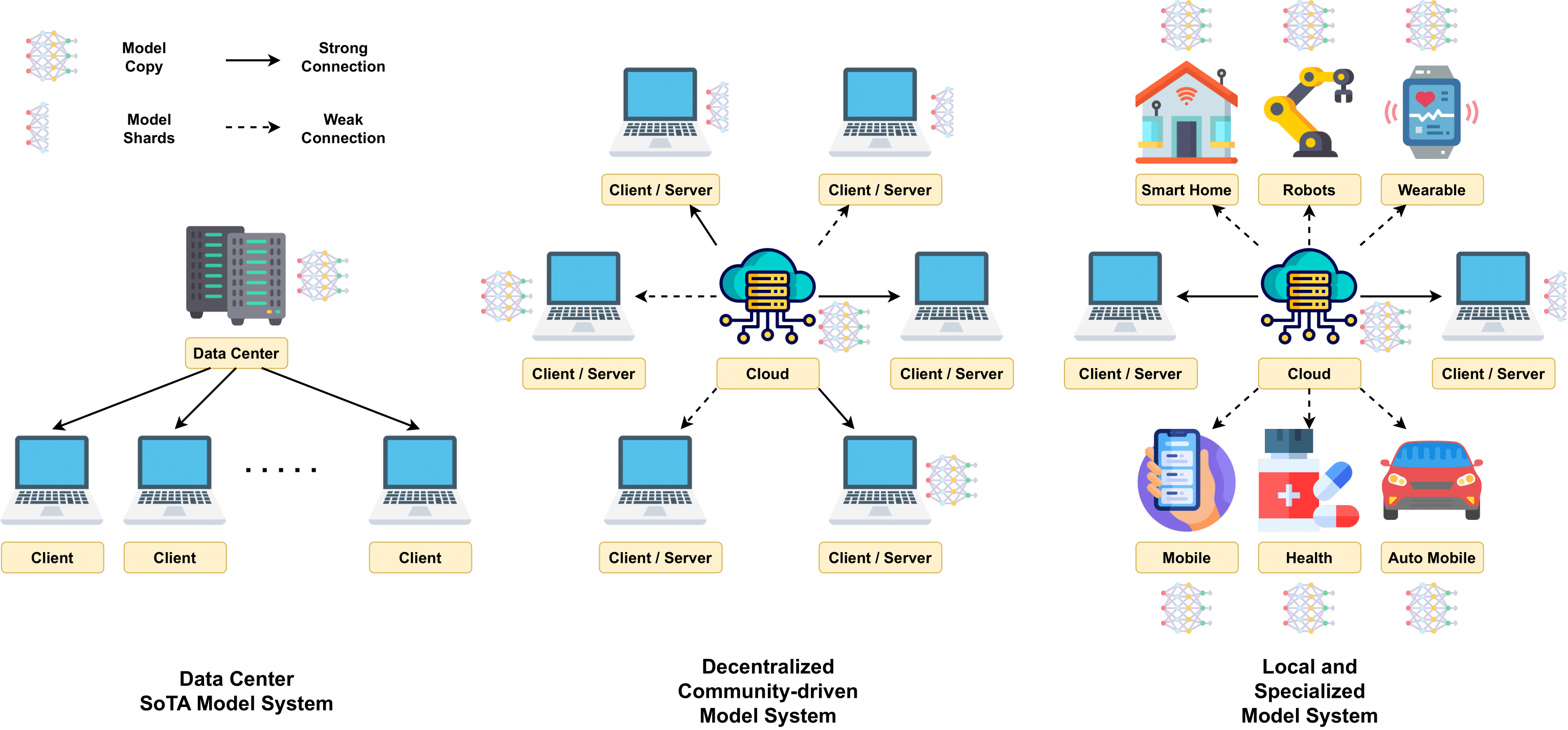

- 4. AGI-Systeme: Implementierung des AGI-Mechanismus

- 4.2 Skalierbare Modellarchitekturen

- 4.3 Groß angelegte Schulung

- 4.4 Inferenztechniken

- 4.5 Kosten und Effizienz

- 4.6 Computerplattformen

- 5. AGI-Ausrichtung: Sicherstellen, dass AGI verschiedene Anforderungen erfüllt

- 5.1 Erwartungen an die AGI-Ausrichtung

- 5.2 Aktuelle Ausrichtungstechniken

- 5.3 Vorgehensweise bei AGI-Ausrichtungen

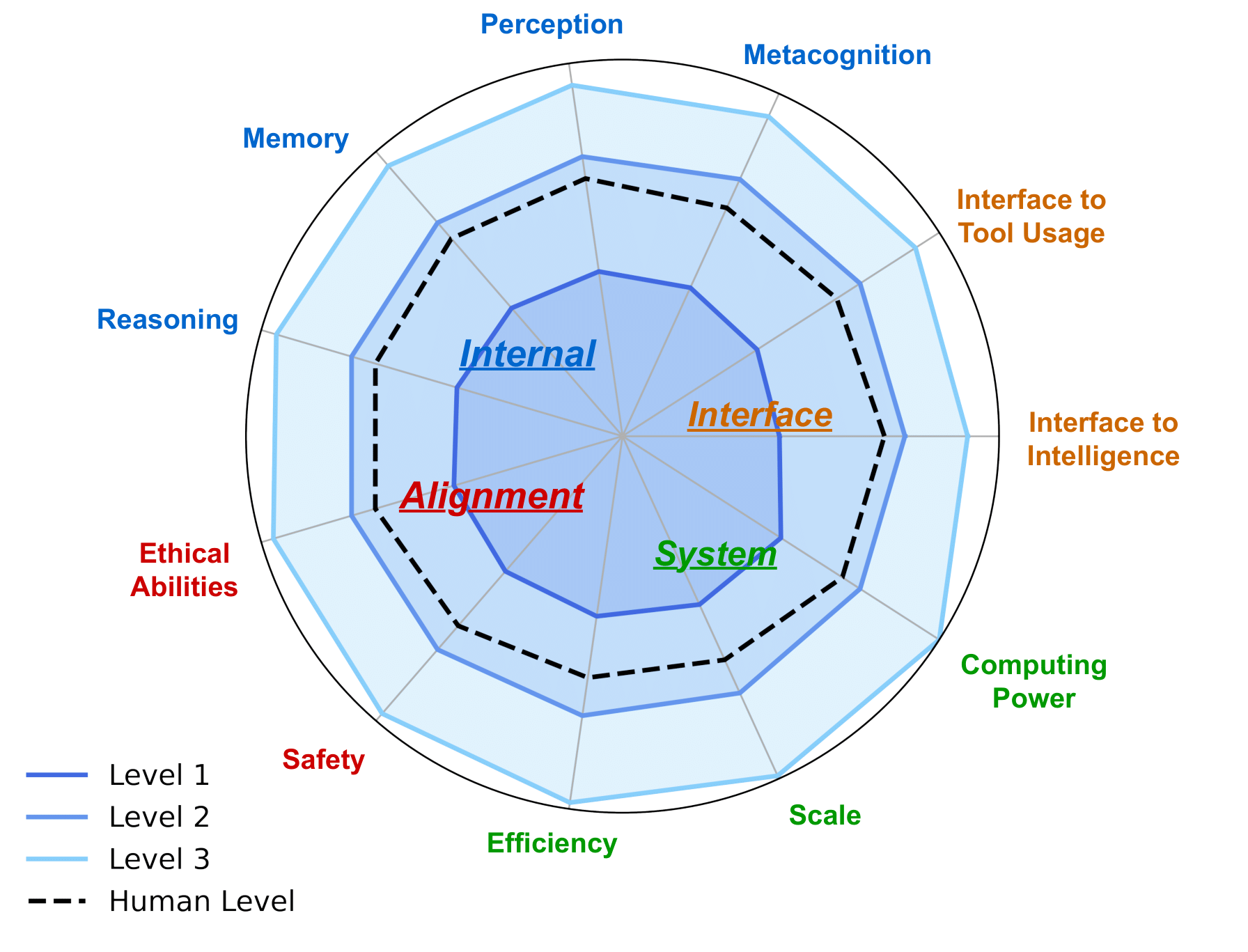

- 6. AGI-Roadmap: Verantwortungsvoller Umgang mit AGI

- 6.1 KI-Ebenen: Darstellung der Entwicklung der künstlichen Intelligenz

- 6.2 AGI-Bewertung

- 6.2.1 Erwartungen an die AGI-Bewertung

- 6.2.2 Aktuelle Auswertungen und ihre Grenzen

- 6.5 Weitere Überlegungen während der AGI-Entwicklung

- 7. Fallstudien

- 7.1 KI für wissenschaftliche Entdeckung und Forschung

- 7.2 Generative visuelle Intelligenz

- 7.3 Weltmodelle

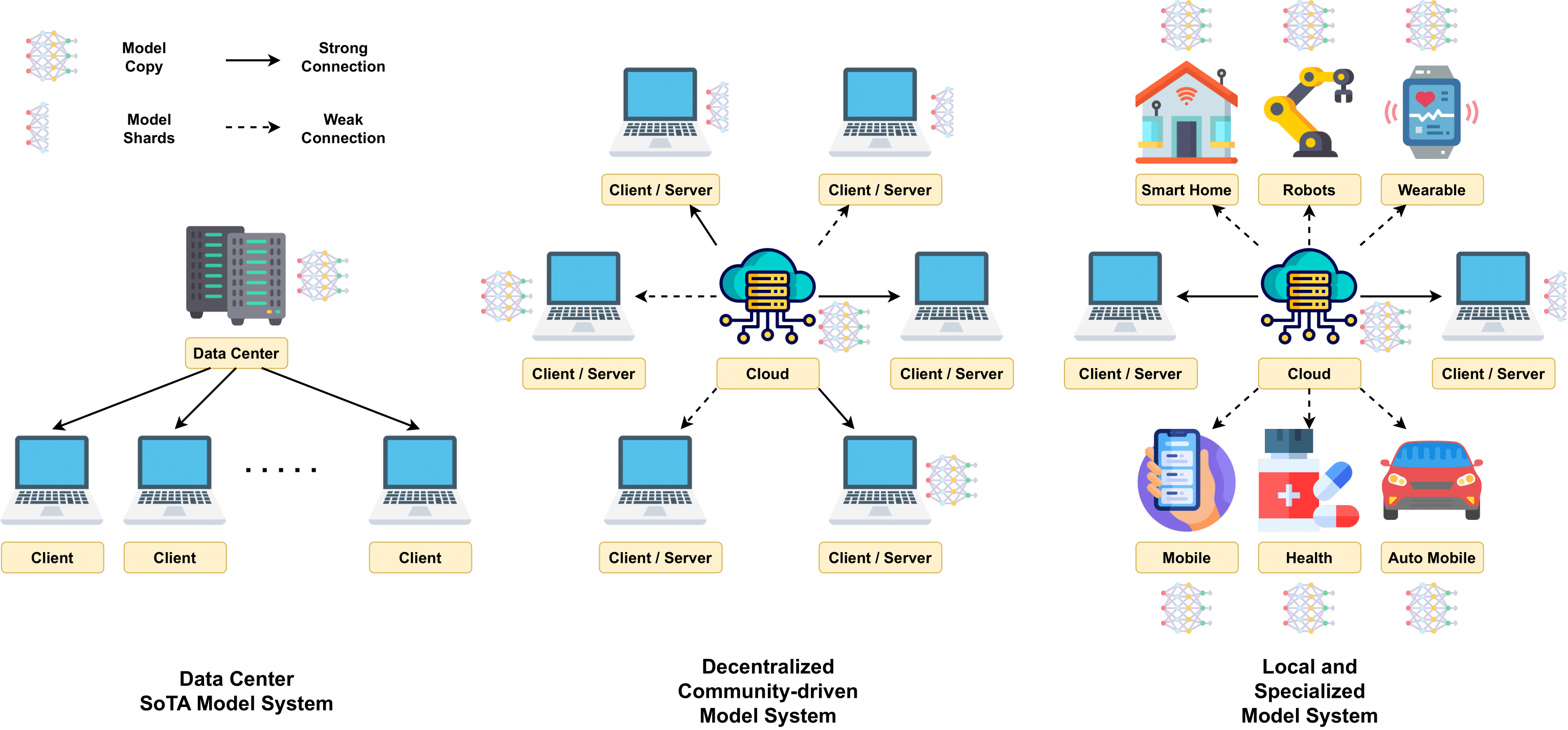

- 7.4 Dezentrales LLM

- 7.5 KI für die Codierung

- 7.6 KI für Robotik in realen Anwendungen

- 7.7 Mensch-KI-Zusammenarbeit

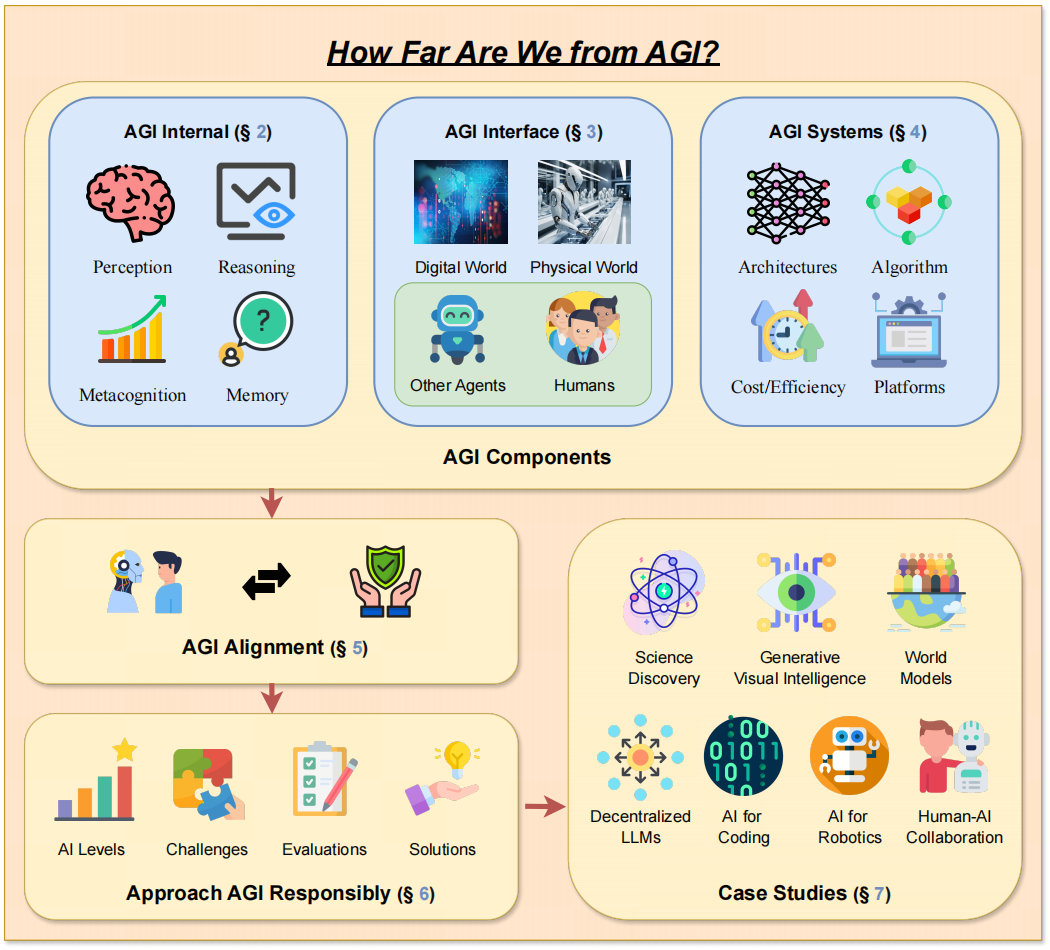

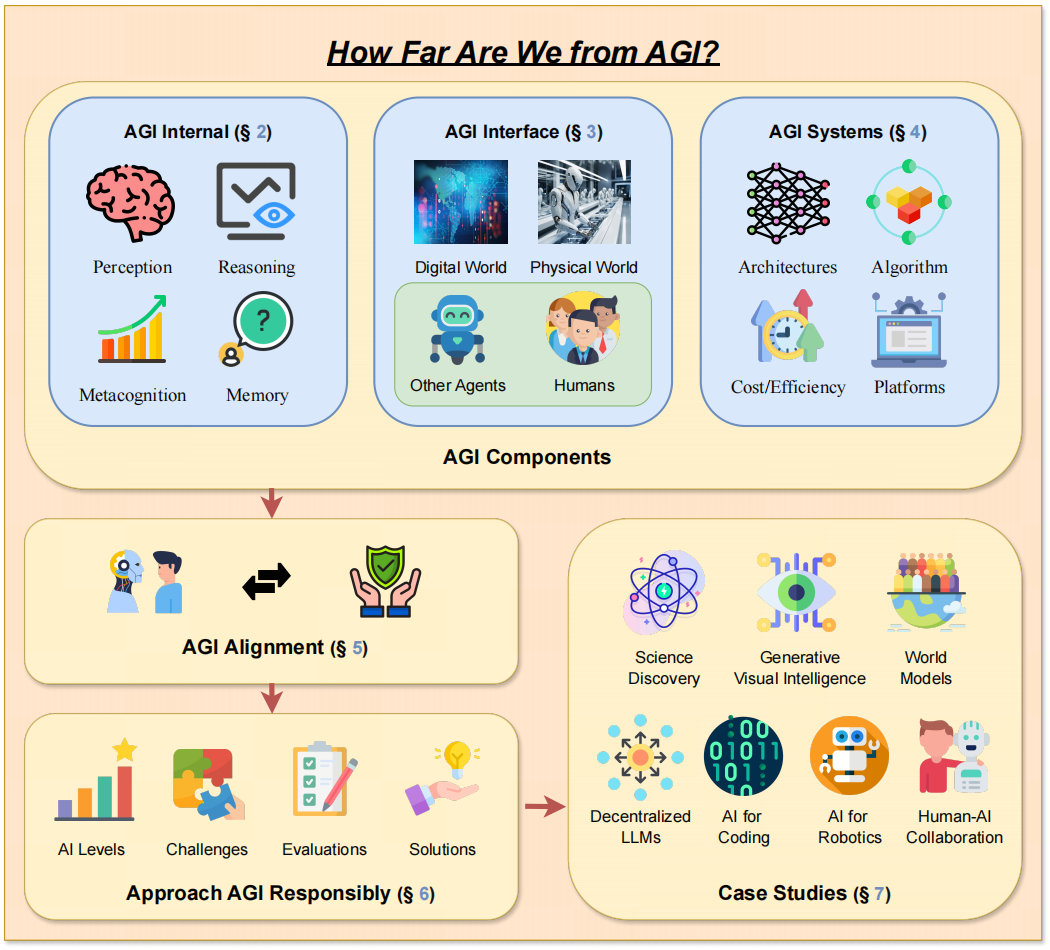

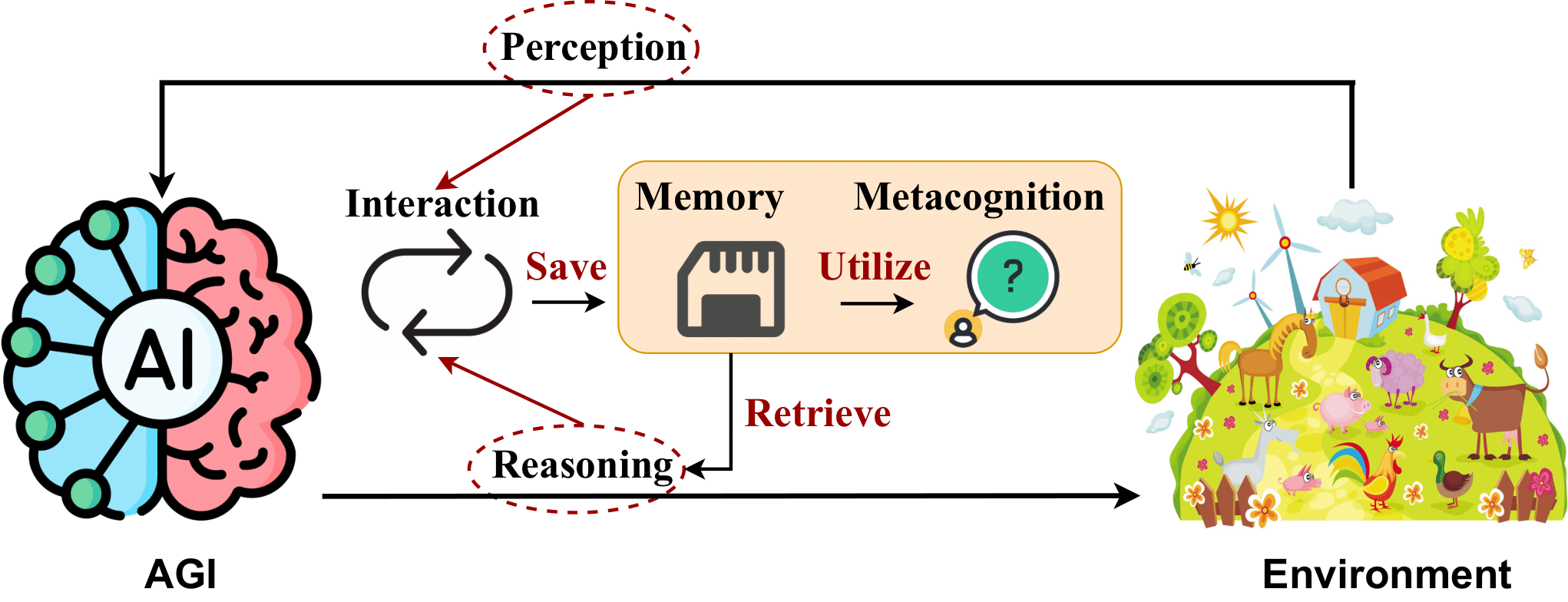

-> Das Rahmendesign unserer Arbeit. <-

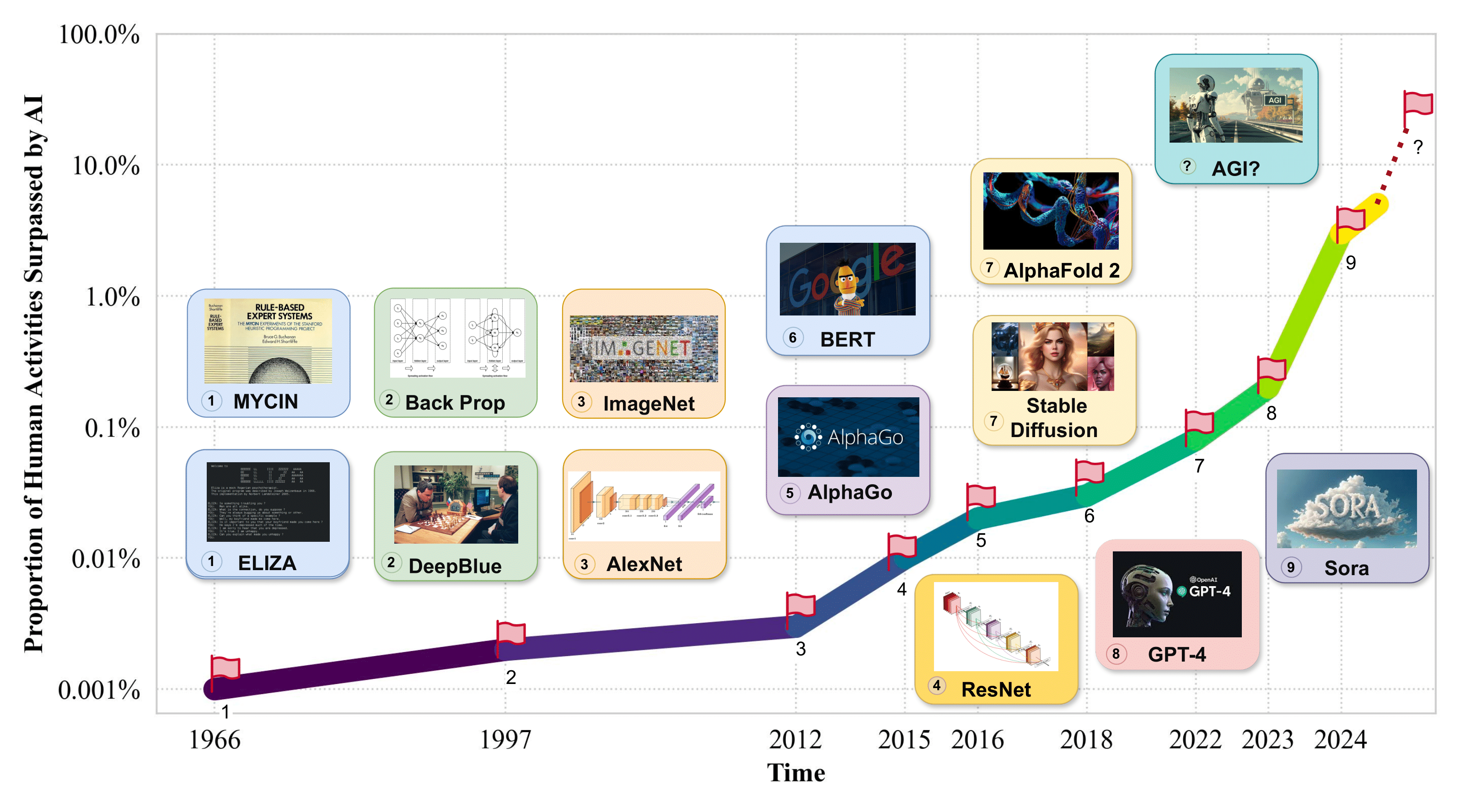

1. Einführung

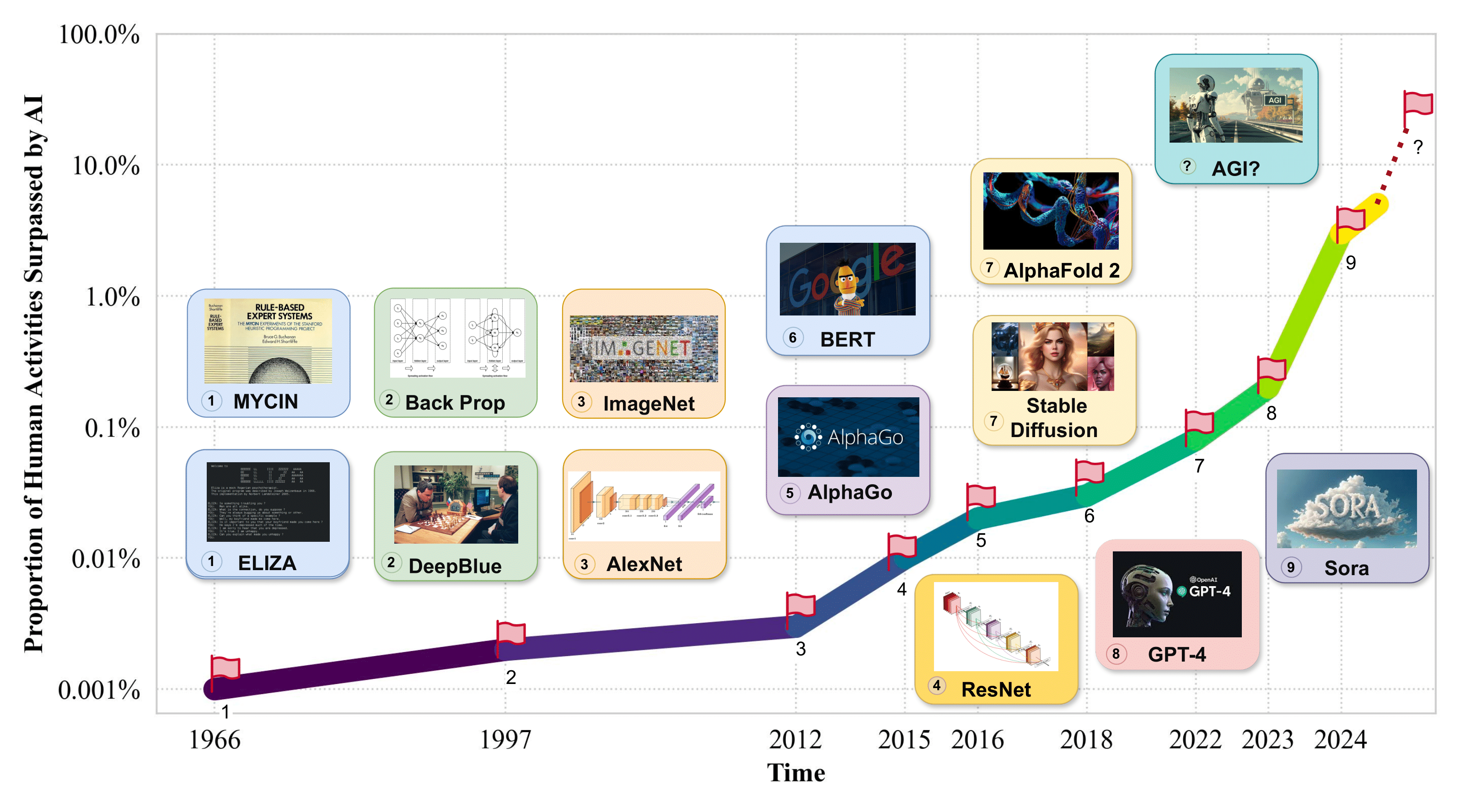

-> Anteil menschlicher Aktivitäten, der von KI übertroffen wird. <-

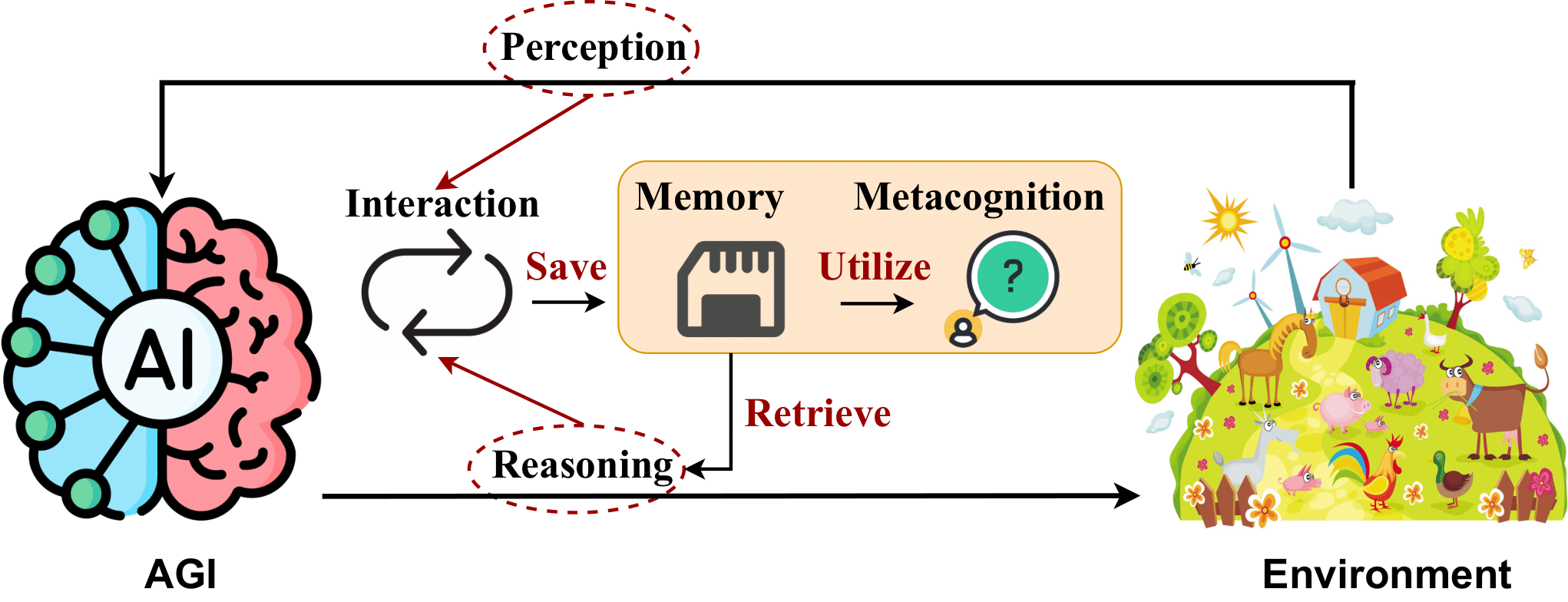

2. AGI Internal: Enthüllung des Geistes von AGI

2.1 KI-Wahrnehmung

- Flamingo: ein visuelles Sprachmodell für Few-Shot-Lernen . Jean-Baptiste Alayrac et al. NeurIPS 2022. [Papier]

- BLIP-2: Bootstrapping-Sprach-Bild-Vortraining mit eingefrorenen Bildkodierern und großen Sprachmodellen . Junnan Li et al. ICML 2023. [Papier]

- SPHINX: Das gemeinsame Mischen von Gewichten, Aufgaben und visuellen Einbettungen für multimodale große Sprachmodelle . Ziyi Lin et al. EMNLP 2023. [Papier]

- Visuelle Anweisungsoptimierung . Haotian Liu et al. NeurIPS 2023. [Papier]

- GPT4Tools: Lehren eines großen Sprachmodells zur Verwendung von Tools durch Selbstunterricht . Rui Yang et al. NeurIPS 2023. [Papier]

- Otter: Ein multimodales Modell mit kontextbezogener Befehlsoptimierung . Bo Li et al. arXiv 2023. [Papier]

- VideoChat: Chat-zentriertes Videoverständnis . KunChang Li et al. arXiv 2023. [Papier]

- „mPLUG-Owl: Modularisierung ermöglicht großen Sprachmodellen Multimodalität“ . Qinghao Ye et al. arXiv 2023. [Papier]

- Eine Umfrage zu multimodalen großen Sprachmodellen . Shukang Yin et al. arXiv 2023. [Papier]

- PandaGPT: Ein Modell zum Anleiten – Befolgen Sie alle . Yixuan Su et al. arXiv 2023. [Papier]

- LLaMA-Adapter: Effiziente Feinabstimmung von Sprachmodellen mit Zero-Init-Aufmerksamkeit . Renrui Zhang et al. arXiv 2023. [Papier]

- Gemini: Eine Familie hochleistungsfähiger multimodaler Modelle . Rohan Anil et al. arXiv 2023. [Papier]

- Shikra: Die Magie des referenziellen Dialogs im multimodalen LLM entfesseln . Keqin Chen et al. arXiv 2023. [Papier]

- ImageBind: Ein Einbettungsbereich, um sie alle zu binden . Rohit Girdhar et al. CVPR 2023. [Papier]

- MobileVLM: Ein schneller, starker und offener Sprachassistent für mobile Geräte . Xiangxiang Chu et al. arXiv 2023. [Papier]

- Was macht gute visuelle Tokenizer für große Sprachmodelle aus? . Guangzhi Wang et al. arXiv 2023. [Papier]

- MiniGPT-4: Verbesserung des Vision-Sprachverständnisses mit fortschrittlichen großen Sprachmodellen . Deyao Zhu et al. ICLR 2024. [Papier]

- LanguageBind: Erweiterung des Videosprachen-Vortrainings auf N-Modalität durch sprachbasierte semantische Ausrichtung . Bin Zhu et al. ICLR 2024. [Papier]

2.2 KI-Argumentation

- „Die Aufforderung zur Gedankenkette löst Argumentation in großen Sprachmodellen aus“ . Jason Wei et al. NeurIPS 2022. [Papier]

- Neuronale Theorie des Geistes? Über die Grenzen der sozialen Intelligenz in großen LMs . Maarten Sap et al. EMNLP 2022. [Papier]

- Innerer Monolog: Verkörpertes Denken durch Planung mit Sprachmodellen . Wenlong Huang et al. CoRL 2022. [Papier]

- Übersicht über Halluzinationen bei der Erzeugung natürlicher Sprache . Ziwei Ji et al. ACM Computing Surveys 2022. [Papier]

- ReAct: Synergie zwischen Denken und Handeln in Sprachmodellen . Shunyu Yao et al. ICLR 2023. [Papier]

- Zerlegte Eingabeaufforderungen: Ein modularer Ansatz zur Lösung komplexer Aufgaben . Tushar Khot et al. ICLR 2023. [Papier]

- Komplexitätsbasierte Eingabeaufforderung für mehrstufiges Denken . Yao Fu et al. ICLR 2023. [Papier]

- „Least-to-Most-Prompting“ ermöglicht komplexes Denken in großen Sprachmodellen . Denny Zhou et al. ICLR 2023. [Papier]

- Auf dem Weg zum Denken in großen Sprachmodellen: Eine Umfrage . Jie Huang et al. ACL-Ergebnisse 2023. [Papier]

- ProgPrompt: Generieren lokalisierter Roboteraufgabenpläne mithilfe großer Sprachmodelle . Ishika Singh et al. ICRA 2023. [Papier]

- Das Denken mit dem Sprachmodell ist das Planen mit dem Weltmodell . Shibo Hao et al. EMNLP 2023. [Papier]

- „Bewertung der Objekthalluzination in großen Seh-Sprach-Modellen“ . Yifan Li et al. EMNLP 2023. [Papier]

- Gedankenbaum: Bewusste Problemlösung mit großen Sprachmodellen . Shunyu Yao et al. NeurIPS 2023. [Papier]

- Selbstverfeinerung: Iterative Verfeinerung mit Selbst-Feedback . Aman Madaan et al. NeurIPS 2023. [Papier]

- Reflexion: Sprachagenten mit verbalem Verstärkungslernen . Noah Shinn et al. NeurIPS 2023. [Papier]

- Beschreiben, erklären, planen und auswählen: Interaktive Planung mit großen Sprachmodellen ermöglicht Open-World-Multitasking-Agenten . Zihao Wang et al. NeurIPS 2023. [Papier]

- LLM+P: Unterstützung großer Sprachmodelle durch optimale Planungskompetenz . Bo Liu et al. arXiv 2023. [Papier]

- Sprachmodelle, Agentenmodelle und Weltmodelle: Das GESETZ für maschinelles Denken und Planen . Zhiting Hu et al. arXiv 2023. [Papier]

- MMToM-QA: Multimodale Theorie der Beantwortung von Geistesfragen . Chuanyang Jin et al. arXiv 2024. [Papier]

- Gedankengraphik: Komplexe Probleme mit großen Sprachmodellen lösen . Maciej Besta et al. AAAI 2024. [Papier]

- Erreichen von >97 % bei GSM8K: Ein tiefes Verständnis der Probleme macht LLMs zu perfekten Denkern . Qihuang Zhong et al. arXiv 2024. [Papier] ausstehend

2.3 KI-Speicher

- Dense Passage Retrieval für die Beantwortung von Open-Domain-Fragen . Vladimir Karpukhin et al. EMNLP 2020. [Papier]

- Retrieval-Augmented Generation für wissensintensive NLP-Aufgaben . Patrick Lewis et al. NeurIPS 2020. [Papier]

- REALM: Retrieval-Augmented Language Model Pre-Training . Kelvin Guu et al. ICML 2020. [Papier]

- Retrieval Augmentation reduziert Halluzinationen im Gespräch . Kurt Shuster et al. EMNLP-Ergebnisse 2021. [Papier]

- Verbesserung von Sprachmodellen durch Abrufen von Billionen von Tokens . Sebastian Borgeaud et al. ICML 2022. [Papier]

- Generative Agenten: Interaktive Simulakren des menschlichen Verhaltens . Joon Sung Park et al. UIST 2023. [Papier]

- Kognitive Architekturen für Sprachagenten . Theodore R. Sumers et al. TMLR 2024. [Papier]

- Voyager: Ein verkörperter Agent mit offenem Ende und großen Sprachmodellen . Guanzhi Wang et al. arXiv 2023. [Papier]

- Eine Übersicht über den Gedächtnismechanismus von Agenten, die auf großen Sprachmodellen basieren . Zeyu Zhang et al. arXiv 2024. [Papier]

- „Rekursives Zusammenfassen ermöglicht langfristiges Dialoggedächtnis in großen Sprachmodellen“ . Qingyue Wang et al. arXiv 2023. [Papier] ausstehend

2.4 KI-Metakognition

- Die Berücksichtigung von Metafähigkeiten bei der Externalisierung stillschweigenden Wissens und beim organisatorischen Lernen . Jyoti Choudrie et al. HICSS 2006. [Papier]

- Sich weiterentwickelnde selbstüberwachte neuronale Netze Autonome Intelligenz durch weiterentwickeltes Selbstlernen . Nam Le . arXiv 2019. [Papier]

- Vorab trainierte Sprachmodelle zu besseren Lernern mit wenigen Schüssen machen . Tianyu Gao et al. ACL 2021. [Papier]

- Identifizierung und Manipulation der Persönlichkeitsmerkmale von Sprachmodellen . Graham Caron et al. arXiv 2022. [Papier]

- Brainish: Formalisierung einer multimodalen Sprache für Intelligenz und Bewusstsein . Paul Liang et al. arXiv 2022. [Papier]

- Eine Theorie des Bewusstseins aus theoretischer Informatikperspektive: Erkenntnisse aus der bewussten Turingmaschine . Lenore Blum et al. PNAS 2022. [Papier]

- WizardLM: Befähigung großer Sprachmodelle, komplexen Anweisungen zu folgen . Können Xu et al. arXiv 2023. [Papier]

- Selbstunterricht: Sprachmodelle mit selbst generierten Anweisungen ausrichten . Yizhong Wang et al. ACL 2023. [Papier]

- ReST trifft auf ReAct: Self-Improvement for Multi-Step Reasoning LLM Agent . Renat Aksitov et al. arXiv 2023. [Papier]

- Die Kulturpsychologie großer Sprachmodelle: Ist ChatGPT ein ganzheitlicher oder analytischer Denker? . Chuanyang Jin et al. arXiv 2023. [Papier]

- Bewusstsein in der künstlichen Intelligenz: Erkenntnisse aus der Wissenschaft des Bewusstseins . Patrick Butlin et al. arXiv 2023. [Papier]

- Überprüfung der Zuverlässigkeit psychologischer Skalen bei großen Sprachmodellen . Jen-tse Huang et al. arXiv 2023. [Papier]

- Bewertung und Induzierung der Persönlichkeit in vorab trainierten Sprachmodellen . Guangyuan Jiang et al. NeurIPS 2024. [Papier]

- Ebenen der AGI: Operationalisierung des Fortschritts auf dem Weg zur AGI . Meredith Ringel Morris et al. arXiv 2024. [Papier] ausstehend

- Investigate-Consolidate-Exploit: Eine allgemeine Strategie für die Selbstentwicklung von Agenten zwischen Aufgaben . Cheng Qian et al. arXiv 2024. [Papier] ausstehend

3. AGI-Schnittstelle: Die Welt mit AGI verbinden

3.1 KI-Schnittstellen zur digitalen Welt

- Prinzipien gemischter Benutzeroberflächen . Eric Horvitz. SIGCHI 1999. [Papier]

- Der Aufstieg und das Potenzial großer sprachmodellbasierter Agenten: Eine Umfrage . Zhiheng Xi et al. arXiv 2023. [Papier]

- Werkzeuglernen mit Grundlagenmodellen . Yujia Qin et al. arXiv 2023. [Papier]

- Schöpfer: Entwirrung abstrakter und konkreter Überlegungen großer Sprachmodelle durch Werkzeugerstellung . Cheng Qian et al. arXiv 2023. [Papier]

- AppAgent: Multimodale Agenten als Smartphone-Nutzer . Zhao Yang et al. arXiv 2023. [Papier]

- Mind2Web: Auf dem Weg zu einem generalistischen Agenten für das Web . Xiang Deng et al. NeurIPS-Benchmark 2023. [Papier]

- ToolQA: Ein Datensatz für die Beantwortung von LLM-Fragen mit externen Tools . Yuchen Zhuang et al. arXiv 2023. [Papier]

- Generative Agenten: Interaktive Simulationen menschlichen Verhaltens . Joon Sung Park et al. arXiv 2023. [Papier]

- Toolformer: Sprachmodelle können sich den Umgang mit Werkzeugen selbst beibringen . Timo Schick et al. arXiv 2023. [Papier]

- Gorilla: Großes Sprachmodell verbunden mit riesigen APIs . Shishir G. Patil et al. arXiv 2023. [Papier]

- Voyager: Ein verkörperter Agent mit offenem Ende und großen Sprachmodellen . Guanzhi Wang et al. arXiv 2023. [Papier]

- OS-Copilot: Auf dem Weg zu generalistischen Computeragenten mit Selbstverbesserung . Zhiyong Wu et al. arXiv 2024. [Papier]

- WebArena: Eine realistische Webumgebung zum Aufbau autonomer Agenten . Shuyan Zhou et al. ICLR 2024. [Papier]

- Große Sprachmodelle als Werkzeugmacher . Tianle Cai et al. ICLR 2024. [Papier]

3.2 KI-Schnittstellen zur physischen Welt

- Lehren aus der Amazon Picking Challenge: Vier Aspekte des Aufbaus von Robotersystemen . Clemens Eppner et al. RSS 2016. [Papier]

- „Perceiver-Actor: Ein Multitasking-Transformator für Robotermanipulation“ . Mohit Shridhar et al. arXiv 2022. [Papier]

- Vima: Allgemeine Robotermanipulation mit multimodalen Eingabeaufforderungen . Yunfan Jiang et al. arXiv 2022. [Papier]

- Tue, was ich kann, nicht, was ich sage: Sprache in robotischen Angeboten verankern . Michael Ahn et al. arXiv 2022. [Papier]

- Voxposer: Zusammensetzbare 3D-Wertkarten für die Robotermanipulation mit Sprachmodellen . Wenlong Huang et al. arXiv 2023. [Papier]

- MotionGPT: Menschliche Bewegung als Fremdsprache . Biao Jiang et al. arXiv 2023. [Papier]

- Rt-2: Vision-Sprach-Aktionsmodelle übertragen Webwissen auf Robotersteuerung . Anthony Brohan et al. arXiv 2023. [Papier]

- Navigieren zu Objekten in der realen Welt . Theophile Gervet et al. Wissenschaftsrobotik 2023. [Papier]

- Lm-nav: Roboternavigation mit großen vortrainierten Modellen für Sprache, Vision und Aktion . Dhruv Shah et al. CRL 2023. [Papier]

- Palm-e: Ein verkörpertes multimodales Sprachmodell . Danny Driess et al. arXiv 2023. [Papier]

- LLM-Planner: Few-Shot Grounded Planning für verkörperte Agenten mit großen Sprachmodellen . Chan Hee Song et al. ICCV 2023. [Papier]

- Instruct2Act: Zuordnung multimodaler Anweisungen zu Roboteraktionen mit einem großen Sprachmodell . Siyuan Huang et al. arXiv 2023. [Papier]

- DROID: Ein umfangreicher Datensatz zur Robotermanipulation in freier Wildbahn . Alexander Khazatsky et al. arXiv 2024. [Papier]

- BEHAVIOR-1K: Ein menschenzentrierter, verkörperter KI-Benchmark mit 1.000 alltäglichen Aktivitäten und realistischer Simulation . Chengshu Li et al. arXiv 2024. [Papier]

3.3 KI-Schnittstellen zur Intelligenz

3.3.1 KI-Schnittstellen zu KI-Agenten

- Kontrafaktische Multi-Agenten-Politikgradienten . Jakob Foerster et al. AAAI 2018. [Papier]

- Erklärungen aus großen Sprachmodellen machen kleine Denker besser . Shiyang Li et al. arXiv 2022. [Papier]

- Destillation des kontextbezogenen Lernens: Übertragung der Few-Shot-Lernfähigkeit vorab trainierter Sprachmodelle . Yukun Huang et al. arXiv 2022. [Papier]

- Autoagents: Ein Framework für die automatische Agentengenerierung . Guangyao Chen et al. arXiv 2023. [Papier]

- „Neuronale amortisierte Inferenz für verschachteltes Multi-Agenten-Denken“ . Kunal Jha et al. arXiv 2023. [Papier]

- Wissensdestillation großer Sprachmodelle . Yuxian Gu et al. arXiv 2023. [Papier]

- Metagpt: Metaprogrammierung für ein kollaboratives Framework mit mehreren Agenten . Sirui Hong et al. arXiv 2023. [Papier]

- Beschreiben, erklären, planen und auswählen: Interaktive Planung mit großen Sprachmodellen ermöglicht Open-World-Multitasking-Agenten . Zihao Wang et al. arXiv 2023. [Papier]

- Agentverse: Erleichterung der Zusammenarbeit mehrerer Agenten und Erforschung neu auftretender Verhaltensweisen bei Agenten . Weize Chen et al. arXiv 2023. [Papier]

- Mindstorms in auf natürlicher Sprache basierenden Geistesgesellschaften . Mingchen Zhuge et al. arXiv 2023. [Papier]

- Jarvis-1: Open-World-Multitasking-Agenten mit speichererweiterten multimodalen Sprachmodellen . Zihao Wang et al. arXiv 2023. [Papier]

- Symbolische Gedankenkettendestillation: Auch kleine Modelle können Schritt für Schritt „denken“ . Liunian Harold Li et al. ACL 2023. [Papier]

- Destillieren Schritt für Schritt! Übertreffen größerer Sprachmodelle mit weniger Trainingsdaten und kleineren Modellgrößen . Cheng-Yu Hsieh et al. arXiv 2023. [Papier]

- „Schwach-zu-stark“-Verallgemeinerung: Starke Fähigkeiten durch schwache Aufsicht hervorbringen . Collin Burns et al. arXiv 2023. [Papier]

- Verbesserung von Chat-Sprachmodellen durch Skalierung hochwertiger Lehrgespräche . Ning Ding et al. arXiv 2023. [Papier]

- GAIA: ein Maßstab für allgemeine KI-Assistenten . Grégoire Mialon et al. ICLR 2024. [Papier]

- Voyager: Ein verkörperter Agent mit offenem Ende und großen Sprachmodellen . Guanzhi Wang et al. arXiv 2023. [Papier]

- Camel: Kommunikative Agenten zur „geistigen“ Erforschung einer groß angelegten Sprachmodellgesellschaft . Guohao Li et al. arXiv 2023. [Papier]

- Maßgeschneiderte Selbstrationalisierer mit Multi-Belohnungs-Destillation . Sahana Ramnath et al. arXiv 2023. [Papier]

- Vision Superalignment: Schwach-zu-stark-Verallgemeinerung für Vision Foundation-Modelle . Jianyuan Guo et al. arXiv 2024. [Papier]

- WebArena: Eine realistische Webumgebung zum Aufbau autonomer Agenten . Shuyan Zhou et al. ICLR 2024. [Papier]

- Prinzipgesteuerte Selbstausrichtung von Sprachmodellen von Grund auf mit minimaler menschlicher Aufsicht . Zhiqing Sun et al. NeurIPS 2024. [Papier]

- Mind2web: Auf dem Weg zu einem generalistischen Agenten für das Web . Xiang Deng et al. NeurIPS 2024. [Papier]

- Auf dem Weg zur allgemeinen Computersteuerung: Ein multimodaler Agent für Red Dead Redemption II als Fallstudie . Weihao Tan et al. arXiv 2024. [Papier]

3.3.2 KI-Schnittstellen zum Menschen

- Richtlinien für die Mensch-KI-Interaktion . Saleema Amershi et al. CHI 2019. [Papier]

- Designprinzipien für generative KI-Anwendungen . Justin D. Weisz et al. CHI 2024. [Papier]

- Graphologue: Erkunden großer Sprachmodellantworten mit interaktiven Diagrammen . Peiling Jiang et al. UIST 2023. [Papier]

- Sensecape: Ermöglichung der mehrstufigen Erkundung und Sinneswahrnehmung mit großen Sprachmodellen . Sangho Suh et al. UIST 2023. [Papier]

- Unterstützung der Sensemaking großer Sprachmodellausgaben im großen Maßstab . Katy Ilonka Gero et al. CHI 2024. [Papier]

- Luminate: Strukturierte Generierung und Erforschung des Designraums mit großen Sprachmodellen für die gemeinsame Gestaltung von Mensch und KI . Sangho Suh et al. CHI 2024. [Papier]

- KI-Ketten: Transparente und kontrollierbare Mensch-KI-Interaktion durch Verkettung großer Sprachmodell-Eingabeaufforderungen . Tongshuang Wu et al. CHI 2022. [Papier]

- Promptify: Text-zu-Bild-Generierung durch interaktive Prompt-Exploration mit großen Sprachmodellen . Stephen Brade et al. CHI 2023. [Papier]

- ChainForge: Ein visuelles Toolkit für Prompt Engineering und LLM-Hypothesetests . Ian Arawjo et al. CHI 2024. [Papier]

- CoPrompt: Unterstützung des sofortigen Teilens und Verweisens bei der kollaborativen Programmierung in natürlicher Sprache . Li Feng et al. CHI 2024. [Papier]

- Generieren von automatischem Feedback zu UI-Mockups mit großen Sprachmodellen . Peitong Duan et al. CHI 2024. [Papier]

- Rambler: Unterstützung des Schreibens mit Sprache durch LLM-unterstützte Gist-Manipulation . Susan Lin et al. CHI 2024. [Papier]

- Einbettung großer Sprachmodelle in die erweiterte Realität: Chancen und Herausforderungen für Inklusion, Engagement und Privatsphäre . Efe Bozkir et al. arXiv 2024. [Papier]

- GenAssist: Bilderzeugung zugänglich machen . Mina Huh et al. UIST 2023. [Papier]

- „Je weniger ich tippe, desto besser“: Wie KI-Sprachmodelle die Kommunikation für AAC-Benutzer verbessern oder behindern können . Stephanie Valencia et al. CHI 2023. [Papier]

- Erneute Untersuchung, ob, warum und wie die Interaktion zwischen Mensch und KI besonders schwierig zu gestalten ist . Qian Yang et al. CHI 2020. [Papier]

4. AGI-Systeme: Implementierung des AGI-Mechanismus

4.2 Skalierbare Modellarchitekturen

- Unverschämt große neuronale Netze: Die spärlich begrenzte Expertenmischungsschicht . Noam Shazeer et al. arXiv 2017. [Papier]

- Transformatoren sind RNNs: Schnelle autoregressive Transformatoren mit linearer Aufmerksamkeit . Angelos Katharopoulos et al. arXiv 2020. [Papier]

- Longformer: Der Long-Document-Transformer . Iz Beltagy et al. arXiv 2020. [Papier]

- LightSeq: Eine leistungsstarke Inferenzbibliothek für Transformatoren . Xiaohui Wang et al. arXiv 2021. [Papier]

- Schalttransformatoren: Skalierung auf Billionen-Parametermodelle mit einfacher und effizienter Sparsity . William Fedus et al. arXiv 2022. [Papier]

- Effiziente Modellierung langer Sequenzen mit strukturierten Zustandsräumen . Albert Gu et al. arXiv 2022. [Papier]

- MegaBlocks: Effizientes Sparse-Training mit einer Expertenmischung . Trevor Gale et al. arXiv 2022. [Papier]

- Training rechenoptimaler großer Sprachmodelle . Jordan Hoffmann et al. arXiv 2022. [Papier]

- Effektive Langkontextskalierung von Foundation-Modellen . Wenhan Xiong et al. arXiv 2023. [Papier]

- Hyänenhierarchie: Auf dem Weg zu größeren Faltungssprachmodellen . Michael Poli et al. arXiv 2023. [Papier]

- Stanford Alpaca: Ein Anweisungsfolgendes LLaMA-Modell . Rohan Taori et al. GitHub 2023. [Code]

- Rwkv: RNNs für die Transformer-Ära neu erfinden . Bo Peng et al. arXiv 2023. [Papier]

- Deja Vu: Kontextuelle Sparsität für effiziente LLMs zur Inferenzzeit . Zichang Liu et al. arXiv 2023. [Papier]

- Flash-LLM: Ermöglicht kostengünstige und hocheffiziente Inferenz großer generativer Modelle mit unstrukturierter Sparsity . Haojun Xia et al. arXiv 2023. [Papier]

- ByteTransformer: Ein Hochleistungstransformator für Eingaben variabler Länge . Yujia Zhai et al. arXiv 2023. [Papier]

- Tutel: Adaptive Expertenmischung im großen Maßstab . Changho Hwang et al. arXiv 2023. [Papier]

- Mamba: Linearzeitsequenzmodellierung mit selektiven Zustandsräumen . Albert Gu, Tri Dao. arXiv 2023. [Papier]

- Hungry Hungry Hippos: Auf dem Weg zur Sprachmodellierung mit Zustandsraummodellen . Daniel Y. Fu et al. arXiv 2023. [Papier]

- Remanentes Netzwerk: Ein Nachfolger des Transformers für große Sprachmodelle . Yutao Sun et al. ArXiv, 2023.

- Mechanistischer Entwurf und Skalierung hybrider Architekturen . Michael Poli et al. arXiv 2024. [Papier]

- Überarbeitung der Wissensdestillation für autoregressive Sprachmodelle . Qihuang Zhong et al. arXiv 2024. [Papier]

- DB-LLM: Genaue Dual-Binarisierung für effiziente LLMs . Hong Chen et al. arXiv 2024. [Papier]

- Reduzieren der Größe des Transformer-Schlüsselwertcaches mit schichtübergreifender Aufmerksamkeit . William Brandon et al. arXiv 2024.[Papier]

- Sie zwischenspeichern nur einmal: Decoder-Decoder-Architekturen für Sprachmodelle Yutao Sun et al. arXiv 2024. [Papier]

4.3 Groß angelegte Schulung

- Training tiefer Netze mit sublinearen Speicherkosten . Tianqi Chen et al. arXiv 2016. [Papier]

- Jenseits von Daten- und Modellparallelität für tiefe neuronale Netze . Zhihao Jia et al. arXiv 2018. [Papier]

- GPipe: Effizientes Training riesiger neuronaler Netze mithilfe von Pipeline-Parallelität . Yanping Huang et al. arXiv 2019. [Papier]

- Parametereffizientes Transferlernen für NLP . Neil Houlsby et al. ICML 2019. Papier

- Megatron-LM: Training von Sprachmodellen mit mehreren Milliarden Parametern mithilfe von Modellparallelität . Mohammad Shoeybi et al. arXiv 2020. [Papier]

- Alpa: Automatisierung der Inter- und Intra-Operator-Parallelität für verteiltes Deep Learning . Lianmin Zheng et al. arXiv 2022. [Papier]

- DeepSpeed-Inferenz: Ermöglicht eine effiziente Inferenz von Transformatormodellen in beispiellosem Maßstab . Reza Yazdani Aminabadi et al. arXiv 2022. [Papier]

- Auswendiglernen ohne Überanpassung: Analyse der Trainingsdynamik großer Sprachmodelle . Kushal Tirumala et al. arXiv 2022. [Papier]

- SWARM-Parallelität: Das Training großer Modelle kann überraschend kommunikationseffizient sein . Max Ryabinin et al. arXiv 2023. [Papier]

- Trainingsverläufe von Sprachmodellen über Skalen hinweg . Mengzhou Xia et al. arXiv 2023. [Papier]

- HexGen: Generative Inferenz des Foundation-Modells über eine heterogene dezentrale Umgebung . Youhe Jiang et al. arXiv 2023. [Papier]

- FusionAI: Dezentrales Training und Bereitstellung von LLMs mit massiven GPUs auf Verbraucherebene . Zhenheng Tang et al. arXiv 2023. [Papier]

- Erregen Sie Aufmerksamkeit mit blockweisen Transformatoren für nahezu unendlichen Kontext . Hao Liu et al. arXiv 2023. [Papier]

- Pythia: Eine Suite zur Analyse großer Sprachmodelle über Training und Skalierung hinweg . Stella Biderman et al. arXiv 2023. [Papier]

- Feinabstimmung von Sprachmodellen über langsame Netzwerke mithilfe der Aktivierungskomprimierung mit Garantien . Jue Wang et al. arXiv 2023. [Papier]

- LLaMA-Adapter: Effiziente Feinabstimmung von Sprachmodellen mit Zero-Init-Aufmerksamkeit . Renrui Zhang et al. arXiv 2023. [Papier]

- QLoRA: Effiziente Feinabstimmung quantisierter LLMs . Tim Dettmers et al. arXiv 2023. [Papier]

- Effiziente Speicherverwaltung für die Bereitstellung großer Sprachmodelle mit PagedAttention . Woosuk Kwon et al. arXiv 2023. [Papier]

- Infinite-LLM: Effizienter LLM-Dienst für lange Kontexte mit DistAttention und verteiltem KVCache . Bin Lin et al. arXiv 2024. [Papier]

- OLMo: Beschleunigung der Wissenschaft der Sprachmodelle . Dirk Groeneveld et al. arXiv 2024. [Papier]

- Zum effizienten Training groß angelegter Deep-Learning-Modelle: Eine Literaturübersicht . Li Shen et al. arXiv 2023. [Papier] ausstehend

4.4 Inferenztechniken

- FlashAttention: Schnelle und speichereffiziente exakte Aufmerksamkeit mit IO-Awareness . Tri Dao et al. NeurIPS 2022. [Papier]

- Draft & Verify: Verlustfreie Beschleunigung großer Sprachmodelle durch selbstspekulative Dekodierung . Jun Zhang et al. arXiv 2023. [Papier]

- Auf dem Weg zu einer effizienten generativen Bereitstellung großer Sprachmodelle: Ein Überblick von Algorithmen zu Systemen . Xupeng Miao et al. arXiv 2023. [Papier]

- FlashDecoding++: Schnellere Inferenz großer Sprachmodelle auf GPUs . Ke Hong et al. arXiv 2023. [Papier]

- Schnelle Schlussfolgerung aus Transformatoren durch spekulative Dekodierung . Yaniv Leviathan et al. arXiv 2023. [Papier]

- Schnelle verteilte Inferenzbereitstellung für große Sprachmodelle . Bingyang Wu et al. arXiv 2023. [Papier]

- S-LoRA: Tausende gleichzeitige LoRA-Adapter bedienen . Ying Sheng et al. arXiv 2023. [Papier]

- TensorRT-LLM: Eine TensorRT-Toolbox für die optimierte Inferenz großer Sprachmodelle . NVIDIA. GitHub 2023. [Code]

- Punica: LoRA-Bereitstellung für mehrere Mandanten . Lequn Chen et al. arXiv 2023. [Papier]

- S$^3: Erhöhung der GPU-Auslastung während der generativen Inferenz für höheren Durchsatz . Yunho Jin et al. arXiv 2023. [Papier]

- Multi-LoRA-Inferenzserver, der auf Tausende fein abgestimmter LLMs skaliert werden kann . Prädibase. GitHub 2023. [Code]

- Prompt-Lookup-Dekodierung . Apoorv Saxena. GitHub 2023. [Code]

- FasterTransformer . NVIDIA. GitHub 2021. [Papier]

- DeepSpeed-FastGen: Textgenerierung mit hohem Durchsatz für LLMs über MII und DeepSpeed-Inference . Connor Holmes et al. arXiv 2024. [Papier]

- SpecInfer: Beschleunigung der generativen Bereitstellung großer Sprachmodelle mit baumbasierter spekulativer Inferenz und Verifizierung . Xupeng Miao et al. arXiv 2024. [Papier]

- Medusa: Einfaches LLM-Inferenzbeschleunigungs-Framework mit mehreren Dekodierungsköpfen . Tianle Cai et al. arXiv 2024. [Papier]

- Das Modell sagt Ihnen, was Sie verwerfen sollten: Adaptive KV-Cache-Komprimierung für LLMs . Suyu Ge et al. ICLR 2024. [Papier]

- Effiziente Streaming-Sprachmodelle mit Aufmerksamkeitssenken . Guangxuan Xiao et al. ICLR 2024. [Papier]

- DeFT: Flash Tree-Attention mit IO-Awareness für effiziente, auf Baumsuche basierende LLM-Inferenz . Jinwei Yao et al. arXiv 2024. [Papier]

- Effizientes Programmieren großer Sprachmodelle mit SGLang . Lianmin Zheng et al. arXiv 2023. [Papier]

- GESCHWINDIGKEIT: Spekulative Pipeline-Ausführung für effiziente Dekodierung . Coleman Hooper et al. arXiv 2023. [Papier]

- Sequoia: Skalierbare, robuste und hardwarebewusste spekulative Dekodierung . Zhuoming Chen et al. arXiv 2024. [Papier] ausstehend

4.5 Kosten und Effizienz

- Demonstrieren-Suchen-Vorhersagen: Erstellen von Retrieval- und Sprachmodellen für wissensintensives NLP . Omar Khattab et al. arXiv 2023. [Papier]

- Automatisiertes maschinelles Lernen: Methoden, Systeme, Herausforderungen . Frank Hutter et al. Springer Publishing Company, Incorporated, 2019.

- Modellsuppen: Die Mittelung der Gewichte mehrerer fein abgestimmter Modelle verbessert die Genauigkeit, ohne die Inferenzzeit zu verlängern . Mitchell Wortsman et al. arXiv 2022. [Papier]

- Daten-Debugging mit Shapley-Bedeutung gegenüber End-to-End-Pipelines für maschinelles Lernen . Bojan Karlaš et al. arXiv 2022. [Papier]

- Kostengünstige Hyperparameteroptimierung für die Inferenz der Generierung großer Sprachmodelle . Chi Wang et al. arXiv 2023. [Papier]

- Große Sprachmodelle sind schnelle Ingenieure auf menschlicher Ebene . Yongchao Zhou et al. arXiv 2023. [Papier]

- Zusammenführen durch übereinstimmende Modelle in Aufgabenunterräumen . Derek Tam et al. arXiv 2023. [Papier]

- Bearbeiten von Modellen mit Aufgabenarithmetik . Gabriel Ilharco et al. arXiv 2023. [Papier]

- PriorBand: Praktische Hyperparameteroptimierung im Zeitalter des Deep Learning . Neeratyoy Mallik et al. arXiv 2023. [Papier]

- Eine empirische Studie zur multimodalen Modellzusammenführung . Yi-Lin Sung et al. arXiv 2023. [Papier]

- DSPy: Kompilieren deklarativer Sprachmodellaufrufe in sich selbst verbessernden Pipelines . Omar Khattab et al. arXiv 2023. [Papier]

- FrugalGPT: Wie man große Sprachmodelle nutzt und gleichzeitig die Kosten senkt und die Leistung verbessert . Lingjiao Chen et al. arXiv 2023. [Papier]

- Tandemtransformatoren für inferenzeffiziente LLMs . Aishwarya PS et al. arXiv 2024. [Papier]

- AIOS: LLM-Agent-Betriebssystem . Kai Mei et al. arXiv 2024. [Papier]

- LoraHub: Effiziente aufgabenübergreifende Generalisierung durch dynamische LoRA-Komposition . Chengsong Huang et al. arXiv 2024. [Papier]

- AutoML im Zeitalter großer Sprachmodelle: Aktuelle Herausforderungen, zukünftige Chancen und Risiken . Alexander Tornede et al. arXiv 2024. [Papier]

- Experten zu einem zusammenführen: Verbesserung der Recheneffizienz der Expertenmischung . Shwai He et al. EMNLP 2023. [Papier] ausstehend

4.6 Computerplattformen

- TVM: Ein automatisierter End-to-End-Optimierungs-Compiler für Deep Learning . Tianqi Chen et al. arXiv 2018. [Papier]

- TPU v4: Ein optisch rekonfigurierbarer Supercomputer für maschinelles Lernen mit Hardware-Unterstützung für Einbettungen . Norman P. Jouppi et al. arXiv 2023. [Papier]

5. AGI-Ausrichtung: Sicherstellen, dass AGI verschiedene Anforderungen erfüllt

5.1 Erwartungen an die AGI-Ausrichtung

- Menschenverträglich: Künstliche Intelligenz und das Problem der Kontrolle . Stuart Russell . Wikinger, 2019.

- Künstliche Intelligenz, Werte und Ausrichtung . Iason Gabriel . Minds and Machines, 2020. [Papier]

- Ausrichtung von Sprachagenten . Zachary Kenton et al. arXiv, 2021. [Papier]

- Das Wertlernproblem . Nate Soares . Technischer Bericht des Machine Intelligence Research Institute [Papier]

- Konkrete Probleme der KI-Sicherheit . Dario Amodei et al. arXiv, 2016. [Papier]

- Ethische und soziale Schadensrisiken durch Sprachmodelle . Laura Weidinger et al. arXiv, 2021. [Papier]

- Über die Gefahren stochastischer Papageien: Können Sprachmodelle zu groß sein? . Emily M. Bender et al. FAccT 2021. [Papier]

- Die globale Landschaft der KI-Ethikrichtlinien . Anna Jobin et al. Nature Machine Intelligence, 2019. [Papier]

- Anhaltende antimuslimische Voreingenommenheit in großen Sprachmodellen . Abubakar Abid et al. AIES, 2021. [Papier]

- Auf dem Weg zu einer geschlechtsspezifischen Koreferenzlösung . Yang Trista Cao et al. ACL, 2020. [Papier]

- Die sozialen Auswirkungen der Verarbeitung natürlicher Sprache . Dirk Hovy et al. ACL 2016. [Papier]

- TruthfulQA: Messen, wie Modelle menschliche Unwahrheiten nachahmen . Stephanie Lin et al. ACL 2022. [Papier]

- Die Radikalisierungsrisiken von GPT-3 und fortgeschrittenen neuronalen Sprachmodellen . Kris McGuffie et al. arXiv, 2020. [Papier]

- KI-Transparenz im Zeitalter der LLMs: Eine auf den Menschen ausgerichtete Forschungs-Roadmap . F. Vera Liao et al. arXiv 2023. [Papier]

- Über Fachwissen und Rollen hinaus: Ein Rahmen zur Charakterisierung der Stakeholder des interpretierbaren maschinellen Lernens und ihrer Bedürfnisse . Harini Suresh et al. CHI 2021. [Papier]

- Identifizierung und Minderung der Sicherheitsrisiken generativer KI . Clark Barrett et al. arXiv, 2023. [Papier]

- LLM-Agenten können Websites autonom hacken . Richard Fang et al. arXiv, 2024. [Papier]

- Deepfakes, Phrenologie, Überwachung und mehr! Eine Taxonomie der KI-Datenschutzrisiken . Hao-Ping Lee et al. CHI 2024. [Papier]

- Datenschutz im Zeitalter der KI . Sauvik Das et al. Mitteilungen der ACM, 2023. [Papier]

5.2 Aktuelle Ausrichtungstechniken

- Lernen, mit menschlichem Feedback zusammenzufassen . Nisan Stiennon et al. NeurIPS 2020. [Papier]

- Zweite Gedanken sind am besten: Lernen, sich durch Textbearbeitungen wieder an menschlichen Werten auszurichten . Ruibo Liu et al. NeurIPS 2022. [Papier]

- Sprachmodelle trainieren, um Anweisungen mit menschlichem Feedback zu befolgen . Long Ouyang et al. NeurIPS 2022. [Papier]

- Die inneren Dämonen an die Leine nehmen: Selbstentgiftung für Sprachmodelle . Canwen Xu et al. AAAI 2022. Papier

- Generative Sprachmodelle an menschlichen Werten ausrichten . Ruibo Liu et al. NAACL 2022. [Papier]

- Ausbildung eines hilfreichen und harmlosen Assistenten mit verstärkendem Lernen aus menschlichem Feedback . Yuntao Bai et al. arXiv 2022. [Papier]

- Konstitutionelle KI: Harmlosigkeit durch KI-Feedback . Yuntao Bai et al. arXiv 2022. [Papier]

- Raft: Belohnungsranking-Feinabstimmung für die generative Fundamentmodellausrichtung . Hanze Dong et al. arXiv 2023. [Papier]

- Verbesserung von Sprachmodellen mit vorteilsbasierten Offline-Richtliniengradienten . Ashutosh Baheti et al. arXiv 2023. [Papier]

- Sprachmodelle mit maßstabsgetreuem Sprachfeedback trainieren . Jérémy Scheurer et al. arXiv 2023. [Papier]

- Ein allgemeines theoretisches Paradigma zum Verständnis des Lernens aus menschlichen Vorlieben . Mohammad Gheshlaghi Azar et al. arXiv 2023. [Papier]

- Lassen Sie uns Schritt für Schritt überprüfen . Hunter Lightman et al. arXiv 2023. [Papier]

- Offene Probleme und grundlegende Grenzen des verstärkenden Lernens aus menschlichem Feedback . Stephen Casper et al. arXiv 2023. [Papier]

- Ausrichten großer Sprachmodelle durch synthetisches Feedback . Sungdong Kim et al. arXiv 2023. [Papier]

- RLAIF: Skalierung des Verstärkungslernens aus menschlichem Feedback mit KI-Feedback . Harrison Lee et al. arXiv 2023. [Papier]

- Optimierung des Präferenzrankings für die menschliche Ausrichtung . Feifan Song et al. arXiv 2023. [Papier]

- Verbesserung der Faktizität und Argumentation in Sprachmodellen durch Multiagentendebatte . Yilun Du et al. arXiv 2023. [Papier]

- Ausrichtung großer Sprachmodelle: Eine Umfrage . Tianhao Shen et al. arXiv 2023. [Papier]

- Direkte Präferenzoptimierung: Ihr Sprachmodell ist insgeheim ein Belohnungsmodell . Rafael Rafailov et al. NeurIPS 2024. [Papier]

- Lima: Weniger ist mehr für die Ausrichtung . Chunting Zhou et al. NeurIPS 2024. [Papier]

5.3 Vorgehensweise bei AGI-Ausrichtungen

- Ethische und soziale Schadensrisiken durch Sprache . Mellor Weidinger et al. arXiv 2021. [Papier]

- Internationaler Konsens zur KI-Sicherheit in Peking . Pekinger Akademie für Künstliche Intelligenz. 2024. [Papier]

- Kontrafaktische Erklärungen ohne Öffnen der Black Box: Automatisierte Entscheidungen und die DSGVO . Sandra Wachter et al. Harvard Journal of Law & Technology, 2017. [Papier]

- Skalierbare Agentenausrichtung über Belohnungsmodellierung: eine Forschungsrichtung . Jan Leike et al. Arxiv 2018. [Papier]

- Ethik in künstliche Intelligenz aufbauen . Han Yu et al. IJCAI 2018. Papier

- Menschenkompatibel: Künstliche Intelligenz und das Problem der Kontrolle . Stuart Russell . Viking, 2019. [Papier]

- Verantwortungsbewusste künstliche Intelligenz: Wie man KI auf verantwortungsvolle Weise entwickelt und nutzt . Virginia Dignum . Springer Nature, 2019. [Papier]

- Maschinenethik: Das Design und die Regierungsführung ethischer KI und autonomer Systeme . Alan F. Winfield et al. Proceedings of the IEEE, 2019. [Papier]

- Offene Probleme in der kooperativen KI . Allan Dafoe et al. ARXIV 2020. [Papier]

- Künstliche Intelligenz, Werte und Ausrichtung . Iason Gabriel . Köpfe und Maschinen, 2020. [Papier]

- Kooperative KI: Maschinen müssen lernen, Gemeinsamkeiten zu finden . Allan Dafoe et al. Natur 2021. [Papier]

- Maschinenmoral, moralischer Fortschritt und die drohende Umweltkatastrophe . Ben Kenward et al. ARXIV 2021. [Papier]

- X-Risiko-Analyse für KI-Forschung . Dan Hendrycks et al. ARXIV 2022. [Papier]

- Aufgabenabzug für skalierbare Aufsicht (Agisf -Destillation) . Charbel-Raphaël Segerie. Blog 2023. [Blog]

- Verallgemeinerung mit schwacher bis starker Verallgemeinerung: Erleichterung starker Fähigkeiten mit schwacher Überwachung . Collin Burns et al. ARXIV 2023. [Papier]

- Wessen Meinungen reflektieren Sprachmodelle? . Shibani Santurkar et al. ICML 2023. [Papier]

- AI -Ausrichtung: Eine umfassende Umfrage . Jiaming Ji et al. ARXIV 2023. [Papier]

- Offene Probleme und grundlegende Einschränkungen des Verstärkungslernens durch menschliches Feedback . Stephen Casper et al. ARXIV 2023. [Papier]

- Die Entsperrung auf Basis-LLMs: Überdenken der Ausrichtung über das Lernen in Kontext . Bill Yuchen Lin et al. ARXIV 2023. [Papier]

- Ausrichtung des großen Sprachmodells: Eine Umfrage . Tianhao Shen et al. ARXIV 2023. [Papier]

6. AGI Roadmap: Verantwortungsbewusst nähern sich AGI

6.1 AI -Ebenen: Darstellung der Entwicklung künstlicher Intelligenz

- Funken der künstlichen allgemeinen Intelligenz: frühe Experimente mit GPT-4 . Sébastien Bubeck et al. ARXIV 2023. [Papier]

- AGI -Ebenen: Operationalisierung von Fortschritten auf dem Weg zu Agi . Meredith Ringel Morris et al. ARXIV 2024. [Papier]

6.2 AGI -Bewertung

6.2.1 Erwartungen an die AGI -Bewertung

- Auf der systematischen Berichterstattung über die Energie- und CO2 -Fußabdrücke des maschinellen Lernens . Peter Henderson et al. Journal of Machine Learning Research, 2020.

- Grüne Ai . Roy Schwartz Kommunikation der ACM, 2020.

- Bewertung von großsprachigen Modellen, die auf Code geschult wurden . Mark Chen et al. Kein Tagebuch, 2021.

- Dokumentation großer WebText Corpora: Eine Fallstudie zum kolossalen Clean Cracled Corpus . Jesse Dodge et al. ARXIV 2021. [Papier]

- Über die Chancen und Risiken von Fundamentmodellen . Rishi Bommasani et al. ARXIV 2021. [Papier]

- Menschenähnliche systematische Verallgemeinerung durch ein meta-lernendes neuronales Netzwerk . Brenden M Lake et al. Nature, 2023. [Papier]

- Superbench misst LLMs im Freien: Eine kritische Analyse . Superbench -Team. Arxiv 2023.

- Ganzheitliche Bewertung von Sprachmodellen . Percy Liang et al. ARXIV 2023. [Papier]

6.2.2 Aktuelle Bewertungen und ihre Einschränkungen

- Kader: Über 100.000 Fragen zum Maschinenverständnis des Textes . Pranav Rajpurkar et al. Arxiv 2016. [Papier]

- TRIVIAQA: Ein weitgehend beaufsichtigter Herausforderungsdatensatz für das Leseverständnis . Mandar Joshi et al. Arxiv 2017. [Papier]

- CoQA: Eine Konversationsfragestellungsherausforderung . Siva Reddy et al. Transaktionen des Association for Computational Linguistics, 2019.

- Genaue, zuverlässige und schnelle Robustheit Bewertung . Wieland Brendel et al. Neurips 2019. [Papier]

- Messung des massiven Verständnisses von Multitasking -Sprachen . Dan Hendrycks et al. ARXIV 2020. [Papier]

- Bewertung der Modell Robustheit und Stabilität für Datensatzverschiebung . Adarsh Subbaswamy et al. Präsentiert auf der Internationalen Konferenz über künstliche Intelligenz und Statistik, 2021. Papier

- MMDIALOG: Ein groß angelegter Multiturn-Dialog-Datensatz zur Konversation mit multimodalem Open-Domain-Konversation . Jiazhan Feng et al. ARXIV 2022. [Papier]

- Selbstversorgungsstruktur: Sprachmodelle mit selbst erzeugten Anweisungen ausrichten . Yizhong Wang et al. ARXIV 2022. [Papier]

- Super-naturalinstructions: Verallgemeinerung durch deklarative Anweisungen zu über 1600 NLP-Aufgaben . Yizhong Wang et al. ARXIV 2022. [Papier]

- Ganzheitliche Analyse der Halluzination in GPT-4V (Ision): Vorspannungen und Interferenzprobleme . Chenhang Cui et al. ARXIV 2023. [Papier]

- Bewertung der Robustheit für Anweisungen von Großsprachenmodellen . Yuansheng Ni et al. ARXIV 2023. [Papier]

- Gaia: Ein Maßstab für allgemeine AI -Assistenten . Grégoire Mialon et al. ARXIV 2023. [Papier]

- Ein umfassender Bewertungsrahmen für tiefe Modell Robustheit . Jun Guo et al. Mustererkennung, 2023. [Papier]

- Agieval: Ein menschlich-zentrierter Benchmark für die Bewertung von Fundamentmodellen . Wanjun Zhong et al. ARXIV 2023. [Papier]

- MMMU: Ein massives multimodales Verständnis für multimodales Verständnis und ein Argumentieren für Experten AGI . Xiang et al. ARXIV 2023. [Papier]

- Bewertung der Kreativität des Großsprachenmodells aus literarischer Sicht . Murray Shanahan et al. ARXIV 2023. [Papier]

- Agentbench: Bewertung von LLM . Xiao Liu et al. ICLR 2024. [Papier]

- Bewertung und Verständnis der Kreativität in großen Sprachmodellen . Yunpu Zhao et al. ARXIV 2024. [Papier]

- Beurteilung von LLM-as-a-Judge mit MT-Bench und Chatbot Arena . Lianmin Zheng et al. Neurips 2024. [Papier]

6.5 Weitere Überlegungen während der AGI -Entwicklung

- Grundlegende Herausforderungen bei der Sicherstellung von Ausrichtung und Sicherheit von Modellen in Großsprachen . Usman Anwar et al. ARXIV 2024. [Papier]

- Best Practices und Lektionen, die in synthetischen Daten für Sprachmodelle gelernt werden . Ruibo liu et al. ARXIV 2024. [Papier]

- Förderung der sozialen Intelligenz in KI -Agenten: Technische Herausforderungen und offene Fragen . Leena Mathur et al. ARXIV 2024. [Papier]

7. Fallstudien

7.1 KI für die Entdeckung und Forschung der Wissenschaft

- Hoch genaue Proteinstrukturvorhersage mit Alphafold . Jumper, John et al. Nature, 2021. [Papier]

- Automatisierte wissenschaftliche Entdeckung: Von der Gleichung Entdeckung zu autonomen Entdeckungssystemen . Kramer, Stefan et al. ARXIV 2023. [Papier]

- Vorhersage von Effekten von nichtkodierenden Varianten mit einem tief lernbasierten Sequenzmodell . Zhou, Jian et al. Nature Methods, 2015. [[Papier] (https://www.ncbi.nlm.nih.gov/pmc/articles/pmc4768299/]

- Lernen, Physik durch visuelle De-Animation zu sehen . Wu, Jiajun et al. Neurips 2017. [Papier]

- Deep Learning für Echtzeit-Gravitationswellenerkennung und Parameterschätzung: Ergebnisse mit erweiterten LIGO-Daten . George, Daniel et al. Physikbriefe B, 2018. [Papier]

- Identifizierung von Quantenphasenübergängen mit kontroversen neuronalen Netzwerken . Rem, Bart-Jan et al. Nature Physics, 2019. [Papier]

- OpenAgi: Wenn LLM Domain -Experten trifft . Ge, Yingqiang et al. Neurips, 2023. [Papier]

- Von dunkler Materie bis hin zu Galaxien mit Faltungsnetzwerken . Zhang, Xinyue et al. Arxiv 2019. [Papier]

- Globale Optimierung der Quantendynamik mit Alphazero Deep Exploration . Dalgaard, Mogens et al. NPJ Quanteninformation, 2020. [Papier]

- Lernen, die zeitliche Struktur für die biomedizinische Sehverarbeitung zu nutzen . Shruthi Bannur et al. CVPR, 2023. [Papier]

- Mathbert: Ein vorgebildetes Sprachmodell für allgemeine NLP-Aufgaben in der Mathematikbildung . Shen, Jia Tracy et al. ARXIV 2021. [Papier]

- Molekulare Optimierung unter Verwendung von Sprachmodellen . Maziaren, Krzysztof et al. ARXIV 2022. [Papier]

- Retrotrae: Retrosynthetische Übersetzung von atomaren Umgebungen mit Transformator . Ucak, Umit Volkan et al. Kein Tagebuch, 2022. [Papier]

- Scholarbert: Größer ist nicht immer besser . Hong, Zhi et al. ARXIV 2022. [Papier]

- Galactica: Ein großes Sprachmodell für die Wissenschaft . Taylor, Ross et al. ARXIV 2022. [Papier]

- Formale Mathematik -Aussage -Lehrplanlernen . Polu, Stanislas et al. ARXIV 2022. [Papier]

- Proof Artefact Co-Training für Theorem, das mit Sprachmodellen beweist . Jesse Michael Han et al. ICLR 2022. [Papier]

- Lösen quantitativer Argumentationsprobleme mit Sprachmodellen . Lewkowycz, Aitor et al. ARXIV 2022. [Papier]

- BIOGPT: Generativ voreingebildeter Transformator für biomedizinische Textgenerierung und -abbau . Luo, Renqian et al. Briefings in Bioinformatik, 2022.

- CHEMCROW: Erweiterung von großsprachigen Modellen mit Chemiewerkzeugen . Bran, Andres M et al. ARXIV 2023. [Papier]

- Autonome chemische Forschung mit großen Sprachmodellen . Boiko, Daniil A et al. Nature, 2023. [Papier]

- Emergente autonome wissenschaftliche Forschungsfähigkeiten großer Sprachmodelle . Daniil A. Boiko et al. ARXIV 2023. [Papier]

- Mathprompter: Mathematische Argumentation unter Verwendung von großsprachigen Modellen . Imani, Shima et al. Präsentiert auf Proceedings der 61. Jahrestagung des Vereins für Computer -Linguistik (Band 5: Branchenspur), 2023. [Papier]

- Lernen, die zeitliche Struktur für die biomedizinische Sehverarbeitung zu nutzen . Shruthi Bannur et al. ARXIV 2023. [Papier]

- LLMs für die Wissenschaft: Verwendung für Codegenerierung und Datenanalyse . Nejjar, Mohamed et al. ARXIV 2023. [Papier]

- MEDAGENTEN: Großsprachige Modelle als Mitarbeiter für medizinisches Argumentieren von Zero-Shot . Xiangru Tang et al. ARXIV 2024. [Papier]

7.2 Generative visuelle Intelligenz

- Tiefes unbeaufsichtigtes Lernen mit Nichtgleichgewichtsthermodynamik . Jascha Sohl-Dickstein et al. ICML 2015. [Papier]

- Generative Modellierung durch Schätzung von Gradienten der Datenverteilung . Yang Song et al. Neurips 2019. [Papier]

- Denoising diffusion probabilistische Modelle . Jonathan Ho et al. Neurips 2020. [Papier]

- Score-basierte generative Modellierung durch stochastische Differentialgleichungen . Yang Song et al. ICLR 2021. [Papier]

- Gleit: Auf dem Weg zu fotorealistischer Bildgenerierung und -bearbeitung mit textgesteuerten Diffusionsmodellen . Alex Nichol et al. ICML 2022. [Papier]

- SDEDIT: Geführte Bildsynthese und Bearbeitung mit stochastischen Differentialgleichungen . Chenlin Meng et al. ICLR 2022. [Papier]

- Videodiffusionsmodelle . Jonathan Ho et al. Neurips 2022. [Papier]

- Hierarchische Text-Konditionelle Bildgenerierung mit Clip Latchs . Aditya Ramesh et al. ARXIV 2022. [Papier]

- Klassifikatorfreie Diffusionsführung . Jonathan Ho et al. ARXIV 2022. [Papier]

- Palette: Image-zu-Image-Diffusionsmodelle . Chitwan Saharia et al. Siggraph 2022. [Papier]

- Hochauflösende Bildsynthese mit latenten Diffusionsmodellen . Robin Rombach et al. CVPR 2022. [Papier]

- Hinzufügen einer bedingten Steuerung zu Text-zu-Image-Diffusionsmodellen . Lvmin Zhang et al. ICCV 2023. [Papier]

- Skalierbare Diffusionsmodelle mit Transformatoren . William Peebles et al. ICCV 2023. [Papier]

- Die sequentielle Modellierung ermöglicht skalierbares Lernen für große Sehmodelle . Yutong Bai et al. ARXIV 2023. [Papier]

- Videogenerierungsmodelle als Weltsimulatoren . Tim Brooks et al. OpenAI 2024. [Papier]

7.3 Weltmodelle

- Lernen, Physik durch visuelle De-Animation zu sehen . Wu, Jiajun et al. Neurips 2017. [Papier]

- Sicheres modellbasiertes Verstärkungslernen mit Stabilitätsgarantien . Berkenkamp, Felix et al. Neurips, 2017. [Papier]

- SIMNET: Lernsimulationsbasierte Weltmodelle für physikalisches Denken . Vicol, Paul, Menapace et al. ICLR 2022. [Papier]

- Dreamix: Dreamfusion über iterative raumzeitliche Mischung . Khalifa, Anji et al. ARXIV 2022. [Papier]

- Allzweck verkörperte KI-Agent durch Verstärkungslernen mit Wissen im Internet . Guo, Xiaoxiao et al. ARXIV 2022. [Papier]

- Vqgan-Clip: Offene Domänenbildgenerierung und Bearbeitung mit natürlicher Sprachanleitung . Crowson, Katherine. ARXIV 2022. [Papier]

- Ein Weg in Richtung autonomer maschineller Intelligenz . Lecun Yann OpenReview, 2022. [Papier]

- Sprachmodelle treffen Weltmodelle: Verbundene Erfahrungen verbessern Sprachmodelle . Jiannan Xiang et al. Neurips 2023. [Papier]

- Mastering verschiedener Domänen durch Weltmodelle . Hafner, Danijar et al. ARXIV 2023. [Papier]

- Erfassung multimodaler Modelle durch Abrufen . Reed, Scott et al. ARXIV 2023. [Papier]

- Sprachmodelle als Null-Shot-Planer: Extrahieren umsetzbarer Wissen für verkörperte Wirkstoffe . Dohan, David et al. ARXIV 2023. [Papier]

- Sprachmodelle, Agentenmodelle und Weltmodelle: Das Gesetz für Maschinenbekämpfung und -planung . Zhiting Hu et al. ARXIV 2023. [Papier]

- Das Denken mit Sprachmodell ist die Planung mit dem Weltmodell . Hao, Shibo et al. ARXIV 2023. [Papier]

- Metasim: Lernen, synthetische Datensätze zu generieren . Zhang, Yuxuan et al. ARXIV 2023. [Papier]

- Weltmodell für Video und Sprache mit Millionen Länge mit Ringeltentwicklung . Hao Liu et al. ARXIV 2024. [Papier]

- Genie: Generative interaktive Umgebungen . Jake Bruce et al. ARXIV 2024. [Papier]

7.4 dezentrales LLM

- Blütenblätter: kollaborative Inferenz und Feinabstimmung großer Modelle . Alexander Borzunov et al. ARXIV 2022. [Papier]

- Blockchain für Deep Learning: Überprüfung und offene Herausforderungen . Die wirtschaftlichen Zeiten. Cluster Computing 2021. [Papier]

- FlexGen: Hochdurchsatz generative Inferenz von großsprachigen Modellen mit einer einzelnen GPU . Ying Sheng et al. ARXIV 2023. [Papier]

- Dezentrales Training von Grundlagenmodellen in heterogenen Umgebungen . Binhang Yuan et al. ARXIV 2023. [Papier]

7.5 AI für die Codierung

- Ein Rahmen für die Bewertung von Codegenerierungsmodellen . Ben Allal et al. Github, 2023. [Code]

- Bewertung von großsprachigen Modellen, die auf Code geschult wurden . Mark Chen et al. ARXIV 2021. [Papier]

- Programmsynthese mit großen Sprachmodellen . Jacob Austin et al. ARXIV 2021. [Papier]

- Codegenerierung auf Wettbewerbsebene mit Alphacode . Yujia Li et al. Wissenschaft, 2022. [Papier]

- Effizientes Training von Sprachmodellen zum Ausfüllen der Mitte . Mohammad Bayarian et al. ARXIV 2022. [Papier]

- Santacoder: Greifen Sie nicht nach den Sternen! . Loubna Ben Allal et al. Geist, 2023. [Papier]

- STARCODER: Möge die Quelle mit Ihnen sein! . Raymond Li et al. ARXIV 2023. [Papier]

- Großsprachige Modelle für die Compiler -Optimierung . Chris Cummins et al. ARXIV 2023. [Papier]

- Lehrbücher sind alles, was Sie brauchen . Suriya Gunasekar et al. ARXIV 2023. [Papier]

- Intercode: Standardisieren und Benchmarking interaktiver Codierung mit Ausführungsfeedback . John Yang et al. ARXIV 2023. [Papier]

- Verstärkungslernen aus automatischem Feedback für die Erzeugung von Test-Test-Test-Tests . Benjamin Steenhoek et al. ARXIV 2023. [Papier]

- Incoder: Ein generatives Modell für Code -Infischen und -synthese . Daniel Fried et al. ARXIV 2023. [Papier]

- Verfeinerung zerlegter C -Code mit großen Sprachmodellen . Wai Kin Wong et al. ARXIV 2023. [Papier]

- SWE-Bench: Können Sprachmodelle die reale Welt lösen?