Webseite: https://serl-robot.github.io/

SERL bietet eine Reihe von Bibliotheken, Env-Wrappern und Beispielen zum Trainieren von RL-Richtlinien für Robotermanipulationsaufgaben. In den folgenden Abschnitten wird die Verwendung von SERL beschrieben. Wir veranschaulichen die Verwendung anhand von Beispielen.

?: SERL-Video, zusätzliches Video zu beispieleffizientem RL.

Inhaltsverzeichnis

SERL: Eine Software-Suite für probeneffizientes Robotic Reinforcement Learning

Installation

Übersicht und Codestruktur

Schnellstart mit SERL in Sim

Laufen Sie mit Franka Arm auf Real Robot

Beitrag

Zitat

Für Personen, die SERL für Aufgaben verwenden, bei denen es um die Steuerung des Greifers geht (z. B. das Aufheben von Objekten), empfehlen wir dringend, einen kleinen Abzug bei der Änderung der Greiferaktion vorzunehmen, da dadurch die Trainingsgeschwindigkeit erheblich verbessert wird. Einzelheiten finden Sie unter: PR #65.

Darüber hinaus empfehlen wir, zusätzlich zum Laden der Offline-Demos auch Interventionen während des Trainings online anzubieten. Wenn Sie einen Franka-Roboter und eine SpaceMouse haben, kann dies so einfach sein wie das bloße Berühren der SpaceMouse während des Trainings.

Wir haben ein großes Problem im Rahmen der Interventionsmaßnahmen behoben. Siehe Version v0.1.1. Bitte aktualisieren Sie Ihren Code mit dem Hauptzweig.

Conda-Umgebung einrichten: Erstellen Sie eine Umgebung mit

conda create -n serl python=3.10

Installieren Sie Jax wie folgt:

Für CPU (nicht empfohlen):

pip install --upgrade „jax[cpu]“

Für GPU:

pip install --upgrade "jax[cuda12]==0.4.28" -f https://storage.googleapis.com/jax-releases/jax_cuda_releases.html

Für TPU

pip install --upgrade "jax[tpu]" -f https://storage.googleapis.com/jax-releases/libtpu_releases.html

Weitere Informationen zur Installation von Jax finden Sie auf der Jax-Github-Seite.

Installieren Sie den serl_launcher

cd serl_launcher pip install -e .pip install -r Anforderungen.txt

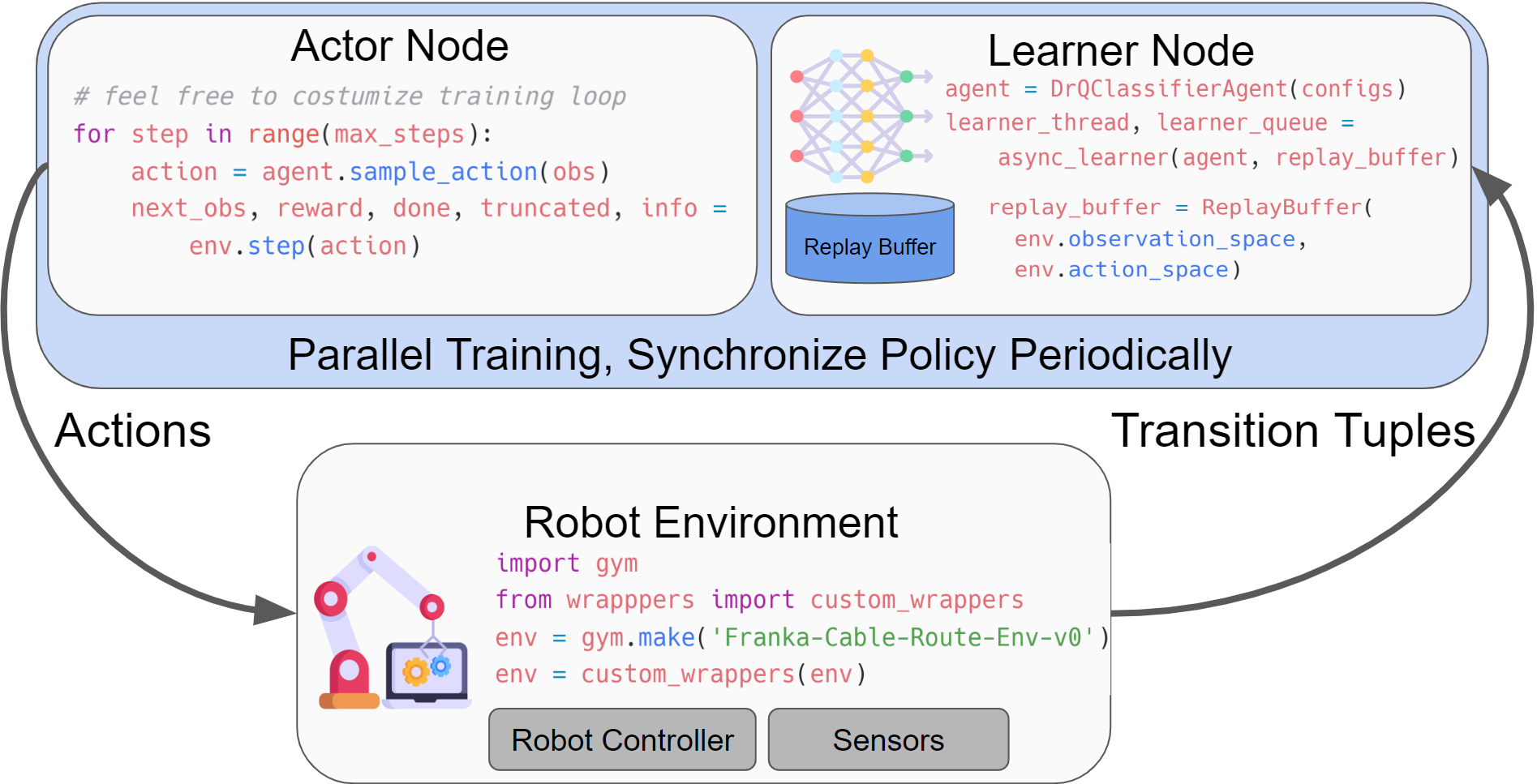

SERL bietet Benutzern eine Reihe allgemeiner Bibliotheken zum Trainieren von RL-Richtlinien für Robotermanipulationsaufgaben. Die Hauptstruktur der Durchführung der RL-Experimente umfasst einen Akteurknoten und einen Lernknoten, die beide mit der Roboter-Fitnessumgebung interagieren. Beide Knoten laufen asynchron, wobei Daten mithilfe von Agentlace über das Netzwerk vom Akteur an den Lernknoten gesendet werden. Der Lernende synchronisiert die Richtlinie regelmäßig mit dem Akteur. Dieses Design bietet Flexibilität für paralleles Training und Inferenz.

Tabelle zur Codestruktur

| Codeverzeichnis | Beschreibung |

|---|---|

| serl_launcher | Hauptcode für SERL |

| serl_launcher.agents | Agentenrichtlinien (z. B. DRQ, SAC, BC) |

| serl_launcher.wrappers | Verpackungen für Fitnessstudios |

| serl_launcher.data | Wiedergabepuffer und Datenspeicher |

| serl_launcher.vision | Visionbezogene Modelle und Hilfsmittel |

| franka_sim | Franka Mujoco Simulations-Fitnessstudio-Umgebung |

| serl_robot_infra | Roboter-Infrastruktur zum Laufen mit echten Robotern |

| serl_robot_infra.robot_servers | Flask-Server zum Senden von Befehlen an den Roboter über ROS |

| serl_robot_infra.franka_env | Fitnessstudio-Umgebung für echten Franka-Roboter |

Wir bieten eine simulierte Umgebung zum Ausprobieren von SERL mit einem Franka-Roboter.

Schauen Sie sich den Quick Start mit SERL in Sim an

Ausbildung anhand staatlicher Beobachtungsbeispiele

Schulung anhand eines Bildbeobachtungsbeispiels

Training aus der Bildbeobachtung mit 20 Beispiel-Demo-Trajektorien

Wir bieten eine Schritt-für-Schritt-Anleitung zum Ausführen von RL-Richtlinien mit SERL auf dem echten Franka-Roboter.

Schauen Sie sich den Lauf mit Franka Arm auf Real Robot an

Einsetzen von Zapfen?

Einfügen von PCB-Komponenten

Kabelführung?

Objektverlagerung ?️

Wir freuen uns über Beiträge zu diesem Repository! Forken Sie und reichen Sie eine PR ein, wenn Sie Verbesserungen an der Codebasis haben. Bevor Sie eine PR einreichen, führen Sie bitte pre-commit run --all-files aus, um sicherzustellen, dass die Codebasis korrekt formatiert ist.

Wenn Sie diesen Code für Ihre Recherche verwenden, zitieren Sie bitte unseren Artikel:

@misc{luo2024serl, title={SERL: A Software Suite for Sample-Efficient Robotic Reinforcement Learning}, Autor={Jianlan Luo und Zheyuan Hu und Charles Xu und You Liang Tan und Jacob Berg und Archit Sharma und Stefan Schaal und Chelsea Finn und Abhishek Gupta und Sergey Levine}, Jahr={2024}, eprint={2401.16013}, archivePrefix={arXiv}, PrimaryClass={cs.RO}}