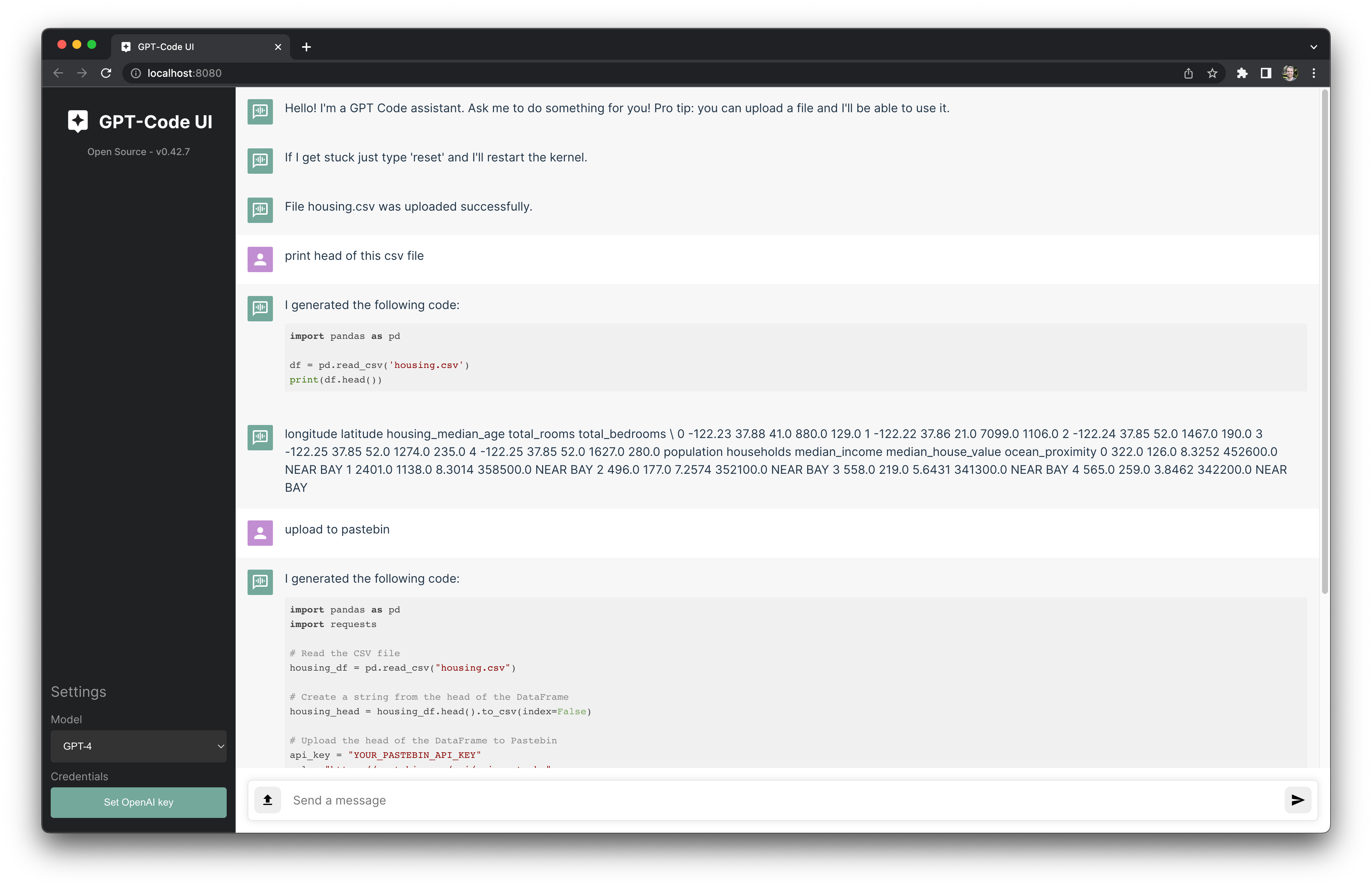

Eine Open-Source-Implementierung des ChatGPT-Code-Interpreters von OpenAI.

Bitten Sie das OpenAI-Modell einfach, etwas zu tun, und es generiert und führt den Code für Sie aus.

Lesen Sie den Blogbeitrag, um mehr zu erfahren.

Judah Cooper bot an, eine Discord-Community zu gründen und zu kuratieren. Treten Sie hier bei.

Öffnen Sie ein Terminal und führen Sie Folgendes aus:

pip install gpt-code-ui

gptcode

Um grundlegende Abhängigkeiten verfügbar zu machen, wird empfohlen, die folgende pip Installation in der Python-Umgebung auszuführen, die in der Shell verwendet wird, in der Sie gptcode ausführen:

pip install " numpy>=1.24,<1.25 " " dateparser>=1.1,<1.2 " " pandas>=1.5,<1.6 " " geopandas>=0.13,<0.14 " " tabulate>=0.9.0<1.0 " " PyPDF2>=3.0,<3.1 " " pdfminer>=20191125,<20191200 " " pdfplumber>=0.9,<0.10 " " matplotlib>=3.7,<3.8 "

Sie können eine .env-Datei im Arbeitsverzeichnis ablegen, um die Umgebungsvariable OPENAI_API_KEY zu laden.

Legen Sie die Variablen API_PORT , WEB_PORT und SNAKEMQ_PORT fest, um die Standardwerte zu überschreiben.

Legen Sie OPENAI_BASE_URL fest, um den verwendeten OpenAI-API-Endpunkt zu ändern (beachten Sie, dass diese Umgebungsvariable das Protokoll https://... enthält).

Sie können .env.example im Repository verwenden (stellen Sie sicher, dass Sie zuerst das Repo git clone um die Datei abzurufen).

Für Azure OpenAI Services gibt es auch andere konfigurierbare Variablen wie den Bereitstellungsnamen. Weitere Informationen finden Sie unter .env.azure-example . Beachten Sie, dass die Modellauswahl auf der Benutzeroberfläche derzeit für Azure OpenAI Services nicht unterstützt wird.

cp .env.example .env

vim .env

gptcode

localagi hat sich die Mühe gemacht, das Python-Paket in einem Docker-Container zu bündeln. Schauen Sie es sich hier an: gpt-code-ui-docker.

Bitte tun Sie es und schauen Sie sich den Beitragsleitfaden an! Dies sollte eine Gemeinschaftsinitiative sein. Ich werde mein Bestes geben, um zu reagieren.

Vielen Dank für Ihr Interesse an diesem Projekt!