Eternal ist eine experimentelle Plattform für maschinelle Lernworkflows.

HINWEIS: Diese App ist in Arbeit und nicht stabil. Bitte betrachten Sie dieses Repo als Referenz. Wir freuen uns über Mitwirkende und konstruktives Feedback. Gerne können Sie es auch als Referenz für Ihre eigenen Projekte verwenden.

Eternal integriert verschiedene Projekte wie llama.cpp , ComfyUI und codapi sowie viele andere Projekte, deren Entwickler so freundlich waren, sie mit der Welt zu teilen. Der gesamte Kredit gehört den jeweiligen Mitwirkenden aller Abhängigkeiten, auf die sich dieses Repo stützt. Vielen Dank, dass Sie Ihre Projekte mit der Welt teilen.

Das Eternal-Frontend wird mit dem legendären HTMX -Framework gerendert.

WICHTIG:

Konfigurieren Sie die Quantitätsebene der Modelle in Ihrer config.yml entsprechend Ihren Systemspezifikationen. Wenn ein lokales Modell nicht ausgeführt werden kann, untersuchen Sie die Ursache, indem Sie die generierte Datei main.log anzeigen. Der häufigste Grund ist unzureichender RAM oder eine falsche Eingabeaufforderungsvorlage. Wir werden in einem zukünftigen Commit eine robustere Fehlerbehandlung und Protokollierung implementieren.

.config.yml Die grundlegende Dokumentation finden Sie im Ordner docs in diesem Repository.

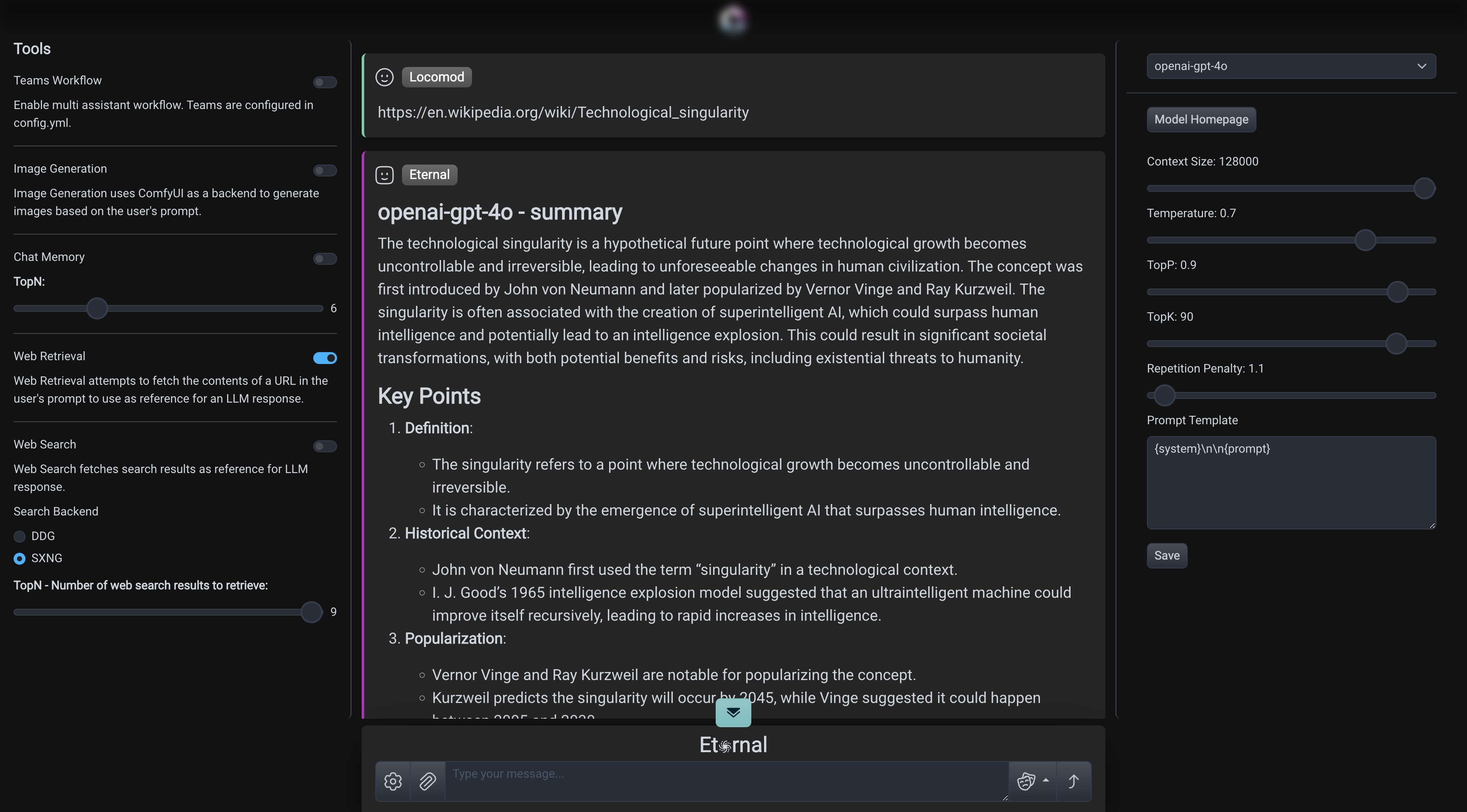

webget : Versucht, eine als Teil der Eingabeaufforderung übergebene URL abzurufen.websearch : Durchsucht das öffentliche Web nach Seiten, die sich auf Ihre Eingabeaufforderung beziehen.Erfordert die Installation des Chrome-Browsers.

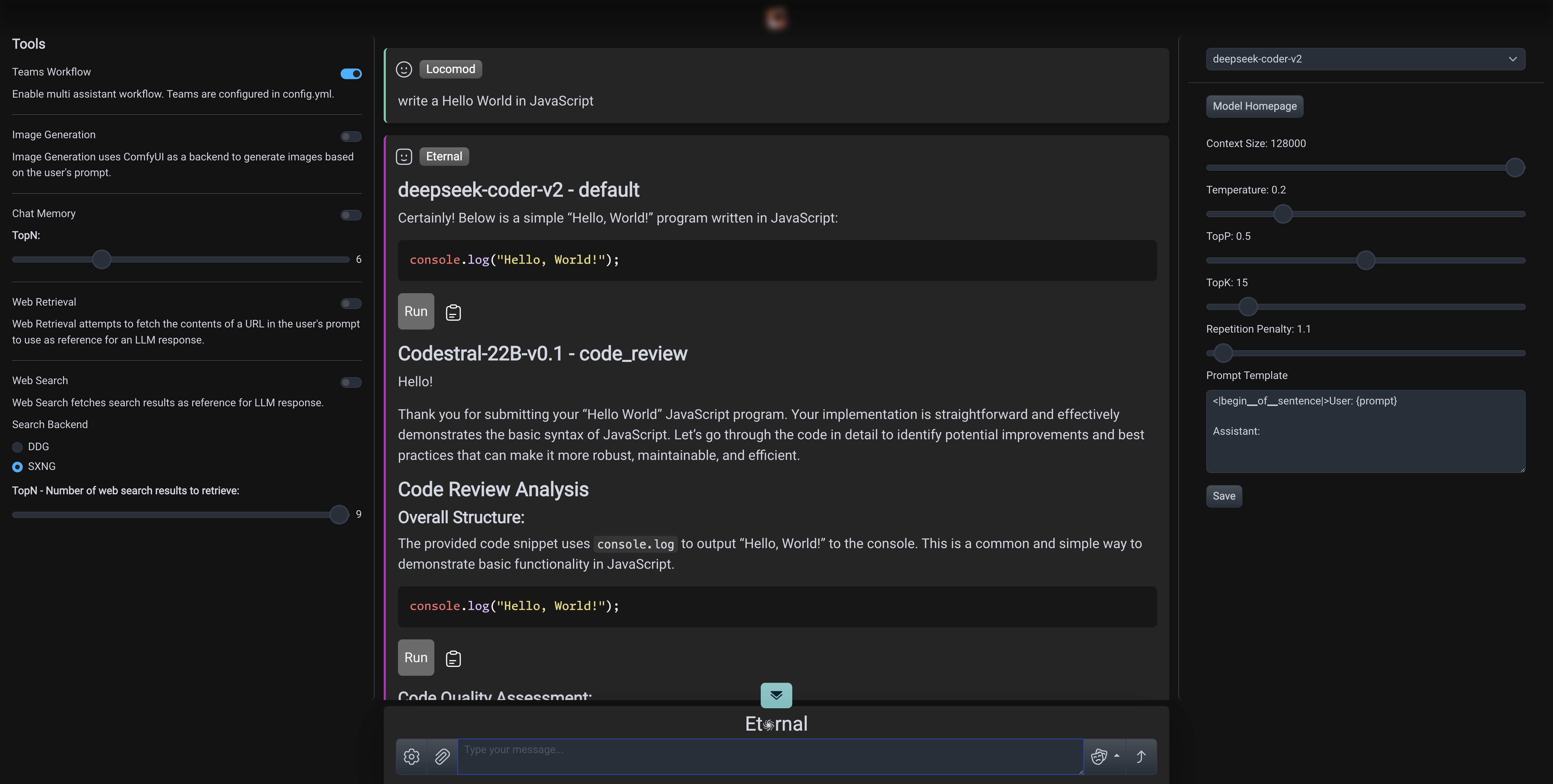

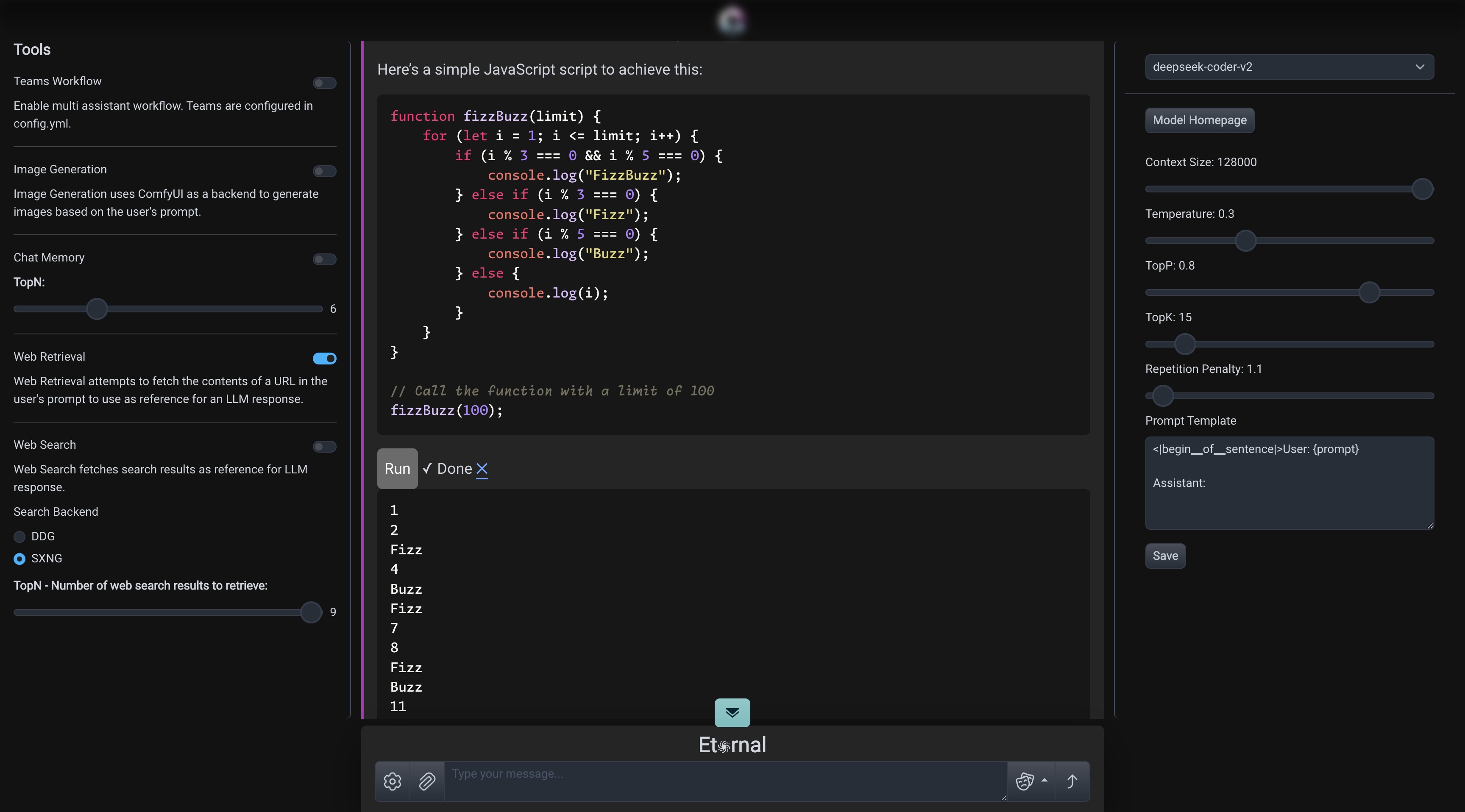

Führen Sie LLM-generierten Code in der Chat-Ansicht in einer sicheren Sandbox aus und bearbeiten Sie ihn. Derzeit wird JavaScript über WASM implementiert. Weitere Sprachen folgen bald!

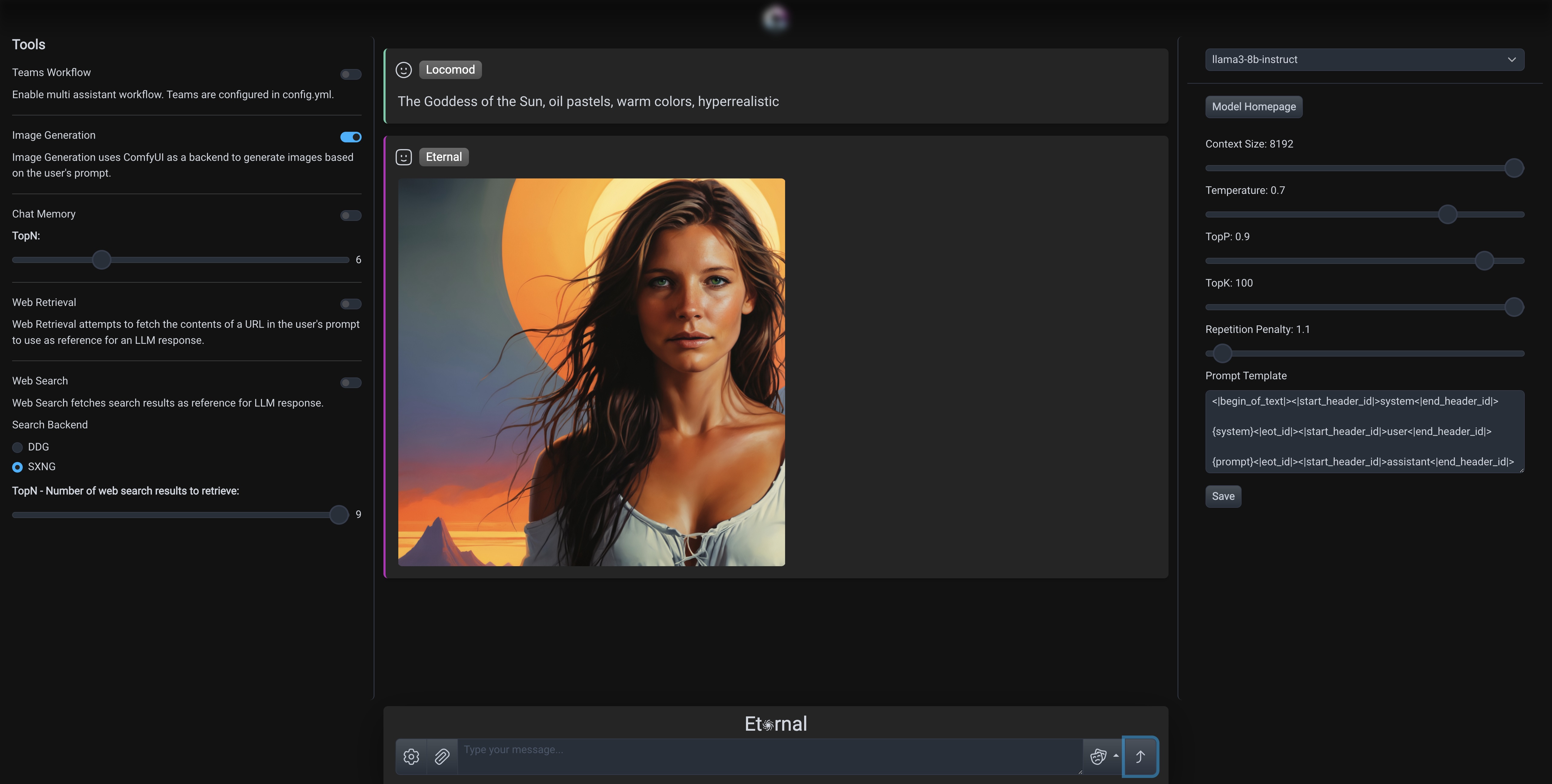

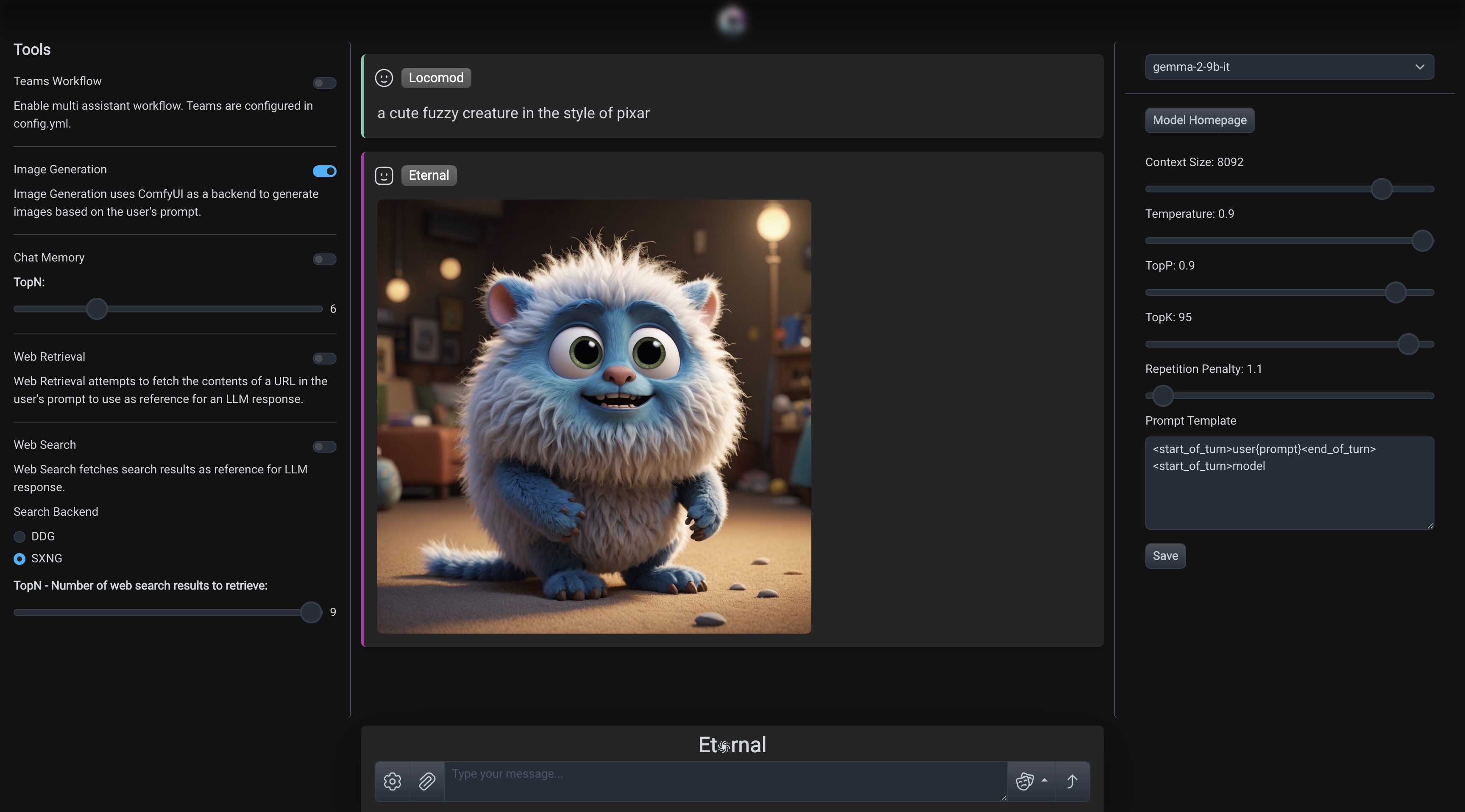

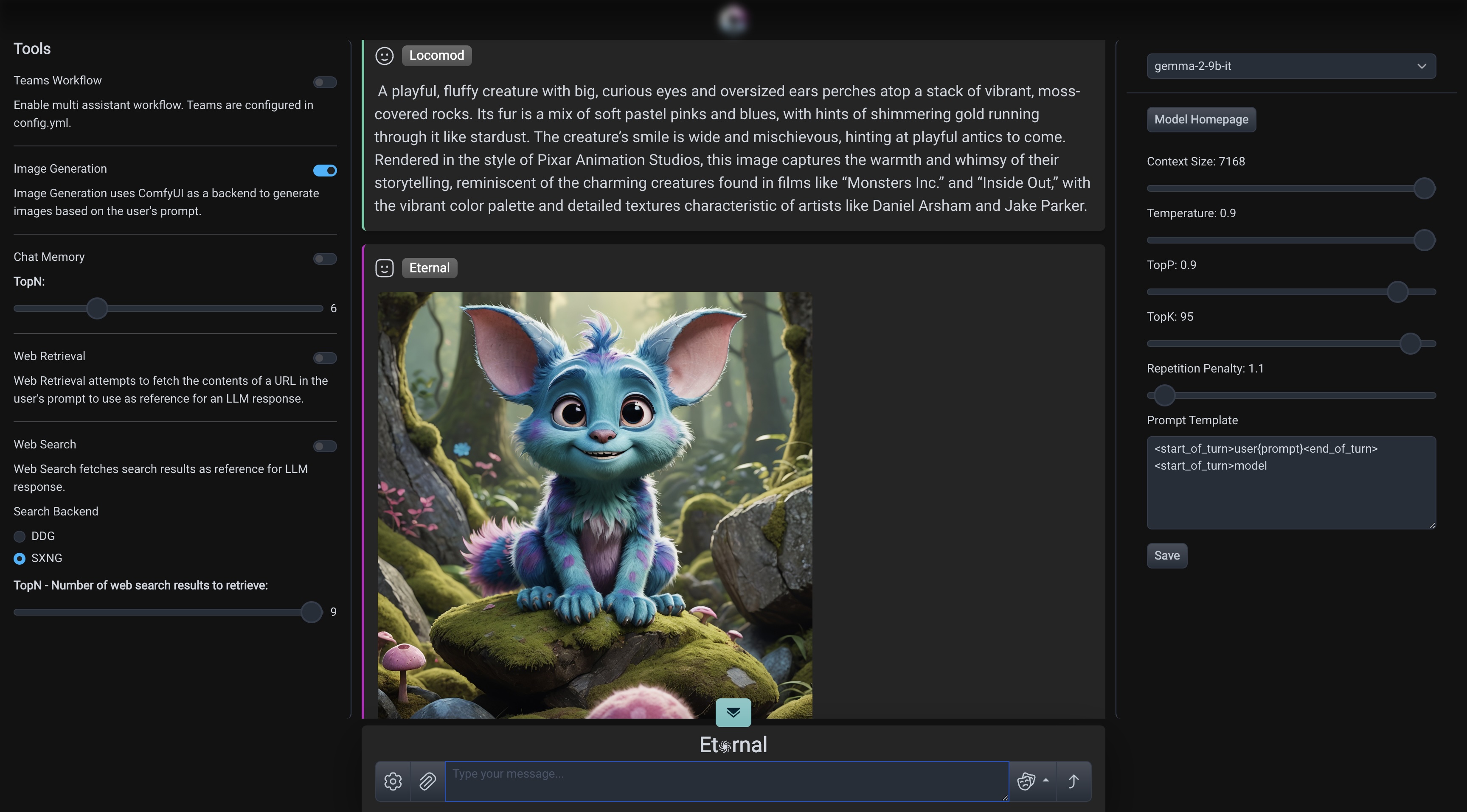

Eternal kann Bilder mithilfe leistungsstarker benutzerdefinierter ComfyUI-Workflows generieren, die automatisch verwaltet und für eine qualitativ hochwertige Ausgabe optimiert werden. Sie müssen nicht mehr Hunderte von Parametern anpassen. Beschreiben und generieren. Legen Sie die Rolle auf image_bot fest und wählen Sie einen beliebigen lokalen oder öffentlichen LLM aus, um Ihre Eingabeaufforderungen zu verbessern.

Benennen Sie die bereitgestellte .config.yml Datei in config.yml um und platzieren Sie sie im selben Pfad wie die Anwendungsbinärdatei. Ändern Sie die Inhalte für Ihre Umgebung und Ihren Anwendungsfall.

Eternal unterstützt derzeit den Aufbau auf Linux oder Windows WSL mit CUDA (nVidia-GPU erforderlich) oder MacOS/Metal (Mac der M-Serie erforderlich).

So erstellen Sie die Anwendung:

$ git clone https://github.com/intelligencedev/eternal.git

$ cd eternal

$ git submodule update --init --recursive

$ make all

Bitte reichen Sie ein Problem ein, wenn beim Erstellungsprozess Probleme auftreten.

Es wird empfohlen, vor dem ersten Anwendungsstart eine neue Python 3.10-Conda-Umgebung und eine neue virtuelle Umgebung zu erstellen. Dadurch werden Fehlermeldungen im Zusammenhang mit erforderlichen Paketinstallationen wie error: externally-managed-environment vermieden.

Wenn Eternal nicht gestartet werden kann, führen Sie die folgenden Befehle aus, um eine neue Conda-Umgebung und Python venv zu konfigurieren:

$ conda create -n eternal python=3.10

$ conda activate eternal

$ python python-m venv .

$ source bin/activate

# Apply execute permissions

$ sudo chmod +x ./eternal

# Run the Eternal binary

$ ./eternal

HINWEIS: Denken Sie daran, die enthaltene .config.yml in config.yml umzubenennen, die Einstellungen für Ihre Umgebung zu ändern und die Datei im selben Pfad wie die Eternal-Binärdatei zu speichern.

Diese README-Datei ist ein allgemeiner Überblick über die Eternal-Anwendung. Detaillierte Einrichtungsanweisungen und eine vollständige Liste der Funktionen, Abhängigkeiten und Konfigurationen finden Sie in der tatsächlichen Anwendungsdokumentation.