tinker chat

1.0.0

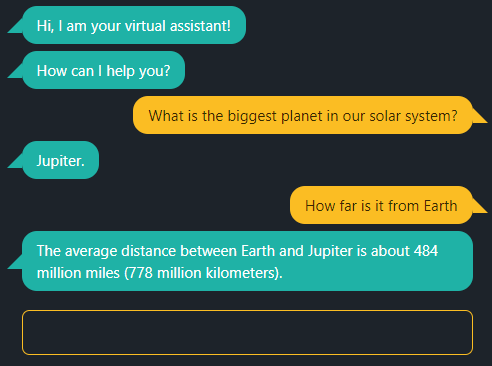

Diese Chat-App unterstützt GPT von OpenAI oder Ihr eigenes lokales LLM.

Um GPT von OpenAI zu verwenden, setzen Sie die Umgebungsvariable OPENAI_API_KEY auf Ihren API-Schlüssel.

Um llama.cpp lokal mit seiner Inferenz-Engine zu nutzen, laden Sie zunächst ein quantisiertes Modell wie Phi-3 Mini, z. B.:

/path/to/llama.cpp/server -m Phi-3-mini-4k-instruct-q4.gguf Legen Sie vor dem Starten der Demo die Umgebungsvariable OPENAI_API_BASE fest:

export OPENAI_API_BASE=http://127.0.0.1:8080Mit Node.js >= v18:

npm install

npm start

und öffnen Sie localhost:5000 mit einem Webbrowser.