Ein weiterer alternativer Gesichtsdetektor wurde hinzugefügt: https://github.com/1adrianb/face-alignment

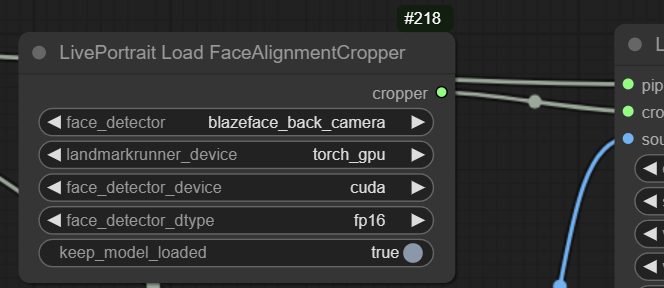

Da hier das Blazeface-Rückkameramodell (oder SFD) verwendet werden kann, ist es für kleinere Gesichter weitaus besser als MediaPipe, das nur das Blazeface-Kurzmodell verwenden kann. Das Aufwärmen beim ersten Lauf kann dabei lange dauern, die nachfolgenden Läufe gehen jedoch schnell vonstatten.

Beispielerkennung mit der blazeface_back_camera:

Die Überarbeitung fast aller Dinge, die sich in der Entwicklung befanden, ist jetzt in die Hauptarbeit integriert. Das bedeutet, dass alte Arbeitsabläufe nicht mehr funktionieren, aber alles sollte schneller sein und es gibt viele neue Funktionen. Aus Legacy-Zwecken wird der alte Hauptzweig in den Legacy-Zweig verschoben

Änderungen

MediaPipe wurde als Alternative zu Insightface hinzugefügt. Bei der Verwendung sollte nun alles unter MIT- und Apache-2.0-Lizenzen abgedeckt sein.

Richtiges Vid2vid inklusive Glättungsalgorithmus (danke @melMass)

Verbesserte Geschwindigkeit und Effizienz, ermöglicht eine nahezu Echtzeitansicht auch in Comfy (~80-100 ms Verzögerung)

Umstrukturierte Knoten für mehr Optionen

Automatisches Überspringen von Bildern, wenn kein Gesicht erkannt wird

Zahlreiche andere Dinge habe ich zu diesem Zeitpunkt vergessen, es war eine Menge

Bessere Mac-Unterstützung auf MPS (danke @Grant-CP

Update zu diesem Update:

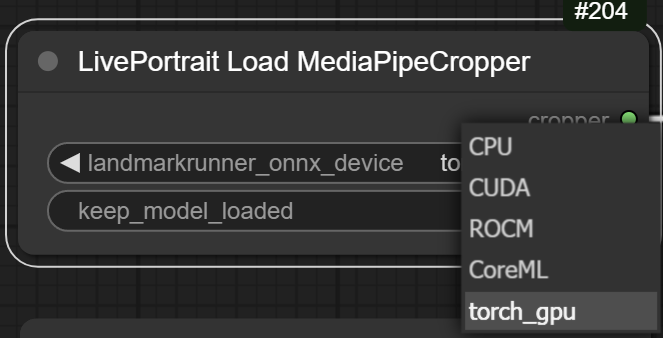

Ich habe das bahnbrechende Runner-ONNX-Modell in ein Torch-Modell konvertiert, was ich noch nie zuvor gemacht habe, und es ist mir nicht gelungen, etwas anderes zu tun, als daraus eine .pth-Datei zu erstellen, Sie müssen mir also einfach vertrauen. Dies ermöglicht die Ausführung all dessen ohne onnxruntime, es läuft auf der GPU und ist ungefähr genauso schnell. Es ist auf dem MediaPipe-Cropper-Knoten als Option verfügbar: Bei Auswahl wird es automatisch von hier heruntergeladen: https://huggingface.co/Kijai/LivePortrait_safetensors/blob/main/landmark_model.pth

Echtzeit mit Webcam-Feed:

Image2vid:

Vid2Vid:

Ich habe alle Pickle-Dateien in Safetensoren konvertiert: https://huggingface.co/Kijai/LivePortrait_safetensors/tree/main

Sie gehen hierher (und werden automatisch heruntergeladen, wenn der Ordner nicht vorhanden ist): ComfyUI/models/liveportrait

Sie können entweder das ursprüngliche Standard-Insightface oder Googles MediaPipe verwenden.

Der größte Unterschied besteht in der Lizenz: Insightface ist ausschließlich für die NICHT-KOMMERZIELLE Nutzung bestimmt. MediaPipe ist bei der Erkennung etwas schlechter und kann unter Windows nicht auf der GPU ausgeführt werden, obwohl es im Vergleich zu Insightface auf der CPU viel schneller ist

Insightface wird nicht automatisch installiert. Wenn Sie es verwenden möchten, befolgen Sie diese Anweisungen: Wenn Sie über eine funktionierende Kompilierungsumgebung verfügen, kann die Installation so einfach sein wie:

pip install insightface

oder für die portable Version im ComfyUI_windows_portable-Ordner:

python_embeded/python.exe -m pip install insightface

Wenn dies fehlschlägt (und das ist wahrscheinlich), können Sie im Abschnitt „Fehlerbehebung“ des Reaktorknotens nach Alternativen suchen:

https://github.com/Gourieff/comfyui-reactor-node

Extrahieren Sie dies für das Insightface-Modell nach ComfyUI/models/insightface/buffalo_l :

https://github.com/deepinsight/insightface/releases/download/v0.7/buffalo_l.zip

Bitte beachten Sie, dass die Insightface-Lizenz nichtkommerzieller Natur ist.