KoGPT2 chatbot

1.0.0

Einfaches Chatbot-Experiment mit öffentlich verfügbaren Hangul-Chatbot-Daten und vorab trainiertem KoGPT2

Wir untersuchen das Potenzial für verschiedene Einsatzmöglichkeiten von KoGPT2 und bewerten seine Leistung qualitativ.

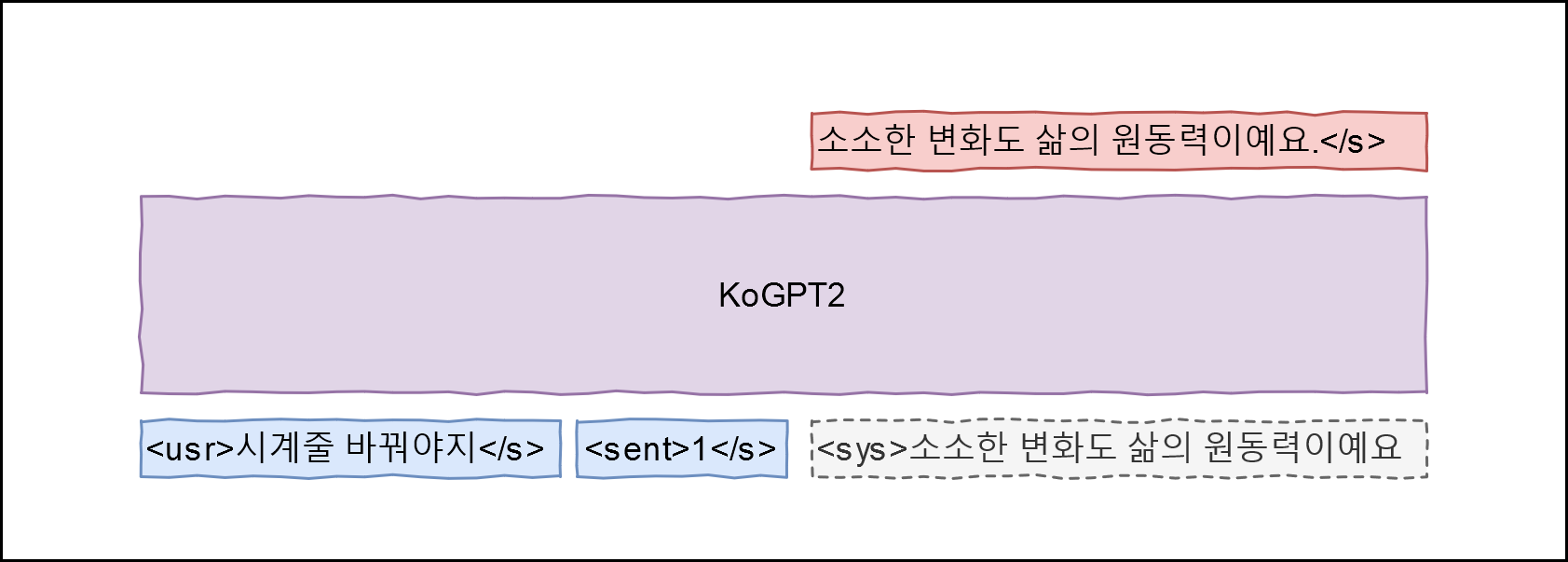

Hallo! ist für Trainingsdaten geeignet. Unter Anwendung von GPT-2 haben wir die folgende Architektur entworfen

Lernen Sie ein Modell kennen, das P(<sys>|<usr>, <sent>) maximieren kann, indem das Q-Feld der Daten der Äußerung <usr> , das Feld A der Äußerung <sys> und die Emotionsbezeichnung <sent> zugeordnet wird <sent> Emotionsbezeichnungen folgen den Definitionen hier (alltägliches Ereignis 0, Trennung (negativ) 1, Liebe (positiv) 2).

git clone --recurse-submodules https://github.com/haven-jeon/KoGPT2-chatbot.gitcd KoGPT2-chatbot pip3 install -r Anforderungen.txt

CUDA_VISIBLE_DEVICES=0 python train_torch.py --gpus 1 --train --max_epochs 2

# CUDA_VISIBLE_DEVICES=0 python train.py --chatCUDA_VISIBLE_DEVICES=0 python train_torch.py --gpus 1 --chat Benutzer > Jackpot Simsimi > Es wird gut. Benutzer > Wie heißt du?Simsimi > Ich bin Wirobot. Benutzer > Was machen wir am Muttertag? Simsimi > Spiel mit mir. Benutzer > Es regnet Simsimi > Nimm einen Regenschirm. Benutzer > Es schneit Simsimi > Einen Schneemann bauen. Benutzer > Donnerschläge Simsimi > Ich vermisse dich auch. Benutzer > Der Frühling ist da. Simsimi > Ich freue mich immer auf den Frühling. Benutzer > Ich habe eine Magenverstimmung. Simsimi > Geh nach Hause und ruh dich schnell aus. Benutzer > Wer hat dich erschaffen? Simsimi > Du bist die Person, die dich erschaffen hat.

PyTorch