Das Kubernetes ChatGPT Bot-Projekt wird veraltet sein und durch HolmesGPT, unseren erweiterten Open Source DevOps-Assistenten, ersetzt. Mit Holmes können Sie Vorfälle untersuchen, Triage-Probleme lösen, Warnungen anreichern und vieles mehr. Schauen Sie sich https://github.com/robusta-dev/holmesgpt an

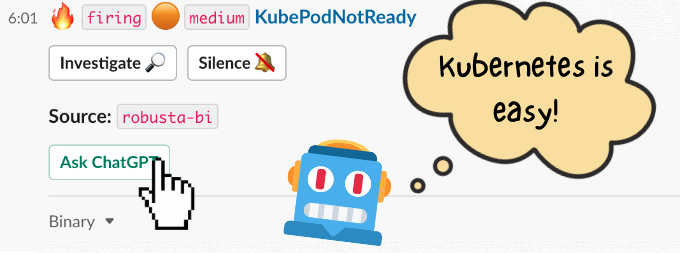

Ein ChatGPT 1- Bot für Kubernetes-Probleme. Fragen Sie die KI, wie Sie Ihre Prometheus-Warnungen lösen können, und erhalten Sie prägnante Antworten.

Lösen Sie Alarme nicht mehr alleine in der Dunkelheit – das Internet steht Ihnen zur Seite.

Bitte denken Sie darüber nach, auf Product Hunt zu stimmen oder Ihren Lieblings-Newsletter zu versenden. Eines Tages wird sich Skynet an Ihre Freundlichkeit erinnern und Sie verschonen!

Prometheus leitet Warnungen mithilfe eines Webhook-Empfängers an den Bot weiter.

Der Bot sendet eine Anfrage an OpenAI und fragt es, wie es Ihre Warnungen beheben kann.

Sie lagern Lebensmittel für den Roboteraufstand in Ihrer Speisekammer.

Der Bot wird mithilfe von Robusta.dev implementiert, einer Open-Source-Plattform zur Reaktion auf Kubernetes-Warnungen. Wir verfügen auch über eine SaaS-Plattform für Multi-Cluster-Kubernetes-Observability.

Ein Slack-Arbeitsbereich

Installieren Sie Robusta mit Helm

Laden Sie das ChatGPT-Playbook. Fügen Sie Folgendes zu generated_values.yaml hinzu:

playbookRepos:

chatgpt_robusta_actions:

url: "https://github.com/robusta-dev/kubernetes-chatgpt-bot.git"

customPlaybooks:

# Add the 'Ask ChatGPT' button to all Prometheus alerts

- triggers:

- on_prometheus_alert: {}

actions:

- chat_gpt_enricher: {} Fügen Sie Ihren OpenAI-API-Schlüssel zu generated_values.yaml hinzu. Stellen Sie sicher, dass Sie den vorhandenen globalConfig -Abschnitt bearbeiten und keinen doppelten Abschnitt hinzufügen.

globalConfig: chat_gpt_token: YOUR KEY GOES HERE

Führen Sie ein Helm-Upgrade durch, um die neuen Werte anzuwenden: helm upgrade robusta robusta/robusta --values=generated_values.yaml --set clusterName=<YOUR_CLUSTER_NAME>

Senden Sie Ihre Prometheus-Benachrichtigungen an Robusta. Alternativ können Sie einfach den mitgelieferten Prometheus-Stack von Robusta verwenden.

Anstatt auf eine Prometheus-Warnung zu warten, sollten wir eine auslösen.

Stellen Sie einen defekten Pod bereit, der im Status „Ausstehend“ hängenbleibt:

kubectl apply -f https://raw.githubusercontent.com/robusta-dev/kubernetes-demos/main/pending_pods/pending_pod_node_selector.yaml

Lösen Sie sofort eine Prometheus-Benachrichtigung aus und überspringen Sie die normalen Verzögerungen:

robusta playbooks trigger prometheus_alert alert_name=KubePodCrashLooping namespace=default pod_name=example-pod

Eine Benachrichtigung wird mit einer Schaltfläche in Slack eingehen. Klicken Sie auf die Schaltfläche, um ChatGPT nach der Warnung zu fragen.

Kann ChatGPT bessere Antworten geben, wenn Sie ihm Pod-Protokolle oder die Ausgabe von kubectl get events zuführen?

Robusta sammelt diese Daten bereits und hängt sie an Prometheus-Benachrichtigungen an, sodass das Hinzufügen einfach sein sollte.

PRs sind willkommen!

Teilen Sie Ihre lustigsten Ergebnisse und schlagen Sie neue Funktionen auf unserem Slack vor.

Sie können gerne das folgende Bild verwenden oder ein eigenes erstellen.

Natan testet ChatGPT für Kubernetes-Produktionswarnungen

Natan Yellin und Sid Palas gehen den Code auf YouTube durch – relevanter Teil beginnt bei 38:54

Technisch gesehen verwendet dieses Projekt kein ChatGPT. Es verwendet das text-davinci-003 -Modell, ein GPT3.5-basiertes Geschwistermodell von ChatGPT. Da die meisten Menschen zwar mit ChatGPT, aber nicht text-davinci-003 oder GPT3.5 vertraut sind, haben wir uns entschieden, den Namen „ChatGPT-Bot“ trotz der technischen Ungenauigkeit beizubehalten. ↩