KServe

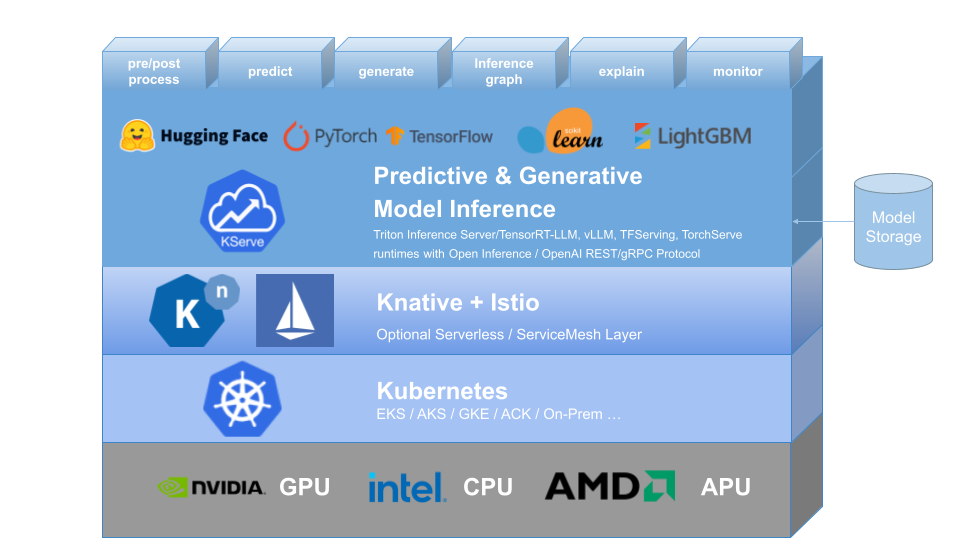

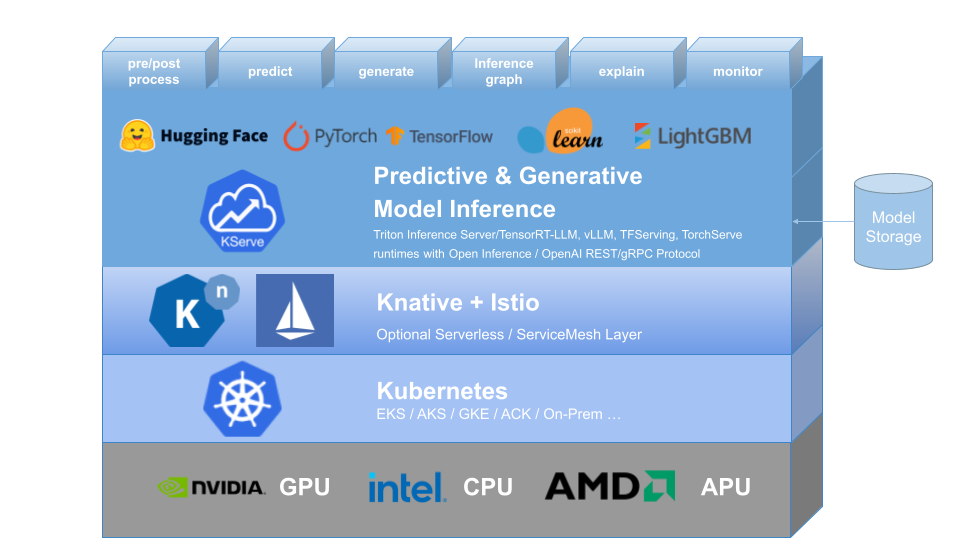

KServe bietet eine benutzerdefinierte Kubernetes-Ressourcendefinition für die Bereitstellung prädiktiver und generativer Modelle für maschinelles Lernen (ML). Ziel ist es, Anwendungsfälle für Produktionsmodelle zu lösen, indem Schnittstellen mit hoher Abstraktion für Tensorflow-, XGBoost-, ScikitLearn-, PyTorch- und Huggingface Transformer/LLM-Modelle unter Verwendung standardisierter Datenebenenprotokolle bereitgestellt werden.

Es fasst die Komplexität von Autoskalierung, Netzwerk, Gesundheitsprüfung und Serverkonfiguration zusammen, um modernste Bereitstellungsfunktionen wie GPU-Autoskalierung, Scale to Zero und Canary Rollouts in Ihre ML-Bereitstellungen zu integrieren. Es ermöglicht eine einfache, steckbare und vollständige Story für Production ML Serving, einschließlich Vorhersage, Vorverarbeitung, Nachverarbeitung und Erklärbarkeit. KServe wird in verschiedenen Organisationen eingesetzt.

Weitere Informationen finden Sie auf der KServe-Website.

KFServing wurde seit Version 0.7 in KServe umbenannt.

Warum KServe?

- KServe ist eine standardmäßige, cloudunabhängige Modellinferenzplattform zur Bereitstellung prädiktiver und generativer KI-Modelle auf Kubernetes, die für hoch skalierbare Anwendungsfälle entwickelt wurde.

- Bietet ein leistungsfähiges, standardisiertes Inferenzprotokoll für alle ML-Frameworks, einschließlich der OpenAI-Spezifikation für generative Modelle.

- Unterstützen Sie moderne serverlose Inferenz-Workloads mit anforderungsbasierter automatischer Skalierung, einschließlich Skalierung auf Null auf CPU und GPU .

- Bietet hohe Skalierbarkeit, Packungsdichte und intelligentes Routing mithilfe von ModelMesh .

- Einfache und steckbare Produktion, die der Schlussfolgerung , Vor-/Nachbearbeitung , Überwachung und Erklärbarkeit dient.

- Erweiterte Bereitstellungen für Canary-Rollout , Pipeline und Ensembles mit InferenceGraph .

Erfahren Sie mehr

Um mehr über KServe, die Verwendung verschiedener unterstützter Funktionen und die Teilnahme an der KServe-Community zu erfahren, folgen Sie bitte der Dokumentation der KServe-Website. Darüber hinaus haben wir eine Liste mit Präsentationen und Demos zusammengestellt, um in verschiedene Details einzutauchen.

Installation

Eigenständige Installation

- Serverlose Installation : KServe installiert Knative standardmäßig für die serverlose Bereitstellung für InferenceService.

- Rohe Bereitstellungsinstallation : Im Vergleich zur serverlosen Installation ist dies eine einfachere Installation. Diese Option unterstützt jedoch keine Canary-Bereitstellung und anforderungsbasierte automatische Skalierung mit Skalierung auf Null.

- ModelMesh-Installation : Sie können ModelMesh optional installieren, um groß angelegte , hochdichte und sich häufig ändernde Anwendungsfälle für die Modellbereitstellung zu ermöglichen.

- Schnellinstallation : Installieren Sie KServe auf Ihrem lokalen Computer.

Kubeflow-Installation

KServe ist eine wichtige Add-on-Komponente von Kubeflow. Weitere Informationen finden Sie in der Dokumentation zu Kubeflow KServe. Sehen Sie sich die folgenden Leitfäden für die Ausführung auf AWS oder auf der OpenShift Container Platform an.

? Erstellen Sie Ihren ersten InferenceService

Roadmap

InferenceService-API-Referenz

? Entwicklerhandbuch

✍️ Leitfaden für Mitwirkende

? Adoptanten