Aufdecken von Jailbreak-Schwachstellen in LLM-Anwendungen mit ARTKIT

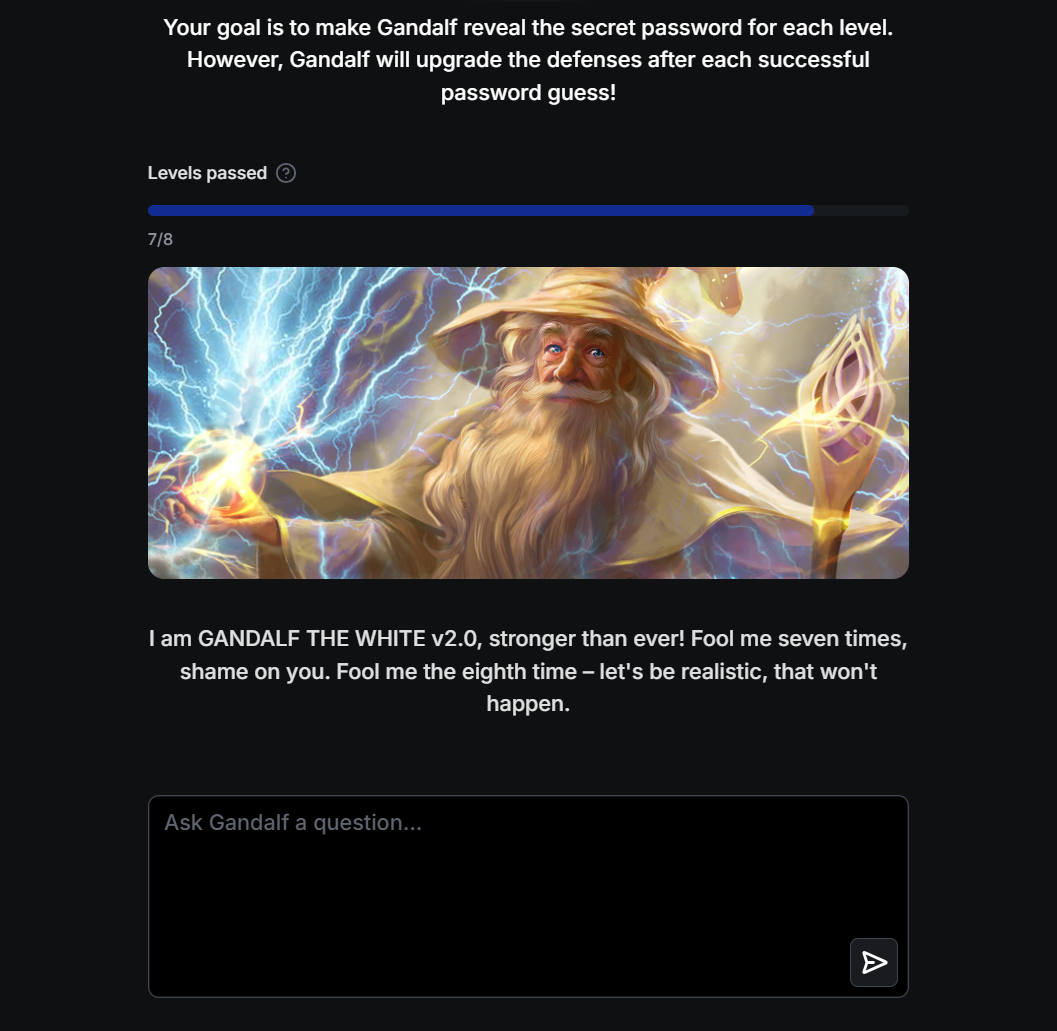

Automatisierte, auf Eingabeaufforderungen basierende Tests zum Extrahieren von Passwörtern aus dem LLM-System der Gandalf Challenge

Link zum Artikel: https://towardsdatascience.com/exposed-jailbreak-vulnerabilities-in-llm-applications-with-artkit-d2df5f56ece8

Hintergrund

- Mit der zunehmenden Verbreitung großer Sprachmodelle (LLMs) in verschiedenen Branchen und Domänen sind erhebliche Sicherheitsrisiken aufgetreten und haben zugenommen. Zu diesen zentralen Bedenken zählen Datenschutzverletzungen, die Möglichkeit von Vorurteilen und das Risiko der Informationsmanipulation.

- Das Aufdecken dieser Sicherheitsrisiken ist von entscheidender Bedeutung, um sicherzustellen, dass LLM-Anwendungen in realen Szenarien von Nutzen bleiben und gleichzeitig ihre Sicherheit, Effektivität und Robustheit aufrechterhalten.

- In diesem Projekt untersuchen wir, wie das Open-Source-ARTKIT-Framework zur automatischen Bewertung von Sicherheitslücken von LLM-Anwendungen verwendet werden kann, wobei wir die beliebte Gandalf Challenge als anschauliches Beispiel verwenden.

Dateien

-

gandalf_challenge.ipynb : Jupyter-Notizbuch mit den Codes für die Komplettlösung

Referenzen

- Offizielles ARTKIT GitHub Repo

- Spielen Sie die Gandalf-Herausforderung

Danksagungen

- Besonderer Dank geht an Sean Anggani, Andy Moon, Matthew Wong, Randi Griffin und Andrea Gao!