100 Tage maschinelles Lernen, Codierung, vorgeschlagen von Siraj Raval

Holen Sie sich die Datensätze hier

Schauen Sie sich den Code hier an.

Schauen Sie sich den Code hier an.

Schauen Sie sich den Code hier an.

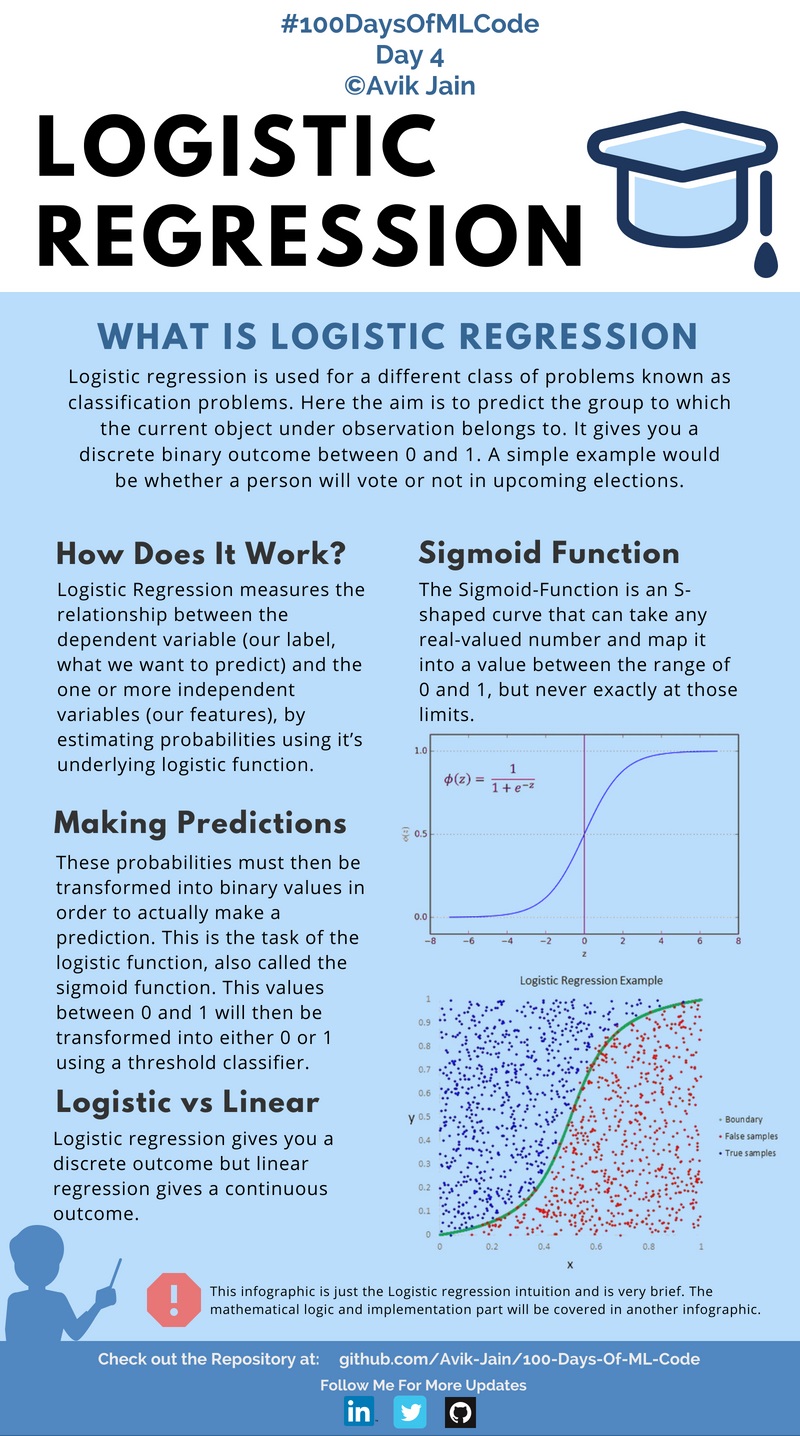

Als ich heute zu #100DaysOfMLCode überging, tauchte ich tiefer in die Tiefe dessen ein, was logistische Regression eigentlich ist und welche Mathematik dahinter steckt. Erfahren Sie, wie die Kostenfunktion berechnet wird und wie Sie dann den Gradientenabstiegsalgorithmus auf die Kostenfunktion anwenden, um den Fehler in der Vorhersage zu minimieren.

Aufgrund der geringeren Zeit werde ich nun an wechselnden Tagen eine Infografik veröffentlichen. Auch wenn mir jemand bei der Dokumentation von Code helfen möchte, bereits Erfahrung auf diesem Gebiet hat und Markdown für Github kennt, kontaktieren Sie mich bitte auf LinkedIn :).

Sehen Sie sich den Kodex hier an

#100DaysOfMLCode Um meine Erkenntnisse zur logistischen Regression zu klären, habe ich im Internet nach einer Ressource oder einem Artikel gesucht und bin auf diesen Artikel (https://towardsdatascience.com/logistic-regression-detailed-overview-46c4da4303bc) von Saishruthi Swaminathan gestoßen.

Es enthält eine detaillierte Beschreibung der logistischen Regression. Schauen Sie es sich an.

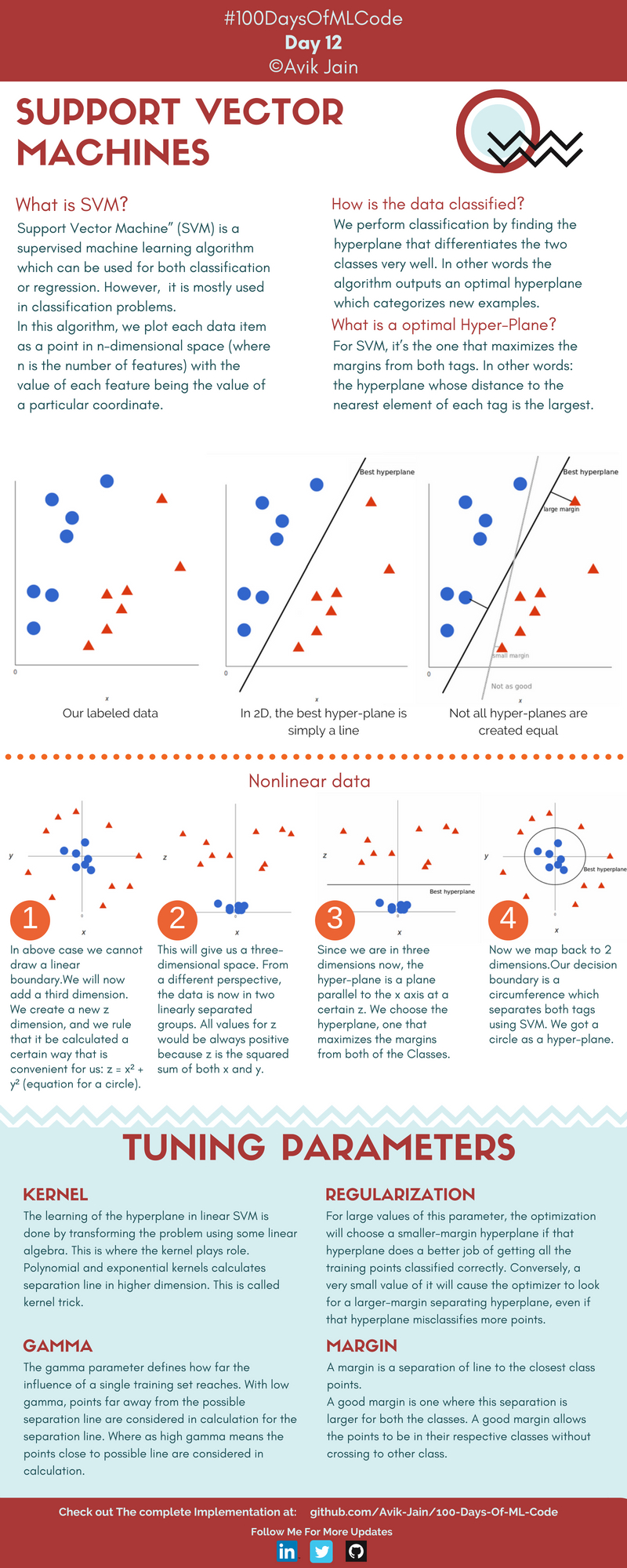

Ich habe eine Vorstellung davon, was SVM ist und wie es zur Lösung des Klassifizierungsproblems verwendet wird.

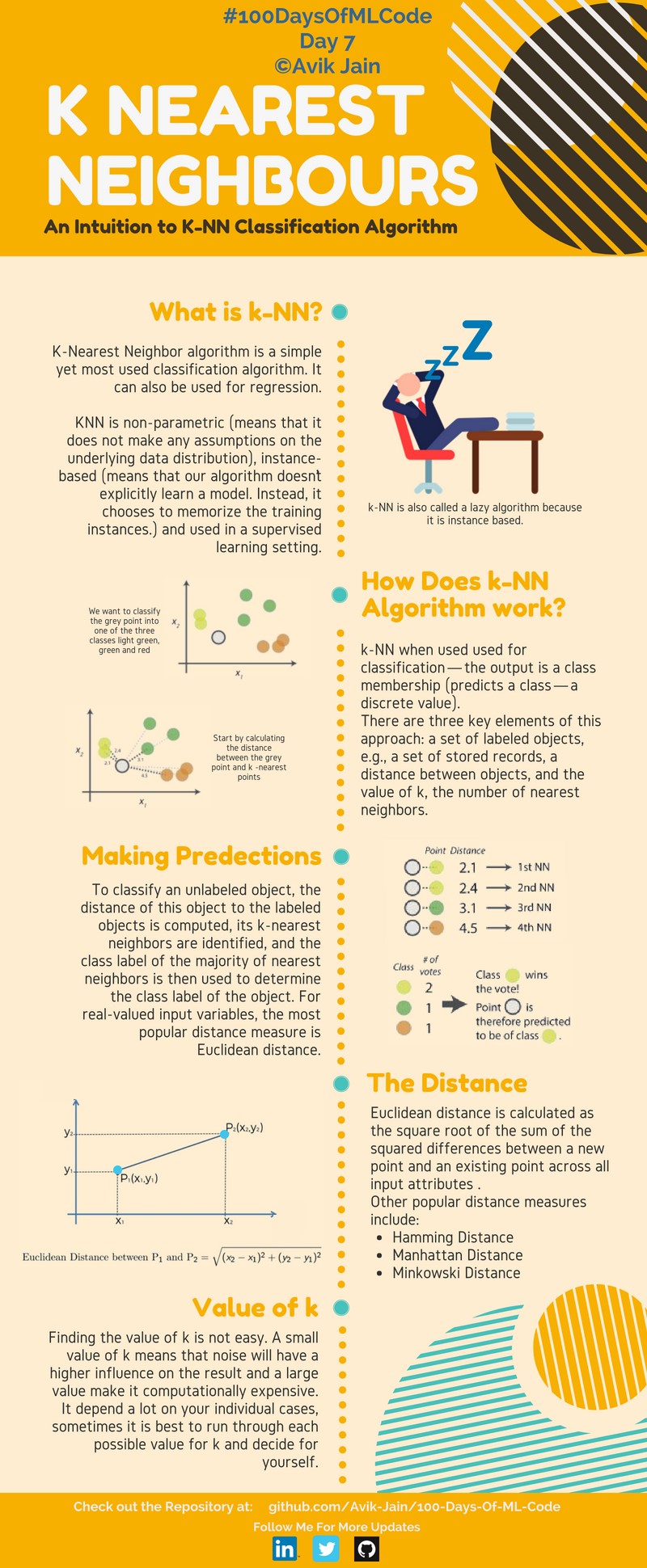

Erfahren Sie mehr über die Funktionsweise von SVM und die Implementierung des K-NN-Algorithmus.

Implementierung des K-NN-Algorithmus zur Klassifizierung. #100DaysOfMLCode Support Vector Machine Infografik ist zur Hälfte fertig. Werde es morgen aktualisieren.

Heute fuhr ich mit #100DaysOfMLCode fort und ging den Naive-Bayes-Klassifikator durch. Ich implementieren die SVM auch in Python mit scikit-learn. Werde den Code bald aktualisieren.

Heute habe ich SVM für linear verwandte Daten implementiert. Verwendete Scikit-Learn-Bibliothek. In Scikit-Learn verfügen wir über den SVC-Klassifikator, den wir zur Lösung dieser Aufgabe verwenden. Wird bei der nächsten Implementierung den Kernel-Trick verwenden. Überprüfen Sie den Code hier.

Erfahren Sie mehr über verschiedene Arten von Naive-Bayes-Klassifikatoren. Außerdem begannen die Vorträge von Bloomberg. Das erste in der Playlist war Black Box Machine Learning. Es bietet einen vollständigen Überblick über Vorhersagefunktionen, Merkmalsextraktion, Lernalgorithmen, Leistungsbewertung, Kreuzvalidierung, Stichprobenverzerrung, Nichtstationarität, Überanpassung und Hyperparameter-Tuning.

Unter Verwendung der Scikit-Learn-Bibliothek wurde ein SVM-Algorithmus zusammen mit einer Kernelfunktion implementiert, die unsere Datenpunkte in höhere Dimensionen abbildet, um die optimale Hyperebene zu finden.

Die gesamte Woche 1 und Woche 2 an einem einzigen Tag abgeschlossen. Erlernte logistische Regression als neuronales Netzwerk.

Abschluss des Kurses 1 der Deep-Learning-Spezialisierung. Ein neuronales Netz in Python implementiert.

Beginn der Vorlesung 1 von 18 des Caltech-Kurses für maschinelles Lernen – CS 156 von Professor Yaser Abu-Mostafa. Es war im Grunde eine Einführung in die kommenden Vorlesungen. Er erklärte auch den Perceptron-Algorithmus.

Woche 1 zum Thema „Improving Deep Neural Networks: Hyperparameter-Tuning, Regularisierung und Optimierung“ abgeschlossen.

Habe mir einige Tutorials zum Web-Scraping mit Beautiful Soup angesehen, um Daten für die Erstellung eines Modells zu sammeln.

Vorlesung 2 von 18 des Caltech-Kurses für maschinelles Lernen – CS 156 von Professor Yaser Abu-Mostafa. Erfahren Sie mehr über die Hoeffding-Ungleichung.

In Lektion 3 des Bloomberg ML-Kurses wurden einige der Kernkonzepte wie Eingaberaum, Aktionsraum, Ergebnisraum, Vorhersagefunktionen, Verlustfunktionen und Hypothesenräume vorgestellt.

Überprüfen Sie den Code hier.

Habe auf YouTube einen tollen Kanal gefunden: 3Blue1Brown. Es gibt eine Playlist namens Essence of Linear Algebra. Begann mit der Fertigstellung von 4 Videos, die einen vollständigen Überblick über Vektoren, lineare Kombinationen, Spannen, Basisvektoren, lineare Transformationen und Matrixmultiplikation gaben.

Link zur Playlist hier.

Weiter geht es mit der fertigen Playlist mit den nächsten 4 Videos zu den Themen 3D-Transformationen, Determinanten, Inverse Matrix, Spaltenraum, Nullraum und nichtquadratische Matrizen.

Link zur Playlist hier.

In der Playlist von 3Blue1Brown sind weitere 3 Videos aus der Essenz der linearen Algebra enthalten. Die behandelten Themen waren Punktprodukt und Kreuzprodukt.

Link zur Playlist hier.

Habe heute die gesamte Playlist fertiggestellt, Videos 12–14. Wirklich eine tolle Playlist, um die Konzepte der linearen Algebra aufzufrischen. Die behandelten Themen waren der Basiswechsel, Eigenvektoren und Eigenwerte sowie abstrakte Vektorräume.

Link zur Playlist hier.

Vervollständigung der Playlist – Essence of Linear Algebra von 3blue1brown. Auf YouTube ist ein Vorschlag zu einer Reihe von Videos vom selben Kanal 3Blue1Brown aufgetaucht. Da ich bereits von der vorherigen Serie zur linearen Algebra beeindruckt war, habe ich mich sofort darauf eingelassen. Etwa 5 Videos zu Themen wie Ableitungen, Kettenregel, Produktregel und Exponentialableitung fertiggestellt.

Link zur Playlist hier.

2 Videos zum Thema Implizite Differenzierung und Grenzen aus der Playlist Essence of Calculus angesehen.

Link zur Playlist hier.

Habe mir die restlichen 4 Videos angesehen, die Themen wie Integration und Derivate höherer Ordnung behandeln.

Link zur Playlist hier.

Überprüfen Sie den Code hier.

Ein erstaunliches Video über neuronale Netze vom YouTube-Kanal 3Blue1Brown. Dieses Video vermittelt ein gutes Verständnis neuronaler Netze und verwendet handgeschriebene Zifferndatensätze, um das Konzept zu erklären. Link zum Video.

Teil zwei der neuronalen Netze vom YouTube-Kanal 3Blue1Brown. Dieses Video erklärt die Konzepte von Gradient Descent auf interessante Weise. 169 unbedingt ansehen und sehr zu empfehlen. Link zum Video.

Teil drei der neuronalen Netze vom YouTube-Kanal 3Blue1Brown. In diesem Video geht es hauptsächlich um partielle Ableitungen und Backpropagation. Link zum Video.

Teil vier der neuronalen Netze vom YouTube-Kanal 3Blue1Brown. Das Ziel besteht hier darin, in etwas formelleren Worten die Intuition darüber darzustellen, wie Backpropagation funktioniert, und im Video werden hauptsächlich die partiellen Ableitungen und die Backpropagation erörtert. Link zum Video.

Link zum Video.

Link zum Video.

Link zum Video.

Link zum Video.

Wechselte zum unbeaufsichtigten Lernen und studierte etwas über Clustering. Wenn Sie an meiner Website arbeiten, schauen Sie sich avikjain.me an. Außerdem habe ich eine wunderbare Animation gefunden, die dabei helfen kann, K – Means Clustering Link leicht zu verstehen

K-Means-Clustering wurde implementiert. Überprüfen Sie den Code hier.

Habe ein neues Buch „Python Data Science HandBook“ von JK VanderPlas erhalten. Sehen Sie sich hier die Jupyter-Notizbücher an.

Begonnen mit Kapitel 2: Einführung in Numpy. Behandelte Themen wie Datentypen, Numpy-Arrays und Berechnungen für Numpy-Arrays.

Überprüfen Sie den Code -

Einführung in NumPy

Datentypen in Python verstehen

Die Grundlagen von NumPy-Arrays

Berechnung auf NumPy-Arrays: Universelle Funktionen

Kapitel 2: Aggregationen, Vergleiche und Rundfunk

Link zum Notizbuch:

Aggregationen: Min, Max und alles dazwischen

Berechnung auf Arrays: Broadcasting

Vergleiche, Masken und boolesche Logik

Kapitel 2: Ausgefallene Indizierung, Arrays sortieren, strukturierte Daten

Link zum Notizbuch:

Ausgefallene Indizierung

Sortieren von Arrays

Strukturierte Daten: Strukturierte Arrays von NumPy

Kapitel 3: Datenmanipulation mit Pandas

Behandelt werden verschiedene Themen wie Pandas-Objekte, Datenindizierung und -auswahl, Datenverarbeitung, Umgang mit fehlenden Daten, hierarchische Indizierung, ConCat und Append.

Link zu den Notizbüchern:

Datenmanipulation mit Pandas

Einführung in Pandas-Objekte

Datenindizierung und -auswahl

Arbeiten mit Daten in Pandas

Umgang mit fehlenden Daten

Hierarchische Indizierung

Kombinieren von Datensätzen: Concat und Append

Kapitel 3: Folgende Themen abgeschlossen: Zusammenführen und Verknüpfen, Aggregation und Gruppierung sowie Pivot-Tabellen.

Datensätze kombinieren: Zusammenführen und verbinden

Aggregation und Gruppierung

Pivot-Tabellen

Kapitel 3: Vektorisierte String-Operationen, Arbeiten mit Zeitreihen

Links zu Notizbüchern:

Vektorisierte String-Operationen

Arbeiten mit Zeitreihen

Hochleistungs-Pandas: eval() und query()

Kapitel 4: Visualisierung mit Matplotlib Erfahren Sie mehr über einfache Liniendiagramme, einfache Streudiagramme, Dichtediagramme und Konturdiagramme.

Links zu Notizbüchern:

Visualisierung mit Matplotlib

Einfache Liniendiagramme

Einfache Streudiagramme

Fehler visualisieren

Dichte- und Konturdiagramme

Kapitel 4: Visualisierung mit Matplotlib Erfahren Sie mehr über Histogramme, das Anpassen von Plotlegenden, Farbbalken und das Erstellen mehrerer Unterplots.

Links zu Notizbüchern:

Histogramme, Binnings und Dichte

Anpassen von Handlungslegenden

Anpassen von Farbleisten

Mehrere Nebenhandlungen

Text und Anmerkung

Kapitel 4: Behandeltes dreidimensionales Plotten in Mathplotlib.

Links zu Notizbüchern:

Dreidimensionales Plotten in Matplotlib

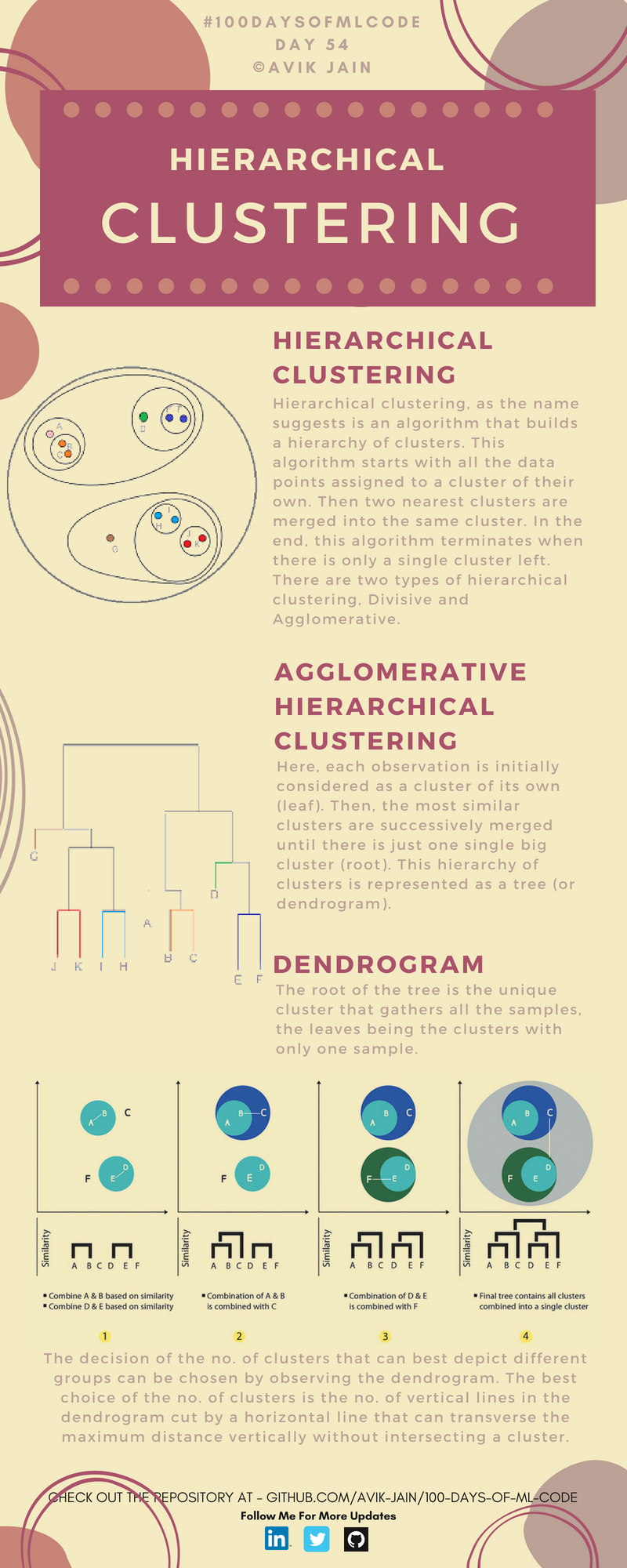

Studierte über hierarchisches Clustering. Schauen Sie sich diese erstaunliche Visualisierung an.