Diese Arbeit verwendet Diffusionsmodelle, um generative Fülltechniken wie Bilddemaskierung, Inpainting, Erweiterung und verschiedene generative Fülltechniken zu implementieren.

Bildinpainting (Originalbild, maskiertes Bild, rekonstruiertes Bild)

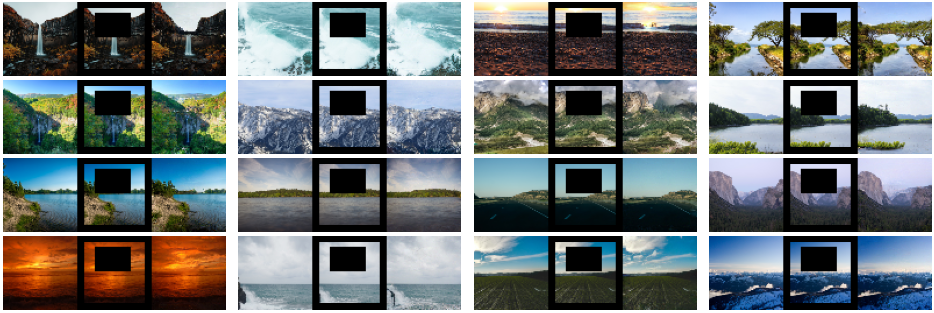

DDPM generiert (trainiert und generiert mithilfe des Landscape-Datensatzes).

LDM generiert (auf COCO trainiert und mithilfe des Landschaftsdatensatzes generiert).

Probenahme mit COCO

Weitere generierte Bilder finden Sie in den Ergebnissen

Schauen Sie sich meine DDPM-Implementierung an.

Dieses Repo beinhaltet generatives Füllen mit DDPM. Um dasselbe mit LDM durchzuführen, schauen Sie sich hier mein LDM-Repo an. Der Ordner „ldm-genfill“ in diesem Repo enthält nur die Modellkonfigurationsdateien zum generativen Füllen mithilfe von LDM-Modellen. Verwenden Sie also die Implementierung in meinem LDM-Repo mit Konfigurationsdateien in diesem Repo. Demo- und andere Anweisungen für alle LDM-Konditionierungen sind im LDM-Repo verfügbar.

Derzeit nicht maskierte Regionen von DDPM scheinen im Vergleich zu LDM kontextrelevanter zu sein, da DDPM direkt auf Bilder wirkt. Durch die Verwendung von Text- und Klassenkonditionierung zur Unterstützung von GenFill wird die Fähigkeit zum kontextuellen Ausfüllen leicht verbessert, und durch weiteres Training kann sich dies ebenfalls verbessern. Möglicherweise sind zu einem späteren Zeitpunkt Verbesserungen geplant.

Aktuelle Updates