Die Enterprise Scale AI Factory ist eine Plug-and-Play-Lösung, die die Bereitstellung, Bereitstellung und Verwaltung von KI-Projekten auf Azure mit einer vorlagenbasierten Arbeitsweise automatisiert.

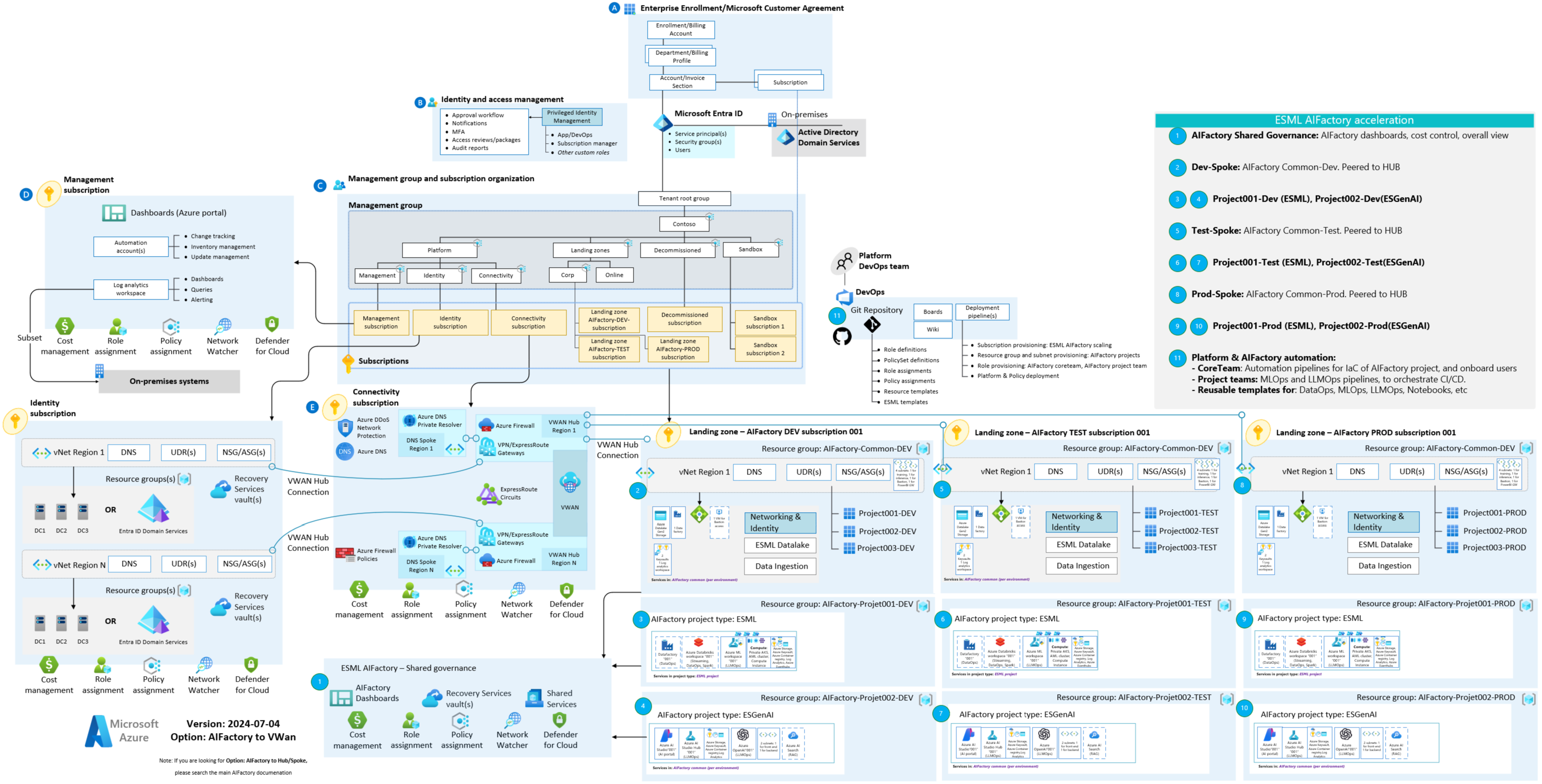

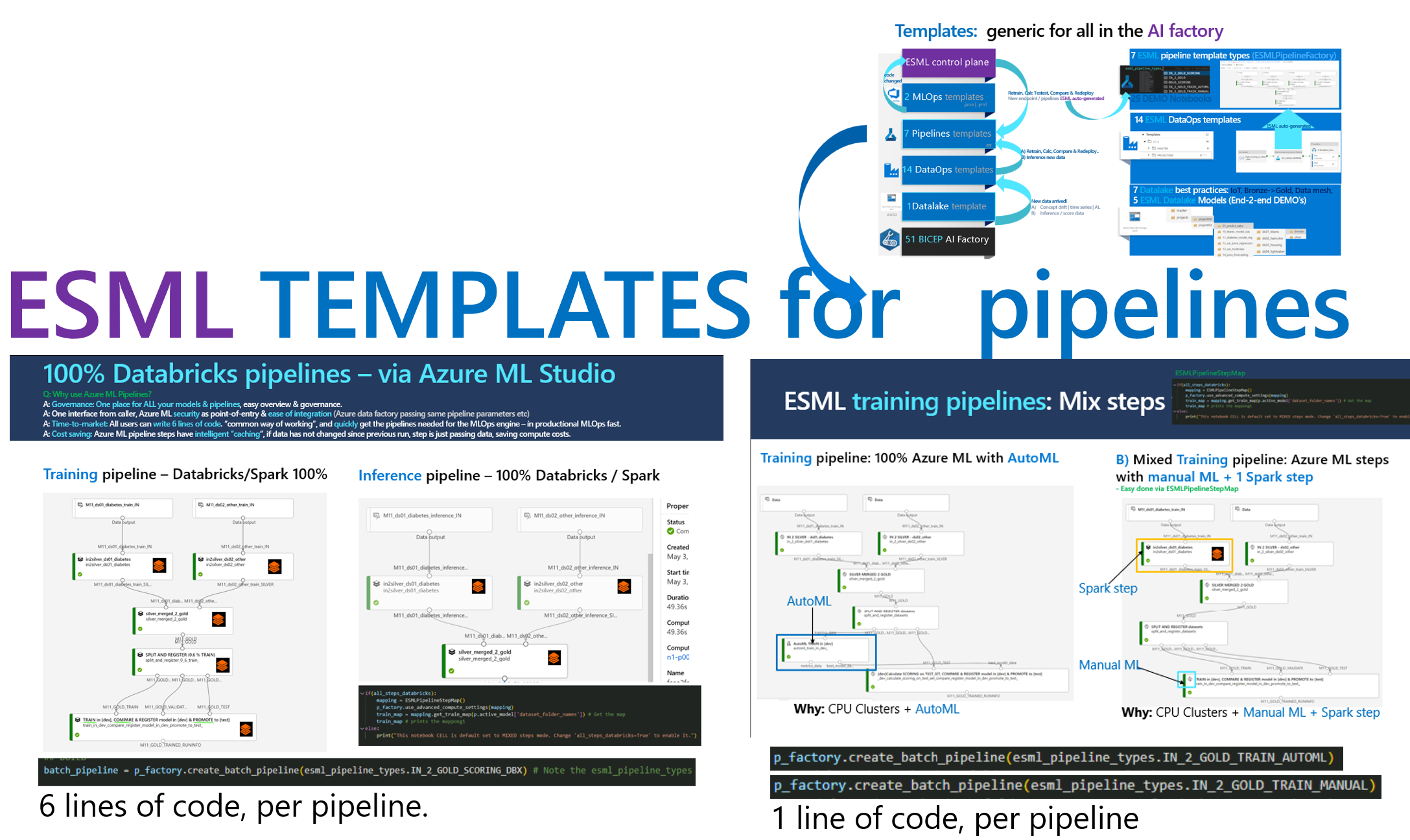

Marry multiple best practices & accelerators: Es verwendet mehrere vorhandene Microsoft-Beschleuniger/Landingzone-Architekturen und Best Practices wie CAF und WAF wieder und bietet ein End-2-End-Erlebnis, einschließlich Entwicklungs-, Test- und Produktionsumgebungen.PRIVATE Netzwerke: Private Endpunkte für alle Dienste wie Azure Machine Learning, privater AKS-Cluster, private Containerregistrierung, Speicher, Azure Data Factory, Überwachung uswPlug-and-play : Erstellen Sie dynamisch Infrastrukturressourcen pro Team, einschließlich dynamischer Vernetzung und dynamischer RBACTemplate way of working & Project way of working: Die AI Factory ist project based (Kostenkontrolle, Datenschutz, Skalierbarkeit pro Projekt) und bietet neben Infrastrukturvorlagen mehrere Vorlagen : DataLake template, DataOps templates, MLOps templates mit wählbaren Projekttypen.Same MLOps – Wetterdatenwissenschaftler entscheiden sich für die Arbeit mit Azure Databricks oder Azure Machine Learning – es wird dieselbe MLOps-Vorlage verwendet.Common way of working, common toolbox, a flexible one : Eine Toolbox mit einer LAMBDA-Architektur mit Tools wie: Azure Datafactory, Azure Databricks, Azure Machine Learning, Eventhubs, AKSEnterprise scale & security & battle tested : Wird seit 2019 von Kunden und Partnern mit MLOps verwendet (siehe LINKS), um die Entwicklung und Bereitstellung von KI-Lösungen mit gemeinsamen Tools und der Kombination mehrerer Best Practices zu beschleunigen. Standardmäßig privates Netzwerk (private Endpunkte). AI factory - setup in 60h (Company: Epiroc) – End-2-End-Pipelines für Anwendungsfall: How-to

AI factory – Technischer BLOG

Microsoft: AI Factory (CAF/MLOps) -Dokumentation: Maschinelle Lernvorgänge – Cloud Adoption Framework | Microsoft Learn

Microsoft: AI Factory (Well-architected framework) Dokumentation: WAF AI Workload – Well-architected Framework | Microsoft Learn

Die beiden Projekttypen leben innerhalb der AIFactory-Landezonen.

Die Dokumentation ist über die Doc-Serie rund um ROLES organisiert.

| Doc-Serie | Rolle | Fokus | Einzelheiten |

|---|---|---|---|

| 10-19 | CoreTeam | Governance | Aufbau der AI Factory. Regierungsführung. Infrastruktur, Vernetzung. Berechtigungen |

| 20-29 | CoreTeam | Usage | Benutzer-Onboarding und AI Factory-Nutzung. DataOps für das Datenerfassungsteam des CoreTeams |

| 30-39 | ProjectTeam | Usage | Dashboard, verfügbare Tools und Dienste, DataOps, MLOps, Zugriffsoptionen auf die private AIFactory |

| 40-49 | All | FAQ | Verschiedene häufig gestellte Fragen. Bitte schauen Sie hier, bevor Sie einen ESML AIFactory-Mentor kontaktieren. |

Auch die Organisation erfolgt über die vier Komponenten der ESML AIFactory:

| Komponente | Rolle | Doc-Serie |

|---|---|---|

| 1) Infrastruktur: AIFactory | Kernteam | 10-19 |

| 2) Datalake-Vorlage | Alle | 20-29,30-39 |

| 3) Vorlagen für: DataOps, MLOps, *GenAIOps | Alle | 20-29, 30-39 |

| 4) Beschleuniger: ESML SDK (Python, PySpark), RAG Chatbot usw | ProjektTeam | 30-39 |

LINK zur Dokumentation

CAF/AI Factory : https://docs.microsoft.com/en-us/azure/cloud-adoption-framework/ready/azure-best-practices/ai-machine-learning-mlops#mlops-at- KI-Fabriken im OrganisationsmaßstabMicrosoft Intelligent Data Platform : https://techcommunity.microsoft.com/t5/azure-data-blog/microsoft-and-databricks-deepen-partnership-for-modern-cloud/ba-p/3640280Modern data architecture with Azure Databricks and Azure Machine Learning : https://docs.microsoft.com/en-us/azure/architecture/solution-ideas/articles/azure-databricks-modern-analytics-architectureDatalake design : https://docs.microsoft.com/en-us/azure/storage/blobs/data-lake-storage-best-practicesDatamesh : https://martinfowler.com/articles/data-mesh-principles.htmlESML AI Factory eine Standardskalierung von 1-250 ESML-Projekten.Enterprise "cockpit" für ALLE Ihre Projekte und Modelle.cost dashboard pro Projekt/Umgebung, in welchem state sich ein Projekt befindet (Dev-, Test-, Prod-Status).| Datum | Kategorie | Was | Link |

|---|---|---|---|

| 2024-03 | Automatisierung | Kernteammitglied hinzufügen | 26-add-esml-coreteam-member.ps1 |

| 2024-03 | Automatisierung | Projektmitglied hinzufügen | 26-add-esml-project-member.ps1 |

| 2024-03 | Anleitung | Kernteam-Tutorial | 10-AIFactory-infra-subscription-resourceproviders.md |

| 2024-03 | Anleitung | Tutorial für Endbenutzer | 01-jumphost-vm-bastion-access.md |

| 2024-03 | Anleitung | Tutorial für Endbenutzer | 03-use_cases-where_to_start.md |

| 2024-02 | Anleitung | Endbenutzerinstallation der Compute-Instanz | R01-install-azureml-sdk-v1+v2.m |

| 2024-02 | Datalake – Onboarding | Auto-ACL für den PROJECT-Ordner in Lakel | - |

| 2023-03 | Vernetzung | Keine öffentliche IP: Virtuelle private Cloud – aktualisierte Netzwerkregeln | https://learn.microsoft.com/en-us/azure/machine-learning/v1/how-to-secure-workspace-vnet?view=azureml-api-1&preserve-view=true&tabs=required%2Cpe%2Ccli |

| 2023-02 | ESML-Pipeline-Vorlagen | Azure Databricks: Schulungs- und Batch-Pipeline-Vorlagen. 100 % gleiche Unterstützung wie AML-Pipeline-Vorlagen (innere/äußere Schleife MLOps) | - |

| 2022-08 | ESML-Infrastruktur (IaC) | Bicep unterstützt jetzt auch Yaml | - |

| 2022-10 | ESML MLOps | ESML MLOps v3 erweiterter Modus, Unterstützung für Spark-Schritte (Databricks-Notebooks / DatabrickStep) | - |

ESML steht für: Enterprise Scale ML.

Dieser Beschleuniger wurde 2019 aufgrund der Notwendigkeit geboren, DataOps und MLOps zu beschleunigen.

Der Beschleuniger hieß damals ESML. In der Entperise Scale AIFactory nennen wir diese Beschleunigung jetzt nur noch ESML oder Projekttyp=ESML

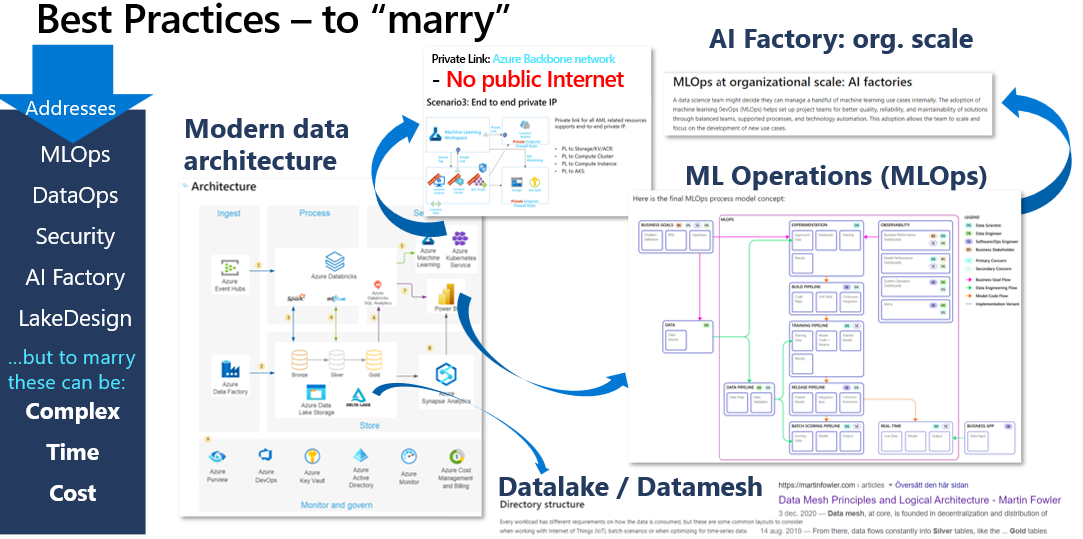

Bei der Innovation mit KI und maschinellem Lernen äußerten mehrere Stimmen die Notwendigkeit einer Enterprise Scale AI & Machine Learning Platform mit schlüsselfertigen end-2-end DataOps und MLOps . Weitere Anforderungen waren ein enterprise datalake design , das in der Lage ist share refined data across the organization , sowie high security und Robustheit: Nur allgemein verfügbare Technologie, VNet-Unterstützung für Pipelines und Daten mit privaten Endpunkten. Eine sichere Plattform mit einem Fabrikansatz zum Erstellen von Modellen.

Selbst wenn Best Practices vorhanden sind, kann die Einrichtung einer solchen AI Factory solution Even if best practices exists, it can be time consuming and complex , und beim Entwurf einer Analyselösung wird häufig eine private Lösung ohne öffentliches Internet gewünscht, da die Arbeit mit Produktionsdaten vom ersten Tag an üblich ist, z. B. bereits in die F&E-Phase. Die Cybersicherheit in diesem Bereich ist wichtig.

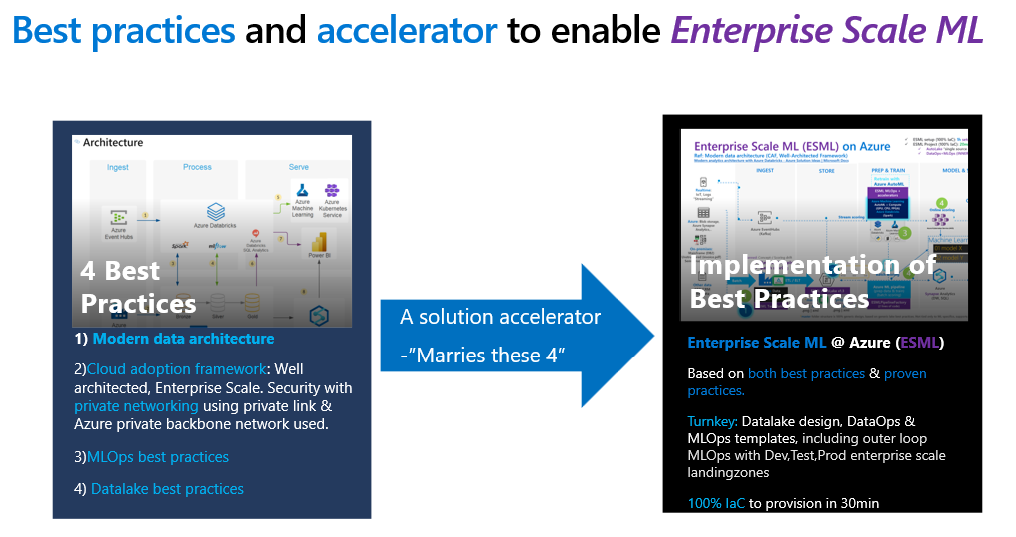

Challenge 1: Mehrere, 4, Best Practices kombinierenChallenge 2: Entwicklung, Test, Produktion von Azure-Umgebungen/Azure-AbonnementsChallenge 3: Schlüsselfertig: Datalake, DataOps, INNER & OUTER LOOP MLOps Außerdem sollte die vollständige Lösung zu 100 % über infrastructure-as-code bereitgestellt werden können, neu erstellt und über mehrere Azure-Abonnements skaliert werden können und project-based skalierbar sein Bis zu 250 Projekte – alle mit ihren eigenen Diensten wie ihrem eigenen Azure-Arbeitsbereich für maschinelles Lernen und Rechenclustern.

Um den Anforderungen und der Herausforderung gerecht zu werden, mussten mehrere Best Practices kombiniert und implementiert werden, wie zum Beispiel: CAF/WAF, MLOps, Datalake design, AI Factory, Microsoft Intelligent Data Platform / Modern Data Architecture. Eine Open-Source-Initiative könnte auf einmal helfen, diesen Open-Source-Beschleuniger Enterprise Scale ML (ESML) –

Eine Open-Source-Initiative könnte auf einmal helfen, diesen Open-Source-Beschleuniger Enterprise Scale ML (ESML) – to get an AI Factory on Azure

ESML stellt eine AI Factory schneller bereit (innerhalb von 4–40 Stunden), mit 1–250 ESML-Projekten, ein ESML-Projekt ist eine Reihe von Azure-Diensten, die sicher zusammengeklebt sind.

Challenge 1 solved: Mehrere heiraten, 4, Best PracticesChallenge 2 solved: Azure-Umgebungen/Azure-Abonnements entwickeln, testen, produzierenChallenge 3 solved: Schlüsselfertig: Datalake, DataOps, INNER & OUTER LOOP MLOps ESML marries multiple best practices in einem solution accelerator mit 100 % Infrastructure-as-CodeIm Folgenden sehen Sie, wie es aussah, als ESML sowohl die Infrastruktur als auch die Generierung von Azure-Pipelines für maschinelles Lernen mit drei Codezeilen automatisierte.

TRAINING & INFERENCE-Pipeline-Vorlagentypen in ESML AIFactory, die für den Endbenutzer beschleunigt werden.

Dieses Repository ist ein reiner Push-Spiegel. Ping Joakim Åström für Beiträge/Ideen.

Da es sich um ein „Nur-Mirror“-Design handelt, sind Pull-Anfragen nicht möglich, außer für ESML-Administratoren. Siehe LIZENZ-Datei (Open Source, MIT-Lizenz) Apropos Open Source, Mitwirkende:

Kim Berg und Ben Kooijman für ihren Beitrag! (Ein großes Lob an den ESML-IP-Rechner und die Bicep-Ergänzungen für den Typ „esml-project“)Christofer Högvall für seinen Beitrag! (Ein großes Lob an das Powershell-Skript, um Ressourcenanbieter zu aktivieren, falls nicht beendet)azure-enterprise-scale-mlenvironment_setupaifactorybicepesml-util26-enable-resource-providers.ps1