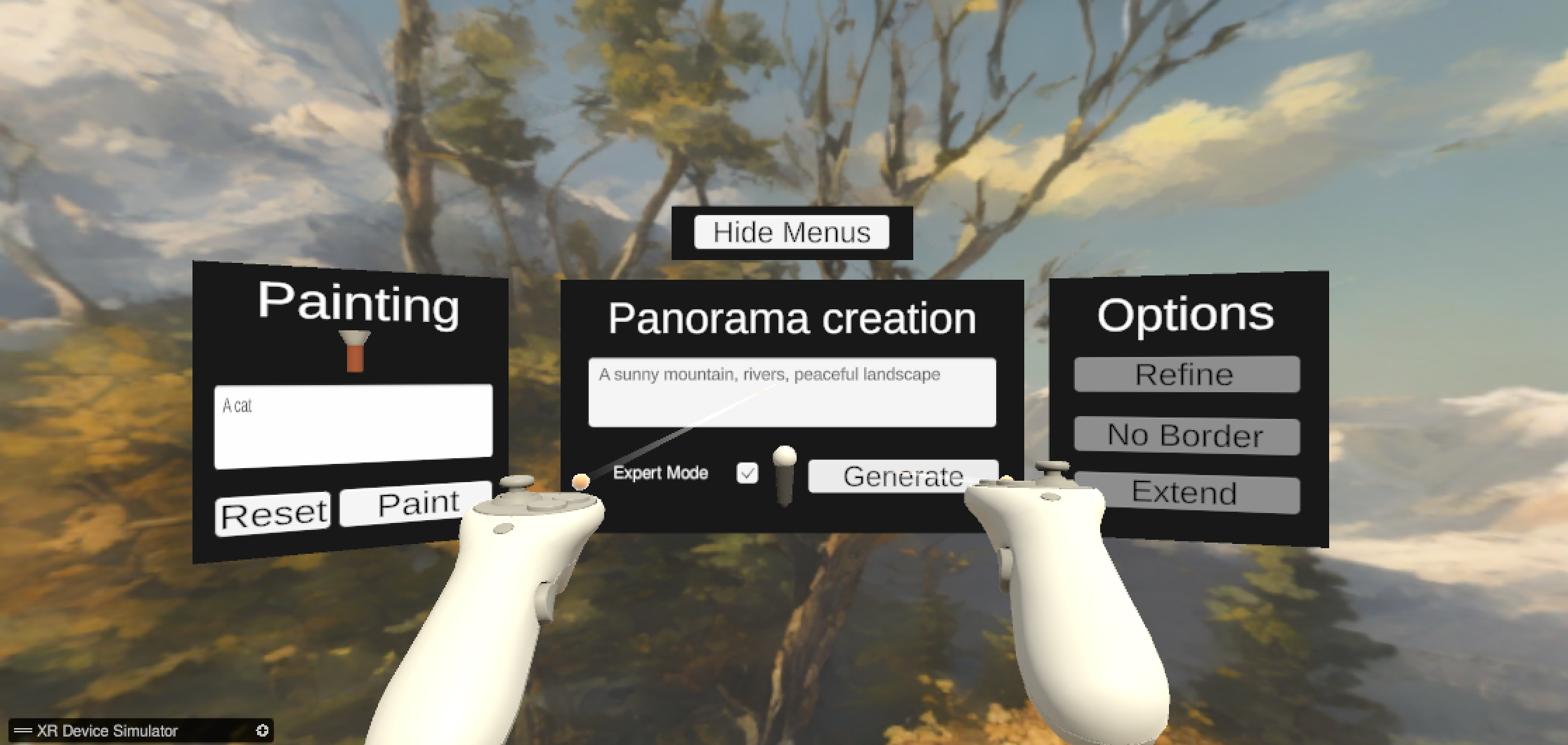

Dieses Unity-Projekt ist ein Client zum Generieren, Ändern und Erkunden von Umgebungen, die von KI anhand von Sprachanweisungen generiert werden.

Es verfügt über zwei Hauptszenen, eine für den Desktop und eine für die virtuelle Realität, die es Ihnen ermöglichen, neue Welten zu erkunden. Die Idee dieses Projekts besteht darin, Ihnen den Zugriff auf alle KI-Funktionen einer Anwendung zu ermöglichen und so die Unterbrechungen im Erstellungsprozess zu reduzieren.

Das Projekt wurde am Fondation Campus Biotech Geneva (GitHub) in Zusammenarbeit mit dem Laboratory of Cognitive Science (Teil des EPLF) entwickelt.

Die Installation ist einfach, da wir Standard-Unity-Funktionen verwenden. Hier ist die ausführliche Anleitung.

Die meisten mit OpenXR kompatiblen VR-Headsets sollten sofort funktionieren. Das Projekt wurde mit dem HP Reverb G2 (einem Windows Mixed Reality Headset) entwickelt.

Wichtig

Dies ist nur der Client. Sie benötigen einen laufenden Server, um die KI-Funktionen tatsächlich nutzen zu können! Das Repository zum Ausführen des Servers finden Sie unter: VR-Environment-GenAI-Server.

Dieses Unity-Projekt enthält eine Szene, die von einer KI anhand einer Texteingabe generiert wurde. Die Szene wird dynamisch basierend auf dem Eingabetext erstellt und ermöglicht die Generierung einzigartiger und kreativer Umgebungen.

So generieren Sie eine Szene:

Für ein reibungsloses Erlebnis müssen Sie möglicherweise einige Konfigurationsparameter festlegen. Die meisten Konfigurationsparameter befinden sich unter Assets/Configurations/api.json .

Falls Sie das Projekt lokal VR und AI auf demselben Computer ausführen (die „Debug“-Konfiguration), sollten Sie Folgendes festlegen.

pythonFallbackApiFile : Dateipfad zur Python-Datei api.json . Diese Datei sollte sich im Stammordner des Python-Projekts befinden.Wenn Sie eine Verbindung zu einem Remote-Server herstellen möchten, müssen Sie folgende wichtige Funktionen festlegen:

serverDefaultIp : die IP, um den AI-Server zu erreichen (IPv4 bevorzugt).serverDefaultPort : Standardportnummer des Servers.Hinweis: Wenn sowohl der Server als auch die Fallback-API-Datei korrekt angegeben sind, wird der Server ignoriert und die Verbindung ist lokal. Sie können den Pfad der Fallback-API-Datei durch einen beliebigen falschen Pfad ersetzen, um dieses Verhalten zu verhindern.

Einige Optionen gelten als veraltet und werden für die Kommunikation auf demselben Dateispeicher verwendet. Sie können angeben, wo Python die Dateien speichern soll. Temporäre Speicherorte sind besser.

audioPath : Der Pfad zur temporären Audiodatei, die bei Verwendung der Speech-to-Text-Funktion gespeichert werden soll.baseImage : der Pfad zur Textur , die geändert werden soll .maskPath : Der Pfad zur temporären Maskentextur, die während der Inpainting-Funktion verwendet wird. Die Hauptmerkmale dieses Projekts sind:

Alle folgenden Szenen befinden sich im Ordner Assets/Scenes .

Die anderen Szenen dienen Testzwecken:

Wir stellen eine Online-Dokumentation zur Verfügung, Sie können diese auch im Ordner docs/ abrufen.

Die Dokumentation wird mit DocFX generiert, Sie können sie mit DocFX neu generieren.

cp README.md Documentation/index.md

# Option 1: Offline, static documentation

docfx Documentation/docfx.json -t statictoc,custom_template

# Option 2: on a web server

docfx Documentation/docfx.json Beide Befehle erzeugen eine Dokumentation unter docs/ .

Dieses Projekt ermöglicht den Import benutzerdefinierter Skyboxen.

Die Skybox wird automatisch in die Szene importiert, wenn der Spieler die Eingabetaste drückt.

Starten Sie die Szene:

Als kleines Bonus-Feature beinhaltet dieses Projekt ein kleines Atemexperiment zur Meditation.

So starten Sie das Atemexperiment:

Das aktive öffentliche Repository für dieses Projekt finden Sie unter: https://github.com/HugoFara/speech-to-world-unity-client

Für den offiziellen öffentlichen KI-Server: https://github.com/fcbg-hnp-vr/VR-Environment-GenAI-Server.