onnx-web

onnx-web wurde entwickelt, um den Prozess der Ausführung von Stable Diffusion und anderen ONNX-Modellen zu vereinfachen, sodass Sie sich auf die Erstellung hochwertiger, hochauflösender Kunst konzentrieren können. Mit der Effizienz der Hardwarebeschleunigung auf AMD- und Nvidia-GPUs und einem zuverlässigen CPU-Software-Fallback bietet es den vollen Funktionsumfang auf Desktops, Laptops und Multi-GPU-Servern mit einem nahtlosen Benutzererlebnis.

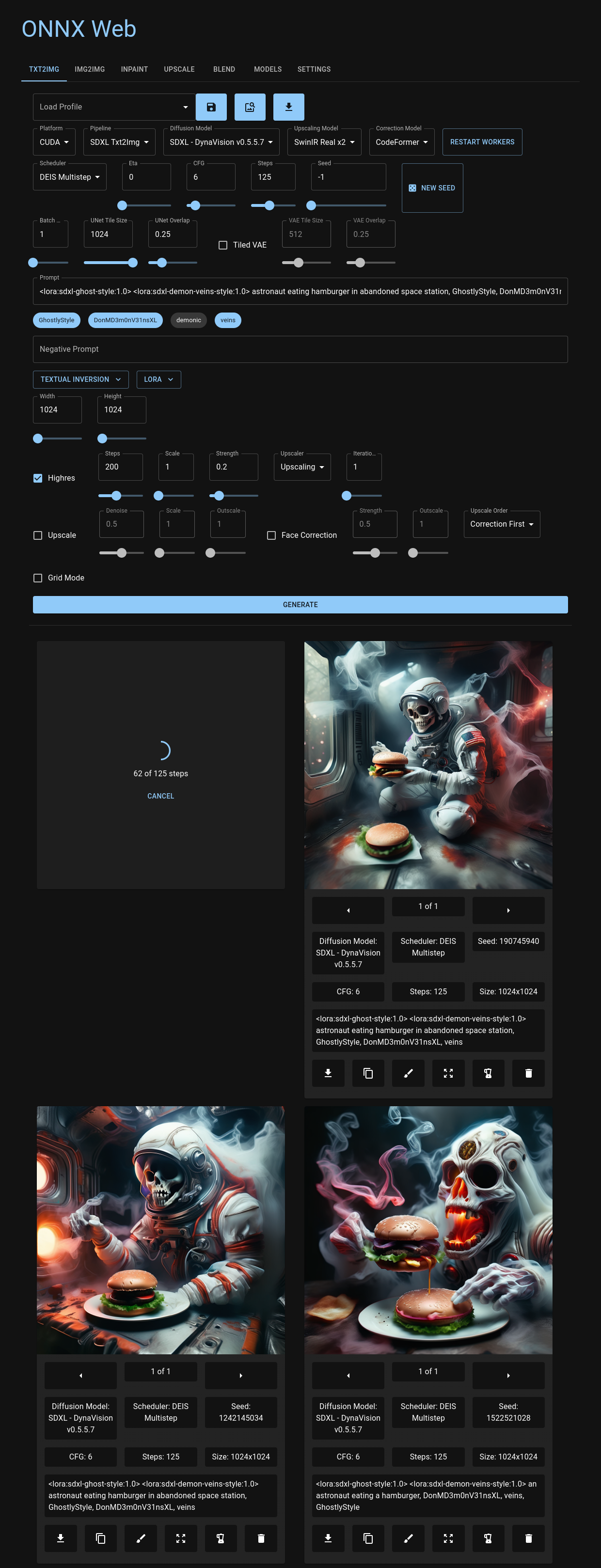

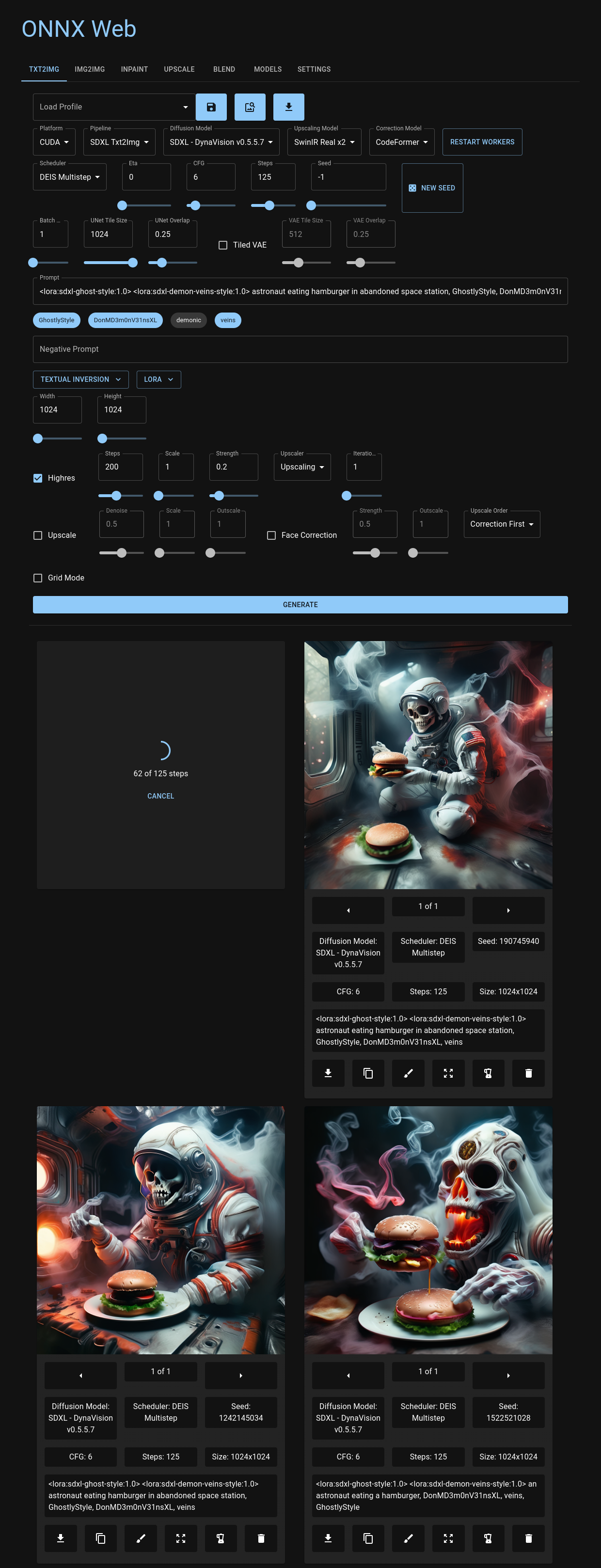

Sie können durch die benutzerfreundliche Web-Benutzeroberfläche navigieren, die auf Github-Seiten gehostet wird und über alle gängigen Browser zugänglich ist, einschließlich Ihres bevorzugten Mobilgeräts. Hier haben Sie die Flexibilität, Diffusionsmodelle und Beschleuniger für jede Bildpipeline auszuwählen und haben einfachen Zugriff auf die Bildparameter, die die einzelnen Modi definieren. Ganz gleich, ob Sie Bilder hochladen oder Ihre künstlerische Note durch Inpainting und Outpainting zum Ausdruck bringen, onnx-web bietet eine ebenso benutzerfreundliche wie leistungsstarke Umgebung. Aktuelle Ausgabebilder werden übersichtlich unter den Steuerelementen angezeigt und dienen als praktische visuelle Referenz, um frühere Parameter noch einmal zu überprüfen oder Ihre früheren Ausgaben neu zu mischen.

Tauchen Sie mit der API, die sowohl mit Linux als auch Windows kompatibel ist, tiefer in das Onnx-Web-Erlebnis ein. Diese RESTful-Schnittstelle integriert nahtlos verschiedene Pipelines aus der HuggingFace-Diffusor-Bibliothek und bietet wertvolle Metadaten zu Modellen und Beschleunigern sowie detaillierte Ausgaben Ihrer kreativen Läufe.

Begeben Sie sich mit onnx-web auf Ihre generative Kunstreise und erkunden Sie seine Möglichkeiten auf unserer detaillierten Dokumentationsseite. Hier finden Sie eine umfassende Anleitung für die ersten Schritte, eine Einrichtungsanleitung und ein Benutzerhandbuch, die Sie bei Ihren kreativen Unternehmungen unterstützen!

Weitere Informationen finden Sie auf der Dokumentationsseite:

- Leitfaden für den Einstieg

- Setup-Anleitung

- Bedienungsanleitung

Merkmale

Dies ist eine unvollständige Liste neuer und interessanter Funktionen:

- unterstützt SDXL und SDXL Turbo

- Große Auswahl an Schedulern: DDIM, DEIS, DPM SDE, Euler Ancestral, LCM, UniPC und mehr

- Hardwarebeschleunigung sowohl auf AMD als auch auf Nvidia

- Getestet auf CUDA, DirectML und ROCm

- Halbpräzisionsunterstützung für GPUs mit wenig Speicher sowohl auf AMD als auch auf Nvidia

- Software-Fallback für reine CPU-Systeme

- Web-App zum Generieren und Anzeigen von Bildern

- gehostet auf Github-Seiten, von Ihrem CDN oder lokal

- Behält Ihre letzten Bilder und den Fortschritt beim Wechseln der Registerkarten bei

- Mehrere Bilder in die Warteschlange stellen und Fehler wiederholen

- Übersetzungen verfügbar für Englisch, Französisch, Deutsch und Spanisch (für weitere Informationen öffnen Sie bitte eine Ausgabe)

- unterstützt viele

diffusers Pipelines- txt2img

- img2img

- Inpainting, mit Maskenzeichnung und Upload

- Panorama, sowohl für SD v1.5 als auch für SDXL

- Hochskalierung mit ONNX-Beschleunigung

- Fügen Sie Ihre eigenen Modelle hinzu und verwenden Sie sie

- Konvertieren Sie Modelle von Diffusoren und SD-Kontrollpunkten

- Laden Sie Modelle vom HuggingFace-Hub, Civitai und HTTPS-Quellen herunter

- weitere Netzwerke einbinden

- permanentes und zeitnahes Mischen

- unterstützt LoRA- und LyCORIS-Gewichte

- unterstützt Textinversionskonzepte und -einbettungen

- Jede Schicht der Einbettungen kann einzeln gesteuert und verwendet werden

- ControlNet

- Bildfilter zur Kantenerkennung und andere Methoden

- mit ONNX-Beschleunigung

- hochauflösender Modus

- führt img2img auf den Ergebnissen der anderen Pipelines aus

- Mehrere Iterationen können 8K-Bilder und mehr erzeugen

- mehrstufige und regionale Eingabeaufforderungen

- Kombinieren Sie mehrere Eingabeaufforderungen nahtlos im selben Bild

- Geben Sie Eingabeaufforderungen für verschiedene Bereiche im Bild ein und verschmelzen Sie diese miteinander

- Ändern Sie die Eingabeaufforderung für den hochauflösenden Modus und verfeinern Sie Details ohne Rekursion

- unendliche Eingabeaufforderungslänge

- mit langer prompter Gewichtung

- Bildüberblendungsmodus

- Kombinieren Sie Bilder aus der Geschichte

- Hochskalierung und Korrektur

- Hochskalierung mit Real ESRGAN, SwinIR und Stable Diffusion

- Gesichtskorrektur mit CodeFormer und GFPGAN

- Der API-Server kann remote ausgeführt werden

- Die REST-API kann über HTTPS oder HTTP bereitgestellt werden

- Hintergrundverarbeitung für alle Bildpipelines

- Abfrage des Bildstatus, funktioniert gut mit Load Balancern

- OCI-Container bereitgestellt

- für alle unterstützten Hardwarebeschleuniger

- Enthält sowohl das API- als auch das GUI-Bundle in einem einzigen Container

- läuft gut auf RunPod, Vast.ai und anderen GPU-Container-Hosting-Diensten

Inhalt

- onnx-web

- Merkmale

- Inhalt

- Aufstellen

- Hinzufügen eigener Modelle

- Verwendung

- Bekannte Fehler und Lösungen

- Ausführen der Container

- Credits

Aufstellen

Es gibt mehrere Möglichkeiten, onnx-web auszuführen:

- plattformübergreifend:

- Klonen Sie dieses Repository, erstellen Sie eine virtuelle Umgebung und führen Sie

pip install aus - Ziehen und Ausführen der OCI-Container

- unter Windows:

- Klonen Sie dieses Repository und führen Sie eines der

setup-*.bat Skripte aus - Laden Sie das experimentelle All-in-One-Paket herunter und führen Sie es aus

Sie müssen nur den Server ausführen und sollten nichts kompilieren müssen. Die Client-GUI wird auf Github Pages gehostet und ist im Windows-All-in-One-Bundle enthalten.

Die erweiterten Setup-Dokumente wurden in den Setup-Leitfaden verschoben.

Hinzufügen eigener Modelle

Sie können Ihre eigenen Modelle hinzufügen, indem Sie sie vom HuggingFace Hub oder Civitai herunterladen oder aus lokalen Dateien konvertieren, ohne Codeänderungen vorzunehmen. Sie können auch zusätzliche Netzwerke wie LoRAs und Textual Inversions herunterladen und integrieren, indem Sie Token in der Eingabeaufforderung verwenden.

Verwendung

Bekannte Fehler und Lösungen

Bitte lesen Sie den Abschnitt „Bekannte Fehler“ im Benutzerhandbuch.

Ausführen der Container

Dies wurde in den Server-Administratorleitfaden verschoben.

Credits

Ein Teil des Konvertierungs- und Pipeline-Codes wurde kopiert oder von Code abgeleitet in:

-

Amblyopius/Stable-Diffusion-ONNX-FP16- GPL v3: https://github.com/Amblyopius/Stable-Diffusion-ONNX-FP16/blob/main/LICENSE

- https://github.com/Amblyopius/Stable-Diffusion-ONNX-FP16/blob/main/pipeline_onnx_stable_diffusion_controlnet.py

- https://github.com/Amblyopius/Stable-Diffusion-ONNX-FP16/blob/main/pipeline_onnx_stable_diffusion_instruct_pix2pix.py

-

d8ahazard/sd_dreambooth_extension- Nichtkommerzielle Lizenz: https://github.com/d8ahazard/sd_dreambooth_extension/blob/main/license.md

- https://github.com/d8ahazard/sd_dreambooth_extension/blob/main/dreambooth/sd_to_diff.py

-

huggingface/diffusers- Apache v2: https://github.com/huggingface/diffusers/blob/main/LICENSE

- https://github.com/huggingface/diffusers/blob/main/scripts/convert_stable_diffusion_checkpoint_to_onnx.py

-

uchuusen/onnx_stable_diffusion_controlnet- GPL v3: https://github.com/uchuusen/onnx_stable_diffusion_controlnet/blob/main/LICENSE

-

uchuusen/pipeline_onnx_stable_diffusion_instruct_pix2pix- Apache v2: https://github.com/uchuusen/pipeline_onnx_stable_diffusion_instruct_pix2pix/blob/main/LICENSE

Für diese Teile gelten eigene Lizenzen mit zusätzlichen Einschränkungen hinsichtlich der kommerziellen Nutzung, Änderung und Weiterverbreitung. Der Rest des Projekts steht unter der MIT-Lizenz und ich arbeite daran, diese Komponenten in einer Bibliothek zu isolieren.

Es gibt viele andere gute Optionen für die Verwendung von Stable Diffusion mit Hardwarebeschleunigung, darunter:

- https://github.com/Amblyopius/AMD-Stable-Diffusion-ONNX-FP16

- https://github.com/azuritecoin/OnnxDiffusersUI

- https://github.com/ForserX/StableDiffusionUI

- https://github.com/pingzing/stable-diffusion-playground

- https://github.com/quickwick/stable-diffusion-win-amd-ui

Ohne Anleitungen von: wäre es nicht möglich gewesen, dies auf AMD einzurichten und zum Laufen zu bringen:

- https://gist.github.com/harishanand95/75f4515e6187a6aa3261af6ac6f61269

- https://gist.github.com/averad/256c507baa3dcc9464203dc14610d674

- https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Install-and-Run-on-AMD-GPUs

- https://www.travelneil.com/stable-diffusion-updates.html