Bitte markieren Sie CoDA und teilen Sie es. Danke

[Papier] [Projektseite]

Yang Cao, Yihan Zeng, Hang Xu, Dan Xu

Die Universität für Wissenschaft und Technologie Hongkong

Huawei Noahs Arche Labor

Aktualisierungen

☑ Als erste Arbeit, die 3D-Gaußsches Splatting in die 3D-Objekterkennung einführt, wird 3DGS-DET hier veröffentlicht!

☑ Unser erweitertes Werk CoDAv2 ist veröffentlicht, schauen Sie es sich auf arXiv an!

☑ Hier werden die neuesten Artikel und Codes zur Wahrnehmung des offenen Vokabulars gesammelt.

☑ Alle Codes, Daten und vorab trainierten Modelle wurden veröffentlicht!

☑ Die Schulungs- und Testcodes wurden veröffentlicht.

☑ Die vorab trainierten Modelle wurden veröffentlicht.

☑ Die OV-Einstellung SUN-RGBD-Datensätze wurden veröffentlicht.

☑ Die ScanNet-Datensätze mit OV-Einstellung wurden veröffentlicht.

☑ Paper-LaTeX-Codes sind unter https://scienhub.com/Yang/CoDA verfügbar.

Unser Code basiert auf PyTorch 1.8.1, Torchvision==0.9.1, CUDA 10.1 und Python 3.7. Möglicherweise funktioniert es auch mit anderen Versionen.

Bitte installieren Sie auch die folgenden Python-Abhängigkeiten:

matplotlib

opencv-python

plyfile

'trimesh>=2.35.39,<2.35.40'

'networkx>=2.2,<2.3'

scipy

Bitte installieren Sie pointnet2 Layer durch Ausführen

cd third_party/pointnet2 && python setup.py install

Bitte installieren Sie eine Cythonisierte Implementierung von gIOU für ein schnelleres Training.

conda install cython

cd utils && python cython_compile.py build_ext --inplace

Um die OV-Einstellung zu erreichen, organisieren wir das ursprüngliche ScanNet und SUN RGB-D neu und übernehmen Anmerkungen weiterer Kategorien. Bitte laden Sie die hier bereitgestellten OV-Einstellungsdatensätze direkt herunter: OV SUN RGB-D und OV ScanNet. Sie können sie auch einfach herunterladen, indem Sie Folgendes ausführen:

bash data_download.sh

Führen Sie dann die heruntergeladene *.tar-Datei aus:

bash data_preparation.sh

Laden Sie hier die vorab trainierten Modelle herunter. Führen Sie dann Folgendes aus:

bash test_release_models.sh

bash scripts/coda_sunrgbd_stage1.sh

bash scripts/coda_sunrgbd_stage2.sh

bash run_samples.sh

Wenn CoDA hilfreich ist, geben Sie bitte Folgendes an:

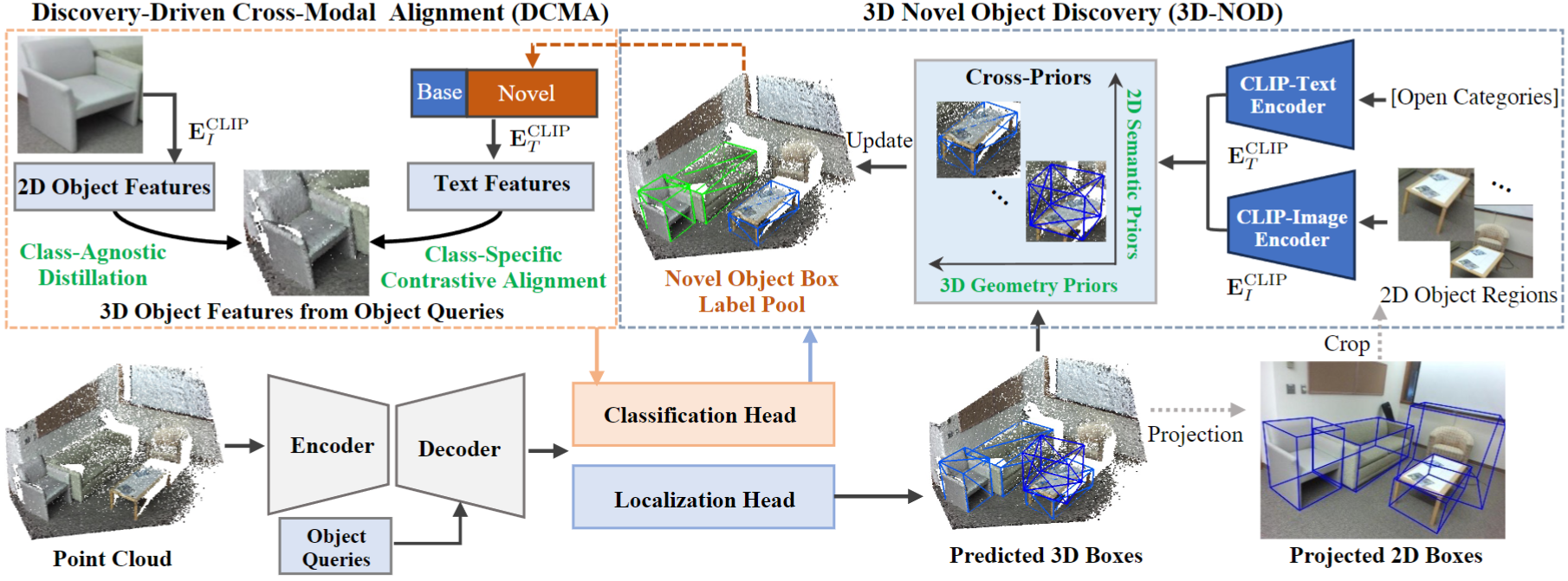

@inproceedings{cao2023coda,

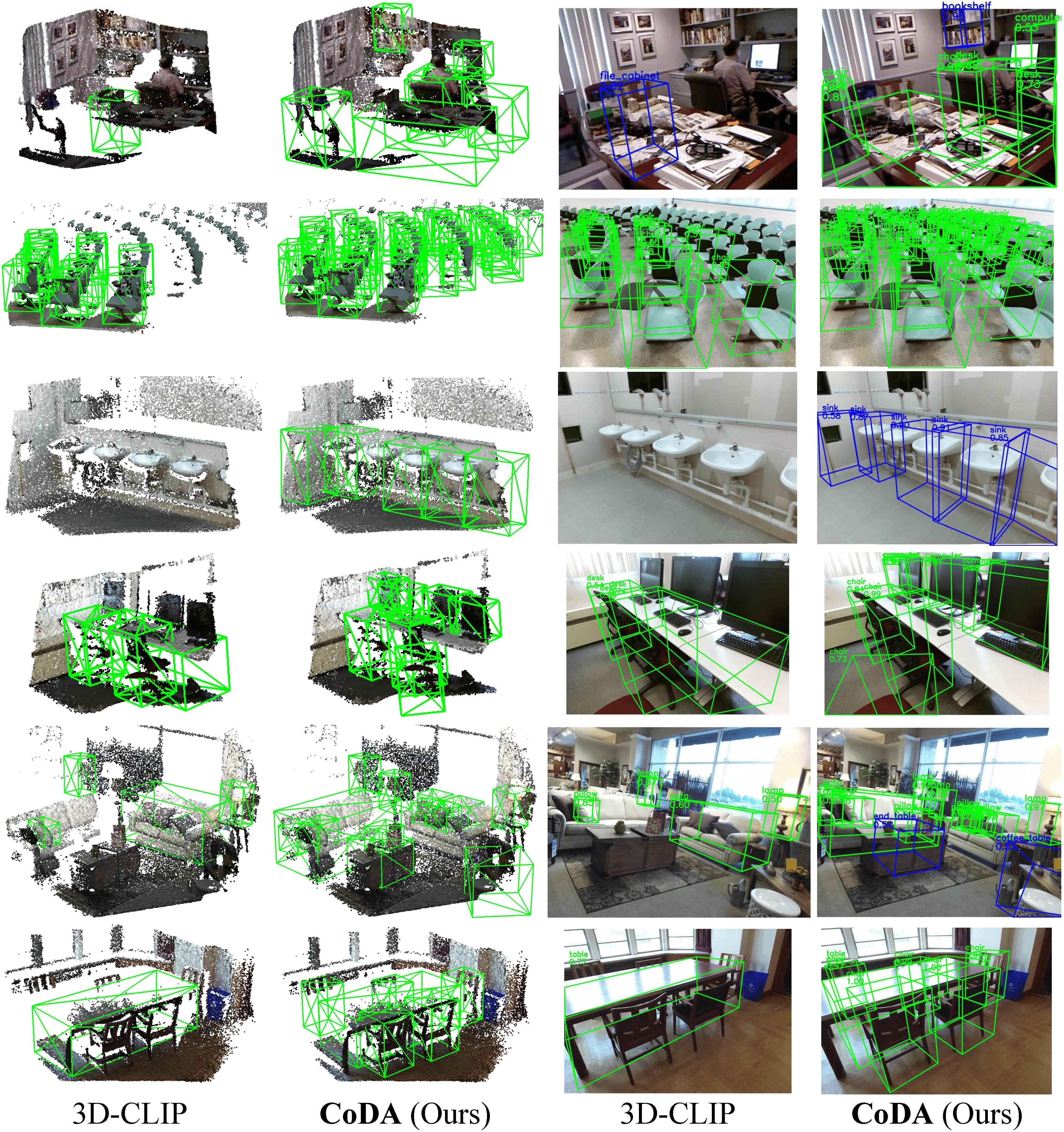

title={CoDA: Collaborative Novel Box Discovery and Cross-modal Alignment for Open-vocabulary 3D Object Detection},

author={Cao, Yang and Zeng, Yihan and Xu, Hang and Xu, Dan},

booktitle={NeurIPS},

year={2023}

}

@misc{cao2024collaborative,

title={Collaborative Novel Object Discovery and Box-Guided Cross-Modal Alignment for Open-Vocabulary 3D Object Detection},

author={Yang Cao and Yihan Zeng and Hang Xu and Dan Xu},

year={2024},

eprint={2406.00830},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2406.00830},

}

Wenn Sie Fragen haben oder eine Zusammenarbeit benötigen (Forschungszwecke oder kommerzielle Zwecke), senden Sie bitte eine E-Mail an [email protected] .

CoDA ist von CLIP und 3DETR inspiriert. Wir schätzen ihre tollen Codes.