Diese Aktion überwacht Kommentare zu Problemen und an Anfragen und erinnert den Absender daran, ob eine beleidigende Sprache gefunden wird.

Erstellen Sie die folgende Workflow-Datei mind-your-language.yml im .github/workflows/ Verzeichnis Ihres Repositorys:

name : Mind your language

on :

issues :

types :

- opened

- edited

issue_comment :

types :

- created

- edited

pull_request_review_comment :

types :

- created

- edited

jobs :

echo_issue_comment :

runs-on : ubuntu-latest

name : profanity check

steps :

- name : Checkout

uses : actions/checkout@v2

- name : Profanity check step

uses : tailaiw/[email protected]

env :

GITHUB_TOKEN : ${{ secrets.GITHUB_TOKEN }} Immer wenn ein Kommentar zu einer Ausgabe oder einer Anfrage erstellt wird, führt der Arbeitsablauf die Überprüfung der Obszönität gegen den Kommentartext durch und reagiert, wenn eine anstößige Sprache gefunden wird.

Ich verwende derzeit Profanity-Check, ein Python-Paket von Profanitätserkennung, die auf maschinellem Lernen basieren, um festzustellen, ob ein Kommentar beleidigend ist oder nicht. Es ist nicht super mächtig, ist aber empfindlich für eine offensichtliche Offensivsprache. Ich hoffe, ich kann einige hochmoderne NLP-Algorithmen verwenden, um eine bessere Leistung zu erzielen. Ich werde bald ein separates Repo erstellen, um bessere Alternativen zu verfolgen. Wenn Sie daran interessiert sind, bleiben Sie dran.

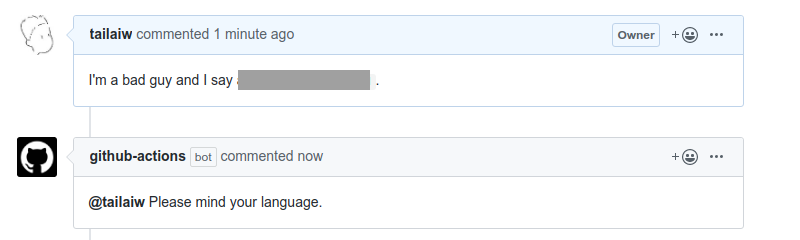

Die Reaktion ist derzeit ein automatisches Bot von Github-Actions, der den Absender eines offensiven Kommentars erwähnt. Siehe das Beispiel wie folgt.

Ich bin ein neuer Entwickler von Github Action, daher sind Vorschlag und Hilfe mehr als willkommen. Natürlich "Machen Sie sich Ihre Sprache"?