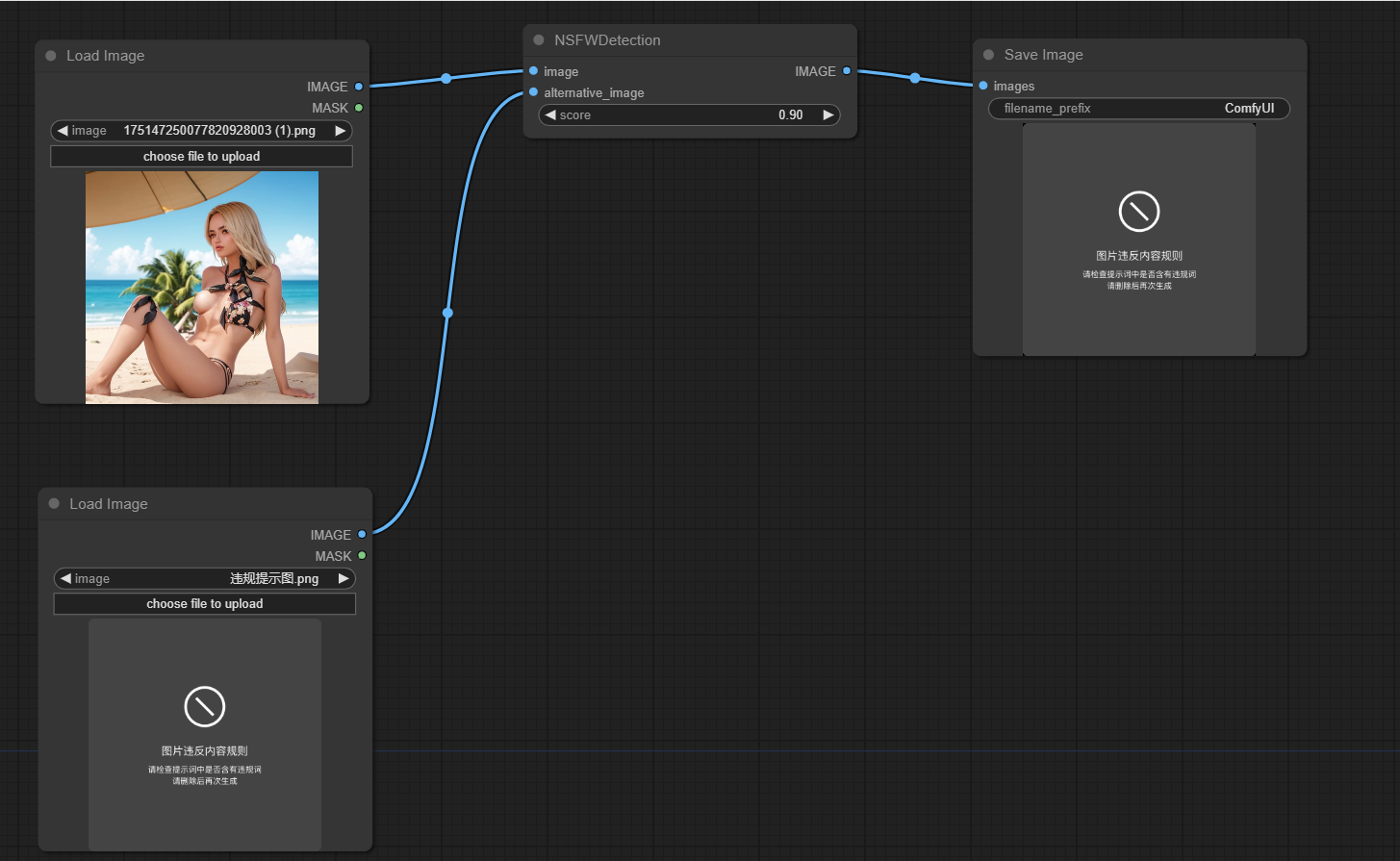

Dieses Projekt soll feststellen, ob von Comfyui generierte Bilder nicht sicher für die Arbeit sind (NSFW). Es verwendet ein maschinelles Lernmodell, um Bilder als sicher oder nicht sicher für die Arbeit zu klassifizieren. Wenn ein Bild als NSFW klassifiziert wird, wird ein alternatives Bild zurückgegeben.

Klonen Sie dieses Repo in Custom_Nodes -Verzeichnis des bequemen Standorts

PIP install install -r requires.txt ausführen

Die Hauptfunktionalität des Projekts ist in der NSFWDetection -Klasse in der Datei node.py eingekapselt. Diese Klasse hat eine run -Methode, die drei Parameter benötigt:

image : Das zu klassifizierende Bild.score : Der Schwellenwert zur Klassifizierung eines Bildes als NSFW.alternative_image : Das zu zurückgegebene Bild, wenn das Eingabebild als NSFW klassifiziert wird.

https://github.com/trumanwong/comfyui-nsfw-detction/blob/main/workflow.json

Beiträge sind willkommen. Bitte senden Sie eine Pull -Anfrage, wenn Sie Verbesserungen oder Fehlerbehebungen haben.

Dieses Projekt ist gemäß den Bedingungen der MIT -Lizenz lizenziert.