Obtener ayuda - Preguntas frecuentes Discusiones Sitio web de documentación de Discord

¿Hoja de ruta de modelos de inicio rápido? ¿Demostración? ¿Explorador? Ejemplos

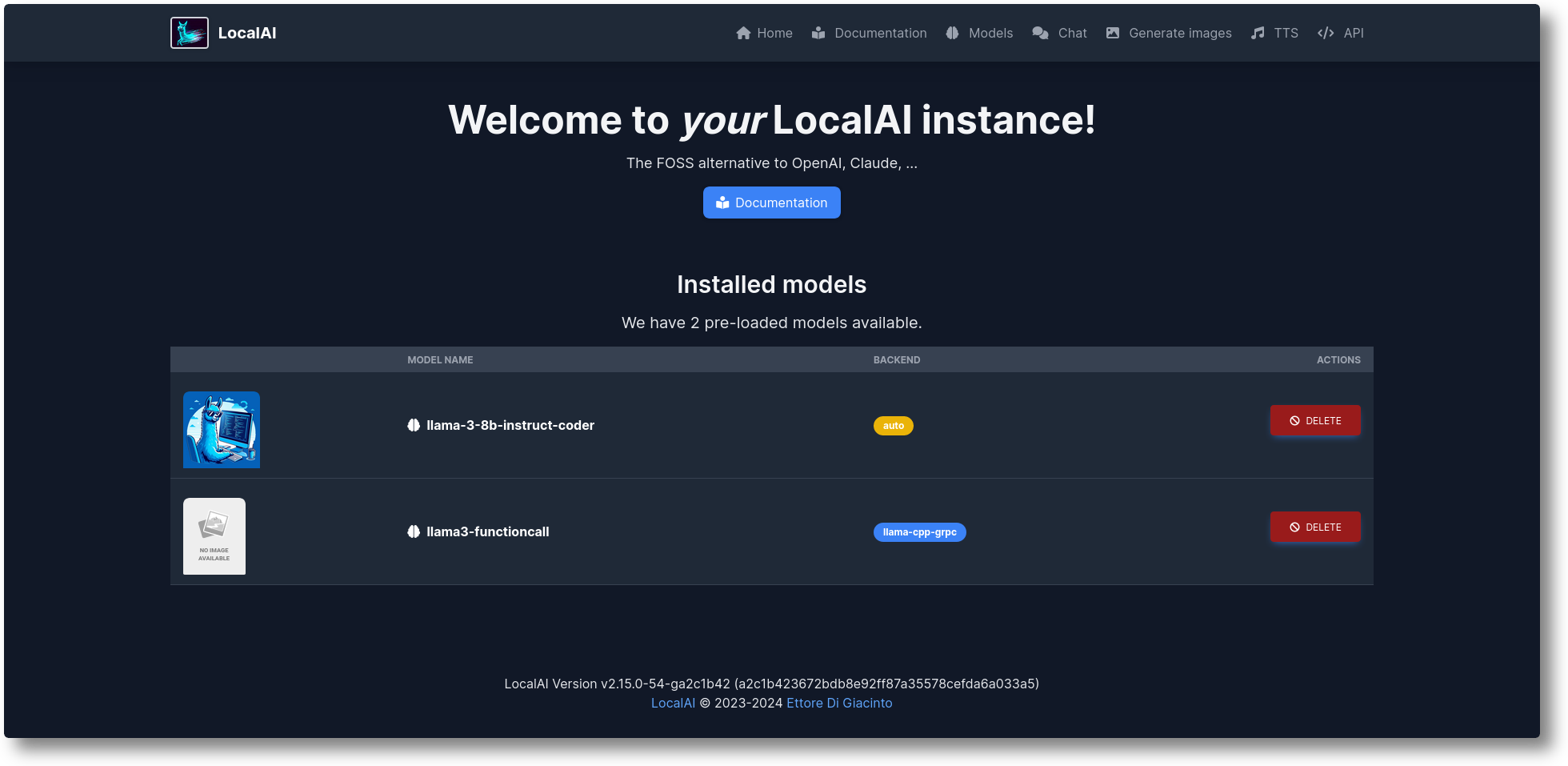

LocalAI es la alternativa gratuita y de código abierto de OpenAI. LocalAI actúa como una API REST de reemplazo directo que es compatible con las especificaciones de API de OpenAI (Elevenlabs, Anthropic...) para la inferencia de IA local. Le permite ejecutar LLM, generar imágenes y audio (y no solo) localmente o en las instalaciones con hardware de consumo, compatible con múltiples familias de modelos. No requiere GPU. Es creado y mantenido por Ettore Di Giacinto.

Ejecute el script del instalador:

rizo https://localai.io/install.sh | sh

O ejecutar con Docker:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu# Imágenes alternativas:# - si tienes una GPU Nvidia:# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12# - sin modelos preconfigurados# docker run -ti --name local-ai -p 8080:8080 localai/localai:latest# - sin modelos preconfigurados para GPU Nvidia# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia -cuda-12

Para cargar modelos:

# Desde la galería de modelos (consulte los modelos disponibles con `local-ai models list`, en la WebUI desde la pestaña de modelos, o visitando https://models.localai.io)local-ai ejecuta llama-3.2-1b-instruct: q4_k_m# Inicie LocalAI con el modelo phi-2 directamente desde huggingfacelocal-ai ejecute huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf# Instale y ejecute un modelo desde Ollama OCI registrolocal-ai run ollama://gemma:2b# Ejecute un modelo desde un archivo de configuraciónlocal-ai run https://gist.githubusercontent.com/.../phi-2.yaml# Instale y ejecute un modelo desde un registro OCI estándar (por ejemplo, Docker Hub)local-ai run oci://localai/phi-2:latest

Empezando

Octubre de 2024: ejemplos trasladados a ejemplos de LocalAI

Agosto de 2024: ? FLUX-1, Explorador P2P

Julio de 2024: ? Panel P2P, modo federado LocalAI y enjambres de IA: #2723

Junio de 2024: ? ¡Puedes navegar ahora por la galería de modelos sin LocalAI! Consulte https://models.localai.io

Junio de 2024: compatibilidad con modelos de registros OCI: n.º 2628

Mayo de 2024: P2P descentralizado llama.cpp: #2343 (¡peer2peer llama.cpp!) Docs https://localai.io/features/distribute/

Mayo de 2024: Voz abierta: #2334

Mayo de 2024: ? Llamadas a funciones sin gramáticas y modo mixto: #2328

Mayo de 2024: inferencia distribuida: n.º 2324

Mayo de 2024: Chat, TTS y generación de imágenes en WebUI: #2222

Abril de 2024: API de reranker: n.º 2121

Elementos de la hoja de ruta: lista de cuestiones

Multimodal con vLLM y comprensión de vídeo: #3729

API en tiempo real #3714

Grupos comunitarios distribuidos, P2P Global: #3113

Mejoras en la interfaz de usuario web: #2156

Servidores v2: #1126

Mejora de UX v2: #1373

API asistente: #1273

Punto final de moderación: #999

Vulcano: #1647

API antrópica: #1808

Si desea ayudar y contribuir, temas disponibles: https://github.com/mudler/LocalAI/issues?q=is%3Aissue+is%3Aopen+label%3A%22up+for+grabs%22

Generación de texto con GPT ( llama.cpp , gpt4all.cpp , ... y más)

Texto a audio

Audio a texto (transcripción de audio con whisper.cpp )

Generación de imágenes con difusión estable.

API de herramientas similares a OpenAI

Generación de incrustaciones para bases de datos vectoriales.

Gramáticas restringidas

Descargar modelos directamente desde Huggingface

API de visión

API de reclasificación

Inferencia P2P

WebUI integrada!

Consulte la sección Primeros pasos en nuestra documentación.

Cree e implemente contenedores personalizados:

https://github.com/sozercan/aikit

UI web:

https://github.com/Jirubizu/localai-admin

https://github.com/go-skynet/LocalAI-frontend

QA-Pilot (un proyecto de chat interactivo que aprovecha los LLM de LocalAI para una rápida comprensión y navegación del repositorio de código de GitHub) https://github.com/reid41/QA-Pilot

Galerías de modelos

https://github.com/go-skynet/model-gallery

Otro:

Gráfico de timón https://github.com/go-skynet/helm-charts

Extensión VSCode https://github.com/badgooooor/localai-vscode-plugin

Utilidad de terminal https://github.com/djcopley/ShellOracle

Asistente local inteligente https://github.com/mudler/LocalAGI

Asistente de inicio https://github.com/sammcj/homeassistant-localai / https://github.com/drndos/hass-openai-custom-conversation / https://github.com/valentinfrlch/ha-gpt4vision

Bot de discordia https://github.com/mudler/LocalAGI/tree/main/examples/discord

Bot flojo https://github.com/mudler/LocalAGI/tree/main/examples/slack

Shell-Pilot (interactúe con LLM utilizando modelos LocalAI a través de scripts de shell puros en su sistema Linux o MacOS) https://github.com/reid41/shell-pilot

Bot de Telegram https://github.com/mudler/LocalAI/tree/master/examples/telegram-bot

Acciones de Github: https://github.com/marketplace/actions/start-localai

Ejemplos: https://github.com/mudler/LocalAI/tree/master/examples/

Guía de ajuste de LLM

Cómo construir localmente

Cómo instalar en Kubernetes

Proyectos que integran LocalAI

Sección de instrucciones (curada por nuestra comunidad)

Ejecute el código de Visual Studio con LocalAI (SUSE)

Ejecute LocalAI en Jetson Nano Devkit

Ejecute LocalAI en AWS EKS con Pulumi

Ejecute LocalAI en AWS

Cree un slackbot para equipos y proyectos OSS que responda a la documentación

LocalAI se encuentra con k8sgpt

Respuesta a preguntas sobre documentos localmente con LangChain, LocalAI, Chroma y GPT4All

Tutorial para usar k8sgpt con LocalAI

Si utiliza este repositorio de datos en un proyecto posterior, considere citarlo con:

@misc{localai,

author = {Ettore Di Giacinto},

title = {LocalAI: The free, Open source OpenAI alternative},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/go-skynet/LocalAI}},¿Considera útil LocalAI?

Apoya el proyecto convirtiéndote en patrocinador o patrocinador. Su logotipo aparecerá aquí con un enlace a su sitio web.

Un enorme agradecimiento a nuestros generosos patrocinadores que apoyan este proyecto cubriendo los gastos de CI y a nuestra lista de patrocinadores:

LocalAI es un proyecto impulsado por la comunidad creado por Ettore Di Giacinto.

MIT - Autor Ettore Di Giacinto [email protected]

LocalAI no podría haberse creado sin la ayuda del excelente software que ya está disponible en la comunidad. ¡Gracias!

llama.cpp

https://github.com/tatsu-lab/stanford_alpaca

https://github.com/cornelk/llama-go para las ideas iniciales

https://github.com/antimatter15/alpaca.cpp

https://github.com/EdVince/Stable-Diffusion-NCNN

https://github.com/ggerganov/whisper.cpp

https://github.com/saharNooby/rwkv.cpp

https://github.com/rhasspy/piper

Este es un proyecto comunitario, ¡un agradecimiento especial a nuestros contribuyentes! ?