Impresionante encuesta AGI

Artículos de lectura obligada sobre Inteligencia General Artificial

? Noticias

- [2024-10] ? Nuestro artículo fue aceptado por TMLR 2024.

- [2024-05] ? Estamos organizando un taller sobre AGI en ICLR 2024 y hemos publicado nuestro documento de posición, "¿Qué tan lejos estamos de AGI?".

Nuestro proyecto es una iniciativa abierta y en curso que evolucionará en paralelo con los avances en AGI. Agradecemos calurosamente los comentarios y solicitudes de la comunidad y planeamos actualizar nuestro documento anualmente. Los contribuyentes en el sitio web del proyecto serán agradecidos en futuras revisiones.

Cita de BibTex si encuentra útil nuestro trabajo/recursos:

@article { feng2024far ,

title = { How Far Are We From AGI } ,

author = { Feng, Tao and Jin, Chuanyang and Liu, Jingyu and Zhu, Kunlun and Tu, Haoqin and Cheng, Zirui and Lin, Guanyu and You, Jiaxuan } ,

journal = { arXiv preprint arXiv:2405.10313 } ,

year = { 2024 }

} Contenido

- Contenido

- 1. Introducción

- 2. AGI Internal: Revelando la mente de AGI

- 2.1 Percepción de la IA

- 2.2 Razonamiento de la IA

- 2.3 Memoria de IA

- 2.4 Metacognición de la IA

- 3. Interfaz AGI: Conectando el mundo con AGI

- 3.1 Interfaces de IA con el mundo digital

- 3.2 Interfaces de IA con el mundo físico

- 3.3 Interfaces de IA con inteligencia

- 3.3.1 Interfaces de IA con agentes de IA

- 3.3.2 Interfaces de IA con humanos

- 4. Sistemas AGI: Implementación del mecanismo de AGI

- 4.2 Arquitecturas de modelos escalables

- 4.3 Capacitación a gran escala

- 4.4 Técnicas de inferencia

- 4.5 Costo y Eficiencia

- 4.6 Plataformas informáticas

- 5. Alineación de AGI: garantizar que AGI satisfaga diversas necesidades

- 5.1 Expectativas de alineación del AGI

- 5.2 Técnicas de alineación actuales

- 5.3 Cómo abordar las alineaciones AGI

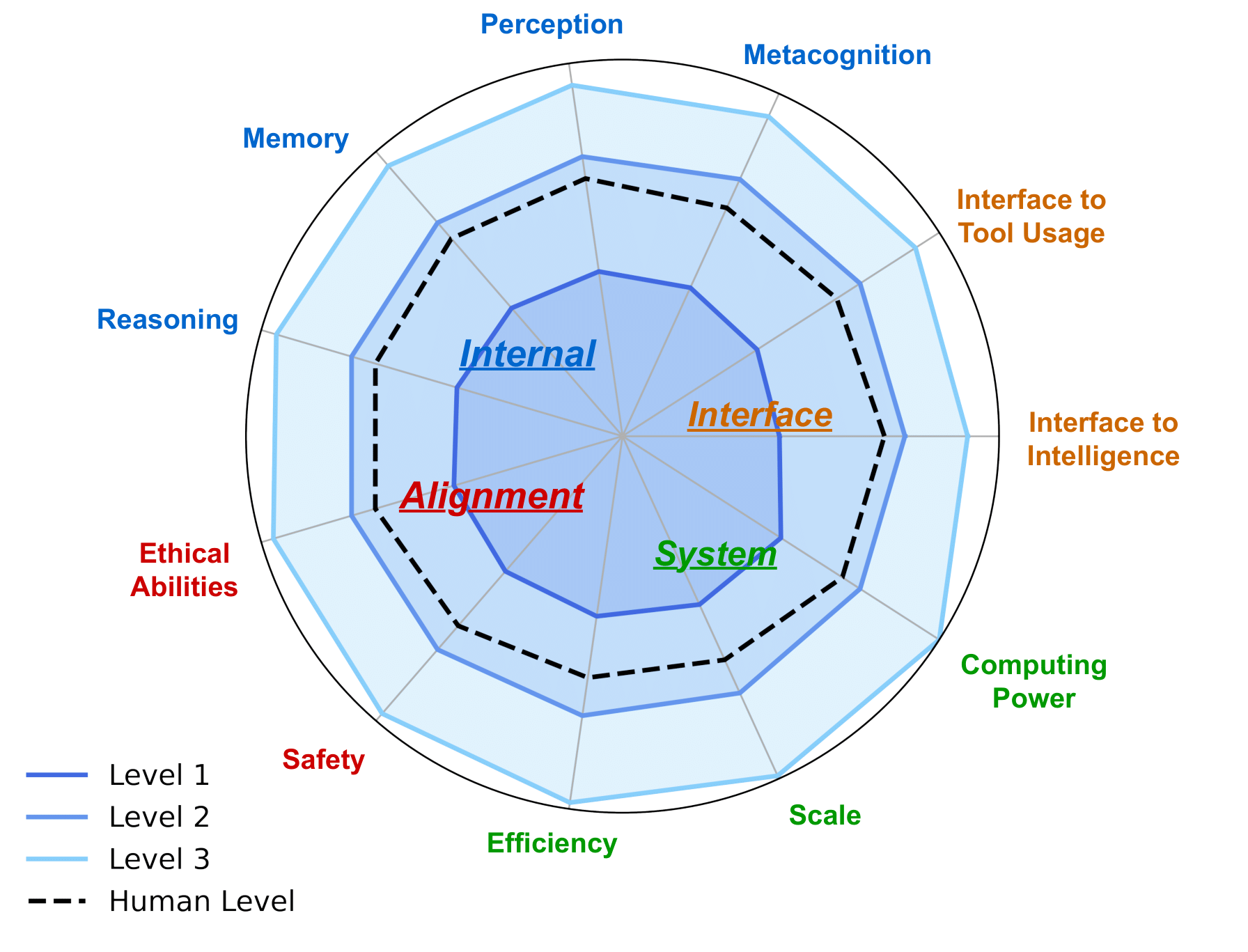

- 6. Hoja de ruta AGI: abordar la AGI de manera responsable

- 6.1 Niveles de IA: trazando la evolución de la inteligencia artificial

- 6.2 Evaluación del AGI

- 6.2.1 Expectativas para la evaluación de AGI

- 6.2.2 Evaluaciones actuales y sus limitaciones

- 6.5 Consideraciones adicionales durante el desarrollo de AGI

- 7. Estudios de caso

- 7.1 IA para el descubrimiento y la investigación científicos

- 7.2 Inteligencia Visual Generativa

- 7.3 Modelos mundiales

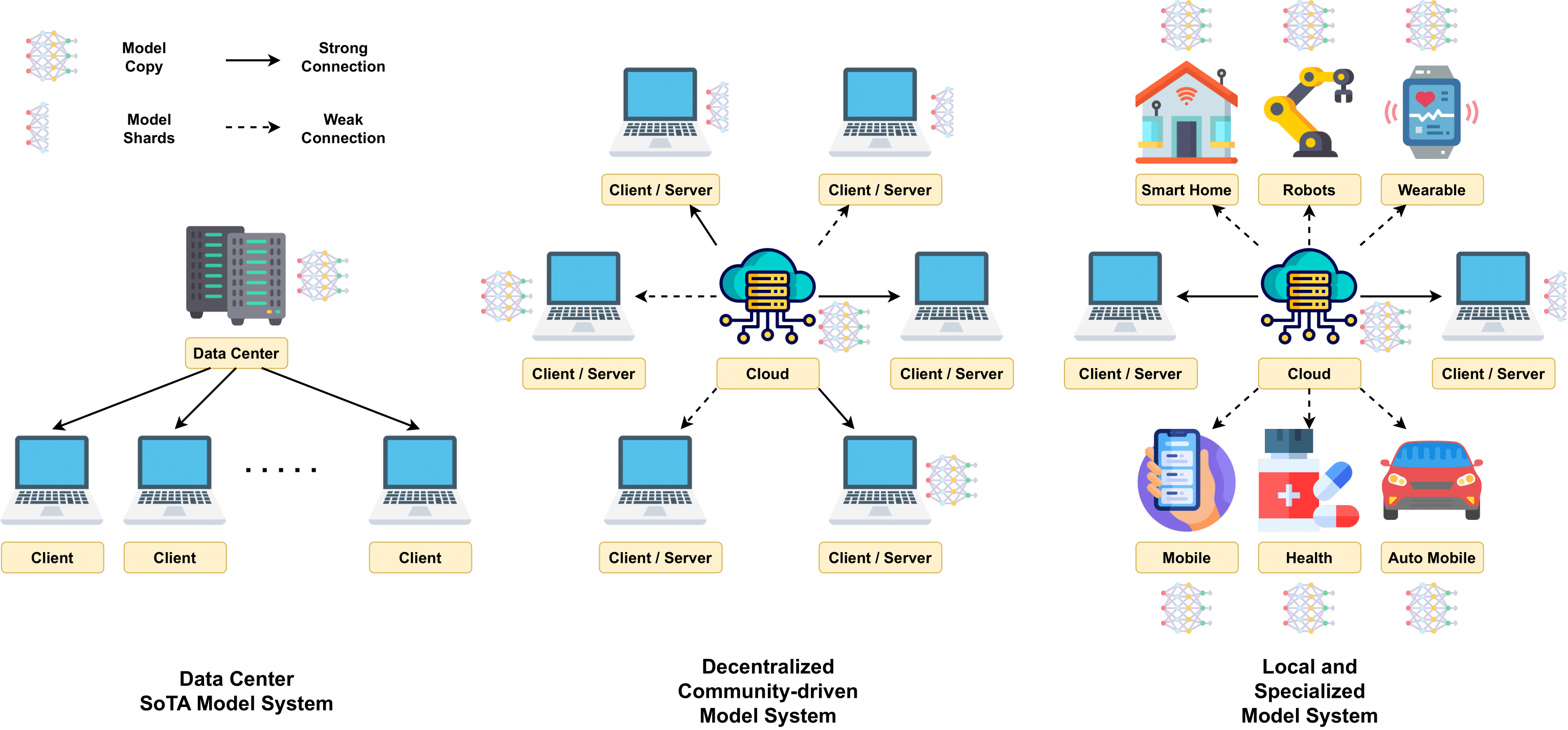

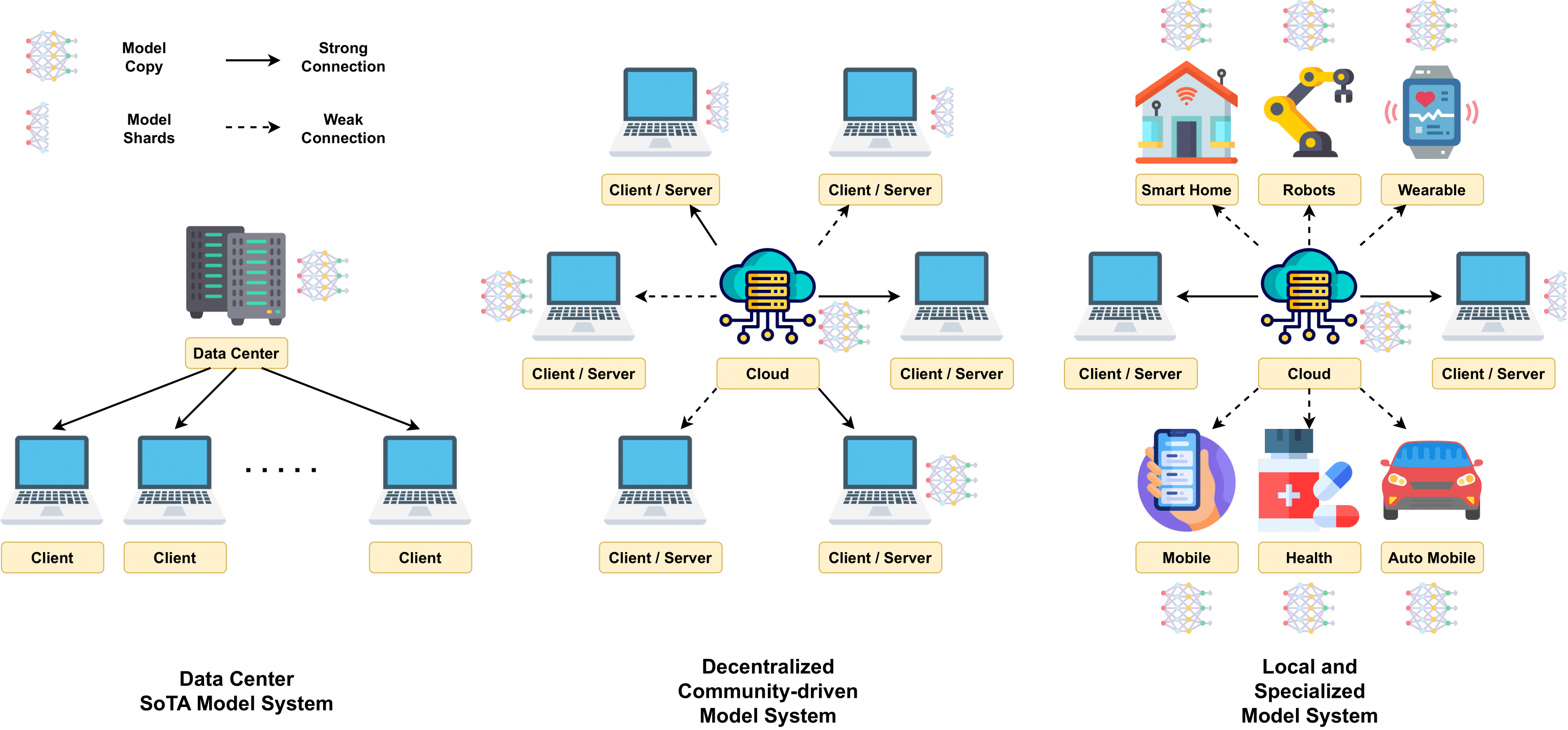

- 7.4 LLM descentralizado

- 7.5 IA para codificación

- 7.6 IA para robótica en aplicaciones del mundo real

- 7.7 Colaboración entre humanos y IA

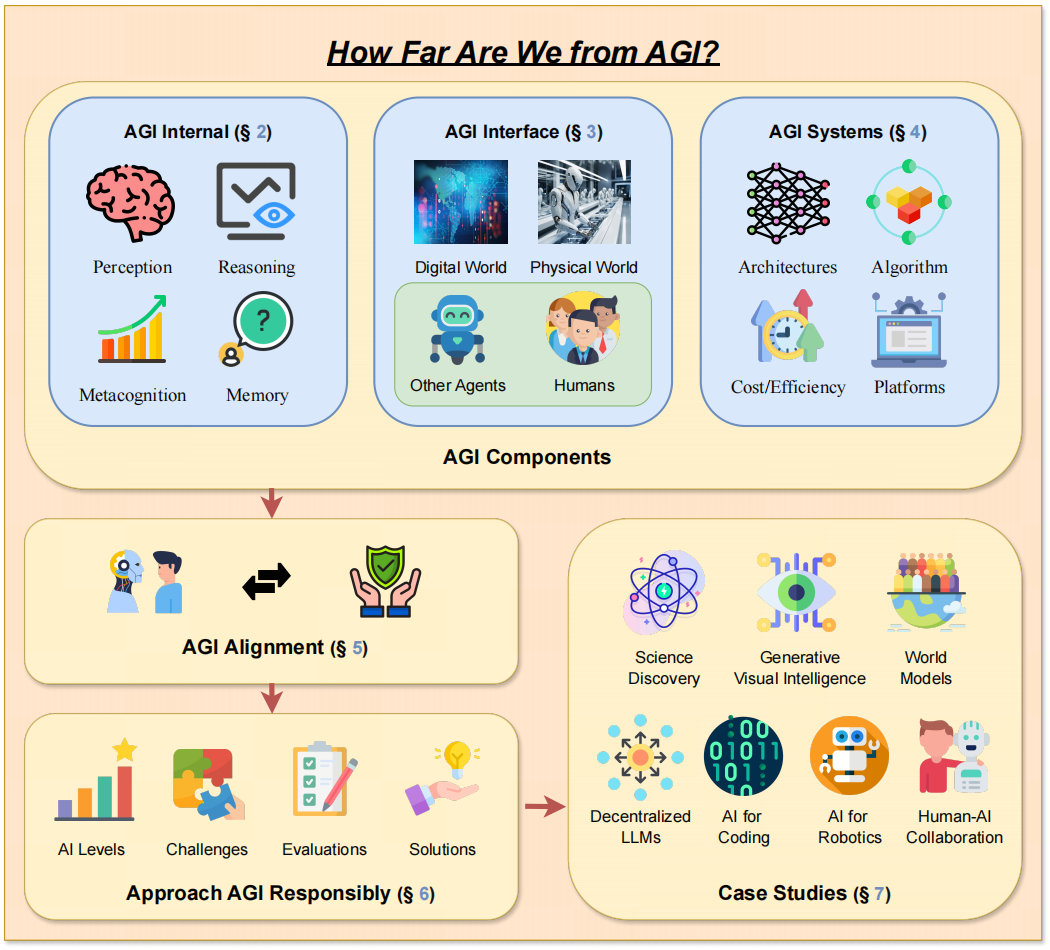

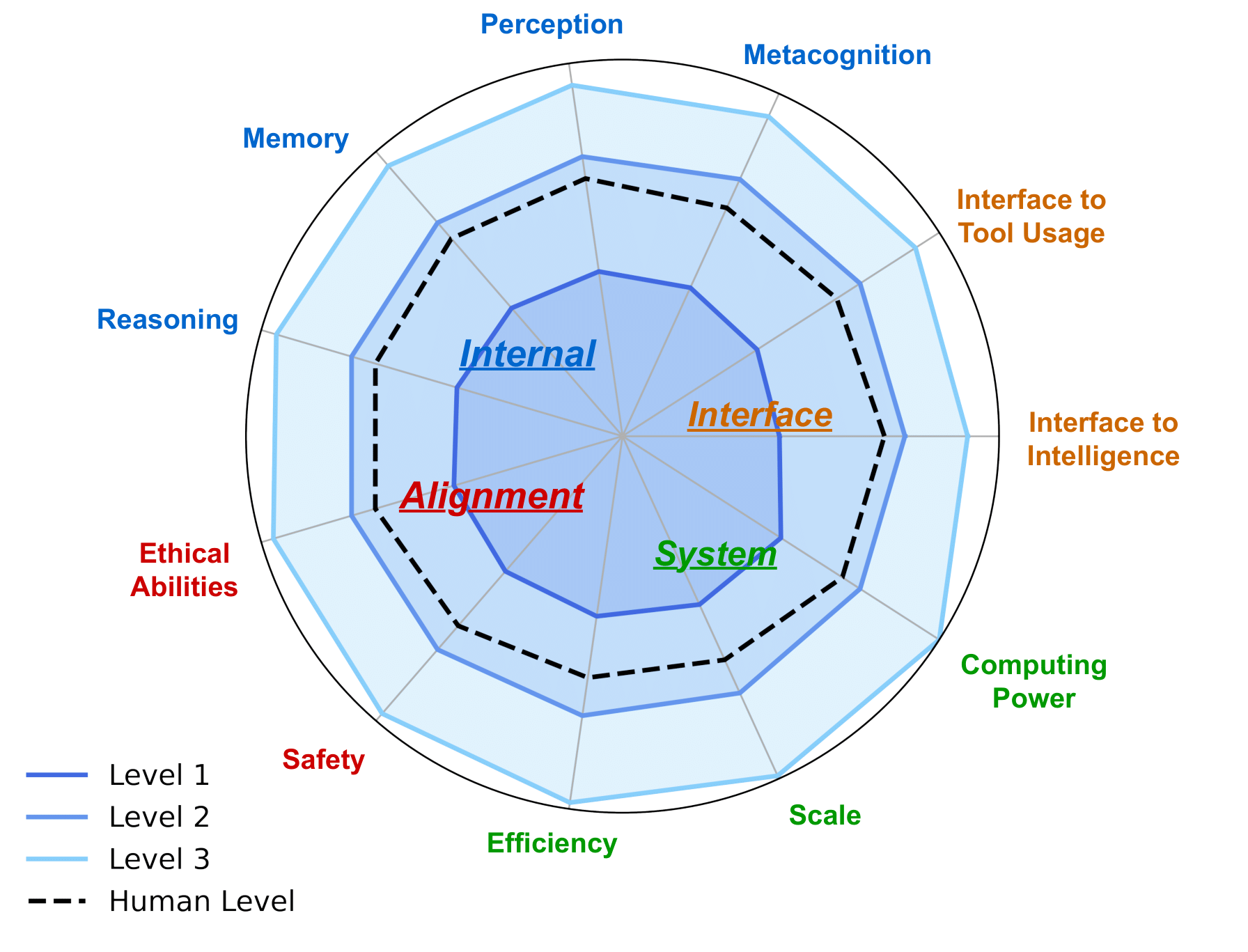

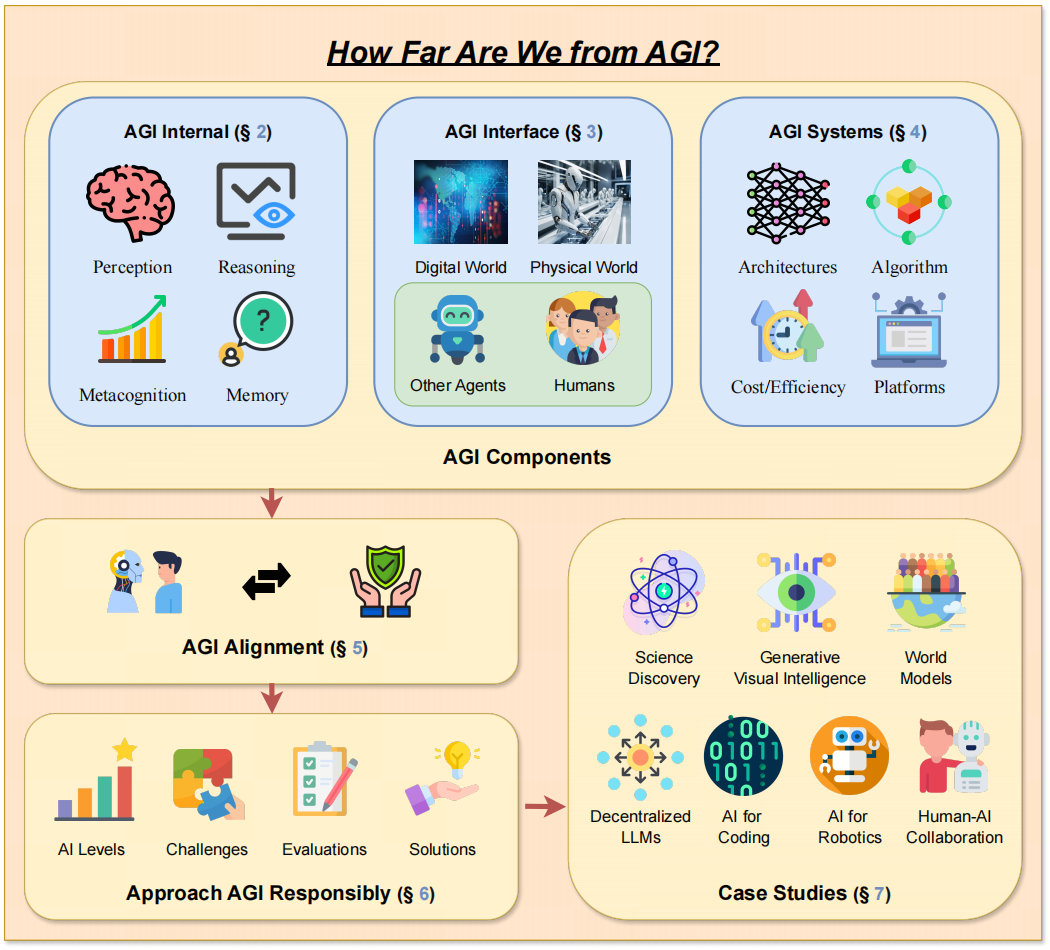

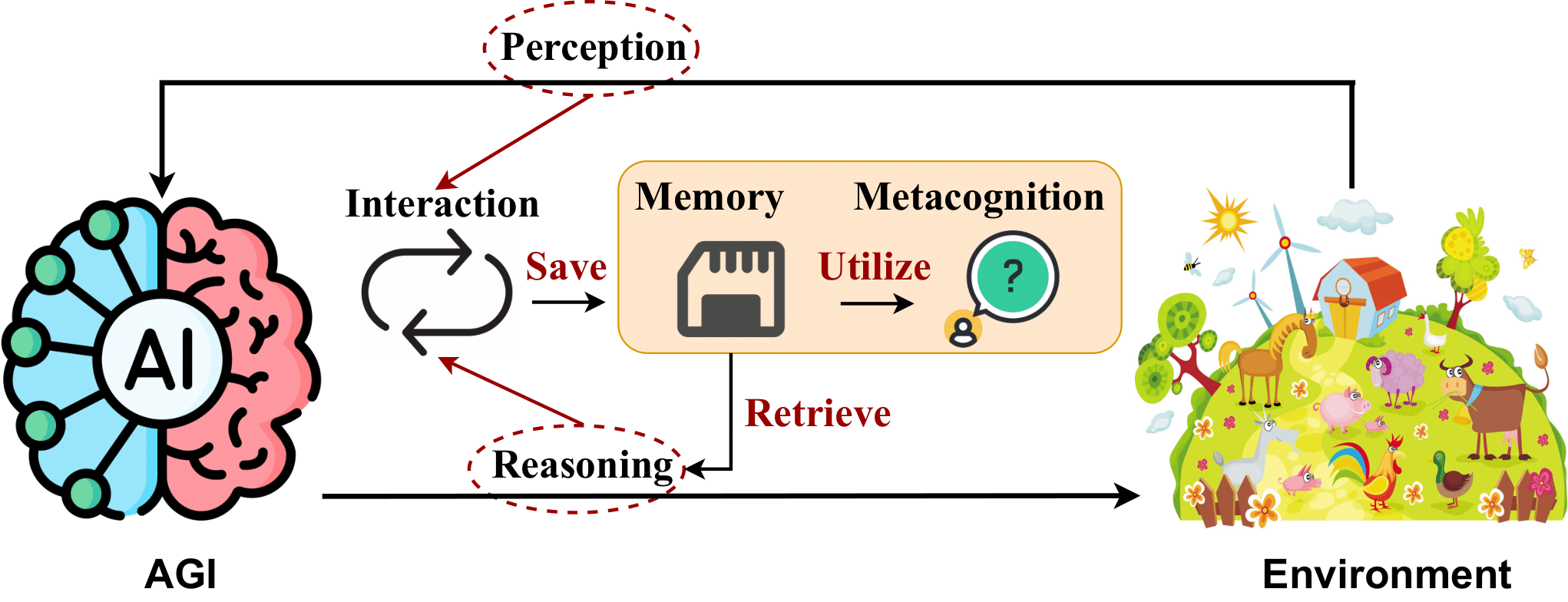

-> El diseño marco de nuestro artículo. <-

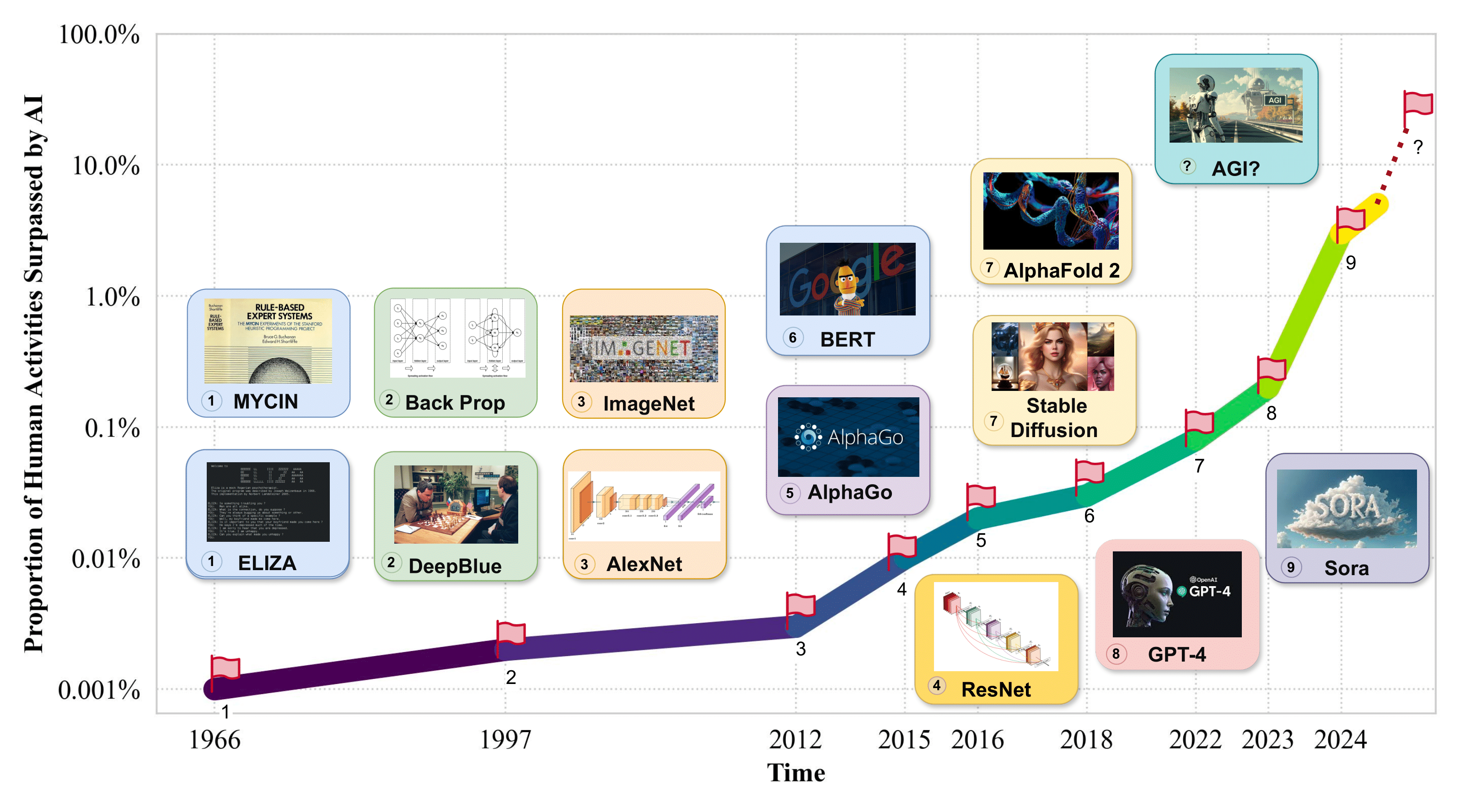

1. Introducción

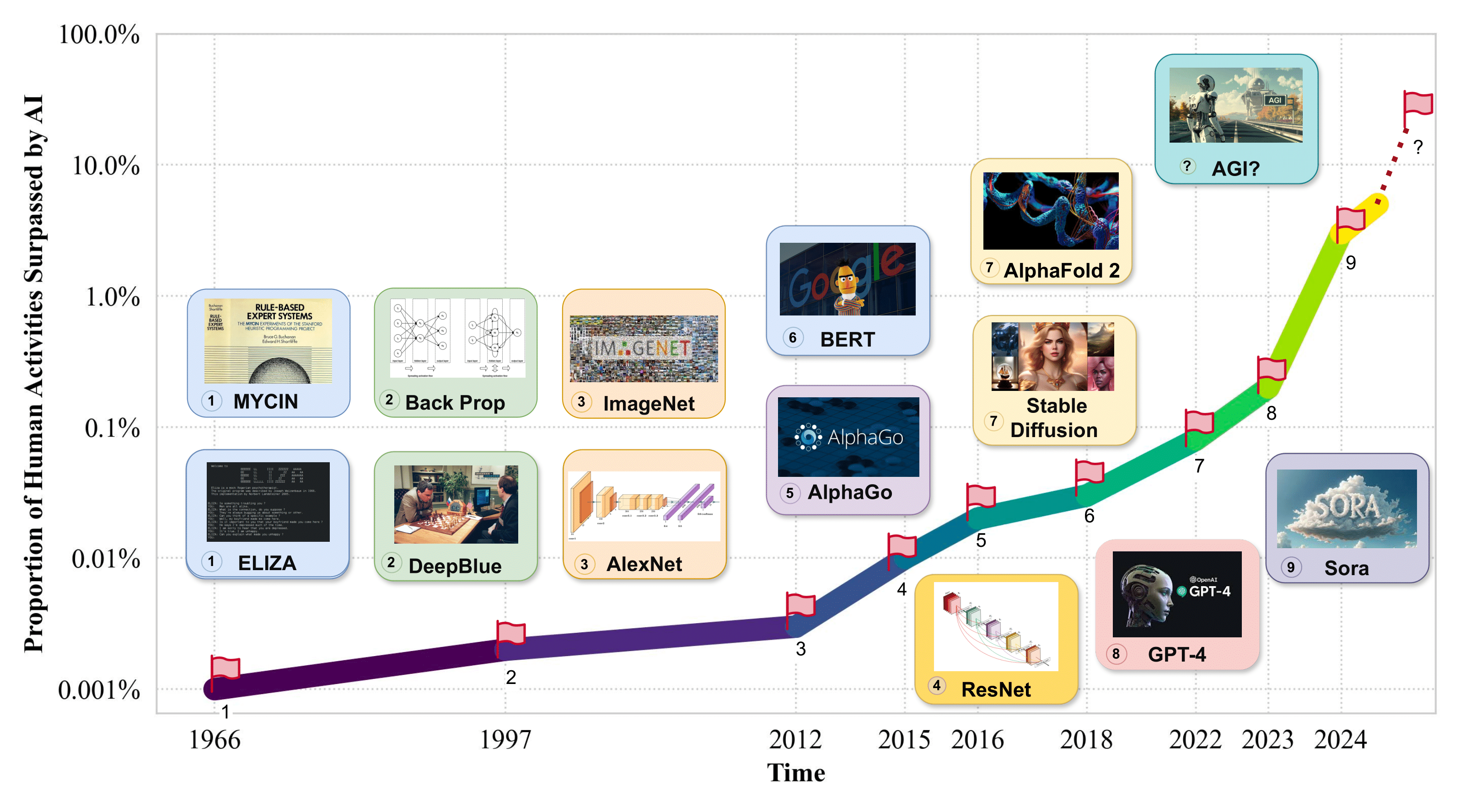

-> Proporción de actividades humanas superadas por la IA. <-

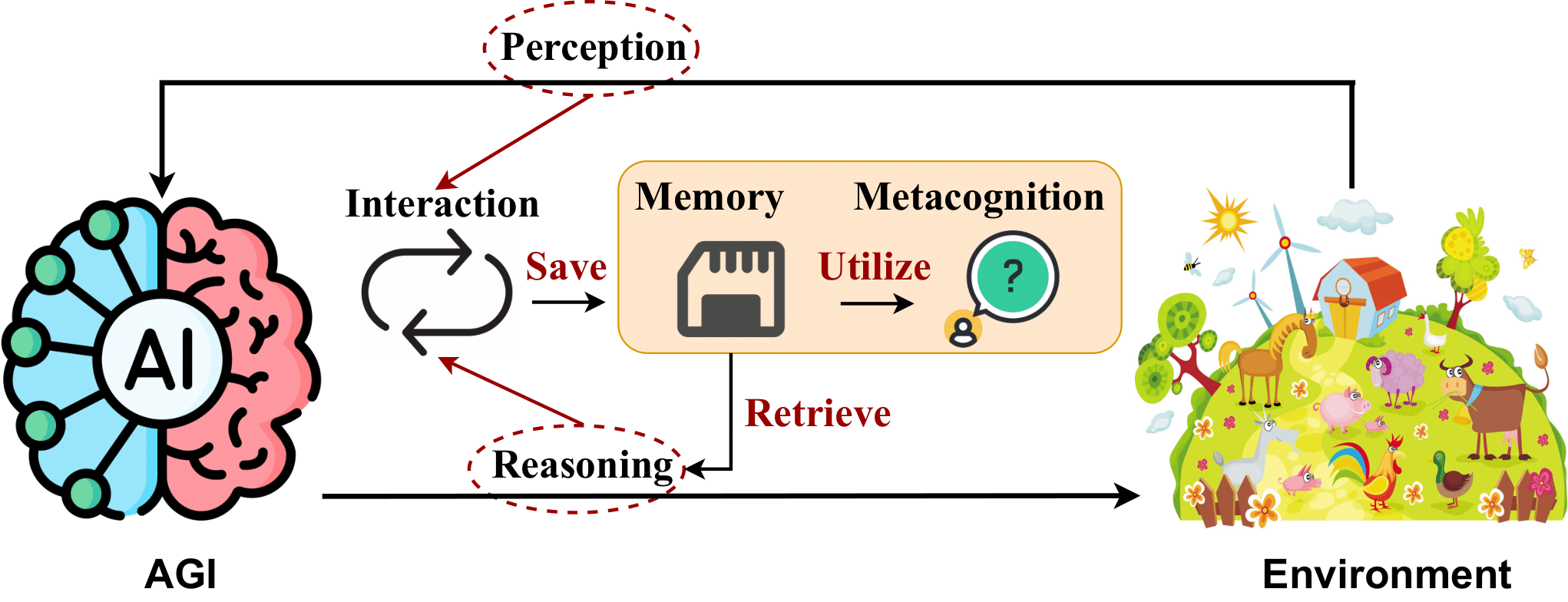

2. AGI Internal: Revelando la mente de AGI

2.1 Percepción de la IA

- Flamingo: un modelo de lenguaje visual para el aprendizaje en pocas ocasiones . Jean-Baptiste Alayrac et al. NeurIPS 2022. [artículo]

- BLIP-2: Entrenamiento previo de imágenes y lenguaje de arranque con codificadores de imágenes congeladas y modelos de lenguaje grandes . Junnan Li et al. ICML 2023. [artículo]

- SPHINX: La combinación conjunta de pesos, tareas e incrustaciones visuales para modelos de lenguajes grandes multimodales . Ziyi Lin et al. EMNLP 2023. [artículo]

- Ajuste de instrucciones visuales . Haotian Liu et al. NeurIPS 2023. [artículo]

- GPT4Tools: Enseñanza de un modelo de lenguaje grande para utilizar herramientas mediante autoinstrucción . Rui Yang et al. NeurIPS 2023. [artículo]

- "Otter: un modelo multimodal con ajuste de instrucciones en contexto" . Bo Li et al. arXiv 2023. [artículo]

- VideoChat: comprensión de los vídeos centrados en el chat . KunChang Li et al. arXiv 2023. [artículo]

- mPLUG-Owl: la modularización potencia los grandes modelos de lenguaje con multimodalidad . Qinghao Ye et al. arXiv 2023. [artículo]

- Una encuesta sobre modelos de lenguajes grandes multimodales . Shukang Yin et al. arXiv 2023. [artículo]

- "PandaGPT: un modelo para instruir: sígalos todos" . Yixuan Su et al. arXiv 2023. [artículo]

- LLaMA-Adapter: Ajuste eficiente de modelos de lenguaje con atención de inicio cero . Renrui Zhang et al. arXiv 2023. [artículo]

- Gemini: una familia de modelos multimodales de gran capacidad . Rohan Anil et al. arXiv 2023. [artículo]

- Shikra: Desatando la magia del diálogo referencial de Multimodal LLM . Keqin Chen et al. arXiv 2023. [artículo]

- ImageBind: un espacio de incrustación para vincularlos a todos . Rohit Girdhar et al. CVPR 2023. [artículo]

- MobileVLM: un asistente de lenguaje de visión abierta, potente y rápido para dispositivos móviles . Xiangxiang Chu et al. arXiv 2023. [artículo]

- ¿Qué constituye un buen tokenizador visual para modelos de lenguaje grandes? . Guangzhi Wang et al. arXiv 2023. [artículo]

- MiniGPT-4: Mejora de la comprensión del lenguaje y la visión con modelos avanzados de lenguaje grande . Deyao Zhu et al. ICLR 2024. [artículo]

- "LanguageBind: ampliación del entrenamiento previo del lenguaje en vídeo a la modalidad N mediante alineación semántica basada en el lenguaje" . Bin Zhu et al. ICLR 2024. [artículo]

2.2 Razonamiento de la IA

- La cadena de pensamiento provoca el razonamiento en modelos de lenguaje grandes . Jason Wei y otros. NeurIPS 2022. [artículo]

- ¿Teoría neuronal de la mente? Sobre los límites de la inteligencia social en los grandes LM . Maarten Sap et al. EMNLP 2022. [artículo]

- Monólogo interior: razonamiento encarnado a través de la planificación con modelos de lenguaje . Wenlong Huang et al. CoRL 2022. [artículo]

- Estudio sobre alucinaciones en la generación del lenguaje natural . Ziwei Ji et al. Encuestas de informática ACM 2022. [artículo]

- ReAct: sinergizar el razonamiento y la actuación en modelos lingüísticos . Shunyu Yao et al. ICLR 2023. [artículo]

- Indicaciones descompuestas: un enfoque modular para resolver tareas complejas . Tushar Khot et al. ICLR 2023. [artículo]

- Indicaciones basadas en la complejidad para el razonamiento de varios pasos . Yao Fu et al. ICLR 2023. [artículo]

- "Las indicaciones de menor a mayor permiten un razonamiento complejo en modelos de lenguaje grandes" . Denny Zhou et al. ICLR 2023. [artículo]

- Hacia el razonamiento en modelos de lenguaje grandes: una encuesta . Jie Huang et al. Hallazgos de ACL 2023. [artículo]

- ProgPrompt: generación de planes de tareas de robots situados utilizando modelos de lenguaje grandes . Ishika Singh y cols. ICRA 2023. [artículo]

- Razonar con el modelo del lenguaje es planificar con el modelo del mundo . Shibo Hao et al. EMNLP 2023. [artículo]

- Evaluación de alucinaciones de objetos en modelos de lenguaje y visión amplia . Yifan Li et al. EMNLP 2023. [artículo]

- Árbol de pensamientos: resolución deliberada de problemas con modelos de lenguaje grandes . Shunyu Yao et al. NeurIPS 2023. [artículo]

- Autorrefinamiento: refinamiento iterativo con autorretroalimentación . Aman Madaan et al. NeurIPS 2023. [artículo]

- Reflexión: Agentes del Lenguaje con Aprendizaje por Refuerzo Verbal . Noah Shinn et al. NeurIPS 2023. [artículo]

- "Describir, explicar, planificar y seleccionar: la planificación interactiva con modelos de lenguaje grandes permite agentes multitarea de mundo abierto" . Zihao Wang et al. NeurIPS 2023. [artículo]

- LLM+P: potenciar modelos de lenguajes grandes con un dominio de planificación óptimo . Bo Liu et al. arXiv 2023. [artículo]

- Modelos de lenguaje, modelos de agentes y modelos mundiales: la LEY del razonamiento y la planificación de las máquinas . Zhiting Hu et al. arXiv 2023. [artículo]

- MMToM-QA: Teoría multimodal de la respuesta a preguntas de la mente . Chuanyang Jin et al. arXiv 2024. [artículo]

- Gráfico de pensamientos: resolución de problemas elaborados con modelos de lenguaje grandes . Maciej Besta et al. AAAI 2024. [artículo]

- "Lograr> 97% en GSM8K: comprender profundamente los problemas convierte a los LLM en razonadores perfectos" . Qihuang Zhong et al. arXiv 2024. [artículo] pendiente

2.3 Memoria de IA

- Recuperación de pasajes densos para responder preguntas en dominio abierto . Vladimir Karpukhin y otros. EMNLP 2020. [artículo]

- Generación de recuperación aumentada para tareas de PNL intensivas en conocimiento . Patrick Lewis y otros. NeurIPS 2020. [artículo]

- REALM: Entrenamiento previo del modelo de lenguaje de recuperación aumentada . Kelvin Guu et al. ICML 2020. [artículo]

- "El aumento de la recuperación reduce las alucinaciones en la conversación" . Kurt Shuster et al. Hallazgos del EMNLP 2021. [artículo]

- "Mejora de los modelos de lenguaje recuperando billones de tokens" . Sebastián Borgeaud et al. ICML 2022. [artículo]

- Agentes generativos: simulacros interactivos del comportamiento humano . Joon Sung Park y otros. UIST 2023. [artículo]

- Arquitecturas cognitivas para agentes del lenguaje . Theodore R. Sumers et al. TMLR 2024. [artículo]

- Voyager: un agente encarnado abierto con grandes modelos de lenguaje . Guanzhi Wang et al. arXiv 2023. [artículo]

- "Una encuesta sobre el mecanismo de memoria de agentes basados en modelos de lenguaje grande" . Zeyu Zhang et al. arXiv 2024. [artículo]

- "El resumen recursivo permite la memoria del diálogo a largo plazo en modelos de lenguaje grandes" . Qingyue Wang et al. arXiv 2023. [artículo] pendiente

2.4 Metacognición de la IA

- La consideración de las metahabilidades en la externalización del conocimiento tácito y el aprendizaje organizacional . Jyoti Choudrie et al. HICSS 2006. [artículo]

- Evolución de la inteligencia autónoma de redes neuronales autosupervisadas a partir del autoaprendizaje evolucionado . Nam Le . arXiv 2019. [artículo]

- "Hacer que los modelos de lenguaje previamente entrenados sean mejores para los estudiantes de pocas oportunidades" . Tianyu Gao et al. ACL 2021. [artículo]

- Identificación y manipulación de los rasgos de personalidad de los modelos de lenguaje . Graham Caron et al. arXiv 2022. [artículo]

- Brainish: formalizando un lenguaje multimodal para la inteligencia y la conciencia . Paul Liang et al. arXiv 2022. [artículo]

- Una teoría de la conciencia desde una perspectiva teórica de la informática: conocimientos de la máquina de Turing consciente . Lenore Blum y cols. PNAS 2022. [artículo]

- WizardLM: Capacitación de modelos de lenguaje grandes para seguir instrucciones complejas . Can Xu et al. arXiv 2023. [artículo]

- Autoinstrucción: alineación de modelos lingüísticos con instrucciones autogeneradas . Yizhong Wang et al. ACL 2023. [artículo]

- "ReST se encuentra con ReAct: superación personal para el agente LLM de razonamiento de varios pasos" . Renat Aksitov y otros. arXiv 2023. [artículo]

- La psicología cultural de los grandes modelos lingüísticos: ¿ChatGPT es un pensador holístico o analítico? . Chuanyang Jin et al. arXiv 2023. [artículo]

- Conciencia en la inteligencia artificial: conocimientos de la ciencia de la conciencia . Patrick Butlin et al. arXiv 2023. [artículo]

- "Revisando la confiabilidad de las escalas psicológicas en modelos de lenguaje grandes" . Jen-tse Huang et al. arXiv 2023. [artículo]

- Evaluación e inducción de la personalidad en modelos de lenguaje previamente entrenados . Guangyuan Jiang et al. NeurIPS 2024. [artículo]

- Niveles de AGI: hacer operativo el progreso en el camino hacia AGI . Meredith Ringel Morris et al. arXiv 2024. [artículo] pendiente

- Investigar-Consolidar-Explotar: una estrategia general para la autoevolución de los agentes entre tareas . Cheng Qian et al. arXiv 2024. [artículo] pendiente

3. Interfaz AGI: Conectando el mundo con AGI

3.1 Interfaces de IA con el mundo digital

- Principios de las interfaces de usuario de iniciativa mixta . Eric Horvitz. SIGCHI 1999. [artículo]

- El auge y el potencial de los grandes agentes basados en modelos lingüísticos: una encuesta . Zhiheng Xi et al. arXiv 2023. [artículo]

- Aprendizaje de herramientas con modelos básicos . Yujia Qin et al. arXiv 2023. [artículo]

- Creador: Desenmarañar razonamientos abstractos y concretos de grandes modelos de lenguaje mediante la creación de herramientas . Cheng Qian et al. arXiv 2023. [artículo]

- AppAgent: Agentes multimodales como usuarios de teléfonos inteligentes . Zhao Yang et al. arXiv 2023. [artículo]

- Mind2Web: Hacia un agente generalista para la Web . Xiang Deng et al. Punto de referencia NeurIPS 2023. [artículo]

- ToolQA: un conjunto de datos para responder preguntas de LLM con herramientas externas . Yuchen Zhuang et al. arXiv 2023. [artículo]

- Agentes generativos: simulacros interactivos del comportamiento humano . Joon Sung Park y otros. arXiv 2023. [artículo]

- "Formador de herramientas: los modelos de lenguaje pueden aprender por sí mismos a utilizar herramientas" . Timo Schick et al. arXiv 2023. [artículo]

- "Gorilla: modelo de lenguaje grande conectado con API masivas" . Shishir G Patil et al. arXiv 2023. [artículo]

- "Voyager: un agente encarnado abierto con grandes modelos de lenguaje" . Guanzhi Wang et al. arXiv 2023. [artículo]

- OS-Copilot: Hacia agentes informáticos generalistas y con superación personal . Zhiyong Wu et al. arXiv 2024. [artículo]

- WebArena: un entorno web realista para crear agentes autónomos . Shuyan Zhou et al. ICLR 2024. [artículo]

- "Grandes modelos de lenguaje como creadores de herramientas" . Tianle Cai et al. ICLR 2024. [artículo]

3.2 Interfaces de IA con el mundo físico

- Lecciones del desafío de la recolección en Amazon: cuatro aspectos de la construcción de sistemas robóticos . Clemens Eppner et al. RSS 2016. [artículo]

- "Perceiver-Actor: un transformador multitarea para manipulación robótica" . Mohit Shridhar y otros. arXiv 2022. [artículo]

- Vima: manipulación general del robot con indicaciones multimodales . Yunfan Jiang et al. arXiv 2022. [artículo]

- "Haz lo que pueda, no lo que digo: fundamentar el lenguaje en posibilidades robóticas" . Michael Ahn et al. arXiv 2022. [artículo]

- "Voxposer: mapas de valores 3D componibles para manipulación robótica con modelos de lenguaje" . Wenlong Huang et al. arXiv 2023. [artículo]

- MotionGPT: movimiento humano como lengua extranjera . Biao Jiang et al. arXiv 2023. [artículo]

- "Rt-2: Los modelos de visión-lenguaje-acción transfieren el conocimiento web al control robótico" . Anthony Brohan et al. arXiv 2023. [artículo]

- Navegar a objetos en el mundo real . Théophile Gervet et al. Robótica científica 2023. [artículo]

- Lm-nav: navegación robótica con grandes modelos de lenguaje, visión y acción previamente entrenados . Dhruv Shah y otros. CRL 2023. [artículo]

- Palm-e: un modelo de lenguaje multimodal incorporado . Danny Driess et al. arXiv 2023. [artículo]

- LLM-Planner: planificación fundamentada de pocas posibilidades para agentes incorporados con modelos de lenguaje grandes . Chan Hee Song y otros. ICCV 2023. [artículo]

- Instruct2Act: asignación de instrucciones multimodales a acciones robóticas con un modelo de lenguaje grande . Siyuan Huang et al. arXiv 2023. [artículo]

- DROID: un conjunto de datos de manipulación de robots salvajes a gran escala . Alexander Khazatsky et al. arXiv 2024. [artículo]

- BEHAVIOR-1K: un punto de referencia de IA encarnado y centrado en el ser humano con 1000 actividades cotidianas y simulación realista . Chengshu Li et al. arXiv 2024. [artículo]

3.3 Interfaces de IA con inteligencia

3.3.1 Interfaces de IA con agentes de IA

- "Gradientes de políticas multiagentes contrafactuales" . Jakob Foerster et al. AAAI 2018. [artículo]

- Las explicaciones de modelos de lenguaje grandes mejoran a los pequeños razonadores . Shiyang Li et al. arXiv 2022. [artículo]

- Destilación del aprendizaje en contexto: transferencia de la capacidad de aprendizaje en pocas oportunidades de modelos de lenguaje previamente entrenados . Yukun Huang et al. arXiv 2022. [artículo]

- Autoagents: un marco para la generación automática de agentes . Guangyao Chen et al. arXiv 2023. [artículo]

- "Inferencia neuronal amortizada para razonamiento multiagente anidado" . Kunal Jha et al. arXiv 2023. [artículo]

- Destilación del conocimiento de grandes modelos lingüísticos . Yuxian Gu et al. arXiv 2023. [artículo]

- Metagpt: Metaprogramación para marco colaborativo multiagente . Sirui Hong et al. arXiv 2023. [artículo]

- Describir, explicar, planificar y seleccionar: la planificación interactiva con grandes modelos de lenguaje permite agentes multitarea de mundo abierto . Zihao Wang et al. arXiv 2023. [artículo]

- Agentverse: facilitar la colaboración entre múltiples agentes y explorar comportamientos emergentes en los agentes . Weize Chen et al. arXiv 2023. [artículo]

- Tormentas mentales en sociedades mentales basadas en el lenguaje natural . Mingchen Zhuge et al. arXiv 2023. [artículo]

- "Jarvis-1: agentes multitarea de mundo abierto con modelos de lenguaje multimodal con memoria aumentada" . Zihao Wang et al. arXiv 2023. [artículo]

- Destilación simbólica de la cadena de pensamiento: los modelos pequeños también pueden "pensar" paso a paso . Liunian Harold Li et al. ACL 2023. [artículo]

- ¡Destilando paso a paso! superando a los modelos de lenguaje más grandes con menos datos de entrenamiento y tamaños de modelo más pequeños . Cheng-Yu Hsieh et al. arXiv 2023. [artículo]

- Generalización de débil a fuerte: obtención de capacidades sólidas con supervisión débil . Collin Burns et al. arXiv 2023. [artículo]

- Mejorar los modelos de lenguaje de chat ampliando conversaciones instructivas de alta calidad . Ning Ding et al. arXiv 2023. [artículo]

- GAIA: un referente para Asistentes Generales de IA . Grégoire Mialon et al. ICLR 2024. [artículo]

- "Voyager: un agente encarnado abierto con grandes modelos de lenguaje" . Guanzhi Wang et al. arXiv 2023. [artículo]

- "Camello: agentes comunicativos para la exploración de la "mente" de una sociedad modelo lingüística a gran escala" . Guohao Li et al. arXiv 2023. [artículo]

- Adaptación de los autorracionalizadores con destilación de múltiples recompensas . Sahana Ramnath et al. arXiv 2023. [artículo]

- Superalineación de la visión: generalización de débil a fuerte para los modelos Vision Foundation . Jianyuan Guo et al. arXiv 2024. [artículo]

- WebArena: un entorno web realista para crear agentes autónomos . Shuyan Zhou et al. ICLR 2024. [artículo]

- Autoalineación basada en principios de modelos de lenguaje desde cero con mínima supervisión humana . Zhiqing Sun et al. NeurIPS 2024. [artículo]

- Mind2web: Hacia un agente generalista para la web . Xiang Deng et al. NeurIPS 2024. [artículo]

- "Hacia el control informático general: un agente multimodal para la redención de los muertos rojos ii como estudio de caso" . Weihao Tan et al. arXiv 2024. [artículo]

3.3.2 Interfaces de IA con humanos

- Directrices para la interacción entre humanos y IA . Saleema Amershi et al. CHI 2019. [artículo]

- Principios de diseño para aplicaciones de IA generativa . Justin D. Weisz et al. CHI 2024. [artículo]

- Grafólogo: exploración de respuestas de modelos de lenguaje grandes con diagramas interactivos . Peiling Jiang et al. UIST 2023. [artículo]

- Sensecape: permitir la exploración multinivel y la creación de sentido con modelos de lenguaje grandes . Sangho Suh et al. UIST 2023. [artículo]

- Respaldo de la comprensión de los resultados de modelos de lenguaje grandes a escala . Katy Ilonka Gero et al. CHI 2024. [artículo]

- Luminate: generación estructurada y exploración del espacio de diseño con grandes modelos de lenguaje para la cocreación entre humanos y IA . Sangho Suh et al. CHI 2024. [Artículo]

- "Cadenas de IA: interacción humano-IA transparente y controlable mediante el encadenamiento de indicaciones de modelos de lenguaje grandes" . Tongshuang Wu et al. CHI 2022. [artículo]

- Promptify: generación de texto a imagen mediante exploración interactiva de mensajes con modelos de lenguaje grandes . Stephen Brade et al. CHI 2023. [artículo]

- ChainForge: un conjunto de herramientas visuales para ingeniería rápida y pruebas de hipótesis de LLM . Ian Arawjo et al. CHI 2024. [artículo]

- CoPrompt: compatibilidad con el intercambio rápido y las referencias en la programación colaborativa en lenguaje natural . Li Feng y cols. CHI 2024. [artículo]

- Generación de comentarios automáticos sobre maquetas de interfaz de usuario con modelos de lenguaje grandes . Peitong Duan et al. CHI 2024. [artículo]

- Rambler: apoyo a la escritura con el habla mediante la manipulación esencial asistida por un LLM . Susan Lin et al. CHI 2024. [artículo]

- Incorporación de grandes modelos lingüísticos en la realidad extendida: oportunidades y desafíos para la inclusión, el compromiso y la privacidad . Efe Bozkir et al. arXiv 2024. [artículo]

- GenAssist: hacer accesible la generación de imágenes . Mina Huh et al. UIST 2023. [artículo]

- "Cuanto menos escribo, mejor": cómo los modelos de lenguaje de IA pueden mejorar o impedir la comunicación para los usuarios de CAA . Estefanía Valencia et al. CHI 2023. [artículo]

- "Reexaminar si la interacción entre humanos e IA es excepcionalmente difícil de diseñar, por qué y cómo" . Qian Yang et al. CHI 2020. [artículo]

4. Sistemas AGI: Implementación del mecanismo de AGI

4.2 Arquitecturas de modelos escalables

- "Redes neuronales escandalosamente grandes: la capa de mezcla de expertos escasamente conectada" . Noam Shazeer y cols. arXiv 2017. [artículo]

- Los transformadores son RNN: transformadores autorregresivos rápidos con atención lineal . Angelos Katharopoulos et al. arXiv 2020. [artículo]

- Longformer: el transformador de documentos largos . Iz Beltagy et al. arXiv 2020. [artículo]

- LightSeq: una biblioteca de inferencia de alto rendimiento para transformadores . Xiaohui Wang et al. arXiv 2021. [artículo]

- Transformadores de conmutación: escalamiento a modelos de billones de parámetros con escasez simple y eficiente . William Fedus et al. arXiv 2022. [artículo]

- Modelado eficiente de secuencias largas con espacios de estados estructurados . Albert Gu et al. arXiv 2022. [artículo]

- "MegaBlocks: entrenamiento disperso eficiente con una combinación de expertos" . Trevor Gale y cols. arXiv 2022. [artículo]

- "Entrenamiento de modelos de lenguaje grande óptimos para la computación" . Jordan Hoffmann et al. arXiv 2022. [artículo]

- "Escalamiento efectivo de contexto largo de modelos básicos" . Wenhan Xiong et al. arXiv 2023. [artículo]

- Jerarquía de hienas: hacia modelos de lenguaje convolucionales más amplios . Michael Poli et al. arXiv 2023. [artículo]

- Stanford Alpaca: un modelo LLaMA que sigue instrucciones . Rohan Taori et al. GitHub 2023. [código]

- "Rwkv: Reinventando rnns para la era de los transformadores" . Bo Peng y cols. arXiv 2023. [artículo]

- Deja Vu: escasez contextual para LLM eficientes en el momento de la inferencia . Zichang Liu et al. arXiv 2023. [artículo]

- Flash-LLM: habilitación de inferencias de modelos generativos grandes rentables y altamente eficientes con escasez no estructurada . Haojun Xia et al. arXiv 2023. [artículo]

- "ByteTransformer: un transformador de alto rendimiento mejorado para entradas de longitud variable" . Yujia Zhai et al. arXiv 2023. [artículo]

- Tutel: combinación adaptativa de expertos a escala . Changho Hwang et al. arXiv 2023. [artículo]

- Mamba: modelado de secuencias de tiempo lineal con espacios de estados selectivos . Albert Gu, Tri Dao. arXiv 2023. [artículo]

- Hipopótamos hambrientos: hacia el modelado del lenguaje con modelos de espacio de estados . Daniel Y. Fu et al. arXiv 2023. [artículo]

- Red retentiva: un sucesor de Transformer para modelos de lenguaje grandes . Yutao Sun et al. ArXiv, 2023.

- Diseño Mecanicista y Escalado de Arquitecturas Híbridas . Michael Poli et al. arXiv 2024. [artículo]

- "Revisando la destilación del conocimiento para modelos de lenguaje autorregresivos" . Qihuang Zhong et al. arXiv 2024. [artículo]

- DB-LLM: binarización dual precisa para LLM eficientes . Hong Chen et al. arXiv 2024. [artículo]

- "Reducción del tamaño de la caché de valores-clave del transformador con atención entre capas" . William Brandon et al. arXiv 2024.[documento]

- Solo se almacena en caché una vez: arquitecturas decodificador-decodificador para modelos de lenguaje Yutao Sun et al. arXiv 2024. [artículo]

4.3 Capacitación a gran escala

- "Entrenamiento de redes profundas con costo de memoria sublineal" . Tianqi Chen et al. arXiv 2016. [artículo]

- Más allá del paralelismo de datos y modelos para redes neuronales profundas . Zhihao Jia et al. arXiv 2018. [artículo]

- GPipe: Entrenamiento eficiente de redes neuronales gigantes mediante paralelismo de canalizaciones . Yanping Huang et al. arXiv 2019. [artículo]

- Aprendizaje por transferencia eficiente de parámetros para PNL . Neil Houlsby et al. ICML 2019. artículo

- Megatron-LM: Entrenamiento de modelos de lenguaje de parámetros multimillonarios utilizando el paralelismo de modelos . Mohammad Shoeybi et al. arXiv 2020. [artículo]

- Alpa: Automatización del paralelismo entre operadores e intraoperadores para el aprendizaje profundo distribuido . Lianmin Zheng et al. arXiv 2022. [artículo]

- Inferencia DeepSpeed: permitir la inferencia eficiente de modelos de transformadores a una escala sin precedentes . Reza Yazdani Aminabadi et al. arXiv 2022. [artículo]

- Memorización sin sobreajuste: análisis de la dinámica de entrenamiento de modelos de lenguaje grandes . Kushal Tirumala et al. arXiv 2022. [artículo]

- "Paralelismo SWARM: entrenar modelos grandes puede ser sorprendentemente eficiente en comunicación" . Max Ryabinin y cols. arXiv 2023. [artículo]

- "Trayectorias de entrenamiento de modelos lingüísticos en todas las escalas" . Mengzhou Xia et al. arXiv 2023. [artículo]

- HexGen: inferencia generativa del modelo de fundación sobre un entorno descentralizado heterogéneo . Youhe Jiang et al. arXiv 2023. [artículo]

- FusionAI: capacitación descentralizada e implementación de LLM con GPU masivas a nivel de consumidor . Zhenheng Tang et al. arXiv 2023. [artículo]

- "Llame la atención con transformadores en bloque para un contexto casi infinito" . Hao Liu et al. arXiv 2023. [artículo]

- Pythia: una suite para analizar modelos de lenguaje grandes a través de entrenamiento y escalamiento . Stella Biderman et al. arXiv 2023. [artículo]

- "Ajuste de modelos de lenguaje en redes lentas mediante compresión de activación con garantías" . Jue Wang et al. arXiv 2023. [artículo]

- LLaMA-Adapter: Ajuste eficiente de modelos de lenguaje con atención de inicio cero . Renrui Zhang et al. arXiv 2023. [artículo]

- QLoRA: Ajuste eficiente de LLM cuantificados . Tim Dettmers et al. arXiv 2023. [artículo]

- Gestión eficiente de la memoria para modelos de lenguaje grandes que sirven con PagedAttention . Woosuk Kwon et al. arXiv 2023. [artículo]

- Infinite-LLM: servicio LLM eficiente para contextos prolongados con DistAttention y KVCache distribuido . Bin Lin et al. arXiv 2024. [artículo]

- OLMo: Acelerando la ciencia de los modelos lingüísticos . Dirk Groeneveld et al. arXiv 2024. [artículo]

- Sobre la formación eficiente de modelos de aprendizaje profundo a gran escala: una revisión de la literatura . Li Shen et al. arXiv 2023. [artículo] pendiente

4.4 Técnicas de inferencia

- FlashAttention: Atención exacta rápida y con uso eficiente de la memoria con IO-Awareness . Tri Dao et al. NeurIPS 2022. [artículo]

- "Borrador y verificación: aceleración de modelos de lenguaje grande sin pérdidas mediante decodificación autoespeculativa" . Jun Zhang et al. arXiv 2023. [artículo]

- Hacia un servicio eficiente de modelos de lenguaje grande generativo: un estudio desde los algoritmos hasta los sistemas . Xupeng Miao et al. arXiv 2023. [artículo]

- "FlashDecoding++: inferencia de modelos de lenguaje grande más rápida en GPU" . Ke Hong et al. arXiv 2023. [artículo]

- "Inferencia rápida de transformadores mediante decodificación especulativa" . Yaniv Leviatán et al. arXiv 2023. [artículo]

- Servicio de inferencia distribuida rápida para modelos de lenguaje grandes . Bingyang Wu et al. arXiv 2023. [artículo]

- S-LoRA: Sirviendo miles de adaptadores LoRA simultáneos . Ying Sheng et al. arXiv 2023. [artículo]

- TensorRT-LLM: una caja de herramientas de TensorRT para la inferencia optimizada de modelos de lenguaje grande . Nvidia. GitHub 2023. [código]

- Punica: Servicio LoRA multiinquilino . Lequn Chen et al. arXiv 2023. [artículo]

- S$^3: aumento de la utilización de GPU durante la inferencia generativa para un mayor rendimiento . Yunho Jin et al. arXiv 2023. [artículo]

- Servidor de inferencia multi-LoRA que escala a miles de LLM ajustados . Predibase. GitHub 2023. [código]

- Decodificación de búsqueda rápida . Apoorv Saxena. GitHub 2023. [código]

- Transformador más rápido . Nvidia. GitHub 2021. [artículo]

- "DeepSpeed-FastGen: generación de texto de alto rendimiento para LLM a través de MII y DeepSpeed-Inference" . Connor Holmes y cols. arXiv 2024. [artículo]

- SpecInfer: Aceleración del modelo de lenguaje generativo grande que ofrece inferencia y verificación especulativas basadas en árboles . Xupeng Miao et al. arXiv 2024. [artículo]

- "Medusa: marco simple de aceleración de inferencia LLM con múltiples cabezales de decodificación" . Tianle Cai et al. arXiv 2024. [artículo]

- "El modelo le indica qué descartar: compresión de caché KV adaptativa para LLM" . Suyu Ge et al. ICLR 2024. [artículo]

- Modelos de lenguaje de transmisión eficientes con receptores de atención . Guangxuan Xiao et al. ICLR 2024. [artículo]

- "DeFT: Flash Tree-attention con IO-Awareness para una inferencia LLM eficiente basada en búsqueda de árboles" . Jinwei Yao et al. arXiv 2024. [artículo]

- Programación eficiente de modelos de lenguajes grandes utilizando SGLang . Lianmin Zheng et al. arXiv 2023. [artículo]

- VELOCIDAD: Ejecución canalizada especulativa para una decodificación eficiente . Coleman Hooper y cols. arXiv 2023. [artículo]

- Sequoia: decodificación especulativa escalable, robusta y compatible con el hardware . Zhuoming Chen et al. arXiv 2024. [artículo] pendiente

4.5 Costo y Eficiencia

- Demostrar-Buscar-Predecir: Composición de modelos de lenguaje y recuperación para PNL con uso intensivo de conocimiento . Omar Khattab et al. arXiv 2023. [artículo]

- Aprendizaje automático automatizado: métodos, sistemas, desafíos . Frank Hutter et al. Springer Publishing Company, incorporada, 2019.

- Sopas de modelos: promediar los pesos de múltiples modelos ajustados mejora la precisión sin aumentar el tiempo de inferencia . Mitchell Wortsman et al. arXiv 2022. [artículo]

- "Depuración de datos con Shapley Importancia sobre las canalizaciones de aprendizaje automático de un extremo a otro" . Bojan Karlaš et al. arXiv 2022. [artículo]

- "Optimización rentable de hiperparámetros para inferencia de generación de modelos de lenguaje grande" . Chi Wang y cols. arXiv 2023. [artículo]

- "Los modelos de lenguaje grandes son ingenieros rápidos a nivel humano" . Yongchao Zhou et al. arXiv 2023. [artículo]

- Fusionar haciendo coincidir modelos en subespacios de tareas . Derek Tam y col. arXiv 2023. [artículo]

- Edición de modelos con aritmética de tareas . Gabriel Ilharco et al. arXiv 2023. [artículo]

- PriorBand: optimización práctica de hiperparámetros en la era del aprendizaje profundo . Neeratyoy Mallik et al. arXiv 2023. [artículo]

- "Un estudio empírico de la fusión de modelos multimodales" . Yi-Lin Sung et al. arXiv 2023. [artículo]

- DSPy: compilación de llamadas de modelos de lenguaje declarativo en canalizaciones de mejora automática . Omar Khattab et al. arXiv 2023. [artículo]

- FrugalGPT: Cómo utilizar modelos de lenguaje grandes mientras se reducen los costos y se mejora el rendimiento . Lingjiao Chen et al. arXiv 2023. [artículo]

- Transformadores en tándem para LLM con inferencia eficiente . Aishwarya PS et al. arXiv 2024. [artículo]

- AIOS: Sistema operativo del agente LLM . Kai Mei et al. arXiv 2024. [artículo]

- LoraHub: generalización eficiente de tareas cruzadas mediante composición dinámica de LoRA . Chengsong Huang et al. arXiv 2024. [artículo]

- AutoML en la era de los grandes modelos lingüísticos: desafíos actuales, oportunidades futuras y riesgos . Alexander Tornede et al. arXiv 2024. [artículo]

- Fusionar expertos en uno: mejorar la eficiencia computacional de la combinación de expertos . Shwai He et al. EMNLP 2023. [artículo] pendiente

4.6 Plataformas informáticas

- TVM: un compilador automatizado de optimización de un extremo a otro para el aprendizaje profundo . Tianqi Chen et al. arXiv 2018. [artículo]

- "TPU v4: una supercomputadora ópticamente reconfigurable para aprendizaje automático con soporte de hardware para incrustaciones" . Norman P. Jouppi et al. arXiv 2023. [artículo]

5. Alineación del AGI: garantizar que el AGI satisfaga diversas necesidades

5.1 Expectativas de alineación del AGI

- Compatible con humanos: la inteligencia artificial y el problema del control . Estuardo Russell . Vikingo, 2019.

- Inteligencia Artificial, Valores y Alineamiento . Iason Gabriel . Mentes y máquinas, 2020. [artículo]

- Alineación de Agentes Lingüísticos . Zachary Kenton et al. arXiv, 2021. [Artículo]

- El problema del aprendizaje de valores . Nate Soares . Informe técnico del Instituto de Investigación de Inteligencia Artificial [artículo]

- Problemas concretos en la seguridad de la IA . Darío Amodei et al. arXiv, 2016. [artículo]

- Riesgos éticos y sociales de daño provenientes de los modelos lingüísticos . Laura Weidinger et al. arXiv, 2021. [artículo]

- Sobre los peligros de los loros estocásticos: ¿pueden los modelos lingüísticos ser demasiado grandes? . Emily M. Bender y otros. HECHO 2021. [artículo]

- El panorama global de las directrices éticas de la IA . Anna Jobin et al. Nature Machine Intelligence, 2019. [artículo]

- "Sesgo antimusulmán persistente en modelos lingüísticos grandes" . Abubakar Abid et al. AIES, 2021. [artículo]

- Hacia una resolución de correferencia inclusiva en materia de género . Yang Trista Cao et al. ACL, 2020. [artículo]

- El impacto social del procesamiento del lenguaje natural . Dirk Hovy et al. ACL 2016. [artículo]

- TruthfulQA: medir cómo los modelos imitan las falsedades humanas . Stephanie Lin et al. ACL 2022. [artículo]

- Los riesgos de radicalización de GPT-3 y los modelos avanzados de lenguaje neuronal . Kris McGuffie y cols. arXiv, 2020. [artículo]

- Transparencia de la IA en la era de los LLM: una hoja de ruta de investigación centrada en las personas . P. Vera Liao et al. arXiv 2023. [artículo]

- Más allá de la experiencia y los roles: un marco para caracterizar a las partes interesadas del aprendizaje automático interpretable y sus necesidades . Harini Suresh et al. CHI 2021. [artículo]

- Identificación y mitigación de los riesgos de seguridad de la IA generativa . Clark Barrett et al. arXiv, 2023. [artículo]

- Los agentes de LLM pueden piratear sitios web de forma autónoma . Richard Fang et al. arXiv, 2024. [artículo]

- ¡Deepfakes, frenología, vigilancia y más! Una taxonomía de los riesgos de privacidad de la IA . Hao-Ping Lee et al. CHI 2024. [artículo]

- Privacidad en la era de la IA . Sauvik Das et al. Comunicaciones de la JCA, 2023. [artículo]

5.2 Técnicas de alineación actuales

- Aprender a resumir con retroalimentación humana . Nisan Stiennon et al. NeurIPS 2020. [artículo]

- Lo mejor es pensarlo dos veces: aprender a realinearse con los valores humanos a partir de las ediciones de texto . Ruibo Liu et al. NeurIPS 2022. [artículo]

- Entrenar modelos de lenguaje para seguir instrucciones con retroalimentación humana . Long Ouyang et al. NeurIPS 2022. [artículo]

- Atar a los demonios internos: autodesintoxicación para modelos de lenguaje . Canwen Xu et al. AAAI 2022. papel

- Alinear los modelos de lenguaje generativo con los valores humanos . Ruibo Liu et al. NAACL 2022. [artículo]

- Capacitar a un asistente útil e inofensivo con aprendizaje reforzado a partir de comentarios humanos . Yuntao Bai et al. arXiv 2022. [artículo]

- IA constitucional: inocuidad de la retroalimentación de la IA . Yuntao Bai et al. arXiv 2022. [artículo]

- "Balsa: ajuste de clasificación de recompensa para la alineación del modelo de base generativa" . Hanze Dong et al. arXiv 2023. [artículo]

- Mejora de los modelos de lenguaje con gradientes de políticas fuera de línea basados en ventajas . Ashutosh Baheti et al. arXiv 2023. [artículo]

- Entrenamiento de modelos lingüísticos con retroalimentación lingüística a escala . Jérémy Scheurer et al. arXiv 2023. [artículo]

- Un paradigma teórico general para comprender el aprendizaje a partir de las preferencias humanas . Mohammad Gheshlaghi Azar et al. arXiv 2023. [artículo]

- Verifiquemos paso a paso . Hunter Lightman y cols. arXiv 2023. [artículo]

- Problemas abiertos y limitaciones fundamentales del aprendizaje por refuerzo a partir de la retroalimentación humana . Stephen Casper y otros. arXiv 2023. [artículo]

- Alineación de modelos de lenguaje grandes mediante retroalimentación sintética . Sungdong Kim y cols. arXiv 2023. [artículo]

- RLAIF: Ampliación del aprendizaje por refuerzo a partir de la retroalimentación humana con retroalimentación de IA . Harrison Lee y cols. arXiv 2023. [artículo]

- Optimización del ranking de preferencias para la alineación humana . Feifan Song et al. arXiv 2023. [artículo]

- "Mejora de la factualidad y el razonamiento en modelos lingüísticos mediante el debate entre múltiples agentes" . Yilun Du et al. arXiv 2023. [artículo]

- Alineación de modelos de lenguaje grande: una encuesta . Tianhao Shen et al. arXiv 2023. [artículo]

- Optimización de preferencias directas: su modelo de lenguaje es secretamente un modelo de recompensa . Rafael Rafailov et al. NeurIPS 2024. [artículo]

- Lima: Menos es más para la alineación . Chunting Zhou et al. NeurIPS 2024. [artículo]

5.3 Cómo abordar las alineaciones AGI

- Riesgos éticos y sociales de daño proveniente del Lenguaje . Mellor Weidinger et al. arXiv 2021. [artículo]

- Consenso internacional de seguridad de la IA de Beijing . Academia de Inteligencia Artificial de Beijing. 2024. [papel]

- Explicaciones contrafactuales sin abrir la caja negra: decisiones automatizadas y el RGPD . Sandra Wachter et al. Harvard Journal of Law & Technology, 2017. [artículo]

- Alineación de agentes escalables a través del modelado de recompensas: una dirección de investigación . Jan Leike et al. ARXIV 2018. [Documento]

- Construyendo ética en inteligencia artificial . Han Yu et al. IJCAI 2018. Documento

- Compatible humano: inteligencia artificial y el problema del control . Stuart Russell . Viking, 2019. [Documento]

- Inteligencia artificial responsable: cómo desarrollar y usar IA de manera responsable . Virginia dignum . Springer Nature, 2019. [Documento]

- Ética de la máquina: el diseño y la gobernanza de la IA ética y los sistemas autónomos . Alan F. Winfield et al. Actas del IEEE, 2019. [Documento]

- Problemas abiertos en AI cooperativa . Allan Dafoe et al. ARXIV 2020. [Documento]

- Inteligencia artificial, valores y alineación . Iason Gabriel . Mentes y máquinas, 2020. [Documento]

- AI cooperativa: las máquinas deben aprender a encontrar un terreno común . Allan Dafoe et al. Naturaleza 2021. [Documento]

- La moralidad de la máquina, el progreso moral y el inminente desastre ambiental . Ben Kenward et al. ARXIV 2021. [Documento]

- Análisis de riesgo X para la investigación de IA . Dan Hendrycks et al. ARXIV 2022. [Documento]

- Descomposición de la tarea para supervisión escalable (destilación AGISF) . Charbel-Raphaël Segerie. Blog 2023. [Blog]

- Generalización de débil a primera: provocar capacidades fuertes con una supervisión débil . Collin Burns, et al. ARXIV 2023. [Documento]

- ¿De qué opiniones reflejan los modelos de idiomas? . Shibani Santurkar et al. ICML 2023. [Documento]

- Alineación de AI: una encuesta integral . Jiaming Ji et al. ARXIV 2023. [Documento]

- Problemas abiertos y limitaciones fundamentales del aprendizaje de refuerzo de la retroalimentación humana . Stephen Casper et al. ARXIV 2023. [Documento]

- El hechizo de desbloqueo en Base LLM: Repensar la alineación a través del aprendizaje en contexto . Bill Yuchen Lin et al. ARXIV 2023. [Documento]

- Alineación del modelo de lenguaje grande: una encuesta . Tianhao Shen et al. ARXIV 2023. [Documento]

6. Hoja de ruta AGI: se acerca responsablemente a AGI

6.1 Niveles de IA: trazar la evolución de la inteligencia artificial

- Chispas de inteligencia general artificial: primeros experimentos con GPT-4 . Sébastien Bubeck et al. ARXIV 2023. [Documento]

- Niveles de AGI: operacionalización del progreso en el camino hacia AGI . Meredith Ringel Morris et al. ARXIV 2024. [Documento]

6.2 Evaluación AGI

6.2.1 Expectativas para la evaluación AGI

- Hacia el informe sistemático de las huellas de energía y carbono del aprendizaje automático . Peter Henderson et al. Journal of Machine Learning Research, 2020.

- Ai verde . Roy Schwartz Communications of the ACM, 2020.

- Evaluación de modelos de idiomas grandes capacitados en código . Mark Chen et al. No Journal, 2021.

- Documento de grandes corpus web de texto web: un estudio de caso sobre el colosal corpus de rastreo limpio . Jesse Dodge et al. ARXIV 2021. [Documento]

- Sobre las oportunidades y riesgos de los modelos fundamentales . Rishi Bommasani et al. ARXIV 2021. [Documento]

- Generalización sistemática similar a la humana a través de una red neuronal de meta-learning . Brenden M Lake et al. Nature, 2023. [Documento]

- Superbench está midiendo LLMS en la apertura: un análisis crítico . Equipo de Superbench. ARXIV 2023.

- Evaluación holística de modelos de idiomas . Percy Liang et al. ARXIV 2023. [Documento]

6.2.2 Evaluaciones actuales y sus limitaciones

- Escuadrón: más de 100,000 preguntas para la comprensión de la máquina del texto . Pranav Rajpurkar et al. ARXIV 2016. [Documento]

- Triviaqa: un conjunto de datos de desafío supervisado a gran escala para la comprensión de lectura . Mandar Joshi et al. ARXIV 2017. [Documento]

- Coqa: un desafío de respuesta a preguntas de conversación . Siva Reddy et al. Transacciones de la Asociación de Lingüística Computacional, 2019.

- Evaluación de robustez precisa, confiable y rápida . Wieland Brendel et al. Neurips 2019. [Documento]

- Medición de la comprensión masiva del lenguaje multitarea . Dan Hendrycks et al. ARXIV 2020. [Documento]

- Evaluar la robustez y la estabilidad del modelo al cambio de conjunto de datos . Adarsh Subbaswamy et al. Presentado en la Conferencia Internacional sobre Inteligencia y Estadísticas Artificiales, 2021. Paper

- MMDIALOG: un conjunto de datos de diálogo múltiple a gran escala para una conversación multimodal de dominio abierto . Jiazhan Feng et al. ARXIV 2022. [Documento]

- Autoestructo: alineando modelos de lenguaje con instrucciones autogeneradas . Yizhong Wang et al. ARXIV 2022. [Documento]

- Super NaturalInstrucciones: Generalización a través de instrucciones declarativas en más de 1600 tareas de PNLP . Yizhong Wang et al. ARXIV 2022. [Documento]

- Análisis holístico de la alucinación en GPT-4V (ISion): desafíos de sesgo y interferencia . Chenhang Cui et al. ARXIV 2023. [Documento]

- Evaluación de la robustez a las instrucciones de modelos de idiomas grandes . Yuansheng Ni et al. ARXIV 2023. [Documento]

- Gaia: un punto de referencia para asistentes generales de IA . Grégoire Mialon et al. ARXIV 2023. [Documento]

- Un marco de evaluación integral para la robustez del modelo profundo . Jun Guo et al. Reconocimiento de patrones, 2023. [Documento]

- Agieval: un punto de referencia centrado en el ser humano para evaluar modelos de base . Wanjun Zhong et al. ARXIV 2023. [Documento]

- MMMU: un punto de referencia de comprensión multimodal multidisciplina masiva y referencia de razonamiento para AGI experto . Xiang et al. ARXIV 2023. [Documento]

- Evaluación de la creatividad del modelo de lenguaje grande desde una perspectiva literaria . Murray Shanahan et al. ARXIV 2023. [Documento]

- AgentBench: Evaluación de LLM . Xiao Liu et al. ICLR 2024. [Documento]

- Evaluar y comprender la creatividad en modelos de idiomas grandes . Yunpu Zhao et al. ARXIV 2024. [Documento]

- Juzgando LLM-As-A-Judge con MT Bench y Chatbot Arena . Lianmin Zheng et al. Neurips 2024. [Documento]

6.5 Consideraciones adicionales durante el desarrollo AGI

- Desafíos fundamentales para asegurar la alineación y la seguridad de los grandes modelos de idiomas . Usman Anwar et al. ARXIV 2024. [Documento]

- Las mejores prácticas y lecciones aprendidas sobre datos sintéticos para modelos de lenguaje . Ruibo Liu et al. ARXIV 2024. [Documento]

- Avance de la inteligencia social en agentes de IA: desafíos técnicos y preguntas abiertas . Leena Mathur et al. ARXIV 2024. [Documento]

7. Estudios de casos

7.1 AI para descubrimiento e investigación de ciencias

- Predicción de estructura de proteínas altamente precisa con Alfafold . Jumper, John et al. Nature, 2021. [Documento]

- Descubrimiento científico automatizado: desde el descubrimiento de la ecuación hasta los sistemas de descubrimiento autónomos . Kramer, Stefan et al. ARXIV 2023. [Documento]

- Predecir los efectos de las variantes no codificantes con el modelo de secuencia basado en el aprendizaje profundo . Zhou, Jian et al. Nature Methods, 2015. [[Documento] (https://www.ncbi.nlm.nih.gov/pmc/articles/pmc4768299/]

- Aprendiendo a ver la física a través de la desanimación visual . Wu, Jiajun et al. Neurips 2017. [Documento]

- Aprendizaje profundo para la detección de ondas gravitacionales en tiempo real y la estimación de parámetros: resultados con datos de LIGO avanzados . George, Daniel et al. Physics Letters B, 2018. [Documento]

- Identificación de transiciones de fase cuántica con redes neuronales adversas . Rem, Bart-Jan et al. Nature Physics, 2019. [Documento]

- Openagi: cuando LLM conoce a expertos en dominios . GE, Yingqiang et al. Neurips, 2023. [Documento]

- De materia oscura a galaxias con redes convolucionales . Zhang, Xinyue et al. ARXIV 2019. [Documento]

- Optimización global de la dinámica cuántica con la exploración profaz de Alphazero . Dalgaard, Mogens et al. Información cuántica NPJ, 2020. [Documento]

- Aprender a explotar la estructura temporal para el procesamiento de la visión biomédica . Shruthi Bannur et al. CVPR, 2023. [Documento]

- Mathbert: un modelo de idioma previamente capacitado para tareas generales de la PNL en educación matemática . Shen, Jia Tracy et al. ARXIV 2021. [Documento]

- Optimización molecular utilizando modelos de lenguaje . Maziarz, Krzysztof et al. ARXIV 2022. [Documento]

- Retrotrae: traducción retrosintética de entornos atómicos con transformador . Ucak, Umit Volkan et al. No Journal, 2022. [Documento]

- Scholarbert: Más grande no siempre es mejor . Hong, Zhi et al. ARXIV 2022. [Documento]

- Galactica: un modelo de lenguaje grande para la ciencia . Taylor, Ross et al. ARXIV 2022. [Documento]

- Declaración de matemáticas formales Aprendizaje del plan de estudios . Polu, Stanislas et al. ARXIV 2022. [Documento]

- Training de artefacto de prueba para la prueba del teorema con modelos de idiomas . Jesse Michael Han et al. ICLR 2022. [Documento]

- Resolver problemas de razonamiento cuantitativo con modelos de idiomas . Lewkowycz, Aitor et al. ARXIV 2022. [Documento]

- Biogpt: transformador generativo previamente capacitado para la generación y minería de texto biomédico . Luo, Renqian et al. Informes en bioinformática, 2022.

- Chemcrow: Aumento de modelos de gran lenguaje con herramientas de química . Bran, Andrés M et al. ARXIV 2023. [Documento]

- Investigación química autónoma con grandes modelos de idiomas . Boiko, Daniil A et al. Nature, 2023. [Documento]

- Capacidades de investigación científica autónoma emergente de modelos de idiomas grandes . Daniil A. Boiko et al. ARXIV 2023. [Documento]

- MathPrompter: razonamiento matemático utilizando modelos de idiomas grandes . Imani, Shima, et al. Presentado en Actas de la 61ª Reunión Anual de la Asociación de Lingüística Computacional (Volumen 5: Track Industry), 2023. [Documento]

- Aprender a explotar la estructura temporal para el procesamiento de la visión biomédica . Shruthi Bannur et al. ARXIV 2023. [Documento]

- LLMS para la ciencia: uso para la generación de códigos y el análisis de datos . Nejjar, Mohamed et al. ARXIV 2023. [Documento]

- Medagentes: modelos de idiomas grandes como colaboradores para el razonamiento médico de disparo cero . Xiangru Tang et al. ARXIV 2024. [Documento]

7.2 Inteligencia visual generativa

- Aprendizaje profundo sin supervisión utilizando termodinámica de no equilibrio . Jascha Sohl-Dickstein et al. ICML 2015. [Documento]

- Modelado generativo al estimar los gradientes de la distribución de datos . Yang Song et al. Neurips 2019. [Documento]

- Modelos probabilísticos de difusión de difusión . Jonathan Ho et al. Neurips 2020. [Documento]

- Modelado generativo basado en puntaje a través de ecuaciones diferenciales estocásticas . Yang Song et al. ICLR 2021. [Documento]

- Glide: hacia la generación de imágenes fotorrealistas y la edición con modelos de difusión guiados por texto . Alex Nichol et al. ICML 2022. [Documento]

- SDEDIT: síntesis de imágenes guiadas y edición con ecuaciones diferenciales estocásticas . Chenlin Meng et al. ICLR 2022. [Documento]

- Modelos de difusión de video . Jonathan Ho et al. Neurips 2022. [Documento]

- Generación jerárquica de imágenes condicionales de texto con clip latentes . Aditya Ramesh et al. ARXIV 2022. [Documento]

- Guía de difusión sin clasificador . Jonathan Ho et al. ARXIV 2022. [Documento]

- Paleta: modelos de difusión de imagen a imagen . Chitwan Saharia et al. Siggraph 2022. [Documento]

- Síntesis de imagen de alta resolución con modelos de difusión latente . Robin Rombach et al. CVPR 2022. [Documento]

- Agregar control condicional a modelos de difusión de texto a imagen . Lvmin Zhang et al. ICCV 2023. [Documento]

- Modelos de difusión escalables con transformadores . William Peebles et al. ICCV 2023. [Documento]

- El modelado secuencial permite el aprendizaje escalable para modelos de visión grandes . Yutong Bai et al. ARXIV 2023. [Documento]

- Modelos de generación de videos como simuladores mundiales . Tim Brooks et al. OpenAI 2024. [Documento]

7.3 modelos mundiales

- Aprendiendo a ver la física a través de la desanimación visual . Wu, Jiajun et al. Neurips 2017. [Documento]

- Aprendizaje seguro de refuerzo basado en modelos con garantías de estabilidad . Berkenkamp, Felix et al. Neurips, 2017. [Documento]

- SIMNET: Aprender modelos mundiales basados en simulación para razonamiento físico . Vicol, Paul, Menapace et al. ICLR 2022. [Documento]

- Dreamix: Dreamfusion a través de la mezcla iterativa espacio -temporal . Khalifa, Anji et al. ARXIV 2022. [Documento]

- Agente de IA encarnado de uso general a través del aprendizaje de refuerzo con conocimiento a escala de Internet . Guo, Xiaoxiao et al. ARXIV 2022. [Documento]

- VQGAN-Clip: generación de imágenes de dominio abierto y edición con orientación del lenguaje natural . Crowson, Katherine. ARXIV 2022. [Documento]

- Un camino hacia la inteligencia de la máquina autónoma . Lecun Yann OpenReview, 2022. [Documento]

- Los modelos de idiomas se encuentran con modelos mundiales: las experiencias encarnadas mejoran los modelos de idiomas . Jiannan Xiang et al. Neurips 2023. [Documento]

- Dominar diversos dominios a través de modelos mundiales . Hafner, Danijar et al. ARXIV 2023. [Documento]

- Adquisición de modelos multimodales a través de la recuperación . Reed, Scott et al. ARXIV 2023. [Documento]

- Modelos de lenguaje como planificadores de disparo cero: extrayendo conocimiento procesable para agentes incorporados . Dohan, David et al. ARXIV 2023. [Documento]

- Modelos de idiomas, modelos de agentes y modelos mundiales: la ley para el razonamiento y la planificación de las máquinas . Zhiting Hu et al. ARXIV 2023. [Documento]

- El razonamiento con el modelo de idioma es planificar con el modelo mundial . Hao, Shibo et al. ARXIV 2023. [Documento]

- Metasim: Aprendiendo a generar conjuntos de datos sintéticos . Zhang, Yuxuan et al. ARXIV 2023. [Documento]

- Modelo mundial en video y lenguaje de un millón con atención . Hao Liu et al. ARXIV 2024. [Documento]

- Genio: entornos interactivos generativos . Jake Bruce et al. ARXIV 2024. [Documento]

7.4 LLM descentralizado

- Pétalos: inferencia colaborativa y ajuste fino de modelos grandes . Alexander Borzunov et al. ARXIV 2022. [Documento]

- Blockchain para el aprendizaje profundo: revisar y abrir desafíos . Los tiempos económicos. Cluster Computing 2021. [Documento]

- Flexgen: inferencia generativa de alto rendimiento de modelos de lenguaje grande con una sola GPU . Ying Sheng et al. ARXIV 2023. [Documento]

- Entrenamiento descentralizado de modelos de base en entornos heterogéneos . Binhang Yuan et al. ARXIV 2023. [Documento]

7.5 Ai para codificar

- Un marco para la evaluación de modelos de generación de código . Ben Allal et al. Github, 2023. [Código]

- Evaluación de modelos de idiomas grandes capacitados en código . Mark Chen et al. ARXIV 2021. [Documento]

- Síntesis del programa con grandes modelos de idiomas . Jacob Austin et al. ARXIV 2021. [Documento]

- Generación de código a nivel de competencia con alfacodo . Yujia Li et al. Science, 2022. [Documento]

- Capacitación eficiente de modelos de idiomas para llenar el medio . Mohammad Bavarian et al. ARXIV 2022. [Documento]

- Santacoder: ¡No alcances las estrellas! . Loubna Ben Allal et al. Mind, 2023. [Documento]

- Starcoder: ¡Que la fuente esté contigo! . Raymond Li et al. ARXIV 2023. [Documento]

- Modelos de idiomas grandes para la optimización del compilador . Chris Cummins et al. ARXIV 2023. [Documento]

- Los libros de texto son todo lo que necesitas . Suriya Gunasekar et al. ARXIV 2023. [Documento]

- Intercode: estandarización y evaluación comparativa de codificación interactiva con comentarios de ejecución . John Yang et al. ARXIV 2023. [Documento]

- Aprendizaje de refuerzo de la retroalimentación automática para la generación de pruebas unitarias de alta calidad . Benjamin Steenhoek et al. ARXIV 2023. [Documento]

- Incoder: un modelo generativo para el relleno y síntesis de código . Daniel Fried et al. ARXIV 2023. [Documento]

- Refinar el código C descompilado con modelos de idiomas grandes . Wai Kin Wong et al. ARXIV 2023. [Documento]

- SWE BENCH: ¿Pueden los modelos de idiomas resolver el mundo real?