Admite salida de transmisión de alta velocidad, diálogo de múltiples rondas, implementación sin configuración y compatibilidad con tokens multicanal.

Totalmente compatible con la interfaz ChatGPT.

También hay las siguientes ocho API gratuitas a las que debes prestar atención:

Interfaz Moonshot AI (Kimi.ai) para API kimi-free-api

Interfaz Zhipu AI (Zhipu Qingyan) para API glm-free-api

Interfaz StepChat para API step-free-api

Interfaz de Alibaba Tongyi (Qwen) para API qwen-free-api

Interfaz Metaso AI (Metaso) para API metaso-free-api

Interfaz Iflytek Spark para API sin chispa

Interfaz MiniMax (Conch AI) para API hailuo-free-api

Interfaz de Lingxin Intelligence (Emohaa) para API emohaa-free-api

La API inversa es inestable. Se recomienda ir al https://platform.deepseek.com/ oficial de DeepSeek para pagar y usar la API para evitar el riesgo de ser prohibido.

Esta organización y los individuos no aceptan donaciones ni transacciones financieras. ¡Este proyecto es puramente para investigación, intercambio y aprendizaje!

Es solo para uso personal y está prohibido proporcionar servicios externos o uso comercial para evitar presionar al servicio oficial, de lo contrario es bajo su propio riesgo.

Es solo para uso personal y está prohibido proporcionar servicios externos o uso comercial para evitar presionar al servicio oficial, de lo contrario es bajo su propio riesgo.

Es solo para uso personal y está prohibido proporcionar servicios externos o uso comercial para evitar presionar al servicio oficial, de lo contrario es bajo su propio riesgo.

https://udify.app/chat/IWOnEupdZcfCN0y7

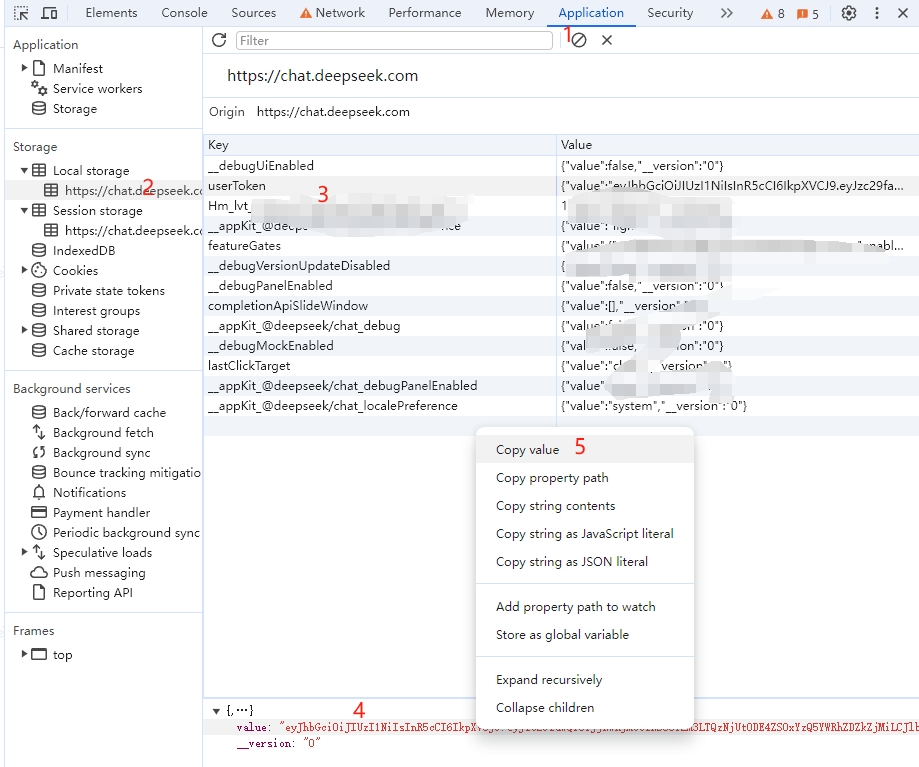

Obtenga el valor de userToken de DeepSeek

Ingrese a DeepSeek para iniciar una conversación, luego abra las herramientas de desarrollador con F12 y busque el valor en userToken en Aplicación > LocalStorage. Esto se usará como el valor del token de portador de Autorización: Authorization: Bearer TOKEN

Actualmente, la misma cuenta solo puede tener una salida al mismo tiempo. Puede proporcionar valores de token de usuario de varias cuentas , utilizarlos para proporcionar:

Authorization: Bearer TOKEN1,TOKEN2,TOKEN3

Se seleccionará uno de estos cada vez que se solicite el servicio.

Prepare un servidor con una IP pública y abra el puerto 8000.

Extraiga la imagen e inicie el servicio.

docker run -it -d --init --name deepseek-free-api -p 8000:8000 -e TZ=Asia/Shanghai vinlic/deepseek-free-api:latestVer registros de servicio en tiempo real

docker logs -f deepseek-free-apiReiniciar servicio

docker restart deepseek-free-apidetener el servicio

docker stop deepseek-free-api version : ' 3 '

services :

deepseek-free-api :

container_name : deepseek-free-api

image : vinlic/deepseek-free-api:latest

restart : always

ports :

- " 8000:8000 "

environment :

- TZ=Asia/ShanghaiNota: Es posible que algunas áreas de implementación no puedan conectarse a Deepseek. Si el registro del contenedor muestra un tiempo de espera de solicitud o no se puede conectar, cambie a otras áreas para la implementación. Nota: La instancia de contenedor de la cuenta gratuita dejará de ejecutarse automáticamente después de un período de inactividad, lo que provocará un retraso de 50 segundos o más en la siguiente solicitud. Se recomienda marcar Renderizar contenedor para mantener vivo.

Bifurca este proyecto en tu cuenta de github.

Visita Render e inicia sesión en tu cuenta de github.

Cree su servicio web (Nuevo+ -> Compile e implemente desde un repositorio Git -> Conecte su proyecto bifurcado -> Seleccione el área de implementación -> Seleccione el tipo de instancia como Gratis -> Crear servicio web).

Después de esperar a que se complete la construcción, copie el nombre de dominio asignado y empalme la URL para acceder.

Nota: El tiempo de espera de respuesta de la solicitud para las cuentas gratuitas de Vercel es de 10 segundos, pero la respuesta de la interfaz suele tardar más y es posible que Vercel muestre un error de tiempo de espera 504.

Primero asegúrese de haber instalado el entorno Node.js.

npm i -g vercel --registry http://registry.npmmirror.com

vercel login

git clone https://github.com/LLM-Red-Team/deepseek-free-api

cd deepseek-free-api

vercel --prodPrepare un servidor con una IP pública y abra el puerto 8000.

Primero instale el entorno Node.js, configure las variables de entorno y confirme que el comando de nodo esté disponible.

Instalar dependencias

npm iInstale PM2 para proteger el proceso

npm i -g pm2Compile y construya. Cuando vea el directorio dist, la compilación estará completa.

npm run buildIniciar servicio

pm2 start dist/index.js --name " deepseek-free-api "Ver registros de servicio en tiempo real

pm2 logs deepseek-free-apiReiniciar servicio

pm2 reload deepseek-free-apidetener el servicio

pm2 stop deepseek-free-api¡Es más rápido y fácil utilizar el siguiente cliente de desarrollo secundario para acceder a los proyectos de la serie API gratuita y admite la carga de documentos/imágenes!

LobeChat desarrollado por Clivia https://github.com/Yanyutin753/lobe-chat

ChatGPT Web https://github.com/SuYxh/chatgpt-web-sea desarrollado por Guangguang@

Actualmente, admite la interfaz /v1/chat/completions que es compatible con openai. Puede usar la interfaz de acceso de cliente que es compatible con openai u otros clientes, o usar servicios en línea como dify para acceder.

Interfaz de finalización de conversación, compatible con la API de finalización de chat de Openai.

ENVIAR /v1/chat/compleciones

El encabezado necesita establecer el encabezado de Autorización:

Authorization: Bearer [userToken value]

Solicitar datos:

{

// model必须为deepseek_chat或deepseek_code

"model" : " deepseek_chat " ,

"messages" : [

{

"role" : " user " ,

"content" : "你是谁? "

}

],

// 如果使用SSE流请设置为true,默认false

"stream" : false

}Datos de respuesta:

{

"id" : " " ,

"model" : " deepseek_chat " ,

"object" : " chat.completion " ,

"choices" : [

{

"index" : 0 ,

"message" : {

"role" : " assistant " ,

"content" : " 我是DeepSeek Chat,一个由中国深度求索公司开发的智能助手,基于人工智能技术构建,旨在通过自然语言处理和机器学习算法来提供信息查询、对话交流和解答问题等服务。我的设计理念是遵循社会主义核心价值观,致力于为用户提供准确、安全、有益的信息和帮助。 "

},

"finish_reason" : " stop "

}

],

"usage" : {

"prompt_tokens" : 1 ,

"completion_tokens" : 1 ,

"total_tokens" : 2

},

"created" : 1715061432

}Compruebe si el token de usuario está activo. Si está activo, no es verdadero; de lo contrario, es falso. No llame a esta interfaz con frecuencia (menos de 10 minutos).

PUBLICAR /token/cheque

Solicitar datos:

{

"token" : " eyJhbGciOiJIUzUxMiIsInR5cCI6IkpXVCJ9... "

}Datos de respuesta:

{

"live" : true

}Si está utilizando el proxy inverso de Nginx deepseek-free-api, agregue los siguientes elementos de configuración para optimizar el efecto de salida de la transmisión y optimizar la experiencia.

# 关闭代理缓冲。当设置为off时,Nginx会立即将客户端请求发送到后端服务器,并立即将从后端服务器接收到的响应发送回客户端。

proxy_buffering off ;

# 启用分块传输编码。分块传输编码允许服务器为动态生成的内容分块发送数据,而不需要预先知道内容的大小。

chunked_transfer_encoding on ;

# 开启TCP_NOPUSH,这告诉Nginx在数据包发送到客户端之前,尽可能地发送数据。这通常在sendfile使用时配合使用,可以提高网络效率。

tcp_nopush on ;

# 开启TCP_NODELAY,这告诉Nginx不延迟发送数据,立即发送小数据包。在某些情况下,这可以减少网络的延迟。

tcp_nodelay on ;

# 设置保持连接的超时时间,这里设置为120秒。如果在这段时间内,客户端和服务器之间没有进一步的通信,连接将被关闭。

keepalive_timeout 120 ;Dado que el lado de inferencia no está en deepseek-free-api, el token no se puede contar y se devolverá como un número fijo.