llm agent

1.0.0

LLM basado en RAG que utiliza memoria a largo plazo a través de una base de datos vectorial

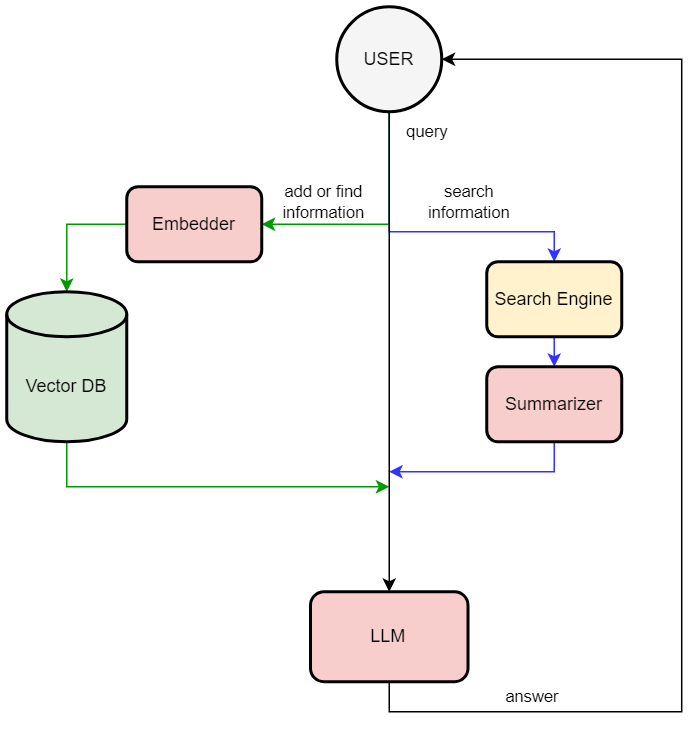

Este repositorio permite que el modelo de lenguaje grande utilice la memoria a largo plazo a través de una base de datos vectorial (este método se llama RAG (Generación Aumentada de Recuperación); es una técnica que permite a LLM recuperar datos de una base de datos externa). La aplicación está construida con mistral-7b-instruct-v0.2.Q4_K_M.gguf (usando el enlace LLAMA_cpp_python) y chromadb. El usuario puede solicitar en lenguaje natural agregar información a la base de datos, buscar información en la base de datos o en Internet utilizando la guía.

You > Hi

LOG: [Response]

Bot < Hello! How can I assist you today?

You > Please add information to db "The user name is Rustam Akimov"

LOG: [Adding to memory]

Bot < Done!

You > Can you find on the Internet who is Pavel Durov

LOG: [Extracting question]

LOG: [Searching]

LOG: [Summarizing]

Bot < According to the search results provided, Pavel Durov is a Russian entrepreneur who co-founded Telegram Messenger Inc.

You > Please find information in db who is Rustam Akimov

LOG: [Extracting question]

LOG: [Querying memory]

Bot < According to the input memories, your name is Rustam Akimov.