DeveloperGPT es una herramienta de línea de comandos basada en LLM que habilita el lenguaje natural para los comandos de terminal y el chat en la terminal. DeveloperGPT funciona con Google Gemini 1.5 Flash de forma predeterminada, pero también es compatible con Google Gemini 1.0 Pro, OpenAI GPT-3.5 y GPT-4, Anthropic Claude 3 Haiku & Sonnet, LLM abiertos (Zephyr, Gemma, Mistral) alojados en Hugging Face y cuantificados. Mistral-7B-Instruct ejecutándose sin conexión en el dispositivo.

A partir de junio de 2024, DeveloperGPT es de uso completamente gratuito cuando se utiliza Google Gemini 1.5 Pro (usado de forma predeterminada) o Google Gemini 1.0 Pro con hasta 15 solicitudes por minuto.

Cambie entre diferentes LLM usando el indicador --model : developergpt --model [llm_name] [cmd, chat]

| Modelo(s) | Fuente | Detalles |

|---|---|---|

| Gemini Pro , Gemini Flash (predeterminado) | Google Géminis 1.0 Pro, Géminis 1.5 Flash | Gratis (hasta 15 solicitudes/min), se requiere clave API de Google AI |

| GPT35, GPT4 | Abierto AI | Pago por uso, se requiere clave API OpenAI |

| Haiku, soneto | Antrópico (Claude 3) | Pago por uso, se requiere clave API antrópica |

| Céfiro | Zephyr7B-Beta | LLM abierto y gratuito, API de inferencia de cara de abrazo |

| Gemma, Gemma-Base | Gemma-1.1-7B-Instrucción, Gemma-Base | LLM abierto y gratuito, API de inferencia de cara de abrazo |

| Mistral-Q6, Mistral-Q4 | Instrucción GGUF Mistral-7B cuantificada | LLM gratuito, abierto, SIN CONEXIÓN, EN EL DISPOSITIVO |

| Mistral | Mistral-7B-Instruir | LLM abierto y gratuito, API de inferencia de cara de abrazo |

mistral-q6 y mistral-q4 son LLM GGUF Mistral-7B-Instruct cuantificados que se ejecutan localmente en el dispositivo usando llama.cpp (modelos cuantificados Q6_K y Q4_K respectivamente). Estos LLM pueden ejecutarse en máquinas sin una GPU dedicada; consulte llama.cpp para obtener más detalles.DeveloperGPT tiene 2 características principales.

Uso: developergpt cmd [your natural language command request]

# Example

$ developergpt cmd list all git commits that contain the word llm

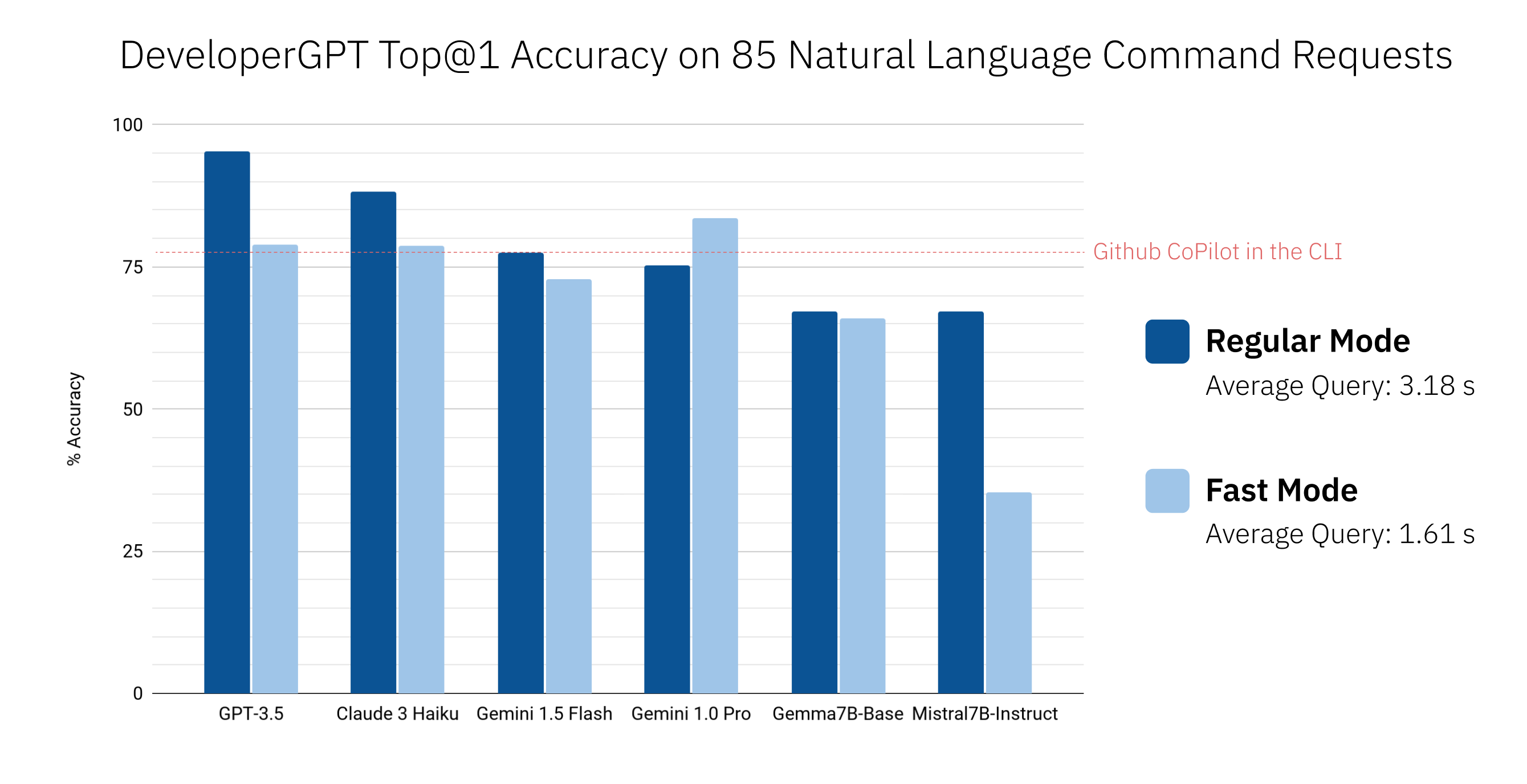

Utilice developergpt cmd --fast para obtener comandos más rápido sin explicaciones (~1,6 segundos con --fast frente a ~3,2 segundos con regular en promedio). Los comandos proporcionados por DeveloperGPT en modo --fast pueden ser menos precisos; consulte Precisión de comandos del lenguaje natural al terminal de DeveloperGPT para obtener más detalles.

# Fast Mode: Commands are given without explanation for faster response

$ developergpt cmd --fast [your natural language command request] Utilice developergpt --model [model_name] cmd para utilizar un LLM diferente en lugar de Gemini Flash (utilizado de forma predeterminada).

# Example: Natural Language to Terminal Commands using the GPT-3.5 instead of Gemini Flash

$ developergpt --model gpt35 cmd [your natural language command request] Uso: developergpt chat

# Chat with DeveloperGPT using Gemini 1.5 Flash (default)

$ developergpt chat

Utilice developergpt --model [model_name] chat para utilizar un LLM diferente.

# Example

$ developergpt --model mistral chatLa moderación del chat NO está implementada: todos sus mensajes de chat deben seguir los términos de uso del LLM utilizado.

DeveloperGPT NO debe utilizarse para ningún propósito prohibido por los términos de uso de los LLM utilizados. Además, DeveloperGPT en sí (aparte de los LLM) es una herramienta de prueba de concepto y no está destinada a ningún trabajo serio o comercial.

pip install -U developergpt # see available commands

$ developergpt La precisión de DeveloperGPT varía según el LLM utilizado y el modo ( --fast frente a regular). A continuación se muestra la precisión Top@1 de diferentes LLM en un conjunto de 85 solicitudes de comandos en lenguaje natural (esta no es una evaluación rigurosa, pero da una idea aproximada de la precisión). También se incluye Github CoPilot en la CLI v1.0.1 para comparar.

De forma predeterminada, DeveloperGPT utiliza Google Gemini 1.5 Flash. Para utilizar Gemini 1.0 Pro o Gemini 1.5 Flash, necesitará una clave API (gratis para usar hasta 15 consultas por minuto).

GOOGLE_API_KEY . Sólo necesitas hacer esto una vez. # set Google API Key (using zsh for example)

$ echo ' export GOOGLE_API_KEY=[your_key_here] ' >> ~ /.zshenv

# reload the environment (or just quit and open a new terminal)

$ source ~ /.zshenv Para utilizar LLM abiertos como Gemma o Mistral alojados en Hugging Face, opcionalmente puede configurar un token de API de inferencia de Hugging Face como variable de entorno HUGGING_FACE_API_KEY . Consulte https://huggingface.co/docs/api-inference/index para obtener más detalles.

Para utilizar Mistral-7B-Instruct cuantificado, simplemente ejecute DeveloperGPT con el indicador --offline . Esto descargará el modelo en la primera ejecución y lo utilizará localmente en ejecuciones futuras (no se requiere conexión a Internet después del primer uso). No se requiere ninguna configuración especial.

developergpt --offline chatPara utilizar GPT-3.5 o GPT-4, necesitará una clave API de OpenAI.

OPENAI_API_KEY . Sólo necesitas hacer esto una vez. Para utilizar Anthropic Claude 3 Sonnet o Haiku, necesitará una clave API de Anthropic.

ANTHROPIC_API_KEY . Sólo necesitas hacer esto una vez.A partir de junio de 2024, Google Gemini 1.0 Pro y Gemini 1.5 Flash pueden utilizar de forma gratuita hasta 15 consultas por minuto. Para obtener más información, consulte: https://ai.google.dev/pricing

A partir de junio de 2024, el uso de LLM alojados en la API Hugging Face Inference es gratuito pero tiene una tarifa limitada. Consulte https://huggingface.co/docs/api-inference/index para obtener más detalles.

Mistral-7B-Instruct es de uso gratuito y se ejecuta localmente en el dispositivo.

Puede monitorear su uso de la API OpenAI aquí: https://platform.openai.com/account/usage. El costo promedio por consulta con GPT-3.5 es <0,1 centavos. No se recomienda el uso de GPT-4 ya que GPT-3.5 es mucho más rentable y logra una precisión muy alta para la mayoría de los comandos.

Puede monitorear su uso de Anthropic API aquí: https://console.anthropic.com/settings/plans. El costo promedio por consulta utilizando Claude 3 Haiku es <0,1 centavos. Consulte https://www.anthropic.com/api para obtener detalles sobre los precios.

Lea el archivo CONTRIBUTING.md.