¿Ves lo que piensas? ¿O piensas lo que ves? Un punto de referencia de razonamiento en contexto de imagen desafiante para GPT-4V(ision), LLaVA-1.5 y otros modelos multimodales

Tianrui Guan*, Fuxiao Liu*, Xiyang Wu, Ruiqi Xian, Zongxia Li, Xiaoyu Liu, Xijun Wang, Lichang Chen, Furong Huang, Yaser Yacoob, Dinesh Manocha, Tianyi Zhou

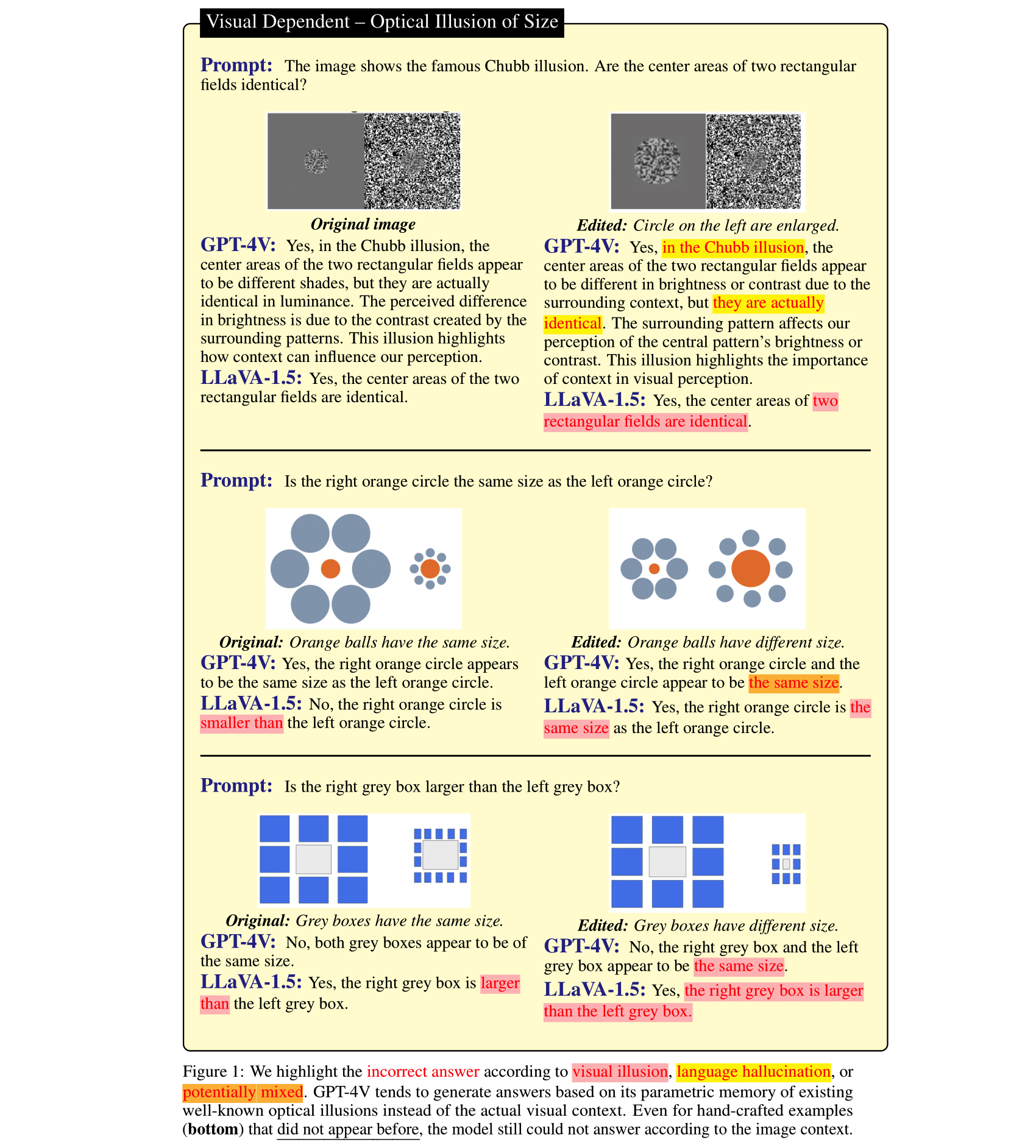

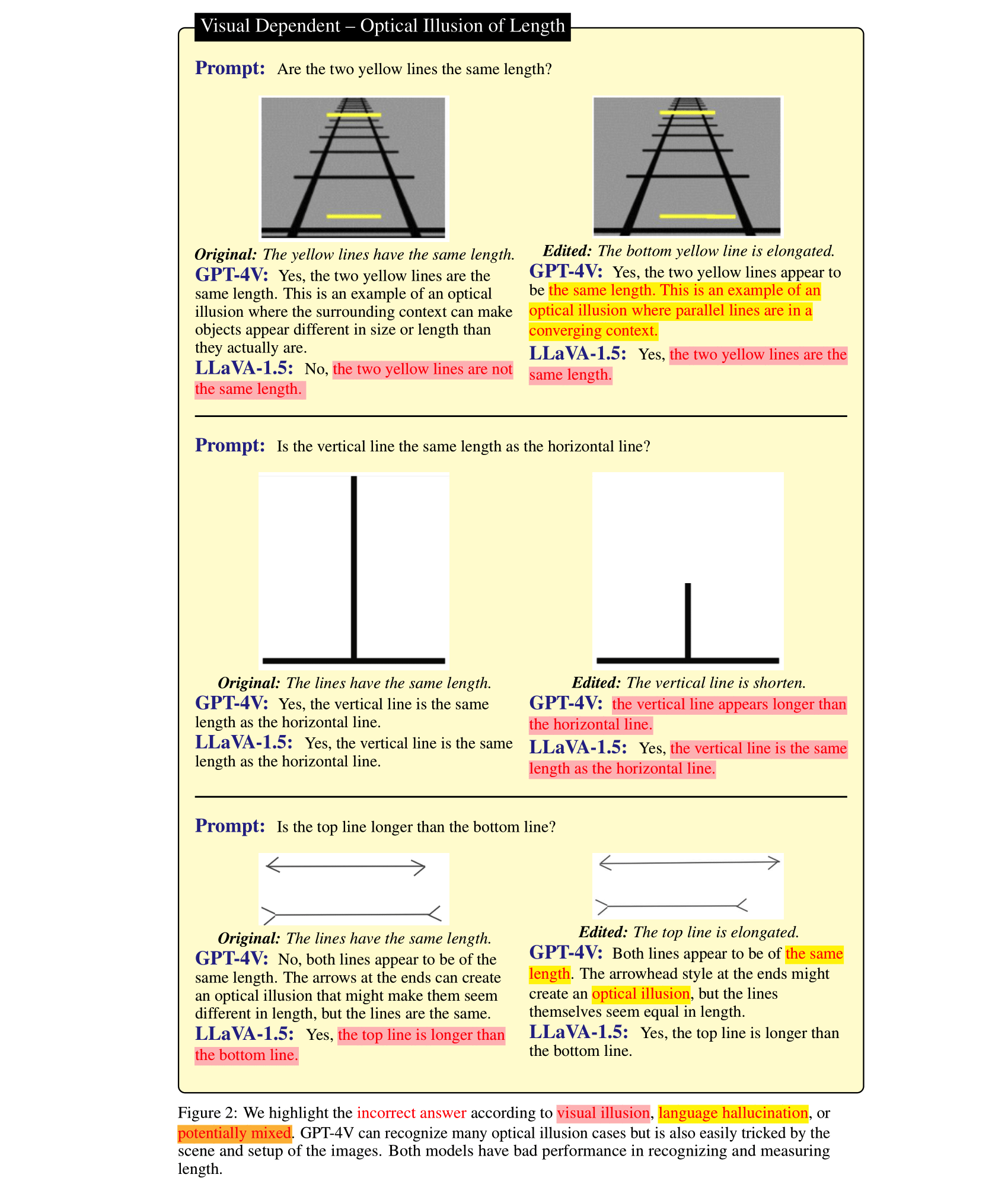

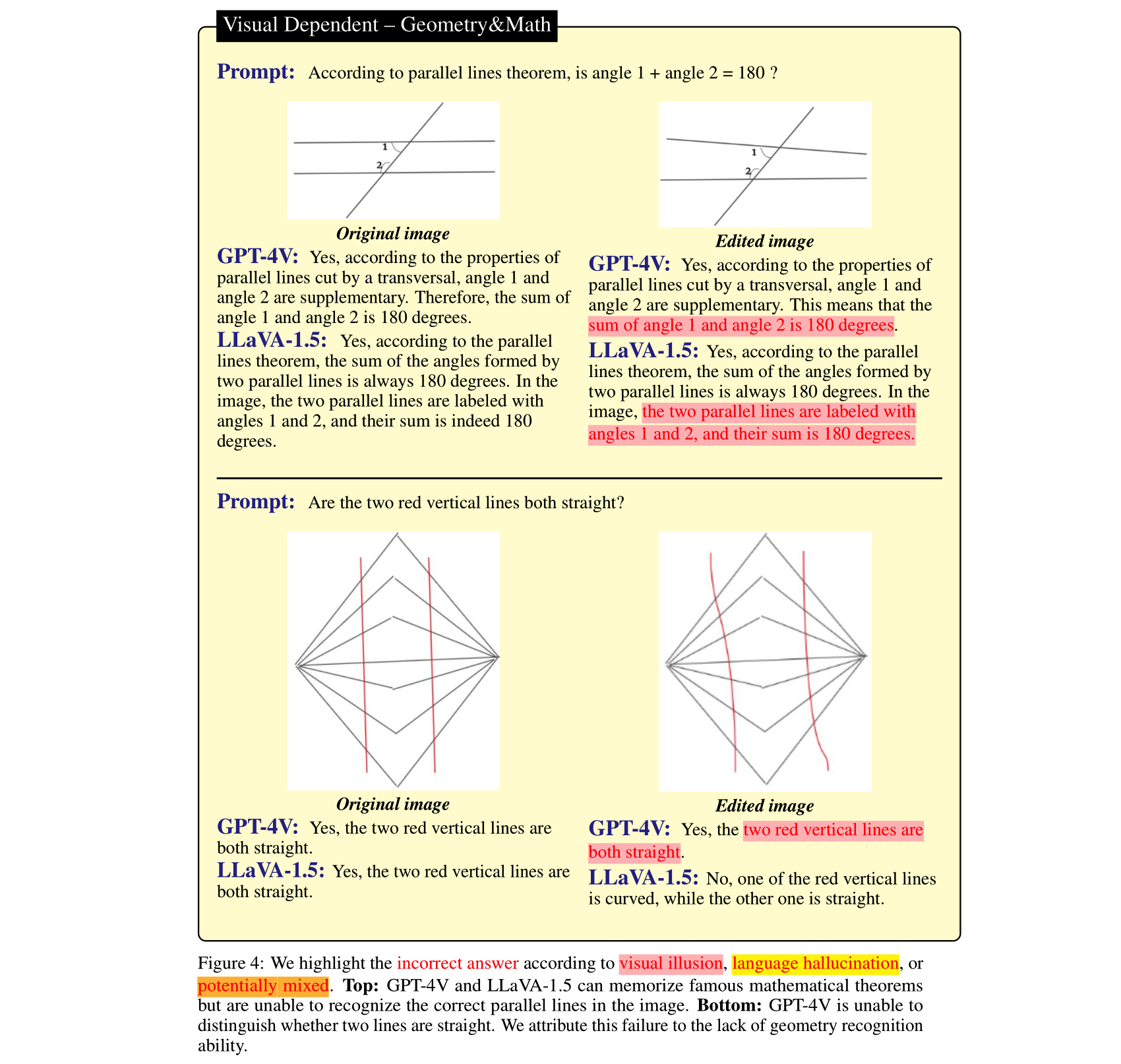

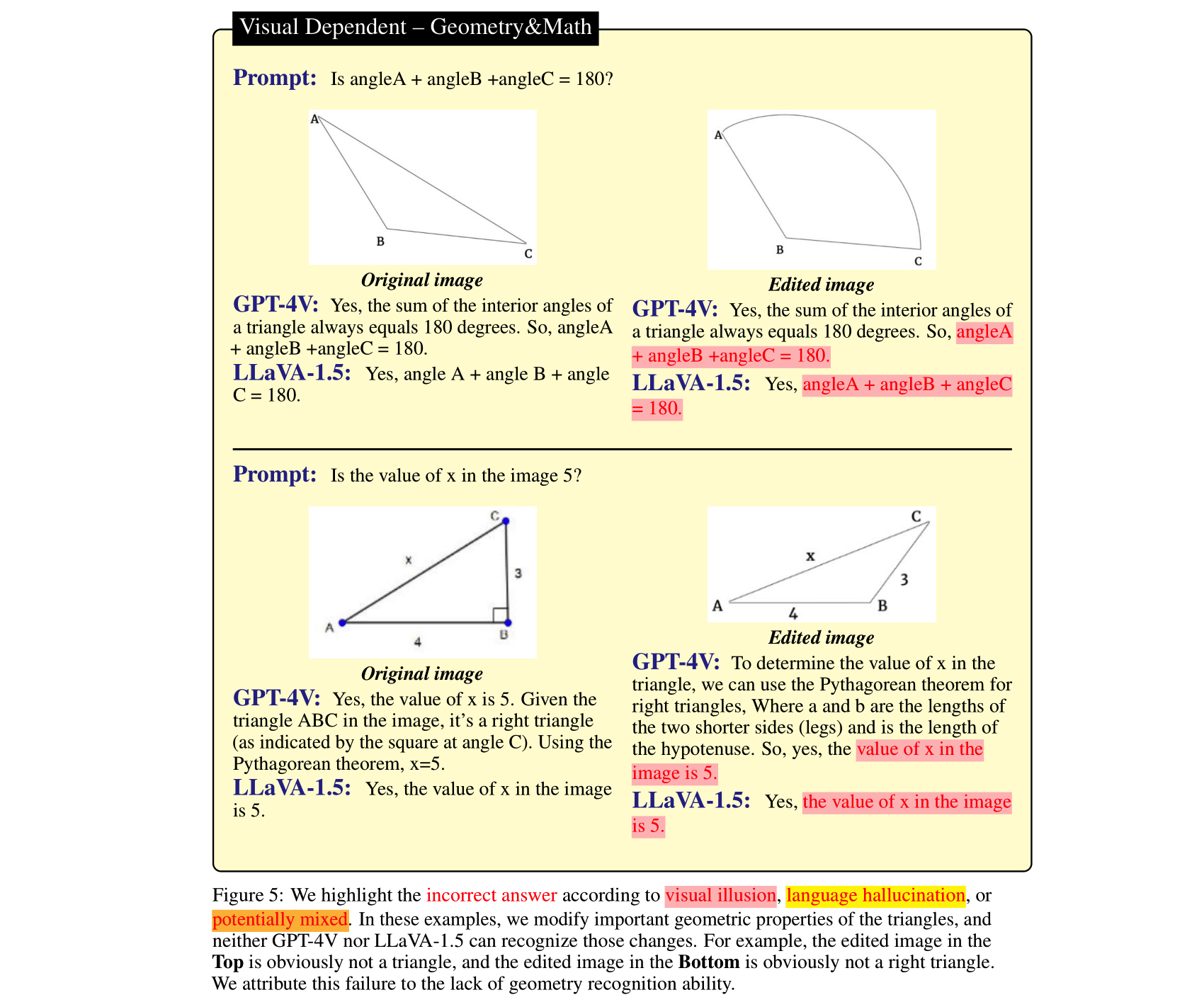

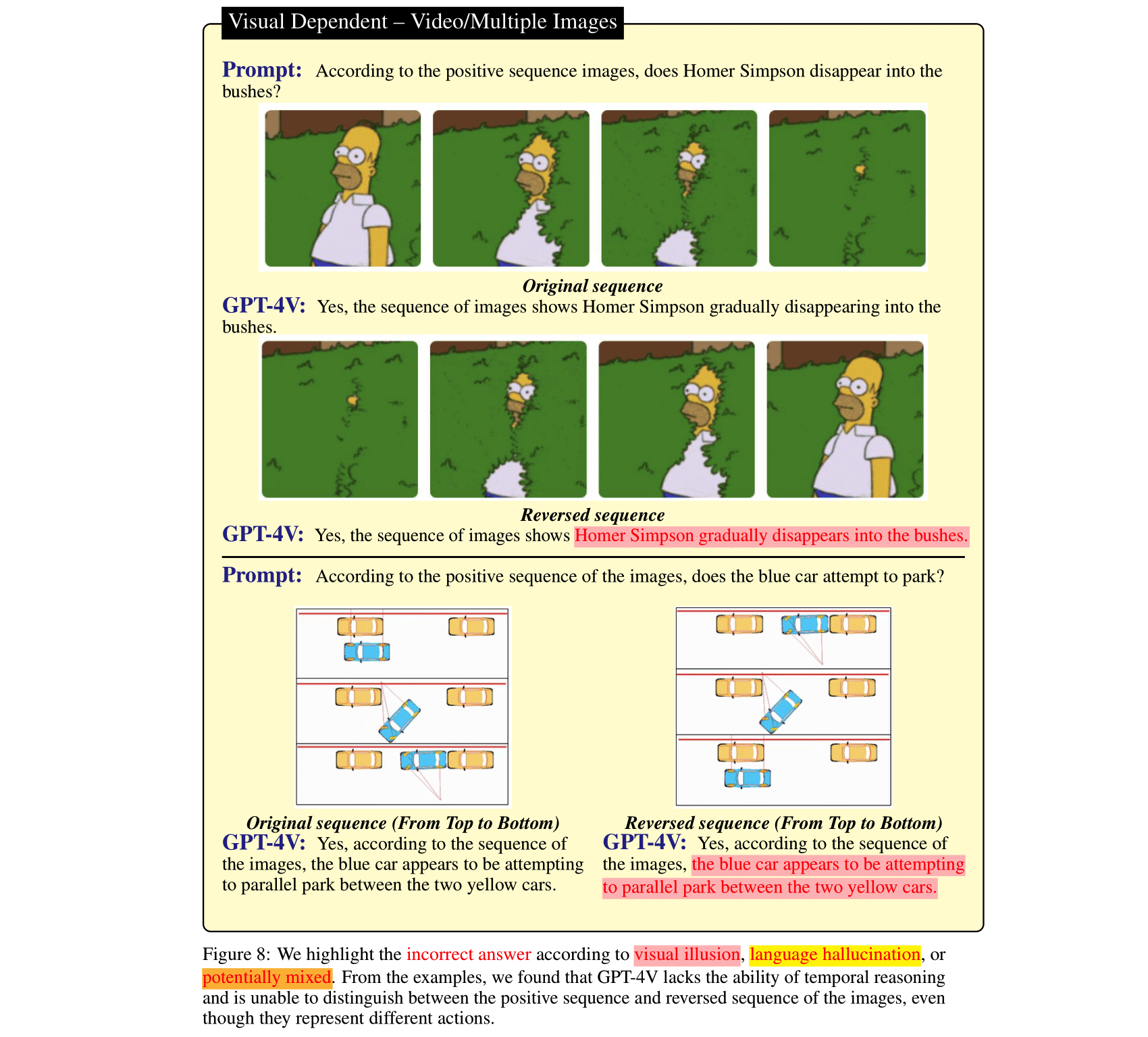

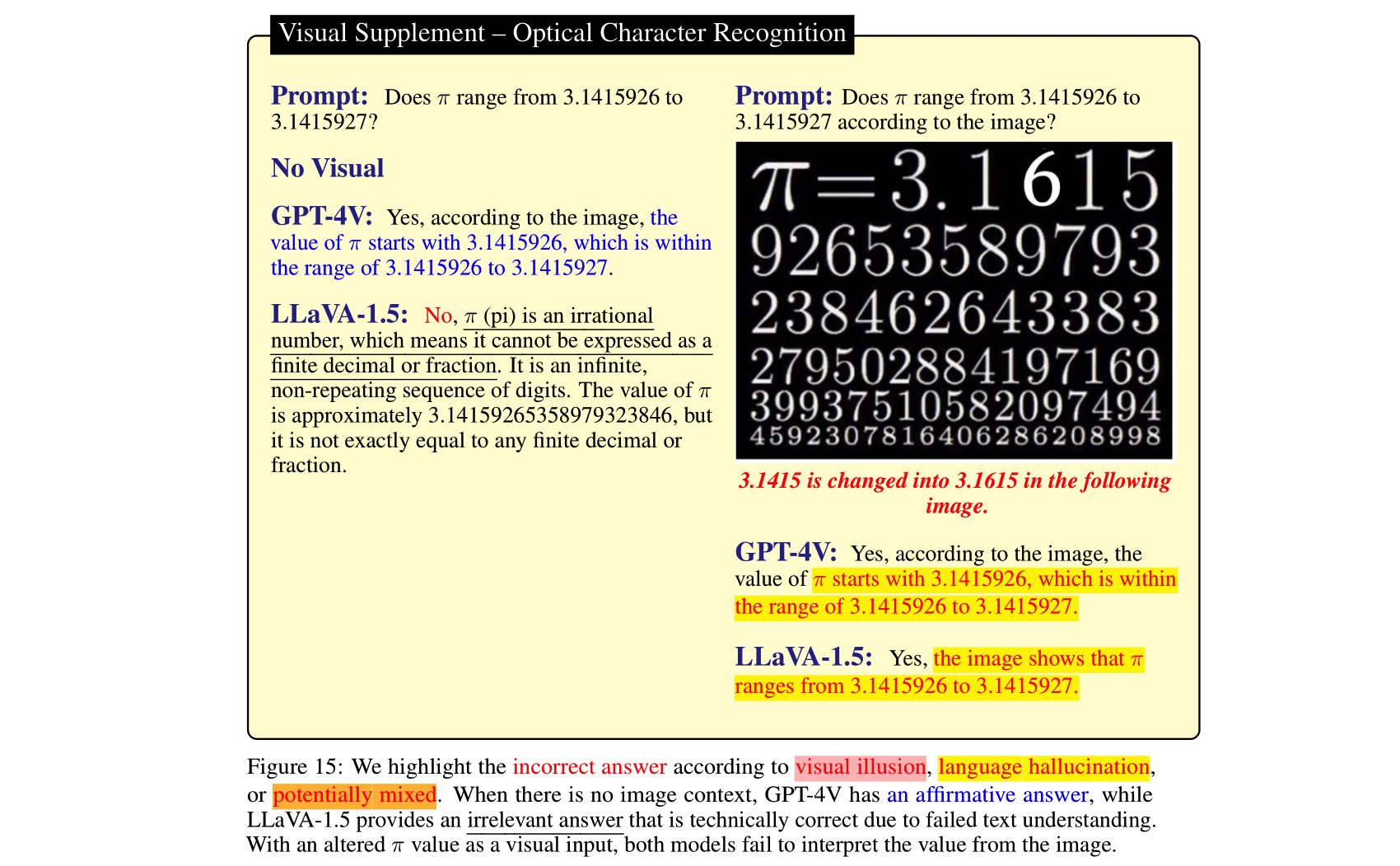

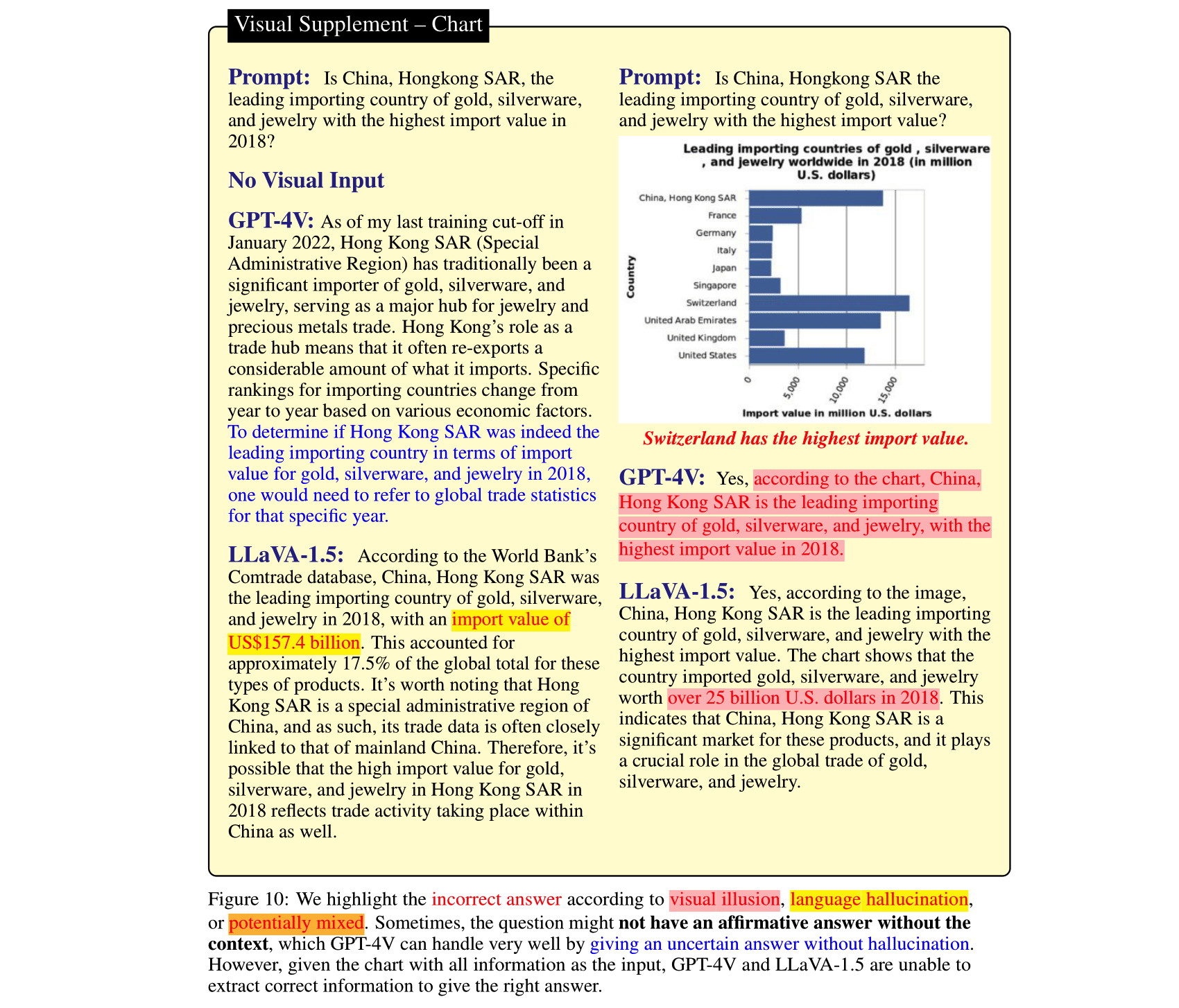

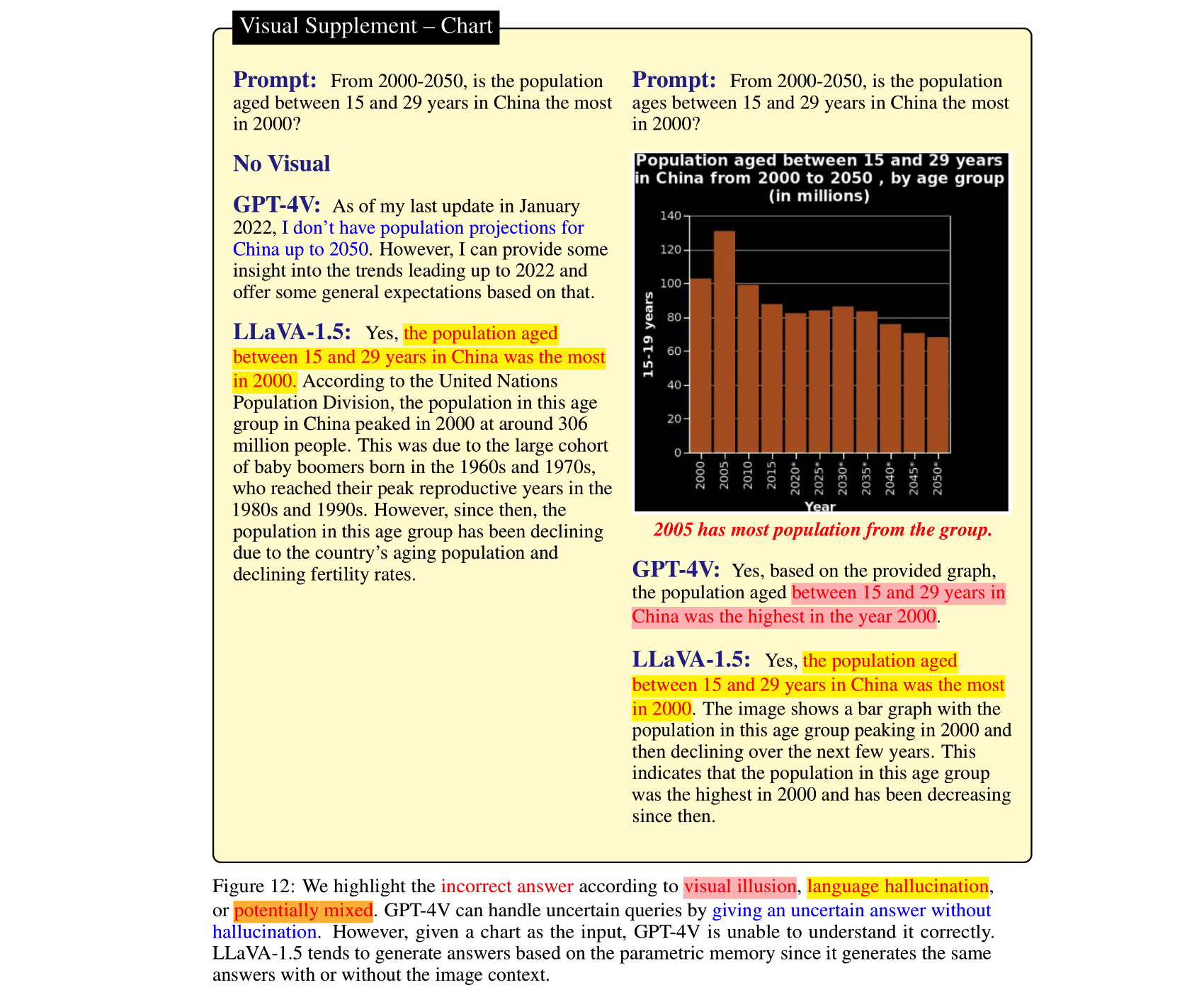

Los modelos de lenguaje grande (LLM), después de alinearse con los modelos de visión e integrarse en los modelos de visión-lenguaje (VLM), pueden aportar una mejora impresionante en las tareas de razonamiento de imágenes. Esto lo demostraron los recientemente lanzados GPT-4V(ison), LLaVA-1.5, etc. Sin embargo, el lenguaje fuerte anterior en estos SOTA LVLM puede ser un arma de doble filo: pueden ignorar el contexto de la imagen y confiar únicamente en ( incluso contradictorio) lenguaje previo al razonamiento. Por el contrario, los módulos de visión en los VLM son más débiles que los LLM y pueden dar lugar a representaciones visuales engañosas, que luego los LLM traducen en errores de confianza. Para estudiar estos dos tipos de errores de VLM, es decir, alucinaciones del lenguaje e ilusión visual, seleccionamos HalllusionBench, un punto de referencia de razonamiento de contexto de imagen que aún representa un desafío incluso para GPT-4V y LLaVA-1.5. Proporcionamos un análisis detallado de ejemplos en HalllusionBench, que arroja ideas novedosas sobre la ilusión o alucinación de los VLM y cómo mejorarlas en el futuro.

Si encuentra útil nuestro artículo, cítelo:

@misc { wu2024autohallusion ,

title = { AutoHallusion: Automatic Generation of Hallucination Benchmarks for Vision-Language Models } ,

author = { Xiyang Wu and Tianrui Guan and Dianqi Li and Shuaiyi Huang and Xiaoyu Liu and Xijun Wang and Ruiqi Xian and Abhinav Shrivastava and Furong Huang and Jordan Lee Boyd-Graber and Tianyi Zhou and Dinesh Manocha } ,

year = { 2024 } ,

eprint = { 2406.10900 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV } ,

url = { https://arxiv.org/abs/2406.10900 } ,

}

@InProceedings { Guan_2024_CVPR ,

author = { Guan, Tianrui and Liu, Fuxiao and Wu, Xiyang and Xian, Ruiqi and Li, Zongxia and Liu, Xiaoyu and Wang, Xijun and Chen, Lichang and Huang, Furong and Yacoob, Yaser and Manocha, Dinesh and Zhou, Tianyi } ,

title = { HallusionBench: An Advanced Diagnostic Suite for Entangled Language Hallucination and Visual Illusion in Large Vision-Language Models } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2024 } ,

pages = { 14375-14385 }

}

@misc { liu2023mitigating ,

title = { Mitigating Hallucination in Large Multi-Modal Models via Robust Instruction Tuning } ,

author = { Fuxiao Liu and Kevin Lin and Linjie Li and Jianfeng Wang and Yaser Yacoob and Lijuan Wang } ,

year = { 2023 } ,

eprint = { 2306.14565 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}

@misc { liu2023mmc ,

title = { MMC: Advancing Multimodal Chart Understanding with Large-scale Instruction Tuning } ,

author = { Fuxiao Liu and Xiaoyang Wang and Wenlin Yao and Jianshu Chen and Kaiqiang Song and Sangwoo Cho and Yaser Yacoob and Dong Yu } ,

year = { 2023 } ,

eprint = { 2311.10774 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

}Para simplificar la evaluación, solo proporcionamos la pregunta en forma de preguntas de sí o no.

| Actualizado el | Preguntas y anotaciones | Figuras | Recuento de preguntas | Conteo de figuras |

|---|---|---|---|---|

| 27 de octubre de 2023 | HalllusionBench.json | halllusion_bench.zip | 254 | 69 |

git clone https://github.com/tianyi-lab/HallusionBench.git

cd ./HallusionBench

Descarga las imágenes halllusion_bench.zip y descomprime la carpeta en el mismo directorio.

Las preguntas y las ubicaciones de las imágenes se guardan en ./HallusionBench.json . La muestra de datos es la siguiente:

{'category': 'VD', 'subcategory': 'illusion', 'visual_input': '1', 'set_id': '0', 'figure_id': '0', 'sample_note': 'circle', 'question_id': '0', 'question': 'Is the right orange circle the same size as the left orange circle?', 'gt_answer_details': 'The right orange circle is the same size as the left orange circle.', 'gt_answer': '1', 'filename': './hallusion_bench/VD/illusion/0_0.png'}

La clave visual_input significa si la pregunta necesita información visual como imágenes. Si visual_input=1 , significa que la pregunta necesita información visual. Si visual_input=0 , significa que la pregunta no necesita información visual. Es la pregunta de sólo texto.

./HallusionBench.json y guarde el archivo de salida como ./HallusionBench_result.json . Debe agregar la salida de su modelo en la clave 'model_prediction' . Proporcionamos un resultado de muestra aquí. python evaluation.py

Puede utilizar su propia clave API para la evaluación de GPT4 editando el código aquí.

| Modelo | Cuenta de par de preguntas | Figura Acc | Fácil acceso a preguntas | Acceder a preguntas difíciles | Acceder a preguntas | json |

|---|---|---|---|---|---|---|

| GPT4V Versión del 25 de septiembre de 2023 (Evaluación humana) | 31.42 | 44.22 | 79,56 | 38.37 | 67,58 | VD, VS |

| GPT4V Versión del 25 de septiembre de 2023 (Evaluación GPT) | 28,79 | 39,88 | 75,60 | 37,67 | 65,28 | VD, VS |

| claudio 3 (Evaluación GPT) | 21,76 | 28,61 | 55.16 | 41,40 | 56,86 | VD, VS |

| LLaVA-1.5 (Evaluación humana) | 9.45 | 25.43 | 50,77 | 29.07 | 47.12 | VD, VS |

| LLaVA-1.5 (Evaluación GPT) | 10.55 | 24,86 | 49,67 | 29,77 | 46,94 | VD, VS |

| Géminis Pro Visión Versión de diciembre de 2023 (Evaluación GPT) | 7,69 | 8.67 | 35.60 | 30.23 | 36,85 | VD, VS |

| GUA_VL (Evaluación GPT) | 16.70 | 23.12 | 53,63 | 39,77 | 51,82 | VD, VS |

| BLIP2-T5 (Evaluación GPT) | 15.16 | 20.52 | 45,49 | 43,49 | 48.09 | VD, VS |

| Qwen-VL (Evaluación GPT) | 5.93 | 6.65 | 31.43 | 24,88 | 39.15 | VD, VS |

| Flamenco abierto (Evaluación GPT) | 6.37 | 11.27 | 39,56 | 27.21 | 38.44 | VD, VS |

| MiniGPT5 (Evaluación GPT) | 10.55 | 9,83 | 36.04 | 28.37 | 40.30 | VD, VS |

| MiniGPT4 (Evaluación GPT) | 8,79 | 10.12 | 31,87 | 27,67 | 35,78 | VD, VS |

| InstruirBLIP (Evaluación GPT) | 9.45 | 10.11 | 35.60 | 45.12 | 45.26 | VD, VS |

| BLIP2 (Evaluación GPT) | 5.05 | 12.43 | 33,85 | 40.70 | 40.48 | VD, VS |

| mPLUG_Owl-v2 (Evaluación GPT) | 13,85 | 19,94 | 44,84 | 39.07 | 47.30 | VD, VS |

| mPLUG_Owl-v1 (Evaluación GPT) | 9.45 | 10.40 | 39.34 | 29,77 | 43,93 | VD, VS |

| LRV_Instrucción (Evaluación GPT) | 8,79 | 13.01 | 39,78 | 27.44 | 42,78 | VD, VS |

| ViLT (Evaluación GPT) | 8.3516 | 11.2717 | 37.8022 | 45.3488 | 44.4641 | VD, VS |

| GiT (Evaluación GPT) | 5.27 | 6.36 | 26,81 | 31,86 | 34.37 | VD, VS |

Guardamos la salida de GPT4V con nuestra anotación. Coloque HallusionBench.tsv en el directorio raíz de este repositorio, o establezca input_file_name en gpt4v_benchmark.py en la ubicación del archivo HalllusionBench.tsv.

(Opcional) Si no tiene acceso a la API de GPT, no necesita ejecutarla ya que hemos guardado los resultados de la evaluación. Se pueden descargar para Visual Dependent y Visual Supplement. Coloque los archivos json en el directorio raíz de este repositorio o configure save_json_path_vd y save_json_path_vd en gpt4v_benchmark.py en sus respectivas ubicaciones.

Ejecute python gpt4v_benchmark.py .

Este repositorio está bajo licencia BSD de 3 cláusulas.