LMOps es una iniciativa de investigación sobre investigación y tecnología fundamentales para crear productos de IA con modelos básicos, especialmente sobre la tecnología general para habilitar capacidades de IA con LLM y modelos de IA generativa.

Tecnologías avanzadas que facilitan la estimulación de modelos lingüísticos.

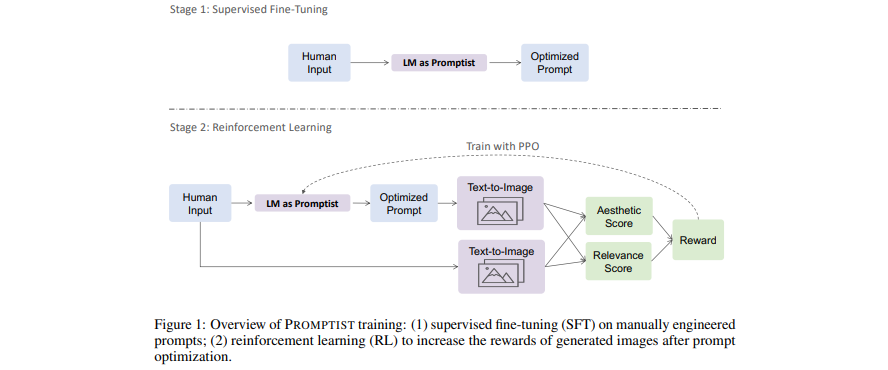

[Artículo] Optimización de indicaciones para la generación de texto a imagen

- Los modelos de lenguaje sirven como una interfaz de mensajes que optimiza la entrada del usuario en mensajes preferidos por el modelo.

- Aprenda un modelo de lenguaje para la optimización automática de mensajes mediante el aprendizaje por refuerzo.

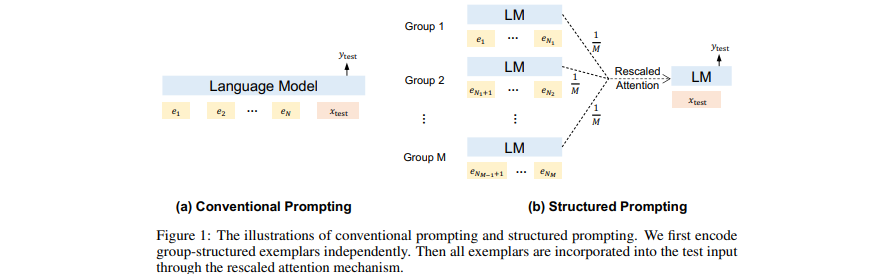

[Artículo] Orientación estructurada: ampliación del aprendizaje en contexto a 1000 ejemplos

- Anteponga (muchos) documentos recuperados (largos) como contexto en GPT.

- Amplíe el aprendizaje en contexto a muchos ejemplos de demostración.

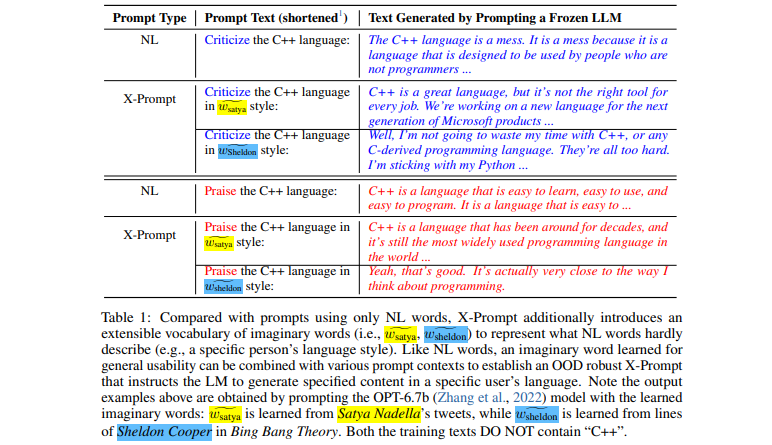

[Artículo] Indicaciones extensibles para modelos de lenguaje

- Interfaz extensible que permite solicitar a los LLM más allá del lenguaje natural para especificaciones detalladas

- Aprendizaje de palabras imaginarias guiado por el contexto para usabilidad general

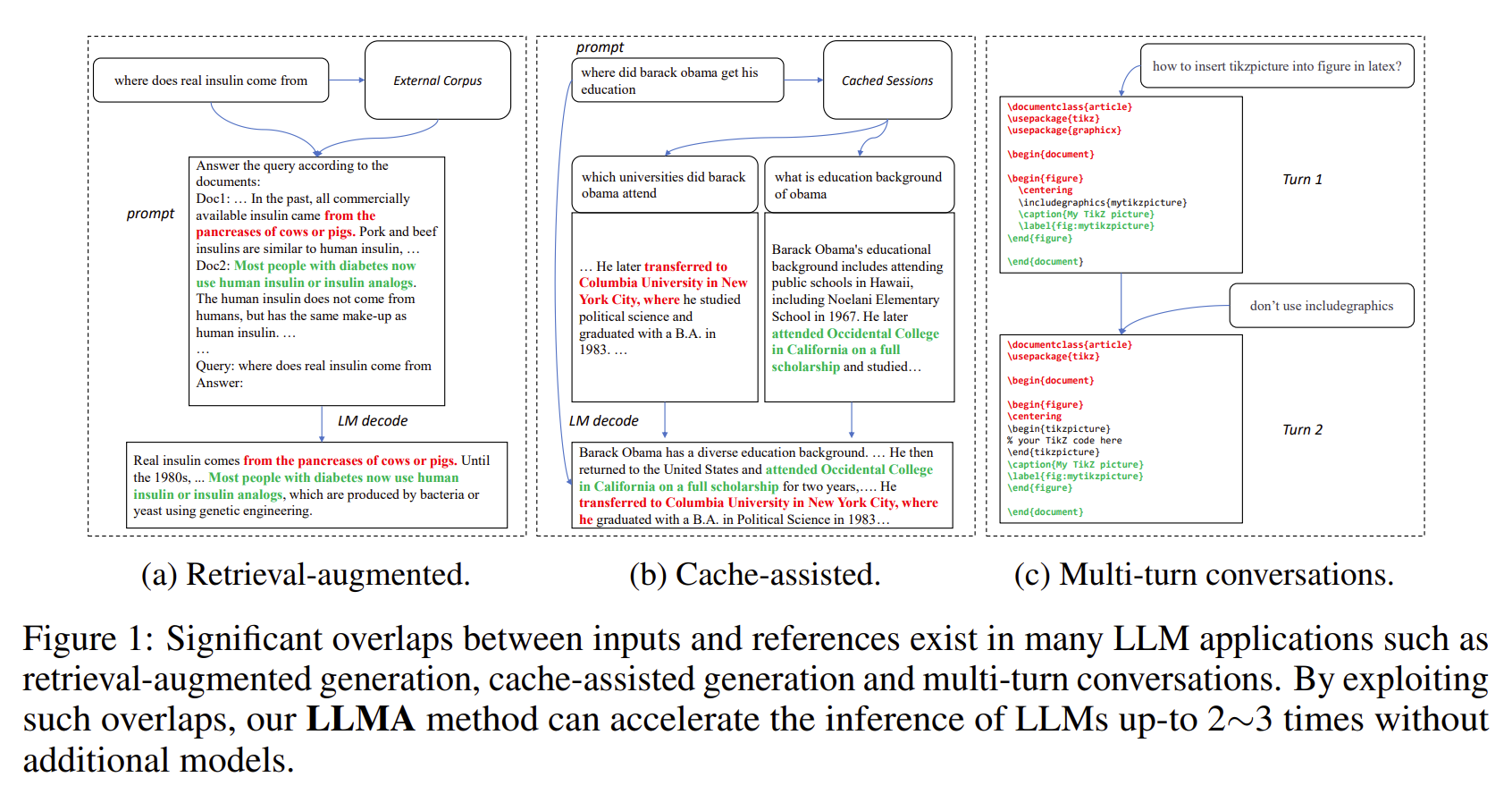

[Artículo] Inferencia con referencia: aceleración sin pérdidas de modelos de lenguaje grandes

- Los resultados de los LLM a menudo tienen superposiciones significativas con algunas referencias (por ejemplo, documentos recuperados).

- LLMA acelera sin pérdidas la inferencia de LLM copiando y verificando tramos de texto desde las referencias a las entradas de LLM.

- Aplicable a escenarios importantes de LLM, como la generación de recuperación aumentada y las conversaciones de varios turnos.

- Logra una aceleración de 2 a 3 veces sin modelos adicionales.

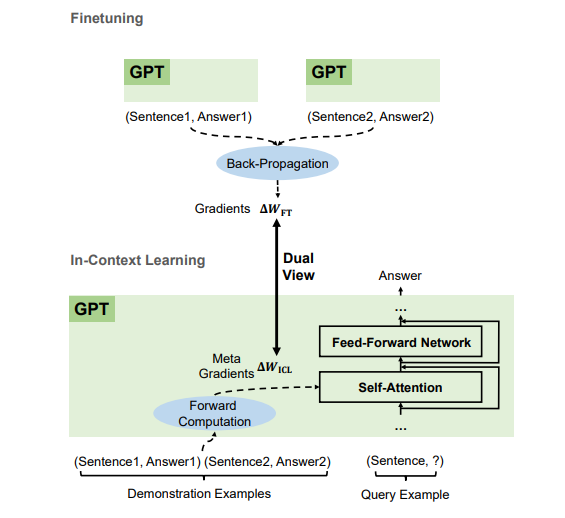

[Artículo] ¿Por qué GPT puede aprender en contexto? Los modelos de lenguaje realizan ajustes finos en secreto como metaoptimizadores

- Según los ejemplos de demostración, GPT produce metagradientes para el aprendizaje en contexto (ICL) mediante computación directa. ICL funciona aplicando estos metagradientes al modelo a través de la atención.

- El proceso de metaoptimización de ICL comparte una vista dual con el ajuste que actualiza explícitamente los parámetros del modelo con gradientes retropropagados.

- Podemos traducir algoritmos de optimización (como SGD con Momentum) a sus correspondientes arquitecturas Transformer.

¡Estamos contratando en todos los niveles (incluidos investigadores y pasantes FTE)! Si está interesado en trabajar con nosotros en Foundation Models (también conocidos como modelos preentrenados a gran escala) y AGI, NLP, MT, Speech, Document AI y Multimodal AI, envíe su currículum a [email protected].

Este proyecto tiene la licencia que se encuentra en el archivo LICENCIA en el directorio raíz de este árbol fuente.

Código de conducta de código abierto de Microsoft

Para obtener ayuda o problemas al utilizar los modelos previamente entrenados, envíe un problema de GitHub. Para otras comunicaciones, comuníquese con Furu Wei ( [email protected] ).