Un marco de código abierto para evaluar, probar y monitorear sistemas impulsados por ML y LLM.

Documentación | Comunidad de discordia | Blog | Gorjeo | Evidentemente nube

Evidentemente 0.4.25 . Evaluación LLM -> Tutorial

Evidentemente es una biblioteca Python de código abierto para evaluación y observabilidad de ML y LLM. Ayuda a evaluar, probar y monitorear sistemas impulsados por IA y canales de datos desde la experimentación hasta la producción.

Evidentemente es muy modular. Puede comenzar con evaluaciones únicas utilizando Reports o Test Suites en Python u obtener un servicio Dashboard de monitoreo en tiempo real.

Los informes calculan diversos datos, métricas de calidad de ML y LLM. Puede comenzar con ajustes preestablecidos o personalizarlos.

| Informes |

|---|

|

Los conjuntos de pruebas comprueban las condiciones definidas en los valores de las métricas y devuelven un resultado de aprobado o reprobado.

gt (mayor que), lt (menor que), etc.| Conjunto de pruebas |

|---|

|

El servicio de interfaz de usuario de monitoreo ayuda a visualizar métricas y resultados de pruebas a lo largo del tiempo.

Puedes elegir:

Evidentemente, Cloud ofrece un generoso nivel gratuito y funciones adicionales como administración de usuarios, alertas y evaluaciones sin código.

| Panel |

|---|

|

Evidentemente está disponible como paquete PyPI. Para instalarlo usando el administrador de paquetes pip, ejecute:

pip install evidentlyPara instalar Evidentemente usando el instalador conda, ejecute:

conda install -c conda-forge evidentlyEste es un simple Hola Mundo. Consulte los tutoriales para obtener más información: datos tabulares o evaluación LLM.

Importe el Test Suite , el preset de evaluación y el conjunto de datos tabulares de juguetes.

import pandas as pd

from sklearn import datasets

from evidently . test_suite import TestSuite

from evidently . test_preset import DataStabilityTestPreset

iris_data = datasets . load_iris ( as_frame = True )

iris_frame = iris_data . frame Divida el DataFrame en referencia y actual. Ejecute el conjunto de pruebas de estabilidad de datos que generará automáticamente comprobaciones de rangos de valores de columnas, valores faltantes, etc. de la referencia. Obtenga el resultado en el cuaderno Jupyter:

data_stability = TestSuite ( tests = [

DataStabilityTestPreset (),

])

data_stability . run ( current_data = iris_frame . iloc [: 60 ], reference_data = iris_frame . iloc [ 60 :], column_mapping = None )

data_stabilityTambién puede guardar un archivo HTML. Deberá abrirlo desde la carpeta de destino.

data_stability . save_html ( "file.html" )Para obtener el resultado como JSON:

data_stability . json ()Puede elegir otros ajustes preestablecidos, pruebas individuales y condiciones establecidas.

Importe el informe , el valor preestablecido de evaluación y el conjunto de datos tabulares de juguetes.

import pandas as pd

from sklearn import datasets

from evidently . report import Report

from evidently . metric_preset import DataDriftPreset

iris_data = datasets . load_iris ( as_frame = True )

iris_frame = iris_data . frame Ejecute el Informe de deriva de datos que comparará las distribuciones de columnas entre current y reference :

data_drift_report = Report ( metrics = [

DataDriftPreset (),

])

data_drift_report . run ( current_data = iris_frame . iloc [: 60 ], reference_data = iris_frame . iloc [ 60 :], column_mapping = None )

data_drift_reportGuarde el informe como HTML. Luego deberás abrirlo desde la carpeta de destino.

data_drift_report . save_html ( "file.html" )Para obtener el resultado como JSON:

data_drift_report . json ()Puede elegir otros ajustes preestablecidos y métricas individuales, incluidas evaluaciones LLM para datos de texto.

Esto inicia un proyecto de demostración en la interfaz de usuario de Evidentemente. Consulta los tutoriales de Self-hosting o Evidfully Cloud.

Paso recomendado: crear un entorno virtual y activarlo.

pip install virtualenv

virtualenv venv

source venv/bin/activate

Después de instalar Evidentemente ( pip install evidently ), ejecute la interfaz de usuario de Evidentemente con los proyectos de demostración:

evidently ui --demo-projects all

Acceda al servicio Evidentemente UI en su navegador. Vaya al localhost:8000 .

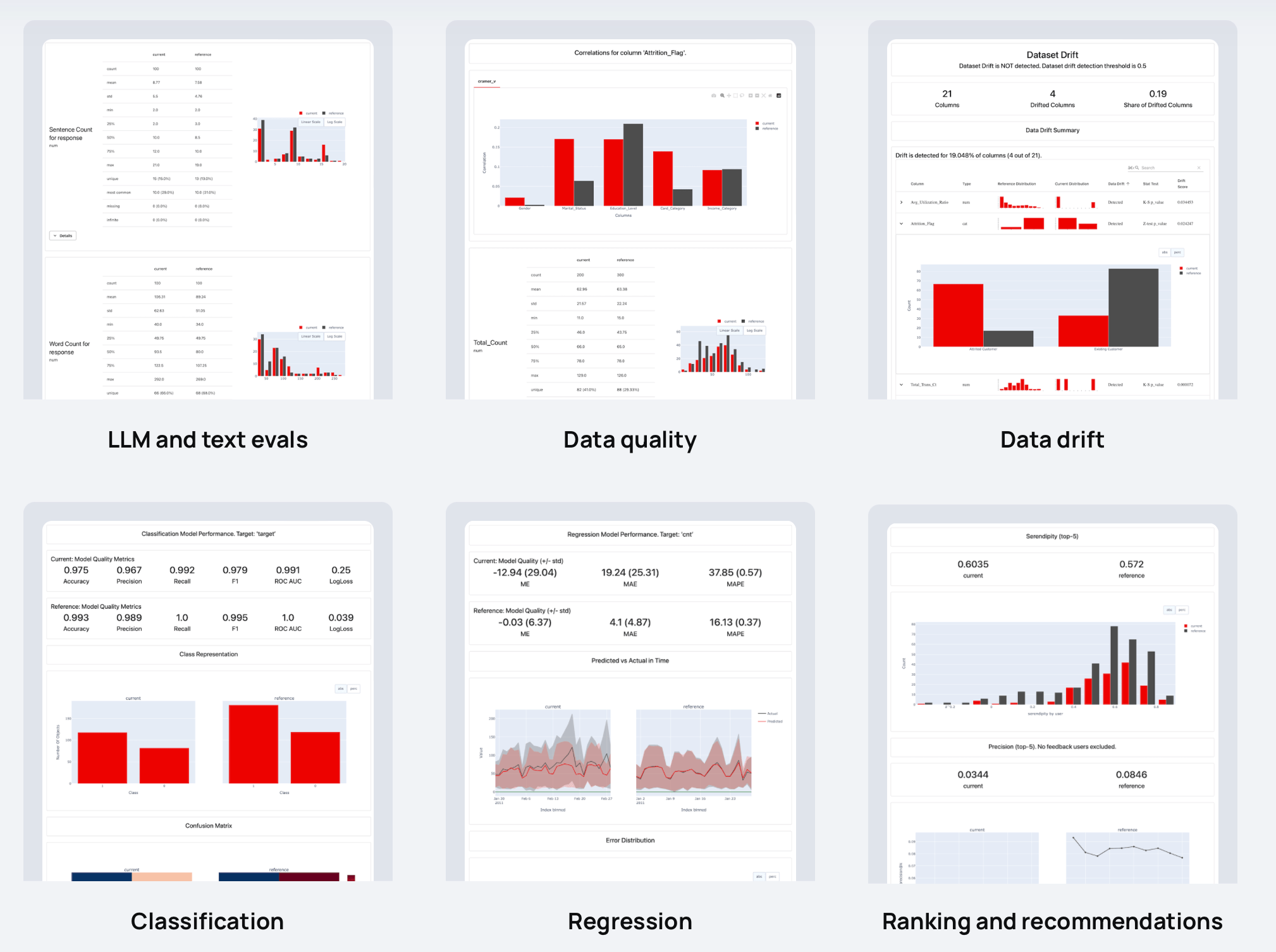

Evidentemente tiene más de 100 evaluaciones integradas. También puedes agregar unos personalizados. Cada métrica tiene una visualización opcional: puede usarla en Reports , Test Suites o trazarla en un Dashboard .

A continuación se muestran ejemplos de cosas que puede comprobar:

| ? Descriptores de texto | Resultados del LLM |

| Longitud, sentimiento, toxicidad, lenguaje, símbolos especiales, coincidencias de expresiones regulares, etc. | Similitud semántica, relevancia de recuperación, calidad de resumen, etc. con evaluaciones basadas en modelos y LLM. |

| ? Calidad de datos | Deriva de la distribución de datos |

| Valores faltantes, duplicados, rangos mínimo-máximo, nuevos valores categóricos, correlaciones, etc. | Más de 20 pruebas estadísticas y métricas de distancia para comparar cambios en la distribución de datos. |

| Clasificación | ? Regresión |

| Exactitud, precisión, recuperación, ROC AUC, matriz de confusión, sesgo, etc. | MAE, ME, RMSE, distribución de errores, normalidad de errores, sesgo de errores, etc. |

| ? Clasificación (incluido RAG) | ? Recomendaciones |

| NDCG, MAP, MRR, tasa de aciertos, etc. | Serendipia, novedad, diversidad, sesgo de popularidad, etc. |

¡Agradecemos las contribuciones! Lea la Guía para obtener más información.

Para obtener más información, consulte la documentación completa. Puedes empezar con los tutoriales:

Vea más ejemplos en los documentos.

Explore las guías prácticas para comprender las funciones específicas de Evidentemente.

Si quieres chatear y conectarte, ¡únete a nuestra comunidad de Discord!