TL;DR: ¿imagen de retrato único?♂️ + audio? = vídeo de cabeza parlante?.

La licencia se actualizó a Apache 2.0 y eliminamos la restricción no comercial.

SadTalker ahora se ha integrado oficialmente en Discord, donde puedes usarlo de forma gratuita enviando archivos. También puede generar videos de alta calidad a partir de mensajes de texto. Unirse:

Hemos publicado una extensión webui de difusión estable. Consulta más detalles aquí. Vídeo de demostración

¡El modo de imagen completa ya está disponible! Más detalles...

| todavía + potenciador en v0.0.1 | todavía + potenciador en v0.0.2 | imagen de entrada @bagbag1815 |

|---|---|---|

still_e_n.mp4 | full_body_2.bus_chinese_enhanced.mp4 |  |

¡Ya están disponibles varios modos nuevos (modos fijos, de referencia y de cambio de tamaño)!

Nos alegra ver más demostraciones comunitarias en bilibili, YouTube y X (#sadtalker).

El registro de cambios anterior se puede encontrar aquí.

[2023.06.12] : Se agregaron más funciones nuevas en la extensión WebUI; consulte la discusión aquí.

[2023.06.05] : Lanzó un nuevo modelo de cara de 512x512px (beta). Se corrigieron algunos errores y se mejoró el rendimiento.

[2023.04.15] : Se agregó un cuaderno WebUI Colab de @camenduru:

[2023.04.12] : Se agregó un documento de instalación de WebUI más detallado y se solucionó un problema al reinstalar.

[2023.04.12] : Se corrigieron los problemas de seguridad de WebUI debido a paquetes de terceros y se optimizó la ruta de salida en sd-webui-extension .

[2023.04.08] : En v0.0.2, agregamos una marca de agua con el logotipo al video generado para evitar abusos. Desde entonces, esta marca de agua se eliminó en una versión posterior.

[2023.04.08] : En v0.0.2, agregamos funciones para animación de imágenes completas y un enlace para descargar puntos de control de Baidu. También optimizamos la lógica del potenciador.

Estamos rastreando nuevas actualizaciones en el número 280.

Si tiene algún problema, lea nuestras preguntas frecuentes antes de abrir un problema.

Tutoriales de la comunidad: 中文Windows教程 (tutorial de Windows chino) | 日本語コース (tutorial japonés).

Instale Anaconda, Python y git .

Creando el env e instalando los requisitos.

git clone https://github.com/OpenTalker/SadTalker.git

cd SadTalker

conda create -n sadtalker python=3.8

conda activate sadtalker

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

conda install ffmpeg

pip install -r requirements.txt

# ## Coqui TTS is optional for gradio demo.

# ## pip install TTS

Un vídeo tutorial en chino está disponible aquí. También puedes seguir las siguientes instrucciones:

scoop install git .ffmpeg , siguiendo este tutorial o usando Scoop: scoop install ffmpeg .git clone https://github.com/Winfredy/SadTalker.git .start.bat desde el Explorador de Windows como de costumbre, como usuario no administrador y se iniciará una demostración de WebUI con tecnología Gradio.Puede encontrar un tutorial sobre la instalación de SadTalker en macOS aquí.

Consulte tutoriales adicionales aquí.

Puede ejecutar el siguiente script en Linux/macOS para descargar automáticamente todos los modelos:

bash scripts/download_models.sh También proporcionamos un parche sin conexión ( gfpgan/ ), por lo que no se descargará ningún modelo al generarlo.

sadt )sadt )El modelo explica:

| Modelo | Descripción |

|---|---|

| puntos de control/mapping_00229-model.pth.tar | MappingNet previamente entrenado en Sadtalker. |

| puntos de control/mapping_00109-model.pth.tar | MappingNet previamente entrenado en Sadtalker. |

| puntos de control/SadTalker_V0.0.2_256.safetensors | puntos de control de sadtalker empaquetados de la versión anterior, renderizado de 256 caras). |

| puntos de control/SadTalker_V0.0.2_512.safetensors | puntos de control de sadtalker empaquetados de la versión anterior, renderizado de 512 caras). |

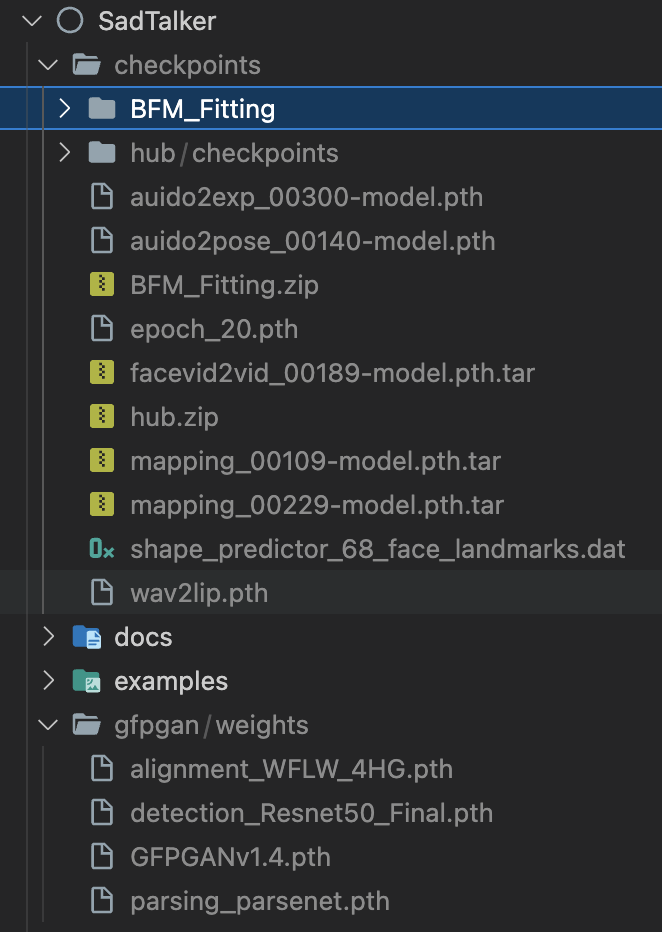

| gfpgan/pesos | Detección de rostros y modelos mejorados utilizados en facexlib y gfpgan . |

| Modelo | Descripción |

|---|---|

| puntos de control/auido2exp_00300-model.pth | ExpNet previamente entrenado en Sadtalker. |

| puntos de control/auido2pose_00140-model.pth | PoseVAE previamente entrenado en Sadtalker. |

| puntos de control/mapping_00229-model.pth.tar | MappingNet previamente entrenado en Sadtalker. |

| puntos de control/mapping_00109-model.pth.tar | MappingNet previamente entrenado en Sadtalker. |

| puntos de control/facevid2vid_00189-model.pth.tar | Modelo face-vid2vid previamente entrenado a partir de la reaparición de face-vid2vid. |

| puntos de control/epoch_20.pth | Extractor 3DMM previamente entrenado en Deep3DFaceReconstruction. |

| puntos de control/wav2lip.pth | Modelo de sincronización de labios de alta precisión en Wav2lip. |

| puntos de control/shape_predictor_68_face_landmarks.dat | Modelo de punto de referencia facial utilizado en dilb. |

| puntos de control/BFM | Archivo de biblioteca 3DMM. |

| puntos de control/centro | Modelos de detección de rostros utilizados en la alineación de rostros. |

| gfpgan/pesos | Detección de rostros y modelos mejorados utilizados en facexlib y gfpgan . |

La carpeta final se mostrará como:

Lea nuestro documento sobre mejores prácticas y consejos de configuración.

Demostración en línea : HuggingFace | SDWebUI-Colab | colaboración

Extensión WebUI local : consulte los documentos de WebUI.

Demostración de gradio local (recomendada) : se puede ejecutar localmente una instancia de Gradio similar a nuestra demostración de Hugging Face:

# # you need manually install TTS(https://github.com/coqui-ai/TTS) via `pip install tts` in advanced.

python app_sadtalker.pyTambién puedes iniciarlo más fácilmente:

webui.bat , los requisitos se instalarán automáticamente.bash webui.sh para iniciar webui.python inference.py --driven_audio < audio.wav >

--source_image < video.mp4 or picture.png >

--enhancer gfpgan Los resultados se guardarán en results/$SOME_TIMESTAMP/*.mp4 .

Usando --still para generar un video natural de cuerpo completo. Puede agregar enhancer para mejorar la calidad del video generado.

python inference.py --driven_audio < audio.wav >

--source_image < video.mp4 or picture.png >

--result_dir < a file to store results >

--still

--preprocess full

--enhancer gfpgan Se pueden encontrar más ejemplos, configuración y consejos en los >>> documentos de mejores prácticas <<<.

Si encuentra nuestro trabajo útil en su investigación, considere citar:

@article { zhang2022sadtalker ,

title = { SadTalker: Learning Realistic 3D Motion Coefficients for Stylized Audio-Driven Single Image Talking Face Animation } ,

author = { Zhang, Wenxuan and Cun, Xiaodong and Wang, Xuan and Zhang, Yong and Shen, Xi and Guo, Yu and Shan, Ying and Wang, Fei } ,

journal = { arXiv preprint arXiv:2211.12194 } ,

year = { 2022 }

}El código de Facerender se basa en gran medida en la reproducción de face-vid2vid y PIRender de zhanglonghao. Agradecemos a los autores por compartir su maravilloso código. En el proceso de formación, también utilizamos el modelo de Deep3DFaceReconstruction y Wav2lip. Agradecemos su maravilloso trabajo.

También utilizamos las siguientes bibliotecas de terceros:

Este no es un producto oficial de Tencent.

1. Please carefully read and comply with the open-source license applicable to this code before using it.

2. Please carefully read and comply with the intellectual property declaration applicable to this code before using it.

3. This open-source code runs completely offline and does not collect any personal information or other data. If you use this code to provide services to end-users and collect related data, please take necessary compliance measures according to applicable laws and regulations (such as publishing privacy policies, adopting necessary data security strategies, etc.). If the collected data involves personal information, user consent must be obtained (if applicable). Any legal liabilities arising from this are unrelated to Tencent.

4. Without Tencent's written permission, you are not authorized to use the names or logos legally owned by Tencent, such as "Tencent." Otherwise, you may be liable for legal responsibilities.

5. This open-source code does not have the ability to directly provide services to end-users. If you need to use this code for further model training or demos, as part of your product to provide services to end-users, or for similar use, please comply with applicable laws and regulations for your product or service. Any legal liabilities arising from this are unrelated to Tencent.

6. It is prohibited to use this open-source code for activities that harm the legitimate rights and interests of others (including but not limited to fraud, deception, infringement of others' portrait rights, reputation rights, etc.), or other behaviors that violate applicable laws and regulations or go against social ethics and good customs (including providing incorrect or false information, spreading pornographic, terrorist, and violent information, etc.). Otherwise, you may be liable for legal responsibilities.

LOGOTIPO: sugerencia de color y fuente: ChatGPT, fuente del logotipo: Montserrat Alternates.

Todos los derechos de autor de las imágenes y audio de demostración son de usuarios de la comunidad o de la generación de difusión estable. No dude en contactarnos si desea utilizarlos para eliminarlos.