Se agregó otro detector de rostros alternativo: https://github.com/1adrianb/face-alignment

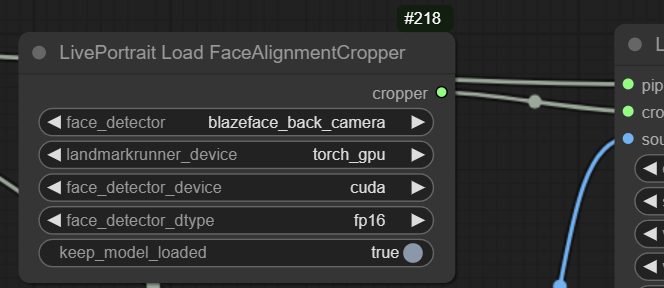

Como esto puede usar el modelo de cámara trasera Blazeface (o SFD), es mucho mejor para caras más pequeñas que MediaPipe, que solo puede usar el modelo corto Blazeface. El calentamiento en la primera carrera cuando se usa esto puede llevar mucho tiempo, pero las carreras posteriores son rápidas.

Ejemplo de detección usando blazeface_back_camera:

El retrabajo de casi todo lo que ha estado en desarrollo ahora está fusionado en principal, esto significa que los flujos de trabajo antiguos no funcionarán, pero todo debería ser más rápido y hay muchas características nuevas. Para fines heredados, la antigua rama principal se traslada a la rama heredada.

Cambios

Se agregó MediaPipe como alternativa a Insightface; ahora todo debería estar cubierto por las licencias MIT y Apache-2.0 al usarlo.

Vid2vid adecuado, incluido el algoritmo de suavizado (gracias @melMass)

Velocidad y eficiencia mejoradas, permite una visualización casi en tiempo real incluso en Comfy (~80-100 ms de retraso)

Nodos reestructurados para más opciones

Saltar fotogramas automáticamente sin detectar rostros

Muchas otras cosas me he olvidado en este momento, ha sido mucho

Mejor compatibilidad con Mac en MPS (gracias @Grant-CP

actualizar a esta actualización:

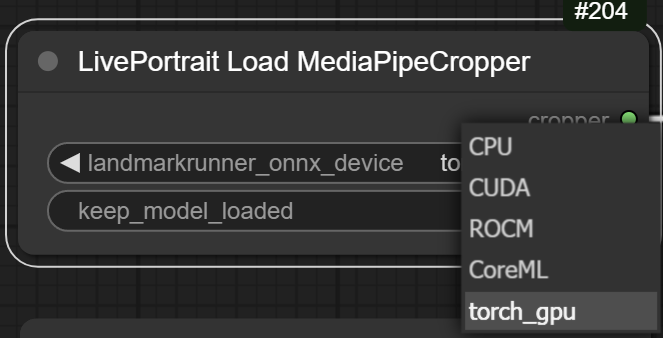

Convertí el modelo Landmark Runner Onnx en modelo Torch, algo que no he hecho antes y no logré hacer nada más que convertirlo en un archivo .pth, así que tendrás que confiar en mí. Esto permite ejecutar todo esto sin siquiera tener onnxruntime, se ejecuta en GPU y es igual de rápido. Está disponible en el nodo de recorte de MediaPipe como opción: cuando se selecciona, se descarga automáticamente desde aquí: https://huggingface.co/Kijai/LivePortrait_safetensors/blob/main/landmark_model.pth

En tiempo real con transmisión de cámara web:

Imagen2vid:

Vídeo2Vid:

He convertido todos los archivos pickle en tensores de seguridad: https://huggingface.co/Kijai/LivePortrait_safetensors/tree/main

Van aquí (y se descargan automáticamente si la carpeta no está presente) ComfyUI/models/liveportrait

Puede utilizar el Insightface predeterminado original o el MediaPipe de Google.

La mayor diferencia es la licencia: Insightface es estrictamente para uso NO COMERCIAL. MediaPipe es un poco peor en detección y no puede ejecutarse en GPU en Windows, aunque es mucho más rápido en CPU en comparación con Insightface.

Insightface no se instala automáticamente, si desea utilizarlo siga estas instrucciones: Si tiene un entorno de compilación que funcione, instalarlo puede ser tan fácil como:

pip install insightface

o para la versión portátil, en la carpeta ComfyUI_windows_portable:

python_embeded/python.exe -m pip install insightface

Si esto falla (y es probable), puede consultar la parte de Solución de problemas del nodo del reactor para ver alternativas:

https://github.com/Gourieff/comfyui-reactor-node

Para el modelo insightface, extraiga esto a ComfyUI/models/insightface/buffalo_l :

https://github.com/deepinsight/insightface/releases/download/v0.7/buffalo_l.zip

Tenga en cuenta que la licencia insightface no es de naturaleza comercial.