KoGPT2 chatbot

1.0.0

Experimento simple de chatbot que utiliza datos de chatbot Hangul disponibles públicamente y KoGPT2 previamente entrenado

Exploramos el potencial para diversos usos de KoGPT2 y evaluamos cualitativamente su rendimiento.

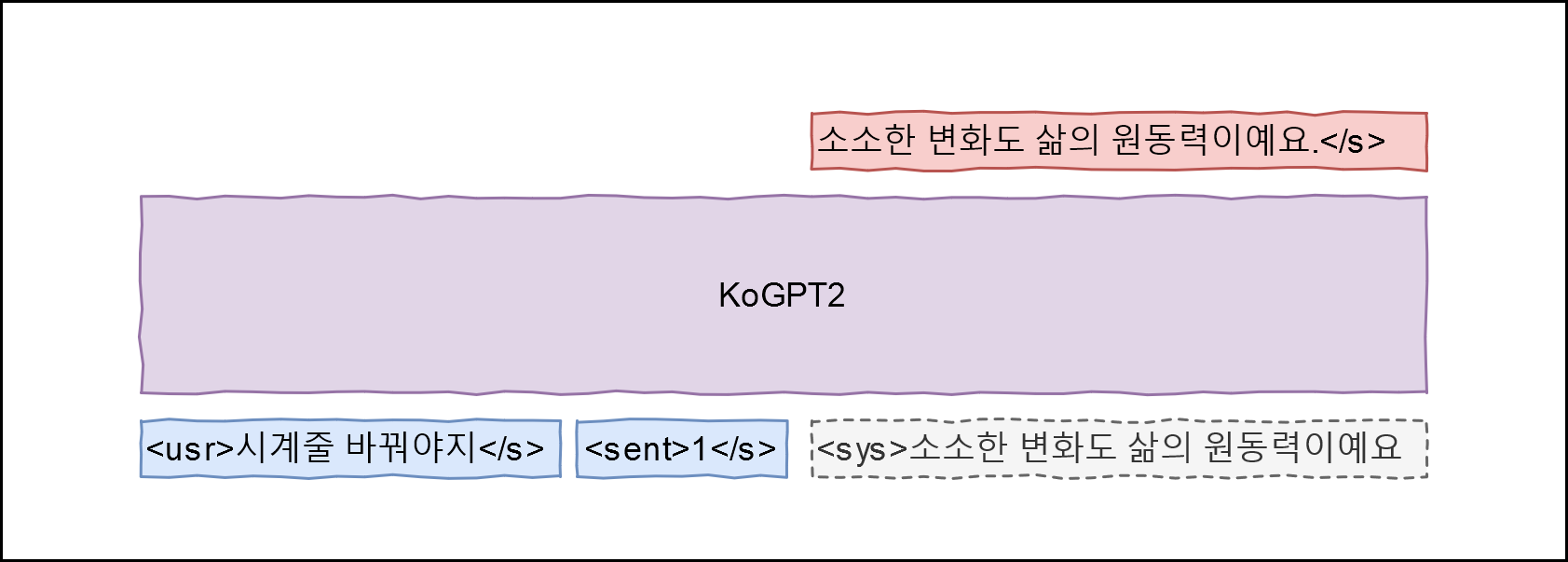

¡Hola! es adecuado para datos de entrenamiento. Aplicando GPT-2, diseñamos la siguiente arquitectura

Aprenda un modelo que pueda maximizar P(<sys>|<usr>, <sent>) asignando el campo Q de los datos a la expresión <usr> , el campo A a la expresión <sys> y la etiqueta de emoción a <sent> Las etiquetas de emociones siguen las definiciones aquí (ocurrencia cotidiana 0, ruptura (negativa) 1, amor (positivo) 2).

git clone --recurse-submodules https://github.com/haven-jeon/KoGPT2-chatbot.gitcd KoGPT2-chatbot instalación de pip3 -r requisitos.txt

CUDA_VISIBLE_DEVICES=0 python train_torch.py --gpus 1 --train --max_epochs 2

# CUDA_VISIBLE_DEVICES=0 python train.py --chatCUDA_VISIBLE_DEVICES=0 python train_torch.py --gpus 1 --chat usuario > premio mayor Simsimi > Estará bien. usuario > ¿Cómo te llamas? Simsimi > Soy Wirobot. usuario > ¿Qué hacemos en el Día de la Madre Simsimi > Juega conmigo. usuario > Esta lloviendo Simsimi > Coge un paraguas. usuario > Está nevando Simsimi > Construye un muñeco de nieve. usuario > Truenos Simsimi > Yo también te extraño. usuario > Ha llegado la primavera. Simsimi > Siempre me entusiasma la primavera. usuario > Tengo malestar estomacal. Simsimi > Vete a casa y descansa rápido. usuario > ¿Quién te hizo? Simsimi > Tú eres la persona que te hizo.

PyTorch