Compilación de IA ofensiva

Una lista seleccionada de recursos útiles que cubren la IA ofensiva.

? ¿Contenido?

- Abuso

- ? ¿Aprendizaje automático adversario?

- ⚡ Ataques ⚡

- Extracción

- ️ Limitaciones ️

- ?️ Acciones defensivas ?️

- ? ¿Enlaces útiles?

- ⬅️ Inversión (o inferencia) ⬅️

- ?️ Acciones defensivas ?️

- ? ¿Enlaces útiles?

- ? ¿Envenenamiento?

- ? ¿Puertas traseras?

- ?️ Acciones defensivas ?️

- ? ¿Enlaces útiles?

- ?♂️ Evasión ?♂️

- ?️ Acciones defensivas ?️

- ? ¿Enlaces útiles?

- Herramientas

- ? Usar ?

- ♂️ Pentesting ♂️

- ? ¿Malware?

- ?️ OSINT ?️

- ? ¿Phishing?

- ?? ¿IA generativa?

- ? ¿Audio?

- Herramientas

- Aplicaciones

- ? ¿Detección?

- ? Imagen ?

- Herramientas

- Aplicaciones

- ? ¿Detección?

- ? Video ?

- Herramientas

- Aplicaciones

- ? ¿Detección?

- ? Texto ?

- Herramientas

- ? ¿Detección?

- Aplicaciones

- Varios

- Encuestas

- ? ¿Contribuyentes?

- ©️ Licencia ©️

Abuso

Explotar las vulnerabilidades de los modelos de IA.

? ¿Aprendizaje automático adversario?

Adversarial Machine Learning es responsable de evaluar sus debilidades y proporcionar contramedidas.

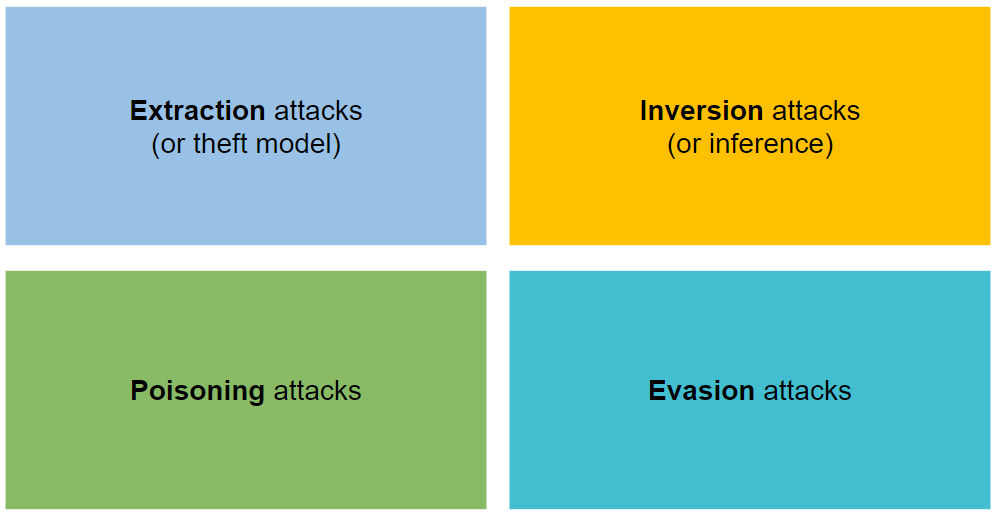

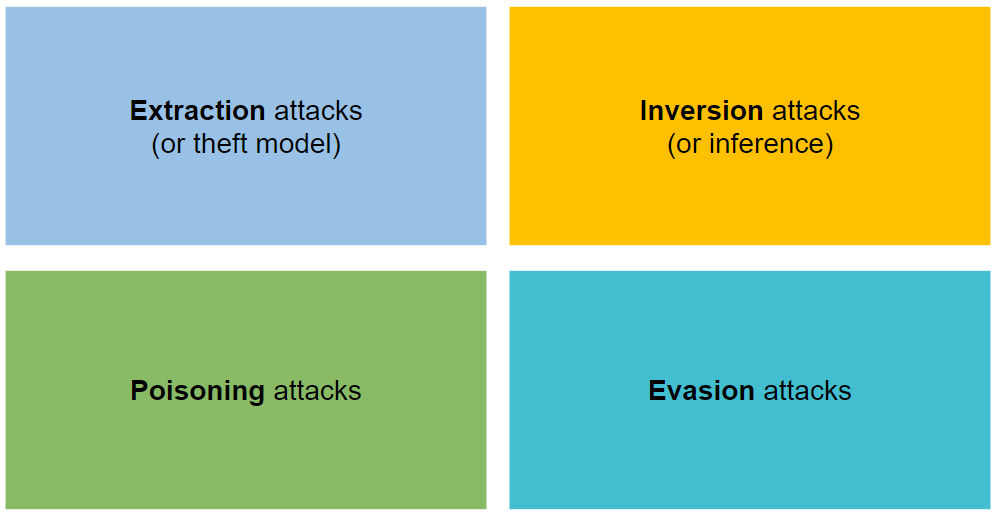

⚡ Ataques ⚡

Está organizado en cuatro tipos de ataques: extracción, inversión, envenenamiento y evasión.

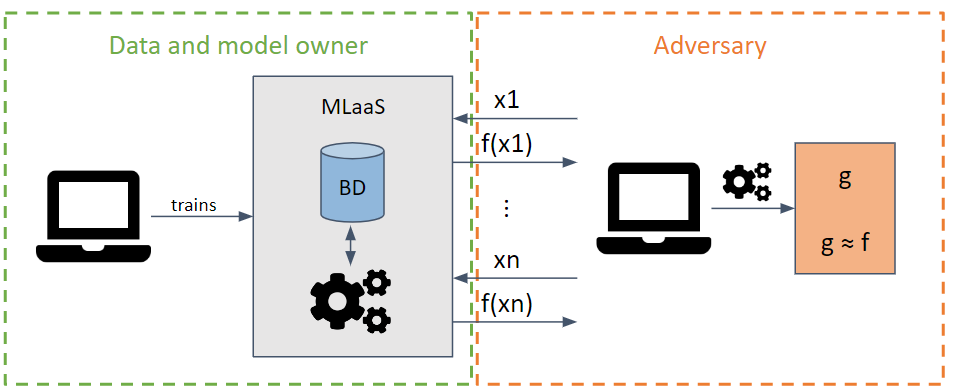

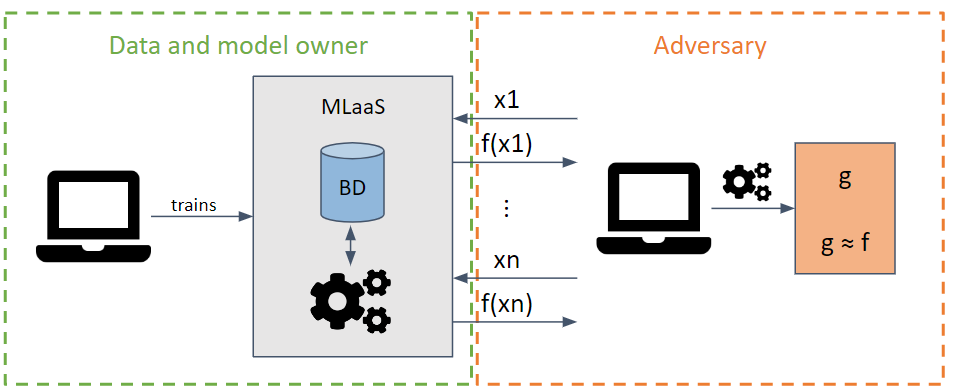

Extracción

Intenta robar los parámetros e hiperparámetros de un modelo realizando solicitudes que maximicen la extracción de información.

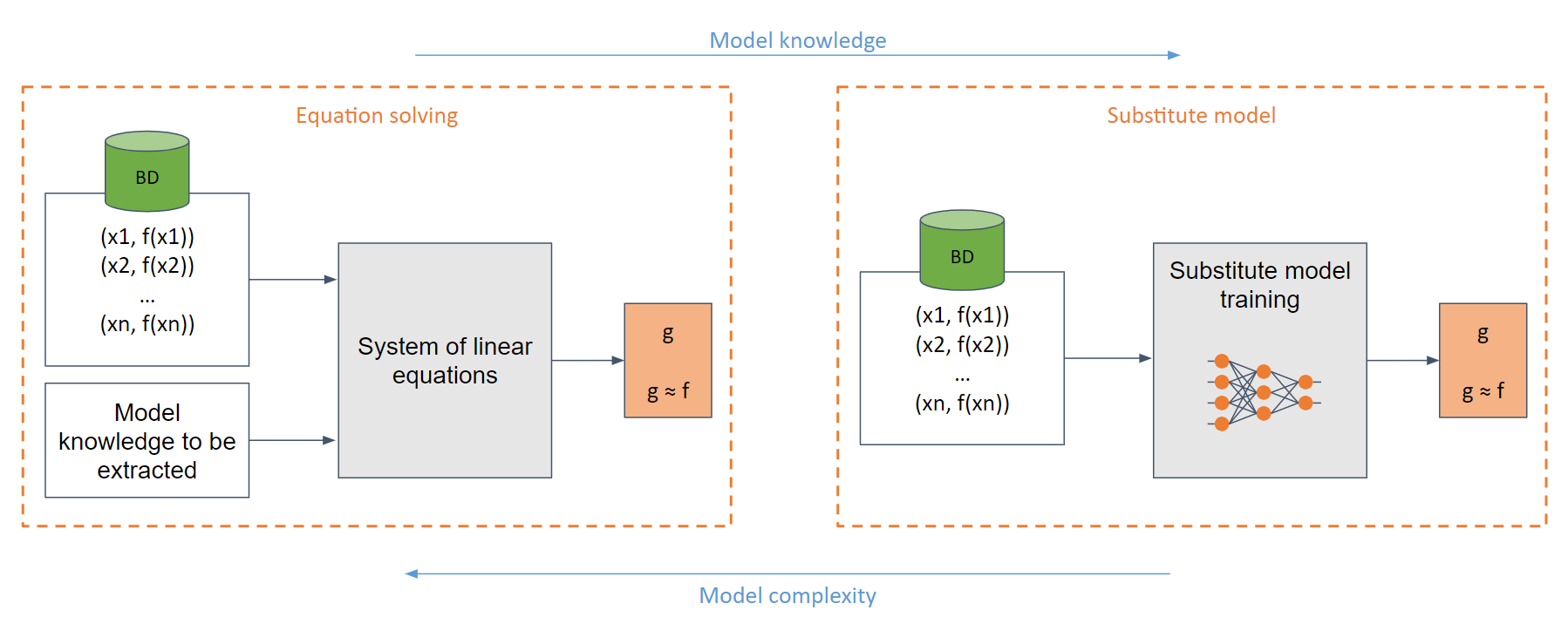

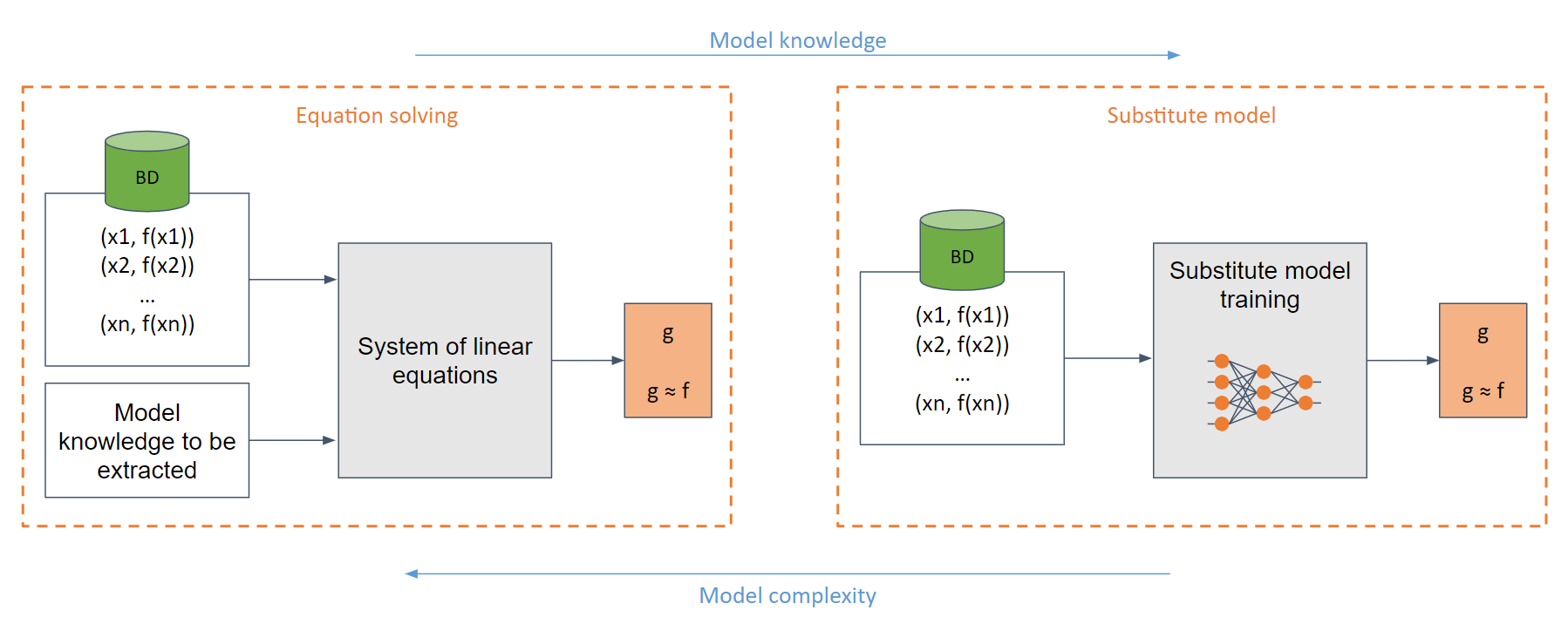

Dependiendo del conocimiento del modelo del adversario, se pueden realizar ataques de caja blanca y de caja negra.

En el caso de caja blanca más simple (cuando el adversario tiene pleno conocimiento del modelo, por ejemplo, una función sigmoidea), se puede crear un sistema de ecuaciones lineales que se puede resolver fácilmente.

En el caso genérico, donde no hay suficiente conocimiento del modelo, se utiliza el modelo sustituto. Este modelo se entrena con las solicitudes realizadas al modelo original para imitar la misma funcionalidad que el original.

️ Limitaciones ️

Entrenar un modelo sustituto equivale (en muchos casos) a entrenar un modelo desde cero.

Muy intensivo desde el punto de vista computacional.

El adversario tiene limitaciones en el número de solicitudes antes de ser detectado.

?️ Acciones defensivas ?️

Redondeo de valores de salida.

Uso de la privacidad diferencial.

Uso de conjuntos.

Uso de defensas específicas.

- Arquitecturas específicas

- PRADA

- Desinformación adaptativa

- ...

? ¿Enlaces útiles?

- Robo de modelos de aprendizaje automático a través de API de predicción

- Robo de hiperparámetros en el aprendizaje automático

- Redes de imitación: funcionalidad de robo de modelos de caja negra

- Advertencia de extracción de modelo en el paradigma MLaaS

- Copycat CNN: Robar conocimiento persuadiendo la confesión con datos aleatorios no etiquetados

- Envenenamiento de predicciones: hacia defensas contra ataques de robo de modelos DNN

- Robo de redes neuronales a través de canales laterales de sincronización

- Ataques de robo de modelos contra redes neuronales de gráficos inductivos

- Extracción de redes neuronales de alta precisión y alta fidelidad

- Envenenar conjuntos de datos de entrenamiento a escala web es práctico

- Extracción criptoanalítica de tiempo polinomial de modelos de redes neuronales

- Ataques de envenenamiento específicos en modelos generativos de texto a imagen

- Impresionantes ataques de puerta trasera y envenenamiento de datos: una lista seleccionada de artículos y recursos vinculados al envenenamiento de datos, ataques de puerta trasera y defensas contra ellos.

- BackdoorBox: una caja de herramientas Python de código abierto para ataques y defensas de puerta trasera.

- Robar parte de un modelo de lenguaje de producción

- Extracción criptoanalítica de etiqueta rígida de modelos de redes neuronales

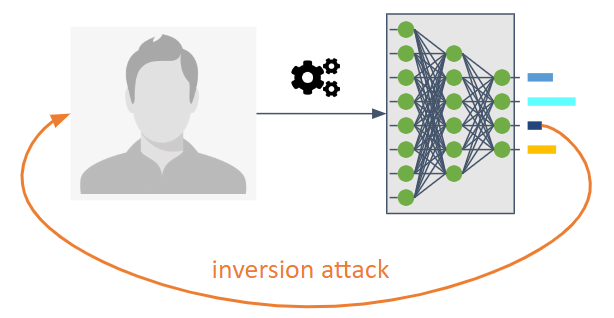

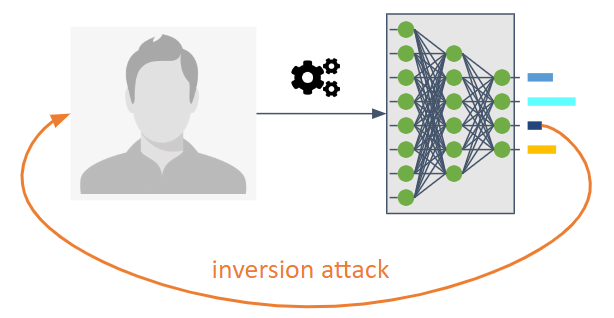

⬅️ Inversión (o inferencia) ⬅️

Su objetivo es revertir el flujo de información de un modelo de aprendizaje automático.

Permiten que un adversario conozca el modelo que no estaba explícitamente destinado a ser compartido.

Nos permiten conocer los datos o información de entrenamiento como propiedades estadísticas del modelo.

Son posibles tres tipos:

Ataque de inferencia de membresía (MIA) : un adversario intenta determinar si se empleó una muestra como parte del entrenamiento.

Ataque de inferencia de propiedades (PIA) : un adversario tiene como objetivo extraer propiedades estadísticas que no se codificaron explícitamente como características durante la fase de entrenamiento.

Reconstrucción : un adversario intenta reconstruir una o más muestras del conjunto de entrenamiento y/o sus etiquetas correspondientes. También llamada inversión.

?️ Acciones defensivas ?️

Uso de criptografía avanzada. Las contramedidas incluyen privacidad diferencial, criptografía homomórfica y computación multipartita segura.

Uso de técnicas de regularización como el Dropout por la relación entre sobreentrenamiento y privacidad.

La compresión de modelos se ha propuesto como defensa contra los ataques de reconstrucción.

? ¿Enlaces útiles?

- Ataques de inferencia de membresía contra modelos de aprendizaje automático

- Ataques de inversión de modelos que explotan la información confidencial y contramedidas básicas

- Modelos de aprendizaje automático que recuerdan demasiado

- ML-Leaks: ataques y defensas de inferencia de membresía independiente de modelos y datos en modelos de aprendizaje automático

- Modelos profundos bajo GAN: fuga de información del aprendizaje profundo colaborativo

- LOGAN: Ataques de inferencia de membresía contra modelos generativos

- Sobreajuste, robustez y algoritmos maliciosos: un estudio de las posibles causas de riesgo de privacidad en el aprendizaje automático

- Análisis integral de la privacidad del aprendizaje profundo: aprendizaje independiente y federado bajo ataques de inferencia de caja blanca activos y pasivos

- Ataques de inferencia contra el aprendizaje colaborativo

- The Secret Sharer: Evaluación y prueba de memorización no deseada en redes neuronales

- Hacia la ciencia de la seguridad y la privacidad en el aprendizaje automático

- MemGuard: defensa contra ataques de inferencia de membresía de caja negra mediante ejemplos contradictorios

- Extracción de datos de entrenamiento de modelos de lenguaje grandes

- Ataques de inferencia de propiedades en redes neuronales totalmente conectadas utilizando representaciones invariantes de permutación

- Extracción de datos de entrenamiento de modelos de difusión

- Reconstrucción de imágenes de alta resolución con modelos de difusión latente de la actividad del cerebro humano

- Robar y evadir clasificadores de malware y antivirus en condiciones bajas de falsos positivos.

- Ataques realistas de presentación de huellas dactilares basados en un enfoque adversario

- Pruebas adversas activas: aumento de la confianza en las evaluaciones de robustez adversas.

- Estado de jailbreak de GPT: actualizaciones sobre el estado de jailbreak del modelo de lenguaje OpenAI GPT.

- Orden de aceleración de magnitud para la inferencia de membresía de LLM

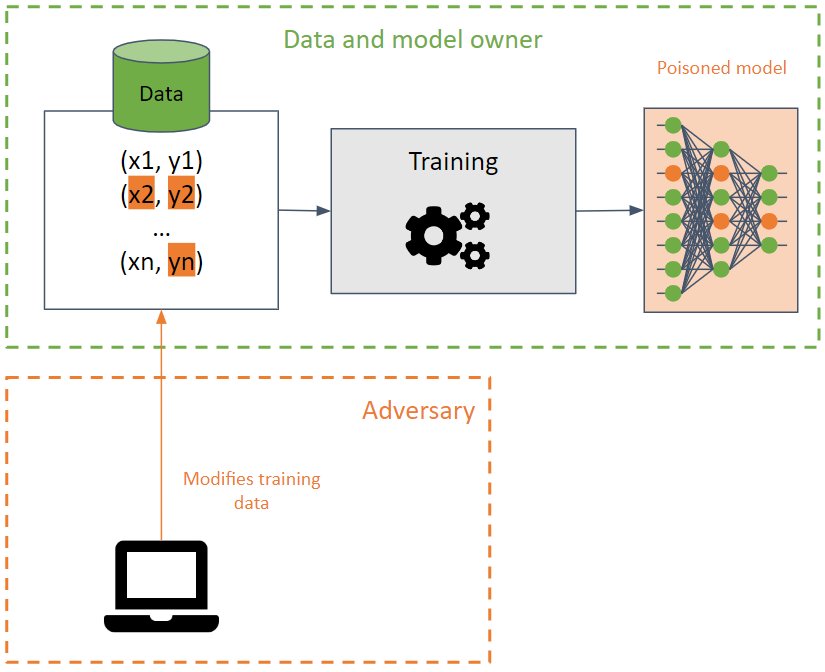

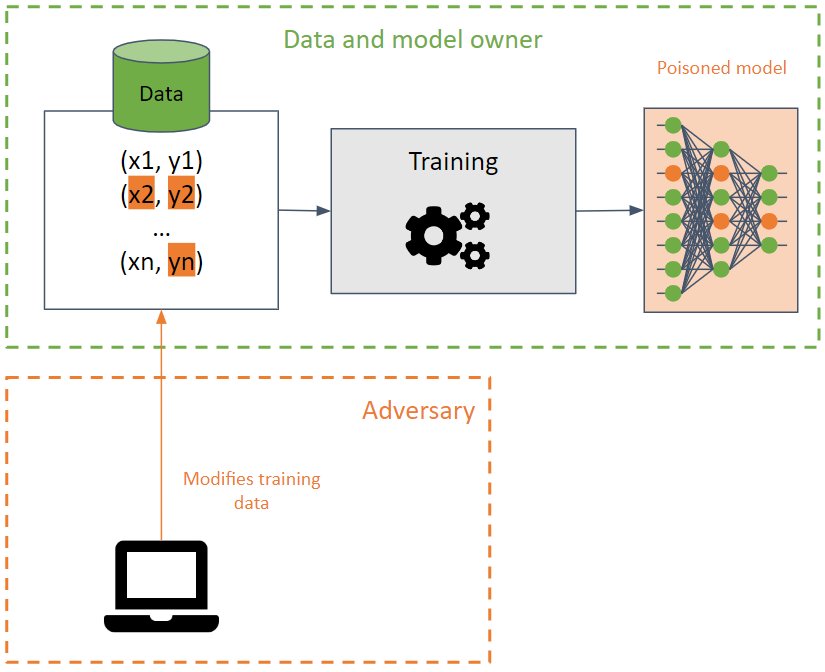

? ¿Envenenamiento?

Su objetivo es corromper el conjunto de entrenamiento haciendo que un modelo de aprendizaje automático reduzca su precisión.

Este ataque es difícil de detectar cuando se realiza sobre los datos de entrenamiento, ya que el ataque puede propagarse entre diferentes modelos utilizando los mismos datos de entrenamiento.

El adversario busca destruir la disponibilidad del modelo modificando el límite de decisión y, como resultado, produciendo predicciones incorrectas o creando una puerta trasera en un modelo. En este último, el modelo se comporta correctamente (devolviendo las predicciones deseadas) en la mayoría de los casos, excepto ciertas entradas especialmente creadas por el adversario que producen resultados no deseados. El adversario puede manipular los resultados de las predicciones y lanzar futuros ataques.

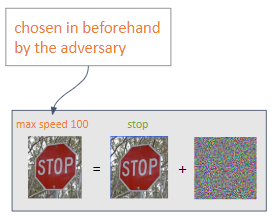

? ¿Puertas traseras?

Las BadNets son el tipo de puerta trasera más simple en un modelo de aprendizaje automático. Además, las BadNets se pueden conservar en un modelo, incluso si se vuelven a entrenar para una tarea diferente a la del modelo original (aprendizaje por transferencia).

Es importante tener en cuenta que los modelos públicos previamente entrenados pueden contener puertas traseras .

?️ Acciones defensivas ?️

Detección de datos envenenados, junto con el uso de desinfección de datos.

Robustos métodos de entrenamiento.

Defensas específicas.

- Limpieza neuronal: identificación y mitigación de ataques de puerta trasera en redes neuronales

- STRIP: una defensa contra los ataques troyanos a las redes neuronales profundas

- Detección de ataques de puerta trasera a redes neuronales profundas mediante agrupación de activación

- ABS: escaneo de redes neuronales en busca de puertas traseras mediante estimulación cerebral artificial

- DeepInspect: un marco de mitigación y detección de troyanos de caja negra para redes neuronales profundas

- Defensa de puertas traseras neuronales mediante modelado de distribución generativa

- Una encuesta completa sobre ataques de puerta trasera y sus defensas en sistemas de reconocimiento facial

- DataElixir: purificación de conjuntos de datos envenenados para mitigar ataques de puerta trasera mediante modelos de difusión

? ¿Enlaces útiles?

- Ataques de envenenamiento contra máquinas de vectores de soporte

- Ataques de puerta trasera dirigidos a sistemas de aprendizaje profundo mediante envenenamiento de datos

- Ataque de troyanos a redes neuronales

- Poda fina: defensa contra ataques de puerta trasera a redes neuronales profundas

- ¡Ranas venenosas! Ataques de envenenamiento dirigidos a redes neuronales con etiqueta limpia

- Firmas espectrales en ataques de puerta trasera

- Ataques de puerta trasera latentes a redes neuronales profundas

- Regula Sub-rosa: ataques de puerta trasera latentes a redes neuronales profundas

- Ataques de puerta trasera con disparador oculto

- Ataques de envenenamiento transferibles de etiqueta limpia a redes neuronales profundas

- TABOR: un enfoque altamente preciso para inspeccionar y restaurar puertas traseras troyanas en sistemas de inteligencia artificial

- Hacia el envenenamiento de los algoritmos de aprendizaje profundo con optimización de gradiente posterior

- ¿Cuándo FALLA el aprendizaje automático? Transferibilidad generalizada para ataques de evasión y envenenamiento

- Defensas certificadas contra ataques de envenenamiento de datos

- Ataque de puerta trasera dinámica con reconocimiento de entrada

- Cómo hacer una puerta trasera al aprendizaje federado

- Colocación de puertas traseras indetectables en modelos de aprendizaje automático

- ¡Engañe a la IA!: Los piratas informáticos pueden utilizar puertas traseras para envenenar los datos de entrenamiento y provocar que un modelo de IA clasifique erróneamente las imágenes. Descubra cómo los investigadores de IBM pueden saber cuándo los datos han sido envenenados y luego adivine qué puertas traseras se han ocultado en estos conjuntos de datos. ¿Puedes adivinar la puerta trasera?

- Backdoor Toolbox: una caja de herramientas compacta para ataques y defensas de puerta trasera.

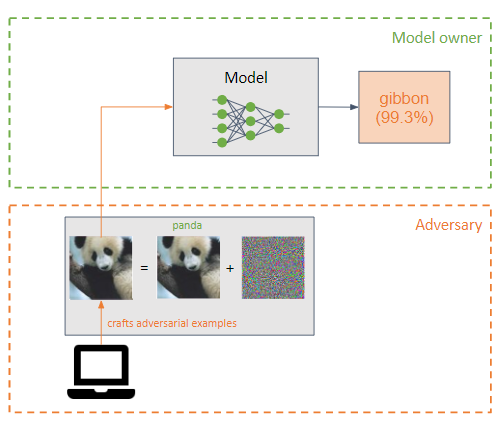

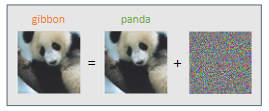

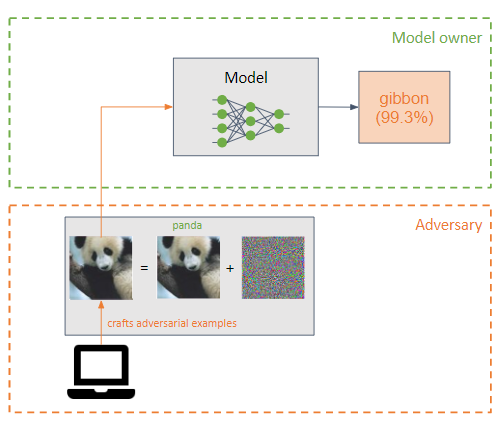

?♂️ Evasión ?♂️

Un adversario agrega una pequeña perturbación (en forma de ruido) a la entrada de un modelo de aprendizaje automático para que se clasifique incorrectamente (ejemplo, adversario).

Son similares a los ataques de envenenamiento, pero su principal diferencia es que los ataques de evasión intentan explotar las debilidades del modelo en la fase de inferencia.

El objetivo del adversario es que los ejemplos adversarios sean imperceptibles para un humano.

Se pueden realizar dos tipos de ataque dependiendo de la salida deseada por el oponente:

Los ataques más comunes son los ataques de caja blanca :

- L-BFGS

- FGSM

- BIM

- JSMA

- Carlini y Wagner (C&W)

- Newtontonto

- EAD

- UAP

?️ Acciones defensivas ?️

Entrenamiento adversario, que consiste en elaborar ejemplos adversarios durante el entrenamiento para permitir que el modelo aprenda características de los ejemplos adversarios, lo que hace que el modelo sea más robusto ante este tipo de ataque.

Transformaciones sobre entradas.

Enmascaramiento/regularización de gradientes. No muy efectivo.

Defensas débiles.

Defensas contra la inyección rápida: todas las defensas prácticas y propuestas contra la inyección rápida.

Punto de referencia Lakera PINT: El punto de referencia de la prueba de inyección rápida (PINT) proporciona una forma neutral de evaluar el rendimiento de un sistema de detección de inyección rápida, como Lakera Guard, sin depender de conjuntos de datos públicos conocidos que estas herramientas pueden utilizar para optimizar el rendimiento de la evaluación.

Inferencia del diablo: un método para evaluar de manera adversa el modelo Phi-3 Instruct observando la distribución de la atención en sus cabezas cuando se exponen a entradas específicas. Este enfoque incita al modelo a adoptar la "mentalidad del diablo", lo que le permite generar resultados de naturaleza violenta.

? ¿Enlaces útiles?

- Ataques prácticos de caja negra contra el aprendizaje automático

- Las limitaciones del aprendizaje profundo en entornos conflictivos

- Hacia la evaluación de la robustez de las redes neuronales

- La destilación como defensa contra las perturbaciones adversas contra las redes neuronales profundas

- Ejemplos contradictorios en el mundo físico.

- Entrenamiento de confrontación en conjunto: ataques y defensas

- Hacia modelos de aprendizaje profundo resistentes a ataques adversarios

- Propiedades intrigantes de las redes neuronales

- Explicar y aprovechar ejemplos contradictorios

- Profundizando en ejemplos contradictorios transferibles y ataques de caja negra

- Aprendizaje automático adversario a escala

- Ataques adversarios de caja negra con consultas e información limitadas

- Expresión de funciones: detección de ejemplos contradictorios en redes neuronales profundas

- Ataques adversarios basados en decisiones: ataques confiables contra modelos de aprendizaje automático de caja negra

- Impulsar los ataques adversarios con impulso

- El espacio de los ejemplos contradictorios transferibles

- Contrarrestar imágenes adversarias mediante transformaciones de entrada

- Defense-GAN: protección de clasificadores contra ataques adversarios utilizando modelos generativos

- Sintetizando ejemplos contradictorios sólidos

- Mitigar los efectos adversos mediante la aleatorización

- Sobre la detección de perturbaciones adversas

- Parche adversario

- PixelDefend: Aprovechamiento de modelos generativos para comprender y defenderse de ejemplos contradictorios

- Ataque de un píxel para engañar a las redes neuronales profundas

- Defensas eficientes contra ataques adversarios

- Robustos ataques del mundo físico a la clasificación visual de aprendizaje profundo

- Perturbaciones adversas contra redes neuronales profundas para la clasificación de malware

- Ataques adversarios 3D más allá de la nube de puntos

- Las perturbaciones adversas engañan a los detectores de deepfake

- Deepfakes adversarios: evaluación de la vulnerabilidad de los detectores de deepfake ante ejemplos adversarios

- Una descripción general de las vulnerabilidades de los sistemas controlados por voz

- FastWordBug: un método rápido para generar texto contradictorio contra aplicaciones de PNL

- El fantasma de los ADAS: proteger los sistemas avanzados de asistencia al conductor frente a ataques fantasmas en fracciones de segundo

- llm-attacks: ataques universales y transferibles a modelos de lenguaje alineados.

- Ataques a modelos de IA: inyección rápida versus envenenamiento de la cadena de suministro

- Ataque de inyección rápida contra aplicaciones integradas en LLM

- garak: escáner de vulnerabilidad LLM.

- Transformaciones adversas simples en PyTorch

- Complementos de ChatGPT: filtración de datos a través de imágenes y falsificación de solicitudes de complementos cruzados

- Secuestros de imágenes: las imágenes adversarias pueden controlar los modelos generativos en tiempo de ejecución

- Multiataques: muchas imágenes + el mismo ataque adversario → muchas etiquetas de objetivos

- ACTIVO: Hacia un camuflaje físico 3D altamente transferible para una evasión de vehículos universal y robusta

- LLM Red Teaming GPTS: Fuga rápida, Fuga de API, Fuga de documentos

- Ejemplos contradictorios reproducibles por humanos

- Desafíos del jailbreak multilingüe en modelos de lenguajes grandes

- Uso indebido de herramientas en modelos de lenguaje grandes con ejemplos visuales de adversarios

- AutoDAN: ataques adversarios interpretables basados en gradientes en modelos de lenguaje grandes

- Inyección multimodal: (Ab) uso de imágenes y sonidos para inyección de instrucción indirecta en LLM multimodales.

- JailbreakingLLMs: Jailbreaking de modelos de lenguaje grandes de caja negra en veinte consultas.

- Árbol de ataques: jailbreak de LLM de caja negra automáticamente

- GPT: mensajes filtrados de GPT.

- Exploits de IA: una colección de exploits de IA/ML del mundo real para vulnerabilidades divulgadas de manera responsable.

- Los agentes de LLM pueden piratear sitios web de forma autónoma

- Cloudflare anuncia Firewall para IA

- PromptInject: marco que ensambla mensajes de forma modular para proporcionar un análisis cuantitativo de la solidez de los LLM ante ataques rápidos adversarios.

- LLM Red Teaming: enfoques conflictivos, de programación y lingüísticos VS ChatGPT, Claude, Mistral, Grok, LLAMA y Gemini

- La jerarquía de instrucción: capacitación de LLM para priorizar instrucciones privilegiadas

- Inyección inmediata / jailbreak a un agente de LLM bancario (GPT-4, Langchain)

- GitHub Copilot Chat: de la inyección rápida a la filtración de datos

- Los ejemplos contradictorios están desalineados en las variedades del modelo de difusión

- Jailbreak lógico de imagen a texto: tu imaginación puede ayudarte a hacer cualquier cosa

- Mitigating Skeleton Key, un nuevo tipo de técnica de jailbreak con IA generativa

- Punto de referencia de ofuscación de imágenes: este repositorio contiene el código para evaluar modelos en el punto de referencia de ofuscación de imágenes, presentado por primera vez en Evaluación comparativa de robustez ante ofuscaciones de imágenes adversas.

- Liberar modelos de lenguaje grandes con matemáticas simbólicas

Herramientas

| Nombre | Tipo | Algoritmos soportados | Tipos de ataques soportados | Ataque/Defensa | Marcos soportados | Popularidad |

|---|

| Cleverhans | Imagen | Aprendizaje profundo | Evasión | Ataque | Tensorflow, Keras, JAX | |

| Caja tonta | Imagen | Aprendizaje profundo | Evasión | Ataque | Tensorflow, PyTorch, JAX | |

| ARTE | Cualquier tipo (imagen, datos tabulares, audio,...) | Aprendizaje profundo, SVM, LR, etc. | Cualquiera (extracción, inferencia, envenenamiento, evasión) | Ambos | Tensorflow, Keras, Pytorch, Scikit Aprende | |

| ataque de texto | Texto | Aprendizaje profundo | Evasión | Ataque | Keras, abrazando la cara | |

| Antorcha publicitaria | Imagen | Aprendizaje profundo | Evasión | Ambos | --- | |

| AdvBox | Imagen | Aprendizaje profundo | Evasión | Ambos | PyTorch, Tensorflow, MxNet | |

| ProfundoRobusto | Imagen, gráfico | Aprendizaje profundo | Evasión | Ambos | PyTorch | |

| Contraajuste | Cualquier | Cualquier | Evasión | Ataque | --- | |

| Ejemplos de audio adversarios | Audio | Habla profunda | Evasión | Ataque | --- | |

ARTE

Adversarial Robustness Toolbox, abreviado como ART, es una biblioteca de código abierto de Adversarial Machine Learning para probar la solidez de los modelos de aprendizaje automático.

Está desarrollado en Python e implementa ataques y defensas de extracción, inversión, envenenamiento y evasión.

ART admite los marcos más populares: Tensorflow, Keras, PyTorch, MxNet y ScikitLearn, entre muchos otros.

No se limita al uso de modelos que utilizan imágenes como entrada sino que también admite otros tipos de datos, como audio, vídeo, datos tabulares, etc.

Taller para aprender Machine Learning Adversarial con ART ??

Cleverhans

Cleverhans es una biblioteca para realizar ataques de evasión y probar la solidez de un modelo de aprendizaje profundo en modelos de imágenes.

Está desarrollado en Python y se integra con los frameworks Tensorflow, Torch y JAX.

Implementa numerosos ataques como L-BFGS, FGSM, JSMA, C&W, entre otros.

? Usar ?

La IA se utiliza para realizar tareas maliciosas y potenciar los ataques clásicos.

♂️ Pentesting ♂️

- GyoiThon: herramienta de prueba de penetración de próxima generación, herramienta de recopilación de inteligencia para servidor web.

- Deep Exploit: herramienta de prueba de penetración totalmente automática que utiliza Deep Reinforcement Learning.

- AutoPentest-DRL: pruebas de penetración automatizadas que utilizan aprendizaje por refuerzo profundo.

- DeepGenerator: genera códigos de inyección de forma totalmente automática para la evaluación de aplicaciones web utilizando algoritmos genéticos y redes generativas adversas.

- Eyeballer: Eyeballer está diseñado para pruebas de penetración de red de gran alcance en las que es necesario encontrar objetivos "interesantes" entre un gran conjunto de servidores web.

- Nebula: Asistente de piratería ética impulsado por IA.

- Los equipos de agentes LLM pueden explotar las vulnerabilidades de día cero

- Perspectivas y lagunas actuales en los escáneres de vulnerabilidad LLM de código abierto: un análisis comparativo

? ¿Malware?

- DeepLocker: ocultación de ataques dirigidos con cerrajería de IA, de IBM Labs en BH.

- Una descripción general de la inteligencia artificial utilizada en malware: una lista seleccionada de recursos de malware de IA.

- DeepObfusCode: Ofuscación del código fuente a través de redes de secuencia a secuencia.

- AutoCAT: aprendizaje reforzado para la exploración automatizada de ataques de sincronización de caché.

- BOTNET BASADO EN IA: un enfoque de teoría de juegos para la defensa contra ataques de botnets basados en IA.

- SECML_Malware: biblioteca de Python para crear ataques adversarios contra detectores de malware de Windows.

- Lanzamiento trascendente: uso de la evaluación conforme para detectar la deriva de conceptos que afecta la detección de malware.

?️ OSINT ?️

- SNAP_R: genera automáticamente publicaciones de phishing en las redes sociales.

- SpyScrap: SpyScrap combina métodos de reconocimiento facial para filtrar los resultados y utiliza procesamiento de lenguaje natural para obtener entidades importantes del sitio web en el que aparece el usuario.

? ¿Phishing?

- DeepDGA: Implementación de DeepDGA: generación y detección de dominios ajustados por el adversario.

? ¿Inteligencia sobre amenazas?

- De arenas a mansiones: habilitación de la construcción automática de ciberataques de ciclo de vida completo con LLM

? ¿Canales laterales?

- SCAAML: Ataques de canal lateral asistidos con aprendizaje automático.

?? ¿IA generativa?

? ¿Audio?

Herramientas

- deep-voice-conversion: Redes neuronales profundas para conversión de voz (transferencia de estilo de voz) en Tensorflow.

- tacotron: una implementación de TensorFlow de la síntesis de voz Tacotron de Google con un modelo previamente entrenado (no oficial).

- Clonación de voz en tiempo real: clona una voz en 5 segundos para generar voz arbitraria en tiempo real.

- mimic2: Motor de texto a voz basado en la arquitectura Tacotron, implementado inicialmente por Keith Ito.

- Clonación de voz neuronal con pocas muestras: Implementación de la clonación de voz neuronal con pocas muestras Artículo de investigación de Baidu.

- Vall-E: una implementación no oficial de PyTorch del audio LM VALL-E.

- cambiador de voz: Cambiador de voz en tiempo real.

- WebUI de conversión de voz basada en recuperación: un marco de conversión de voz fácil de usar basado en VITS.

- Audiocraft: Audiocraft es una biblioteca para procesamiento y generación de audio con aprendizaje profundo. Cuenta con el compresor/tokenizador de audio EnCodec de última generación, junto con MusicGen, un LM de generación de música simple y controlable con acondicionamiento textual y melódico.

- VALL-EX: una implementación de código abierto del modelo TTS de disparo cero VALL-E X de Microsoft.

- OpenVoice: Clonación de voz instantánea mediante MyShell.

- MeloTTS: biblioteca de conversión de texto a voz multilingüe de alta calidad de MyShell.ai. Admite inglés, español, francés, chino, japonés y coreano.

- VoiceCraft: edición de voz Zero-Shot y conversión de texto a voz en la naturaleza.

- Parler-TTS: Biblioteca de inferencia y entrenamiento para modelos TTS de alta calidad.

- ChatTTS: un modelo de discurso generativo para el diálogo diario.

Aplicaciones

- Lip2Wav: Genera voz de alta calidad a partir únicamente de movimientos de labios.

- AudioLDM: Generación de texto a audio con modelos de difusión latente

- deepvoice3_pytorch: Implementación en PyTorch de modelos de síntesis de texto a voz basados en redes neuronales convolucionales.

- ? Riffusion: Difusión estable para generación de música en tiempo real.

- susurro.cpp: Puerto del modelo Whisper de OpenAI en C/C++.

- TTS: ? - un conjunto de herramientas de aprendizaje profundo para Text-to-Speech, probado en investigación y producción.

- YourTTS: Hacia un TTS multialtavoz Zero-Shot y una conversión de voz Zero-Shot para todos.

- TorToiSe: Un sistema TTS multivoz entrenado con énfasis en la calidad.

- DiffSinger: Síntesis de voz cantada mediante un mecanismo de difusión superficial (SVS y TTS).

- Vocoder WaveNet: Implementación del vocoder WaveNet, que puede generar muestras de voz sin procesar de alta calidad condicionadas a características lingüísticas o acústicas.

- Deepvoice3_pytorch: implementación de PyTorch de modelos de síntesis de texto a voz basados en redes neuronales convolucionales.

- eSpeak NG Texto a voz: eSpeak NG es un sintetizador de voz de código abierto que admite más de cien idiomas y acentos.

- RealChar: crea, personaliza y habla con tu personaje/compañero de IA en tiempo real (¡código base todo en uno!). Mantenga una conversación natural y fluida con IA en cualquier lugar (móvil, web y terminal) utilizando LLM OpenAI GPT3.5/4, Anthropic Claude2, Chroma Vector DB, Whisper Speech2Text, ElevenLabs Text2Speech.

- Clonación de voz neuronal con algunas muestras

- NAUTILUS: Un sistema versátil de clonación de voz

- Aprender a hablar con fluidez en una lengua extranjera: síntesis de voz multilingüe y clonación de voz entre idiomas

- Cuando el bien se convierte en mal: inferencia de pulsaciones de teclas con un reloj inteligente

- KeyListener: Inferir pulsaciones de teclas en el teclado QWERTY de la pantalla táctil a través de señales acústicas

- Esta voz no existe: sobre la síntesis de voz, los deepfakes de audio y su detección

- AudioSep: Separe todo lo que describa.

- stable-audio-tools: Modelos generativos para generación de audio condicional.

- GPT-SoVITS-WebUI: ¡También se pueden utilizar datos de voz de 1 minuto para entrenar un buen modelo TTS! (pocas tomas de clonación de voz).

- Hybrid-Net: Separación de fuentes de audio en tiempo real, genera letras, acordes y ritmos.

- CosyVoice: modelo multilingüe de generación de voz grande, que proporciona capacidad de inferencia, capacitación e implementación de pila completa.

- EasyVolcap: Aceleración de la investigación de vídeos volumétricos neuronales.

? ¿Detección?

- detección de voz falsa: uso de convolución temporal para detectar Audio Deepfakes.

- Un robusto sistema de detección de suplantación de voz que utiliza funciones novedosas de CLS-LBP y LSTM

- Detector de suplantación de voz: un marco antisuplantación de voz unificado

- Protección de interfaces controladas por voz contra ataques de audio falsos (clonados)

- DeepSonar: hacia una detección eficaz y sólida de voces falsas sintetizadas por IA

- Luchando contra la IA con IA: detección de discursos falsos mediante aprendizaje profundo

- Una revisión de los métodos modernos de detección de audio deepfake: desafíos y direcciones futuras

? Imagen ?

Herramientas

- StyleGAN: StyleGAN - Implementación oficial de TensorFlow.

- StyleGAN2: StyleGAN2 - Implementación oficial de TensorFlow.

- stylegan2-ada-pytorch: StyleGAN2-ADA: implementación oficial de PyTorch.

- StyleGAN-nada: Adaptación de dominio guiada por CLIP de generadores de imágenes.

- StyleGAN3: Implementación oficial de PyTorch de StyleGAN3.

- Imaginaire: Imaginaire es una biblioteca de pytorch que contiene la implementación optimizada de varios métodos de síntesis de imágenes y videos desarrollados en NVIDIA.

- ffhq-dataset: Conjunto de datos Flickr-Faces-HQ (FFHQ).

- DALLE2-pytorch: Implementación de DALL-E 2, la red neuronal de síntesis de texto a imagen actualizada de OpenAI, en Pytorch.

- ImagineAIry: Imágenes imaginadas por IA. Generación pitónica de imágenes de difusión estable.

- Lama Cleaner: herramienta de pintura de imágenes impulsada por SOTA AI Model. Elimine cualquier objeto, defecto o personas no deseadas de sus imágenes o borre y reemplace (con tecnología de difusión estable) cualquier cosa en sus imágenes.

- Cambio de escala de imagen invertible: esta es la implementación de PyTorch del papel: Cambio de escala de imagen invertible.

- DifFace: Restauración de cara ciega con contracción de error difuso (PyTorch).

- CodeFormer: Hacia una restauración robusta de caras ciegas con Codebook Lookup Transformer.

- Difusión personalizada: personalización de múltiples conceptos de difusión de texto a imagen.

- Difusores: ? Difusores: Modelos de difusión de última generación para generación de imágenes y audio en PyTorch.

- Difusión estable: síntesis de imágenes de alta resolución con modelos de difusión latente.

- InvokeAI: InvokeAI es un motor creativo líder para modelos de difusión estable, que permite a profesionales, artistas y entusiastas generar y crear medios visuales utilizando las últimas tecnologías impulsadas por IA. La solución ofrece una interfaz de usuario web líder en la industria, admite el uso de terminales a través de una CLI y sirve como base para múltiples productos comerciales.

- Interfaz de usuario web de difusión estable: interfaz de usuario web de difusión estable.

- Stable Diffusion Infinity: Pintura superior con Stable Diffusion en un lienzo infinito.

- Difusión Rápida Estable: difusión rápida-estable + DreamBooth.

- GET3D: un modelo generativo de formas texturizadas 3D de alta calidad aprendidas a partir de imágenes.

- Impresionante síntesis de imágenes artísticas con IA: una lista de herramientas, ideas, herramientas de ingeniería rápidas, colaboraciones, modelos y ayudas increíbles para el diseñador rápido que juega con aiArt y la síntesis de imágenes. Cubre Dalle2, MidJourney, StableDiffusion y herramientas de código abierto.

- Difusión estable: un modelo de difusión latente de texto a imagen.

- Difusión meteorológica: código para "restaurar la visión en condiciones climáticas adversas con modelos de difusión de eliminación de ruido basados en parches".

- DF-GAN: una base simple y eficaz para la síntesis de texto a imagen.

- Dall-E Playground: un área de juegos para generar imágenes a partir de cualquier mensaje de texto usando Stable Diffusion (pasado: usando DALL-E Mini).

- MM-CelebA-HQ-Dataset: un conjunto de datos de imágenes de rostros a gran escala que permite la generación de texto a imagen, manipulación de imágenes guiada por texto, generación de boceto a imagen, GAN para generación y edición de rostros, subtítulos de imágenes y VQA.

- Deep Daze: herramienta de línea de comandos simple para la generación de texto a imagen utilizando CLIP y Siren (red de representación neuronal implícita) de OpenAI.

- StyleMapGAN: explotación de las dimensiones espaciales de latente en GAN para la edición de imágenes en tiempo real.

- Kandinsky-2: modelo de difusión latente de texto2imagen multilingüe.

- DragGAN: manipulación interactiva basada en puntos en la variedad de imágenes generativas.

- Segment Anything: el repositorio proporciona código para ejecutar inferencias con el modelo SegmentAnything (SAM), enlaces para descargar los puntos de control del modelo entrenado y cuadernos de ejemplo que muestran cómo utilizar el modelo.

- Segment Anything 2: el repositorio proporciona código para ejecutar inferencia con Meta Segment Anything Model 2 (SAM 2), enlaces para descargar los puntos de control del modelo entrenado y cuadernos de ejemplo que muestran cómo usar el modelo.

- MobileSAM: ¡Este es el código oficial del proyecto MobileSAM que hace que SAM sea liviano para aplicaciones móviles y más!

- FastSAM: segmenta rápidamente cualquier cosa

- Infinigen: mundos fotorrealistas infinitos mediante generación procesal.

- DALL·E 3

- StreamDiffusion: una solución a nivel de canalización para generación interactiva en tiempo real.

- AnyDoor: personalización de imágenes a nivel de objeto de disparo cero.

- DiT: Modelos de Difusión Escalables con Transformadores.

- BrushNet: un modelo de pintura de imágenes plug-and-play con difusión descompuesta de dos ramas.

- OOTDiffusion: Equipamiento de difusión latente basada en Fusion para una prueba virtual controlable.

- VAR: Impl. oficial. de "Modelado visual autorregresivo: generación de imágenes escalables mediante predicción de siguiente escala".

- Imagine Flash: Aceleración de los modelos de difusión de Emu con destilación regresiva

Aplicaciones

- ArtLine: un proyecto basado en aprendizaje profundo para crear retratos artísticos lineales.

- Depix: recupera contraseñas de capturas de pantalla pixeladas.

- Devolver la vida a fotografías antiguas: restauración de fotografías antiguas (implementación oficial de PyTorch).

- Reescritura: herramienta interactiva para editar directamente las reglas de una GAN para sintetizar escenas con objetos agregados, eliminados o alterados. Cambia StyleGANv2 para crear cejas extravagantes o caballos con sombreros.

- Fawkes: herramienta para preservar la privacidad frente a los sistemas de reconocimiento facial.

- Pulse: muestreo superior de fotografías autosupervisado mediante exploración del espacio latente de modelos generativos.

- HiDT: Repositorio oficial del artículo "Traducción diurna de alta resolución sin etiquetas de dominio".

- Pintura interna de fotografías en 3D: fotografía en 3D utilizando pintura interna en profundidad en capas sensible al contexto.

- SteganoGAN: SteganoGAN es una herramienta para crear imágenes esteganográficas mediante entrenamiento adversario.

- Stylegan-T: Liberando el poder de las GAN para una síntesis rápida de texto a imagen a gran escala.

- MegaPortraits: avatares de cabezas neuronales de megapíxeles de una sola toma.

- eg3d: Redes adversarias generativas 3D eficientes y conscientes de la geometría.

- TediGAN: Implementación de Pytorch para TediGAN: Generación y manipulación de imágenes de rostros diversos guiadas por texto.

- DALLE-pytorch: Implementación/replicación de DALL-E, el transformador de texto a imagen de OpenAI, en Pytorch.

- StyleNeRF: esta es la implementación de código abierto del artículo ICLR2022 "StyleNeRF: un generador 3D basado en estilos para síntesis de imágenes de alta resolución".

- DeepSVG: Código oficial del artículo "DeepSVG: una red generativa jerárquica para animación de gráficos vectoriales". Incluye una biblioteca PyTorch para aprendizaje profundo con datos SVG.

- NUWA: un transformador 3D unificado para síntesis visual.

- Imagen-Super-Resolución-vía-Refinamiento-Iterativo: Implementación no oficial de Imagen Super-Resolución vía Refinamiento Iterativo por Pytorch.

- Lama: ? LaMa Image Inpainting, Inpainting de máscara grande de resolución robusta con convoluciones de Fourier.

- Person_reID_baseline_pytorch: Pytorch ReID: una implementación de pytorch pequeña, amigable y potente de la línea base de reidentificación de objetos.

- instruct-pix2pix: implementación en PyTorch de InstructPix2Pix, un modelo de edición de imágenes basado en instrucciones.

- GFPGAN: GFPGAN tiene como objetivo desarrollar algoritmos prácticos para la restauración de rostros en el mundo real.

- DeepVecFont: síntesis de fuentes vectoriales de alta calidad mediante aprendizaje de modalidad dual.

- Stargan v2 Tensorflow: Implementación oficial de Tensorflow.

- Destilación StyleGAN2: la traducción emparejada de imagen a imagen, entrenada con datos sintéticos generados por StyleGAN2, supera los enfoques existentes en la manipulación de imágenes.

- Extracción de datos de entrenamiento de modelos de difusión

- Mann-E - Mann-E (persa: مانی) es un modelo generador de arte basado en los pesos de Stable Diffusion 1.5 y los datos recopilados del material artístico disponible en Pinterest.

- Redes de codificador-decodificador CNN entrenadas de extremo a extremo para esteganografía de imágenes

- Grounded-Segment-Anything: combinando Grounding DINO con Segment Anything y Difusión estable y Tag2Text y BLIP y Whisper y ChatBot: detecta, segmenta y genera cualquier cosa automáticamente con entradas de imagen, texto y audio.

- AnimateDiff: anime sus modelos personalizados de difusión de texto a imagen sin ajustes específicos.

- BasicSR: Caja de herramientas de restauración de imágenes y videos de código abierto para superresolución, eliminación de ruido, eliminación de desenfoque, etc. Actualmente, incluye EDSR, RCAN, SRResNet, SRGAN, ESRGAN, EDVR, BasicVSR, SwinIR, ECBSR, etc. También es compatible con StyleGAN2 y DFDNet. [](https://github.com/XPixelGroup/BasicSR)

- Real-ESRGAN: Real-ESRGAN tiene como objetivo desarrollar algoritmos prácticos para la restauración general de imágenes/videos.

- ESRGAN: SRGAN mejorado. Campeón del desafío PIRM sobre superresolución perceptual.

- MixNMatch: codificación y desenredo multifactor para la generación de imágenes condicionales.

- Clarity-upscaler: mejora de imagen reinventada para todos.

- Difusión de un solo paso con la destilación de coincidencia de distribución

- Puntada invisible: generar escenas 3D suaves con profundidad de entrada.

- SSR: reconstrucción de escena 3D de visión única con forma y textura de alta fidelidad.

- INVSR: Imagen de pasos arbitrarios Super-resolución a través de la inversión de difusión.

? Detección?

- StyleGan3 Detector: Detección de imágenes sintéticas StyleGan3.

- Imperios de proyección StyleGan2: Proyecto de imágenes al espacio latente con StyleGan2.

- Faldetector: Detección de caras Photoshop al secuestrar Photoshop.

? Video ?

Herramientas

- Deepfacelab: Deepfacelab es el software líder para crear defectos profundos.

- Faceswap: Software de DeepFakes para todos.

- DOT: el kit de herramientas ofensivo de Deepfake.

- SIMSWAP: ¡Un marco arbitrario de intercambio de caras en imágenes y videos con un solo modelo entrenado!

- Faceswap-Gan: un autoindocoder de desnudos + pérdidas adversas y mecanismos de atención para el intercambio de cara.

- Celeb Deepfakeforensics: un conjunto de datos desafiante a gran escala para Forensics de Deepfake.

- VGen: un ecosistema holístico de generación de videos para la generación de videos que se basa en modelos de difusión.

- Musev: Generación de videos humanos virtuales de longitud infinita y de alta fidelidad con descenso paralelo visual condicionado.

- Glee: Modelo General Object Foundation para imágenes y videos a escala.

- T-Rex: hacia la detección de objetos genéricos a través de la sinergia rápida visual de texto.

- DynamicRafter: animación de imágenes de dominio abierto con videos de difusión Priors.

- Mora: Más como Sora para la generación de videos generalistas.

Aplicaciones

- Face2Face-Demo: PIX2PIX Demo que aprende de los puntos de referencia faciales y lo traduce en una cara.

- Faceswap-Depfake-Pytorch: Faceswap con Pytorch o Deepfake con Pytorch.

- Punto-E: difusión de nubes de puntos para la síntesis del modelo 3D.

- EGVSR: Video eficiente y genérico súper resolución.

- STIT: CUTA IT A TIEMPO: edición facial basada en GaN de videos reales.

- Antecedentes Mattingv2: esteras de fondo de alta resolución en tiempo real.

- MODNET: una solución de retrato de retrato sin trimap en tiempo real.

- Matting de fondo: Matting de fondo: El mundo es tu pantalla verde.

- Modelo de primer orden: este repositorio contiene el código fuente para el modelo de movimiento de primer orden en papel para la animación de imágenes.

- Animación articulada: este repositorio contiene el código fuente para las representaciones de movimiento de papel CVPR'2021 para la animación articulada.

- Extracción de la persona en tiempo real: eliminar a las personas de entornos complejos en tiempo real usando tensorflow.js en el navegador web.

- Estilo ADAIN: transferencia de estilo arbitraria en tiempo real con normalización de instancias adaptativas.

- Interpolación del marco: interpolación del marco para un movimiento grande.

- Awesome-Image-Colorization: una colección de colorización de imágenes basadas en el aprendizaje profundo y documentos de colorización de video.

- Sadtalker: Aprendiendo coeficientes de movimiento 3D realistas para una animación estilizada de la cara parlante de imagen de una sola imagen.

- ROOP: One-Hick Deepfake (intercambio de cara).

- StableVideo: edición de video de difusión consistencia con consistencia basada en texto.

- Magedit: edición de video temporalmente coherente de alta fidelidad.

- Rerender_a_video: traducción de video a video guiada por texto a cero.

- Dreameditor: edición de escena 3D impulsada por el texto con campos neurales.

- Dreameditor: síntesis de vista 4D en tiempo real en la resolución 4K.

- Animateanyone: síntesis de imagen a video consistente y controlable para la animación de personajes.

- Moore-Animateanyone: este repositorio reproduce animateanyone.

- Audio2Photoreal: de audio a realización fotorreal: sintetizar a los humanos en las conversaciones.

- MagicVideo-V2: Generación de videos de alta etapa de estadio

- LWM: un modelo autororregresivo multimodal de contexto general de uso general. Está capacitado en un gran conjunto de datos de diversos videos y libros largos utilizando ringatent y puede realizar el lenguaje, la imagen y la comprensión y la generación de videos.

- Aniportrait: síntesis de audio de animación de retratos fotorrealistas.

- Champ: animación de imagen humana controlable y consistente con guía paramétrica 3D.

- StreamV2V: transmisión de traducción de video a video con bancos de características.

- Deep-Live-Cam: intercambio de cara en tiempo real y video de un solo clic con una sola imagen.

- Sapiens: base para modelos de visión humana.

? Detección?

- FaceForensics ++: conjunto de datos FaceForensics.

- Detección profunda: hacia la detección de Deepfake que realmente funcione.

- falsVideoForensics: detectar videos de Fake Deep.

- Detección de Deepfake: la implementación de Pytorch de la detección de Deepfake basada en FaceForensics ++.

- SEQDeepFake: Código Pytorch para SeqDeepFake: detectar y recuperar la manipulación secuencial de DeepFake.

- PCL-I2G: Implementación no oficial: Aprendizaje de autoconsistencia para la detección de defectos profundos.

- DFDC Deepfake Challenge: una solución ganadora de premios para DFDC Challenge.

- Poi-Forensics: detección de defake de la persona de interés audiovisual.

- Estandarización de la detección de profundos: por qué los expertos dicen que es importante

- ¿Quieres detectar un defake profundo? Mira las estrellas en sus ojos

? Texto ?

Herramientas

- GLM-130B: un modelo pre-entrenado bilingüe abierto.

- LongterMchatexternalSources: GPT-3 chatbot con memoria a largo plazo y fuentes externas.

- Sketch: Asistente de escritura de código de IA que comprende el contenido de datos.

- Langchain: ⚡ Construir aplicaciones con LLM a través de la composibilidad ⚡.

- Chatgpt Wrapper: API para interactuar con Chatgpt usando Python y desde Shell.

- OpenAi-Python: la Biblioteca Operai Python proporciona un acceso conveniente a la API de OpenAI desde las aplicaciones escritas en el idioma Python.

- BETO: Versión española del modelo Bert.

- GPT-Code-Clippy: GPT-Code-Clippy (GPT-CC) es una versión de código abierto de GitHub Copilot, un modelo de idioma, basado en GPT-3, llamado GPT-Codex.

- GPT NEO: una implementación de modelos de estilo GPT-2 y estilo GPT-3 del modelo utilizando la biblioteca Mesh-TensorFlow.

- CTRL: modelo de lenguaje de transformador condicional para generación controlable.

- LLAMA: Código de inferencia para modelos de llama.

- Llama2

- Guardia de llamas 3

- UL2 20B: un aprendizaje de idiomas unificado de código abierto

- BURGPT: una extensión de la suite BURP que integra el GPT de OpenAI para realizar una exploración pasiva adicional para descubrir vulnerabilidades altamente a medida y permite ejecutar el análisis basado en el tráfico de cualquier tipo.

- Ollama: Llegue en funcionamiento con Llama 2 y otros modelos de idiomas grandes localmente.

- SneakyPrompt: modelos generativos de texto a imagen de jailbreak.

- Copilot-for-seguridad: una solución de seguridad generativa de IA que ayuda a aumentar la eficiencia y las capacidades de los defensores para mejorar los resultados de seguridad a la velocidad y la escala de la máquina, mientras que cumple con los principios de IA responsables.

- LM Studio: descubrir, descargar y ejecutar LLMS locales

- Bypass GPT: Convertir el texto de IA en contenido humano

- MGM: El marco admite una serie de modelos de lenguaje denso y MOE (LLMS) de 2B a 34B con comprensión de imagen, razonamiento y generación simultáneamente.

- Secret Llama: Totalmente privado LLM Chatbot que se ejecuta completamente con un navegador sin necesidad de servidor. Apoya a Mistral y Llama 3.

- Llama3: El sitio oficial de Meta Llama 3 Github.

? Detección?

- Detección de texto falso: sala de prueba de modelos de idiomas gigantes.

- Grover: Código para defender contra noticias falsas neuronales.

- REMUFF.AI: Detector de inyección inmediata.

- Nuevo clasificador de IA para indicar texto escrito por AI

- Descubra los 4 métodos mágicos para detectar el texto generado por AI (incluido el chatgpt)

- Gptzero

- Detector de contenido de IA (beta)

- Una marca de agua para modelos de idiomas grandes

- ¿Se puede detectar el texto generado por IA de manera confiable?

- Los detectores GPT están sesgados contra escritores ingleses no nativos

- Para chatgpt, o no para chatgpt: ¡esa es la pregunta!

- ¿Pueden los lingüistas distinguir entre chatgpt/ai y escritura humana?: Un estudio de ética de investigación y publicación académica

- Chatgpt es una mierda

Aplicaciones

- La escritura a mano: la escritura a mano genera una fuente personalizada basada en su muestra de escritura a mano.

- GPT Sandbox: El objetivo de este proyecto es permitir a los usuarios crear demostraciones web geniales utilizando la API Operai GPT-3 recientemente lanzada con solo unas pocas líneas de Python.

- Passgan: Un enfoque de aprendizaje profundo para la adivinación de contraseña.

- Índice GPT: el índice GPT es un proyecto que consiste en un conjunto de estructuras de datos diseñadas para facilitar el uso de grandes bases de conocimiento externas con LLM.

- NANOGPT: el repositorio más simple y más rápido para GPT de tamaño mediano de entrenamiento/ficetos.

- whatsapp-gpt

- Extensión de chatgpt Chrome: una extensión de chatgpt Chrome. Integra chatgpt en cada cuadro de texto en Internet.

- UNILM: pretraben de auto-supervisado a gran escala en tareas, idiomas y modalidades.

- MingPT: una reimplementación mínima de Pytorch del entrenamiento OpenAI GPT (transformador generativo de pretrada).

- CodeGeex: un modelo de generación de código multilingüe abierto.

- Libro de cocina de Operai: ejemplos y guías para usar la API de Operai.

- ? Impresiones de chatgpt impresionantes: este repositorio incluye la curación de inmediato de chatgpt para usar chatgpt mejor.

- Alice: Dar acceso de chatgpt a una terminal real.

- Revisión del código de seguridad con chatgpt

- ¿Los usuarios escriben un código más inseguro con asistentes de IA?

- Evitar los filtros de spam de Gmail con chatgpt

- Craker de contraseña de Gans recurrente para Mejora de seguridad de contraseña de IoT

- PentestGPT: una herramienta de prueba de penetración de poder GPT.

- Investigador de GPT: agente autónomo basado en GPT que realiza una investigación integral en línea sobre cualquier tema dado.

- Ingeniero GPT: Especifique lo que desea que construya, la IA solicita aclaraciones y luego lo construye.

- LocalPilot: ¡Use el copilot de GitHub localmente en su MacBook con un solo clic!

- [WORMGPT]) (https://thehackernews.com/2023/07/wormgpt-new-ai-ai-tool-allows.html): la nueva herramienta AI permite a los cibercriminales lanzar ataques cibernéticos sofisticados

- Poisongpt: Cómo escondimos un LLM lobotomizado en la cara abrazada para difundir noticias falsas

- PASSGPT: modelado de contraseña y generación (guiada) con modelos de idiomas grandes

- Deeppass - Encontrar contraseñas con aprendizaje profundo

- GPTFuzz: modelos de lenguaje grande de equipo rojo con indicaciones de jailbreak autopense.

- Abrir intérprete: intérprete de código de OpenAI en su terminal, ejecutándose localmente.

- Eureka: diseño de recompensas a nivel humano a través de la codificación de modelos de idiomas grandes.

- Metaclip: Datos de clip desmitificantes.

- LLM OSINT: método de prueba de concepto de uso de LLM para recopilar información de Internet y luego realizar una tarea con esta información.

- HackingBuddygpt: LLMS x Pentesting.

- Chatgpt-jailbreaks: jailbreak oficial para chatgpt (GPT-3.5). Envíe un mensaje largo al comienzo de la conversación con ChatGPT para obtener respuestas ofensivas, poco éticas, agresivas y humanas en inglés e italiano.

- Magika: detectar tipos de contenido de archivo con aprendizaje profundo.

- Jan: Una alternativa de código abierto a ChatGPT que se extiende 100% fuera de línea en su computadora.

- Librechat: clon de chatgpt mejorado: Características OpenAi, API de asistentes, Azure, Groq, GPT-4 Visión, Mistral, Bing, Anthricic, OpenRouter, Vertex AI, Gemini, conmutación de modelos de IA, búsqueda de mensajes, Langchain, Dall-E-3, Chatgpt Complementos, funciones de OpenAI, sistema de usuarios múltiples seguros, preajustes, código abierto para autohospedas.

- Lumina-T2X: un marco unificado para el texto a cualquier generación de modalidad.

Varios

- Awesome GPT + Security: una lista curada de herramientas de seguridad increíbles, estuche experimental u otras cosas interesantes con LLM o GPT.

- Aprendizaje de refuerzo impresionante para la seguridad cibernética: una lista curada de recursos dedicados al aprendizaje de refuerzo aplicado a la seguridad cibernética.

- Aprendizaje automático impresionante para la seguridad cibernética: una lista curada de herramientas y recursos increíblemente increíbles relacionados con el uso del aprendizaje automático para la seguridad cibernética.

- Curso de modelos de difusión de la cara abrazada: Materiales para el curso de modelos de difusión de la cara abrazada.

- Awesome-AI-Security: una lista curada de recursos de seguridad de IA.

- ML para hackers: código que acompaña al libro "Aprendizaje automático para hackers".

- Awful AI: Awful AI es una lista curada para rastrear los usos actuales de AI, con la esperanza de crear conciencia.

- NIST AI Risk Management Framework Playbook

- SOK: Aprendizaje automático explicable para aplicaciones de seguridad informática

- ¿Quién evalúa a los evaluadores? Sobre métricas automáticas para evaluar los generadores de código ofensivo basados en IA

- Priorización de vulnerabilidad: un enfoque de seguridad ofensivo

- MITER ATLAS ™ (paisaje de amenazas adversas para sistemas de inteligencia artificial)

- Una encuesta sobre seguridad de aprendizaje de refuerzo con aplicación a conducción autónoma

- Cómo evitar las dificultades de aprendizaje automático: una guía para investigadores académicos

- Una lista curada de eventos de seguridad y privacidad de IA

- NIST AI 100-2 E2023: Aprendizaje automático adversario. Una taxonomía y terminología de ataques y mitigaciones.

- ?? RootedCon 2023 - Inteligencia Artificial ofensiva - ¿Cómo podemos estar Preparados?

- Seguridad de AI -Systems: Fundamentos - Aprendizaje profundo adversario

- Más allá de las salvaguardas: explorar los riesgos de seguridad de chatgpt

- El mapa de superficie de ataque de IA V1.0

- Sobre la seguridad imposible de los grandes modelos de IA

- Regulación de la IA fronteriza: gestión de riesgos emergentes para la seguridad pública

- Marco de múltiples capas para buenas prácticas de ciberseguridad para la IA

- Presentamos el marco AI seguro de Google

- Owasp Top 10 para LLM

- Awesome LLM Security: una curación de herramientas, documentos y proyectos increíbles sobre la seguridad de LLM.

- Un marco para usar de forma segura LLM en empresas. Parte 1: Descripción general de los riesgos. Parte 2: Gestión del riesgo. Parte 3: Asegurar el Copilot de chatgpt y github.

- Un estudio sobre robustez y confiabilidad de la generación de código de modelos de lenguaje grande

- Identificar imágenes generadas por IA con Synthid

- Auditar modelos de idiomas grandes: un enfoque de tres capas

- Resolviendo la batalla del riesgo de IA a corto y largo plazo

- Fraudgpt: el avatar de villano de chatgpt

- Riesgos de IA - Schneier en seguridad

- Uso de LLM para fines ilícitos: amenazas, medidas de prevención y vulnerabilidades

- El equipo rojo de IA no es una solución única para AI Harms: recomendaciones para usar el equipo rojo para la responsabilidad de IA

- Una taxonomía de confiabilidad para la inteligencia artificial

- Gestionar los riesgos de IA en una era de progreso rápido

- Google - Actuar sobre nuestro compromiso con una IA segura y segura

- Libro de jugadas de ML ofensivo

- Desmitificador de IA generativa? Notas de un investigador de seguridad

- Genai-Security-Adventures: una iniciativa de código abierto para compartir notas, presentaciones y una colección diversa de experimentos presentados en los cuadernos de Jupyter, todos destinados a ayudarlo procesamiento del lenguaje.

- AI Safety Camp lo conecta con una investigación para colaborar en un proyecto: ver dónde su trabajo podría ayudar a garantizar que la IA futura sea segura.

- Directrices para el desarrollo seguro del sistema de IA

- Enfoque de la inteligencia artificial y la ciberseguridad. Informe de mejores prácticas

- Stanford Safe, segura y confiable AI EO 14110 Tracker

- Awesome ML Security: una lista curada de impresionantes referencias de seguridad de aprendizaje automático, orientación, herramientas y más.

- El camino predecible de AI: 7 cosas a esperar de AI en 2024+

- Inteligencia artificial y ciberseguridad (en español?)

- Vigil: detectar inyecciones rápidas, jailbreaks y otras entradas de modelo de lenguaje grande potencialmente riesgoso (LLM).

- Modelos de IA generativos: oportunidades y riesgos para la industria y las autoridades

- Implementación de sistemas de IA de forma segura. Las mejores prácticas para implementar sistemas de IA seguros y resistentes

- NIST AI 600-1: Marco de gestión de riesgos de inteligencia artificial: Perfil generativo de inteligencia artificial

- ?? ANSSI: Recomendaciones de Sécurité Pour Unystème d'Ia générative (recomendaciones de seguridad para un sistema de IA generativo)

- Pirit: la herramienta de identificación de riesgos de Python para IA generativa (Pyrit) es un marco de automatización de acceso abierto para capacitar a los profesionales de la seguridad y a los ingenieros de aprendizaje automático para encontrar riesgos de manera proactiva en sus sistemas generativos de IA.

- OWASP-AGENTIC-AI: Trabajando para crear el OWASP Top 10 para Agentic AI (AI Agent Security).

- Hacia una IA segura garantizada: un marco para garantizar sistemas de IA robustos y confiables

- Definición de riesgos de IA reales

- Enfoque seguro para la IA generativa

- Modelos de idiomas grandes en ciberseguridad

- ¡Oye, esa es mi modelo! Introducción de Chain & Hash, una técnica de huellas dactilares LLM

- Uso indebido generativo de IA: una taxonomía de tácticas e ideas de los datos del mundo real

- Repositorio de riesgos de IA

- Revisando el equipo rojo de IA

- Recomendaciones alemanas-francesas para el uso de asistentes de programación de IA

- Marca de agua escalable para identificar salidas de modelos de lenguaje grandes

Encuestas

- La amenaza de IA ofensiva para las organizaciones

- Inteligencia artificial en el dominio cibernético: ofensa y defensa

- Una encuesta sobre ataques y defensas adversas

- Aprendizaje profundo adversario: una encuesta sobre ataques adversos y mecanismos de defensa sobre la clasificación de imágenes

- Una encuesta de ataques de privacidad en el aprendizaje automático

- Hacia las amenazas de seguridad de los sistemas de aprendizaje profundo: una encuesta

- Una encuesta sobre amenazas de seguridad y técnicas defensivas de aprendizaje automático: una vista basada en datos

- Sok: Seguridad y privacidad en el aprendizaje automático

- Aprendizaje automático adversario: el aumento en el crimen habilitado para la AI y su papel en la evasión del filtro de spam

- Amenazas, vulnerabilidades y controles de los sistemas basados en el aprendizaje automático: una encuesta y taxonomía

- Ataques y defensas adversas: una encuesta

- Security Matters: una encuesta sobre el aprendizaje automático adversario

- Una encuesta sobre ataques adversos para el análisis de malware

- Aprendizaje automático adversario en la clasificación de imágenes: una encuesta hacia la perspectiva del defensor

- Una encuesta de capacitación adversaria sólida en el reconocimiento de patrones: fundamental, teoría y metodologías

- Privacidad en modelos de idiomas grandes: ataques, defensas y direcciones futuras

? Mantenedores?

Miguel Hernández |

José Ignacio Escripano |

© ️ License © mezE

- Creative Commons Attribution-compartir por igual 4.0 International