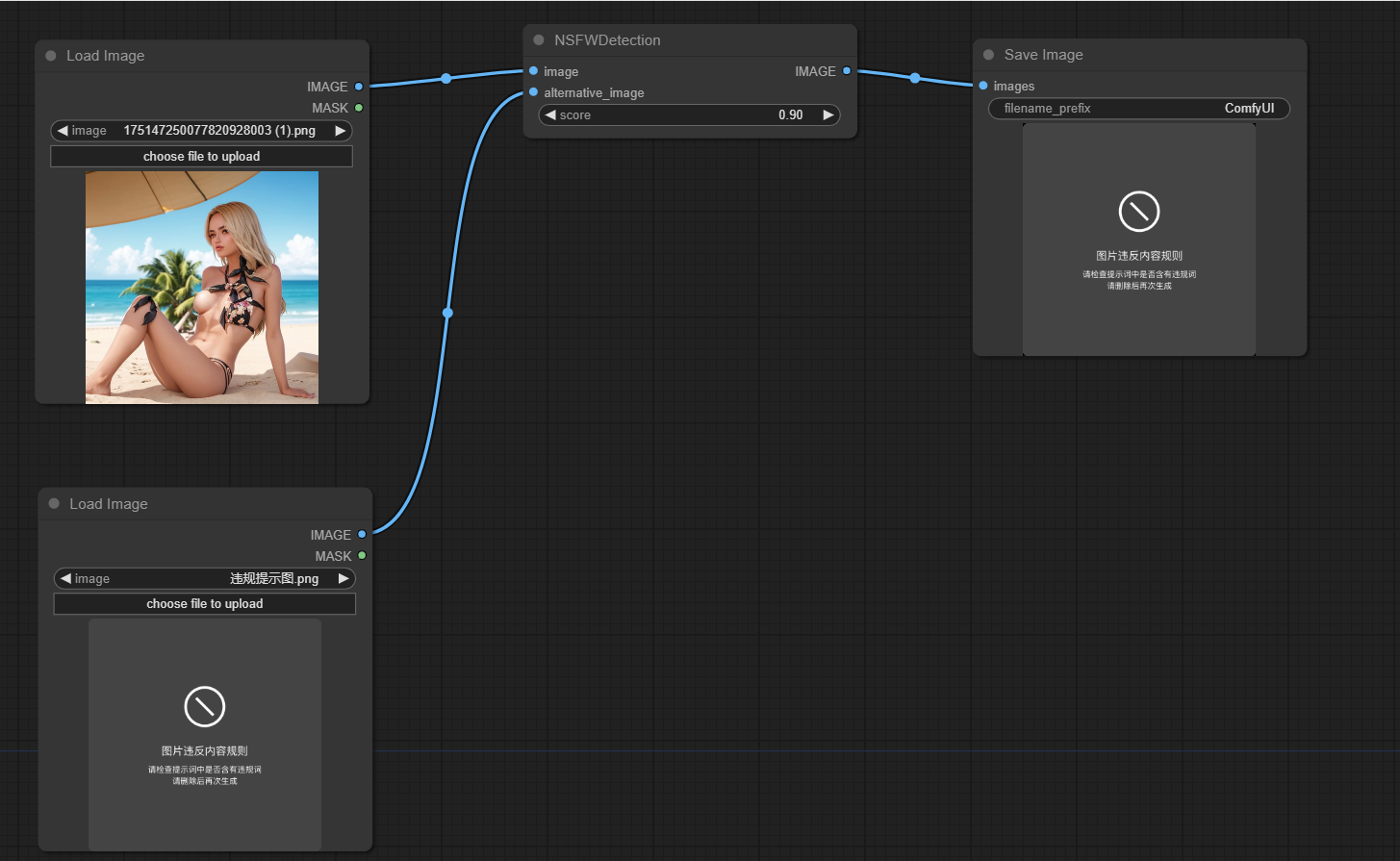

Este proyecto está diseñado para detectar si las imágenes generadas por COMFYUI no son seguras para el trabajo (NSFW). Utiliza un modelo de aprendizaje automático para clasificar las imágenes como seguras o no seguras para el trabajo. Si una imagen se clasifica como NSFW, se devuelve una imagen alternativa.

Clon este repositorio en el directorio de custom_nodes de la ubicación de Comfyui

Ejecute los requisitos de PIP instalación -r.txt

La funcionalidad principal del proyecto se encapsula en la clase NSFWDetection en el archivo node.py Esta clase tiene un método run que toma tres parámetros:

image : la imagen a clasificar.score : el umbral de puntuación para clasificar una imagen como NSFW.alternative_image : la imagen que se devolverá si la imagen de entrada se clasifica como NSFW.

https://github.com/trumanwong/comfyui-nsfw-detection/blob/main/workflow.json

Las contribuciones son bienvenidas. Envíe una solicitud de extracción si tiene mejoras o correcciones de errores.

Este proyecto tiene licencia bajo los términos de la licencia MIT.