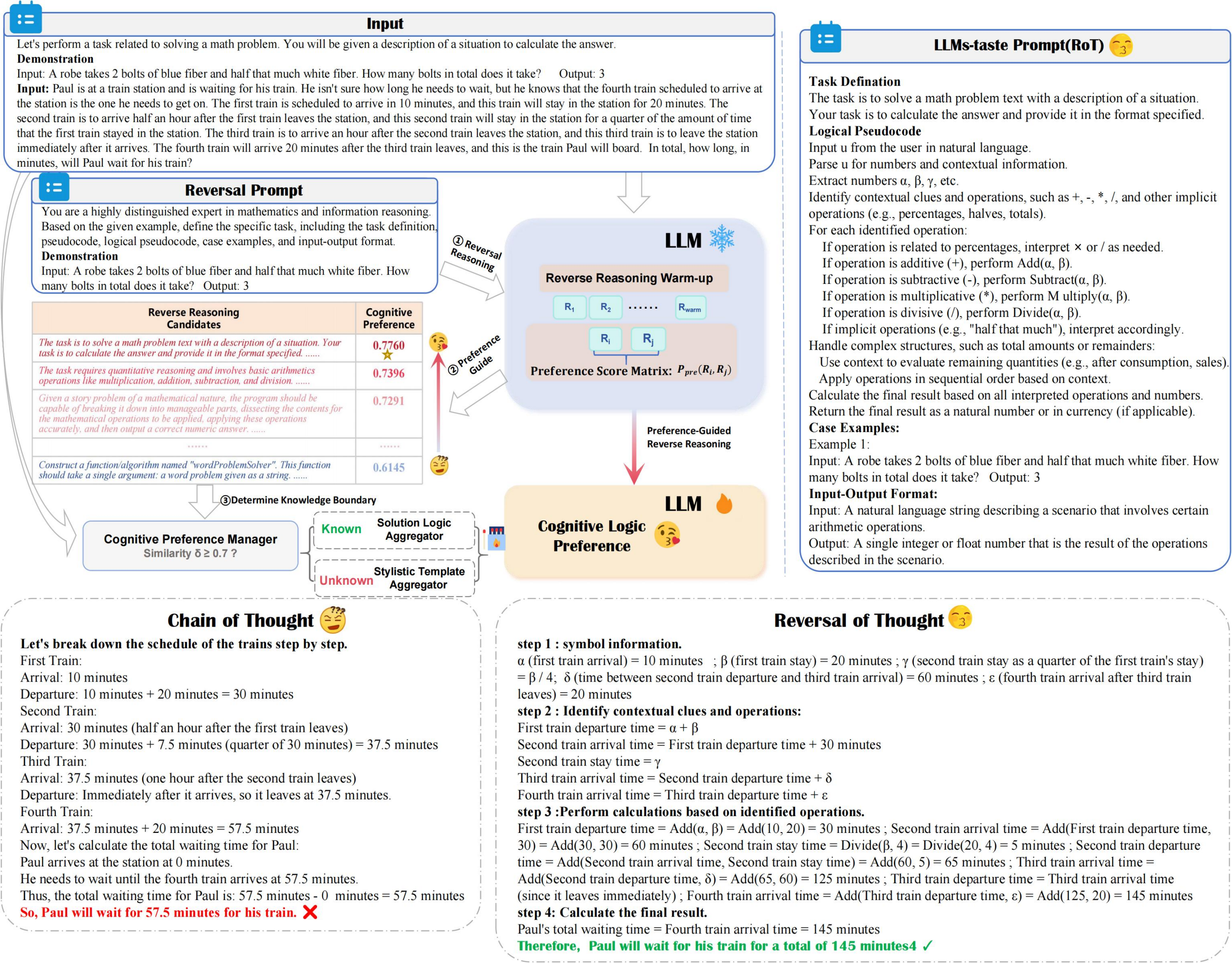

La ROT mejora la precisión y la eficiencia del razonamiento al tiempo que minimiza los costos computacionales, aprovechando el razonamiento inverso guiado por preferencias y un administrador de preferencias cognitivas para explorar de manera óptima el razonamiento de LLM con preferencias cognitivas.

???? reversal_demo.py

from utils . llm_utils import *

from utils . prompt import *

pipeline = Pipeline ( model_id = model_id , base_url = base_url , api_key = api_key , prob = True )

demos = "Input:... Output:..." #Suggest 2-shot Demos

llm_taste = rot_pipeline ( pipeline , reversal_of_thought , demos = demos , warmup = 5 ) Mejorar las indicaciones preferidas por LLM para las soluciones de tareas

Refina las indicaciones para alinearse con las estrategias preferidas por LLM, optimizando la eficiencia de resolución de tareas.

Potencial para crear diversos conjuntos de datos de control de calidad

Genera variados pares de preguntas y respuestas para mejorar la diversidad del conjunto de datos.

Si encuentra útil nuestro trabajo para su investigación, por favor cita nuestro artículo de la siguiente manera:

@article { yuan2024reversal ,

title = { Reversal of Thought: Enhancing Large Language Models with Preference-Guided Reverse Reasoning Warm-up } ,

author = { Yuan, Jiahao and Du, Dehui and Zhang, Hao and Di, Zixiang and Naseem, Usman } ,

journal = { arXiv preprint arXiv:2410.12323 } ,

year = { 2024 }

}