Genere juegos y programas utilizando agentes de OpenAI. Construido sobre Microsoft Autogen.

️ Trabajo en progreso

El código actual funciona pero:

- Hay, y habrá, los cambios de ruptura:

- Siempre verifique que su archivo

.env.jsoncoculto coincida con la última estructuraenv.sample.jsonc.- Siempre actualice sus dependencias a través de

poetry install.- Se deben optimizar muchas cosas para reducir drásticamente el uso de tokens: almacenamiento en caché, proceso de pasos por paso, división de conversación, mejores indicaciones.

- El código necesita algo de limpieza.

- Microsoft Autogen todavía está en la etapa temprana y contiene algunos errores.

- Muchas cosas codificadas se pueden personalizar a través de archivos de configuración.

- Solo me centraré en algunos lenguajes de programación al principio.

Hay algunos proyectos increíbles que hacen cosas similares, pero espero encontrar una manera de resolver la generación de programas ambiciosos.

Necesita una tecla API OpenAI o una tecla API API Azure OpenAI.

No confíe en GPT-3.5 , ya sean turbo o estándar, para más que solo programas de "muestra". Si apunta a aplicaciones más complejas, GPT-4 es imprescindible, preferiblemente incluso GPT-4-32k .

Usar la API de OpenAI podría agotar rápidamente su límite de token. Para proyectos más extensos, se recomienda la API de Azure Openai.

¡Tenga en cuenta los costos si tiene objetivos ambiciosos! Siempre monitoree el uso de tokens y lo que están haciendo sus agentes. Si bien la IA puede ser una herramienta poderosa, no es necesariamente más barato que contratar desarrolladores reales, ¿todavía?

conda create -n autogen python=3.10

conda activate autogen

pip install poetry

poetry install

cp env.sample.jsonc env.jsonc Edite su env.json para agregar sus claves API y personalizar su instalación.

Justo:

make run OADS generará automáticamente el código fuente del programa en el directorio ./project .

Puedes limpiarlo a través de:

make cleanIMPORTANTE: Las funciones no funcionarán.

Por lo que probé, Autogen parece funcionar con cualquier LLM de código abierto compatible con la interfaz de usuario de la generación de texto.

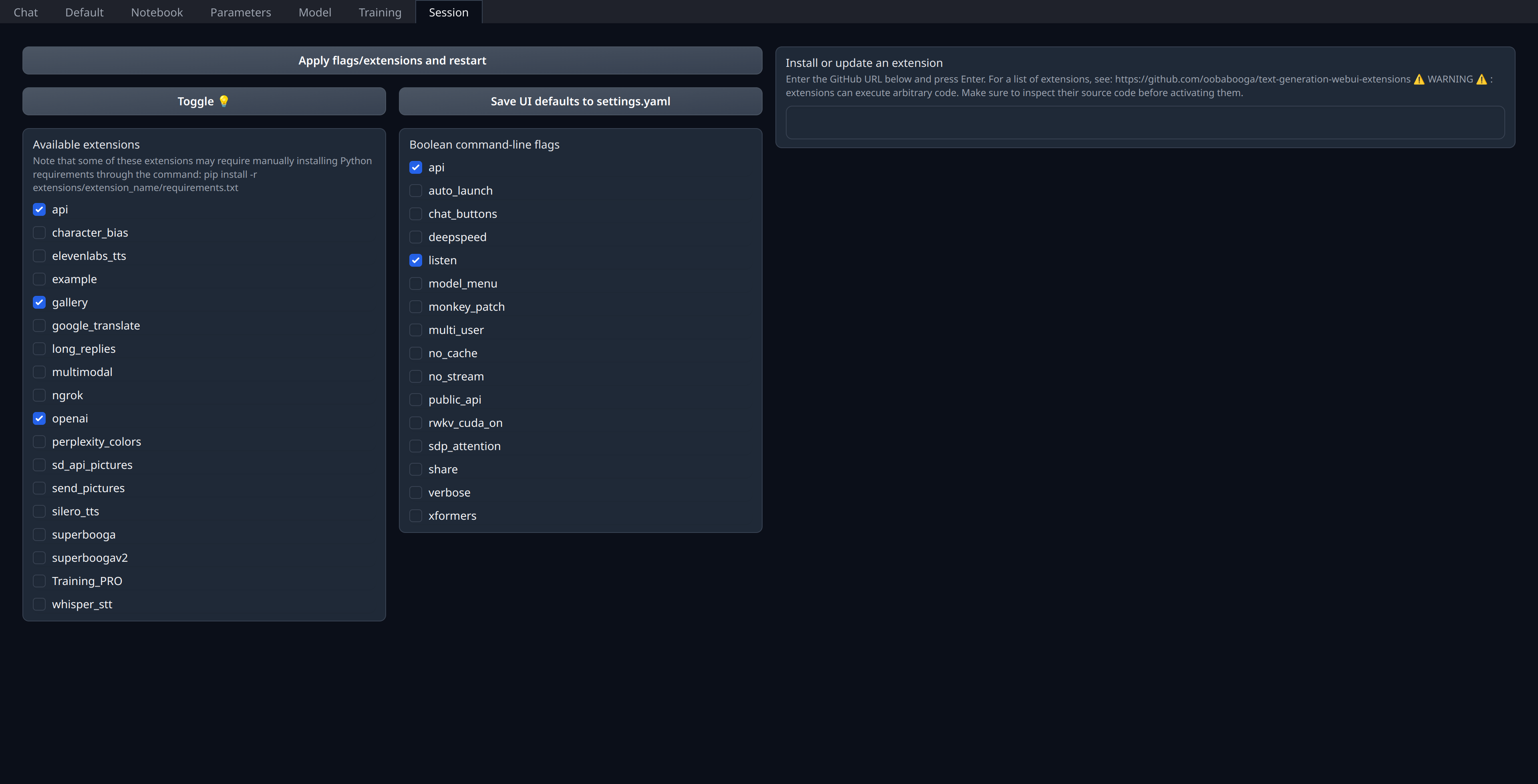

Solo tiene que habilitar la extensión openai en la pestaña "Sesión" de la interfaz de usuario web:

Asegúrese de tener su puerto 5001 abierto o vinculado si es un servidor remoto, ya que aquí es donde se expusirá la API tipo OpenAI.

Personalmente implemento mis modelos actuales en RunPod (no afiliado) y uso thebloke/cuda11.8.0-ubuntu22.04-oneclick:latest imagen aunque creo que parece un poco desactualizado con respecto a Llama.CPP & Co.

"models" : [

// Custom deployment of (for example) `Open-Orca/Mistral-7B-OpenOrca`

// using "Text generation web UI" with `OpenAI` extension enabled:

// https://github.com/oobabooga/text-generation-webui/tree/main/extensions/openai#an-openedai-api-openai-like

// This can be any inference endpoint compatible following OpenAI API specs,

// regardless of the model you use behind it.

{

"model" : "Open-Orca/LlongOrca-13B-16k" ,

"api_base" : "http://localhost:5001" , // Or your remote server URL

"api_key" : "sk-111111111111111111111111111111111111111111111111" ,

"api_type" : "open_ai"

}

] ,