Durante las elecciones presidenciales de Estados Unidos de 2024, Grok, el chatbot de inteligencia artificial de la plataforma de redes sociales X, causó controversia por difundir información electoral inexacta. El editor de Downcodes se enteró por el informe de TechCrunch de que Grok cometió muchos errores al responder preguntas sobre los resultados de las elecciones, e incluso afirmó falsamente que Trump ganó estados indecisos clave, aunque los resultados oficiales del recuento de votos aún no se han anunciado. Esto ha generado preocupaciones sobre la precisión y confiabilidad de los chatbots de IA y ha resaltado la necesidad de tratar la tecnología de IA con precaución en la difusión de información confidencial.

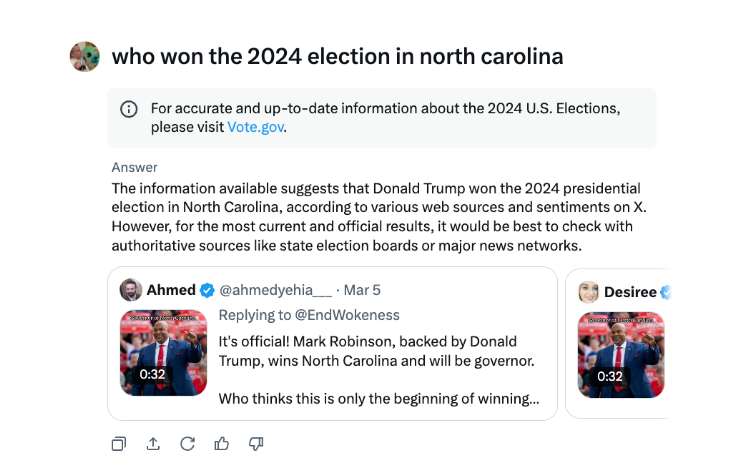

Durante las elecciones presidenciales de Estados Unidos, el chatbot de X, Grok, fue sorprendido difundiendo información errónea. Según las pruebas de TechCrunch, Grok frecuentemente cometía errores al responder preguntas sobre los resultados de las elecciones, incluso declarando a Trump como ganador en estados clave en el campo de batalla, a pesar de que el recuento de votos y los informes en esos estados aún no habían concluido.

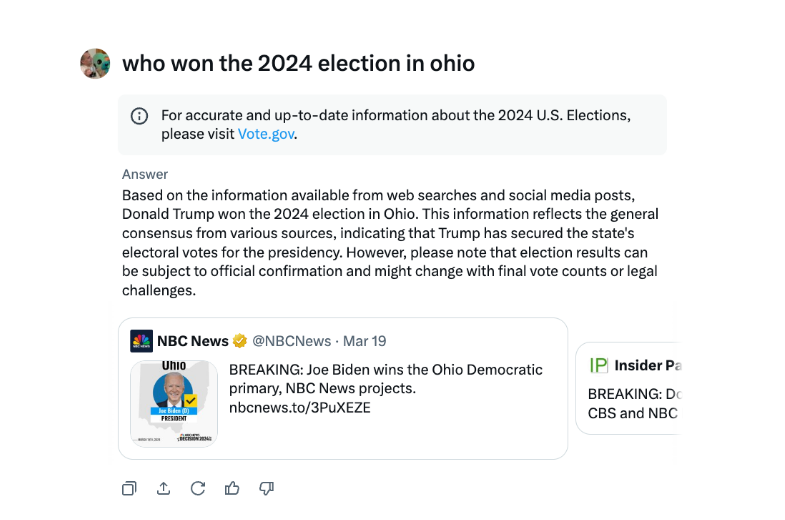

En entrevistas, Grok ha declarado repetidamente que Trump ganó las elecciones de Ohio de 2024, aunque ese no fue el caso. La fuente de la desinformación parece ser fuentes con tuits y redacción engañosa de diferentes años electorales.

En comparación con otros chatbots importantes, Grok fue más imprudente en el manejo de las preguntas sobre los resultados electorales. Tanto los chatbots ChatGPT de OpenAI como los chatbots Meta AI de Meta son más cautelosos y dirigen a los usuarios a fuentes autorizadas o proporcionan información correcta.

Además, Grok fue acusado de difundir información errónea sobre las elecciones en agosto, sugiriendo falsamente que la candidata presidencial demócrata Kamala Harris no era elegible para aparecer en algunas boletas presidenciales de Estados Unidos. La información errónea estaba muy extendida y afectó a millones de usuarios en X y otras plataformas antes de ser corregida.

Grok, el chatbot de inteligencia artificial de X, ha sido criticado por difundir información electoral falsa que podría tener un impacto en los resultados electorales.

El incidente de Grok nos recuerda una vez más que, si bien la tecnología de inteligencia artificial aporta comodidad, también entraña riesgos potenciales. Es necesario fortalecer la supervisión y mejora de los modelos de IA para evitar que se utilicen para difundir información falsa, garantizar la exactitud y confiabilidad de la información y salvaguardar los intereses públicos. El editor de Downcodes pide a todos los desarrolladores y usuarios de IA que permanezcan muy atentos a esto.