El editor de Downcodes se enteró de que Ai2, una institución de investigación de inteligencia artificial sin fines de lucro, lanzó recientemente su nueva serie de modelos de lenguaje OLMo2, que es la segunda generación de su serie "Open Language Model" (OLMo). OLMo2 se adhiere al concepto de código fuente completamente abierto, y sus datos, herramientas y códigos de entrenamiento son completamente abiertos. Esto es particularmente importante en el campo de la IA actual y representa una nueva altura en el desarrollo de la IA de código abierto. A diferencia de otros modelos que afirman ser "abiertos", OLMo2 sigue estrictamente la definición de la Iniciativa de código abierto, cumple con los estrictos estándares de IA de código abierto y proporciona a la comunidad de IA un sólido soporte técnico y valiosos recursos de aprendizaje.

Ai2, una organización de investigación de IA sin fines de lucro, lanzó recientemente su nueva serie OLMo2, que es el modelo de segunda generación de la serie "Open Language Model" (OLMo) lanzada por la organización. El lanzamiento de OLMo2 no solo proporciona un sólido soporte técnico para la comunidad de IA, sino que también representa el último desarrollo de IA de código abierto con su código fuente completamente abierto.

A diferencia de otros modelos de lenguaje "abierto" actualmente en el mercado como la serie Llama de Meta, OLMo2 cumple con la estricta definición de la Open Source Initiative, lo que significa que los datos de entrenamiento, las herramientas y el código utilizados para su desarrollo son públicos y accesibles para cualquier persona. usar. Según lo definido por la Open Source Initiative, OLMo2 cumple con los requisitos de la organización para un estándar de "IA de código abierto", que se finalizó en octubre de este año.

Ai2 mencionó en su blog que durante el proceso de desarrollo de OLMo2, todos los datos de capacitación, códigos, planes de capacitación, métodos de evaluación y puntos de control intermedios estuvieron completamente abiertos, con el objetivo de promover la innovación y el descubrimiento en la comunidad de código abierto a través de recursos compartidos. "Al compartir abiertamente nuestros datos, soluciones y hallazgos, esperamos brindar a la comunidad de código abierto los recursos para descubrir nuevos métodos y tecnologías innovadoras", dijo Ai2.

La serie OLMo2 incluye dos versiones: una es OLMo7B con 7 mil millones de parámetros y la otra es OLMo13B con 13 mil millones de parámetros. La cantidad de parámetros afecta directamente el rendimiento del modelo y las versiones con más parámetros generalmente pueden manejar tareas más complejas. OLMo2 tuvo un buen desempeño en tareas de texto comunes, pudiendo completar tareas como responder preguntas, resumir documentos y escribir código.

Nota sobre la fuente de la imagen: la imagen es generada por IA y la imagen está autorizada por el proveedor de servicios Midjourney

Para entrenar OLMo2, Ai2 utilizó un conjunto de datos que contenía cinco billones de tokens. Token es la unidad más pequeña en el modelo de lenguaje. 1 millón de tokens equivalen aproximadamente a 750.000 palabras. Los datos de capacitación incluyen contenido de sitios web de alta calidad, artículos académicos, foros de discusión de preguntas y respuestas y libros de ejercicios de matemáticas sintéticas, y se seleccionan cuidadosamente para garantizar la eficiencia y precisión del modelo.

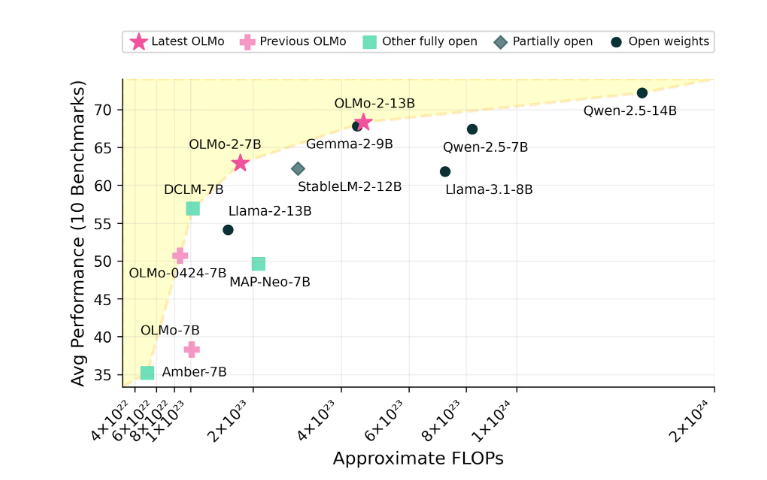

Ai2 confía en el rendimiento de OLMo2 y afirma que ha competido con modelos de código abierto como Meta's Llama3.1 en rendimiento. Ai2 señaló que el rendimiento de OLMo27B incluso superó a Llama3.18B y se convirtió en uno de los modelos de lenguaje totalmente abierto más sólidos en la actualidad. Todos los modelos OLMo2 y sus componentes se pueden descargar de forma gratuita a través del sitio web oficial de Ai2 y siguen la licencia Apache2.0, lo que significa que estos modelos se pueden utilizar no solo para investigación sino también para aplicaciones comerciales.

La naturaleza de código abierto de OLMo2 promoverá en gran medida la cooperación abierta y la innovación en el campo de la IA, proporcionando a investigadores y desarrolladores un espacio más amplio para el desarrollo. Esperamos que OLMo2 traiga más avances y aplicaciones en el futuro.