iFlytek ha lanzado un gran modelo interactivo multimodal de iFlytek, marcando un nuevo hito en el campo de la inteligencia artificial. Este modelo rompe las limitaciones de la interacción de una sola voz en el pasado y logra la integración perfecta de la interacción humana digital, visual y de voz, brindando a los usuarios una experiencia interactiva más vívida, real y conveniente. Los editores de Downcodes le brindarán una comprensión profunda de las funciones y ventajas de este increíble modelo de interacción multimodal y cómo cambiará la forma en que interactuamos con la inteligencia artificial.

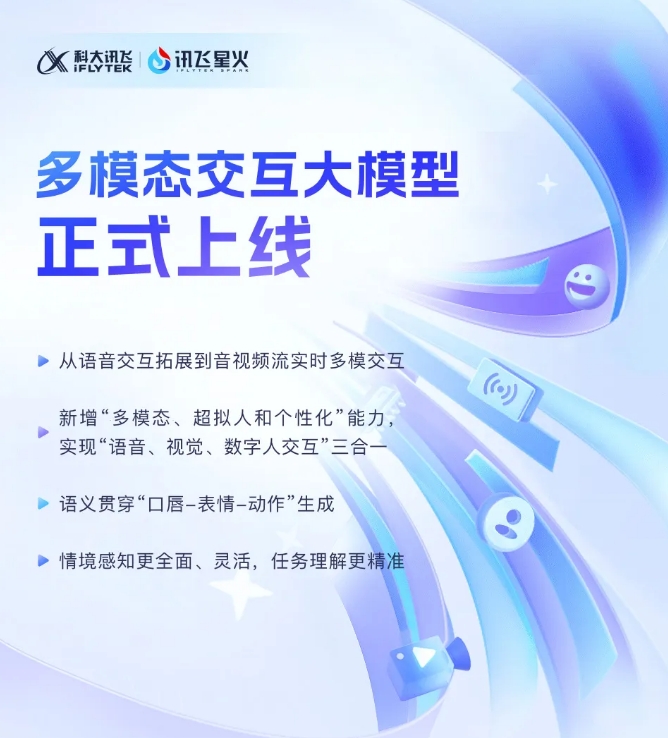

iFlytek anunció recientemente que su modelo grande interactivo multimodal iFlytek Spark recientemente desarrollado se ha puesto oficialmente en funcionamiento. Este avance tecnológico marca la expansión de iFlytek de una tecnología de interacción de voz única a una nueva etapa de interacción multimodal en tiempo real de transmisiones de audio y video. El nuevo modelo integra funciones de interacción humana visual, digital y de voz, y los usuarios pueden lograr una integración perfecta de las tres con un solo clic.

El lanzamiento del modelo interactivo multimodal de iFlytek introduce por primera vez tecnología humana digital súper antropomórfica. Esta tecnología puede hacer coincidir con precisión los movimientos del torso y las extremidades del humano digital con el contenido de voz, generar rápidamente expresiones y movimientos y mejorar en gran medida la calidad. capacidades de la IA. Al integrar texto, voz y expresiones, el nuevo modelo puede lograr una coherencia semántica intermodal, haciendo que la expresión emocional sea más realista y coherente.

Además, iFlytek Spark admite tecnología de interacción ultrarrápida súper antropomórfica y utiliza una red neuronal unificada para realizar directamente el modelado de voz a voz de extremo a extremo, lo que hace que la respuesta sea más rápida y fluida. Esta tecnología puede detectar claramente los cambios emocionales y ajustar libremente el ritmo, el tamaño y la personalidad del sonido según las instrucciones, proporcionando una experiencia interactiva más personalizada.

En términos de interacción visual multimodal, iFlytek Spark puede "comprender el mundo" y "reconocer todo", y percibir de manera integral escenas de fondo específicas, estado logístico y otra información, lo que hace que la comprensión de las tareas sea más precisa. Al integrar diversa información, como voz, gestos, comportamiento y emociones, el modelo puede dar respuestas apropiadas y brindar a los usuarios una experiencia interactiva más rica y precisa.

SDK de modelo grande interactivo multimodal: https://www.xfyun.cn/solutions/Multimodel

La aparición del gran modelo interactivo multimodal iFlytek Spark indica que la tecnología de inteligencia artificial se está desarrollando en una dirección más inteligente y humana. Sus potentes funciones y operaciones convenientes seguramente brindarán una nueva experiencia interactiva a los usuarios y brindarán posibilidades ilimitadas a todos los ámbitos de la vida. ¡Esperamos que iFlytek Spark nos traiga más sorpresas en el futuro!