El editor de Downcodes se enteró de que DeepSeek, una subsidiaria del gigante chino de capital privado Magic Square Quantitative, lanzó recientemente su último modelo de lenguaje a gran escala centrado en la inferencia, R1-Lite-Preview. Actualmente, este modelo solo está abierto al público a través de la plataforma de chatbot web DeepSeek Chat, y su rendimiento ha atraído una atención generalizada, acercándose o superando incluso el modelo de vista previa o1 lanzado recientemente por OpenAI. DeepSeek es conocido por sus contribuciones al ecosistema de IA de código abierto y este lanzamiento continúa su compromiso con la accesibilidad y la transparencia.

DeepSeek, una subsidiaria del gigante chino de capital privado Huifang Quantitative, lanzó recientemente su último modelo de lenguaje a gran escala centrado en la inferencia, R1-Lite-Preview. Actualmente, el modelo solo está disponible para el público a través de DeepSeek Chat, una plataforma de chatbot web.

DeepSeek es conocido por sus contribuciones innovadoras al ecosistema de IA de código abierto, y esta nueva versión tiene como objetivo brindar al público capacidades de inferencia de alto nivel manteniendo al mismo tiempo un compromiso con la accesibilidad y la transparencia. Aunque R1-Lite-Preview actualmente solo está disponible en aplicaciones de chat, ha atraído una gran atención con un rendimiento cercano o incluso superior al modelo o1-preview lanzado recientemente por OpenAI.

R1-Lite-Preview utiliza el razonamiento de "pensamiento en cadena", que puede mostrar los diferentes procesos de pensamiento por los que pasa al responder a las consultas de los usuarios.

Aunque algunas cadenas de pensamiento pueden parecer absurdas o incorrectas para los humanos, en general, las respuestas de R1-Lite-Preview son muy precisas e incluso pueden resolver las "trampas" encontradas por algunos modelos tradicionales de IA potentes, como las series GPT-4o y Claude. por ejemplo, ¿cuántas R hay en la palabra "fresa"? "¿Cuál es más grande, 9,11 o 9,9?"

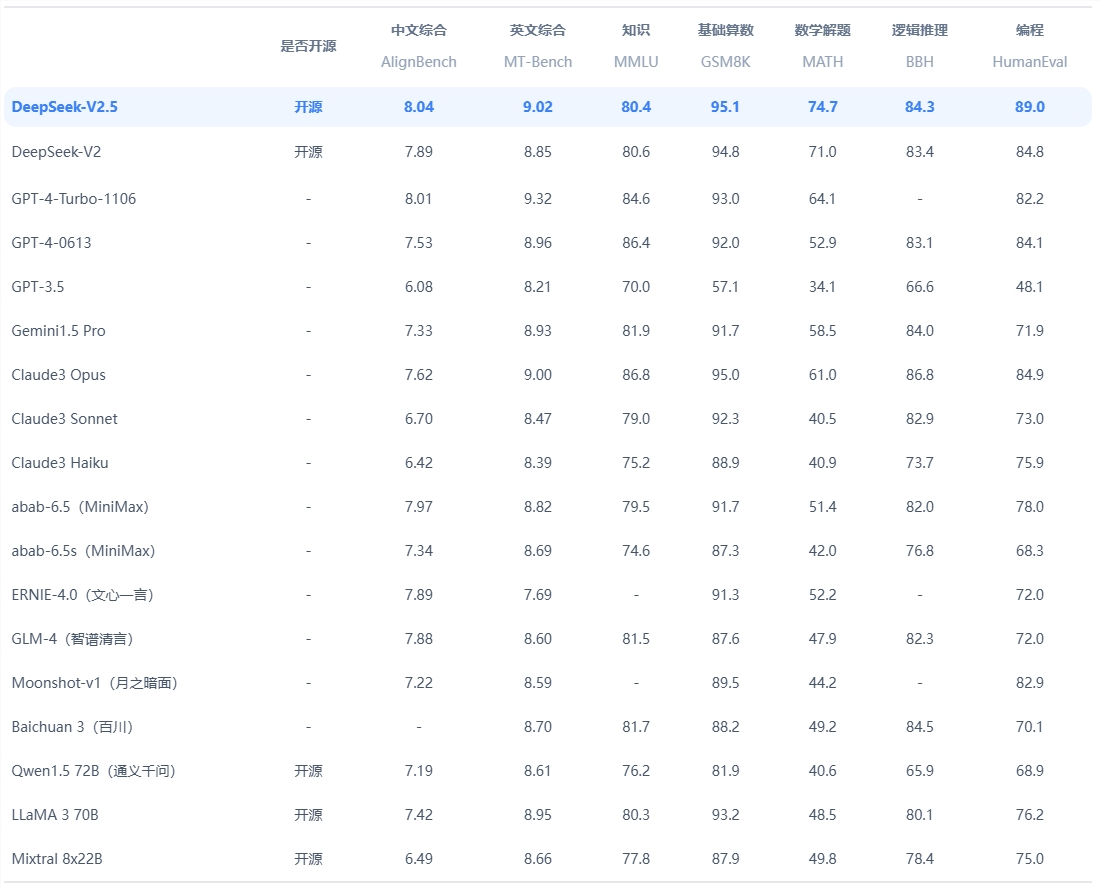

Según DeepSeek, el modelo destaca en tareas que requieren razonamiento lógico, pensamiento matemático y resolución de problemas en tiempo real. Su rendimiento supera el nivel de OpenAI o1-preview en puntos de referencia establecidos como AIME (American Invitational Mathematics Examination) y MATH.

Además, DeepSeek publicó datos ampliados sobre el modelo, lo que demuestra una mejora constante en la precisión cuando al modelo se le da más tiempo, o "tokens de pensamiento", para resolver el problema. El gráfico destaca que a medida que aumenta la profundidad del pensamiento, mejora la puntuación del modelo en puntos de referencia como AIME.

La versión actual de R1-Lite-Preview funciona bien en puntos de referencia clave, capaz de manejar una variedad de tareas, desde matemáticas complejas hasta escenarios lógicos, con puntuaciones comparables a los mejores modelos de inferencia como GPQA y Codeforces. El proceso de razonamiento transparente del modelo permite a los usuarios observar sus pasos lógicos en tiempo real, mejorando el sentido de responsabilidad y credibilidad del sistema.

Vale la pena señalar que DeepSeek no ha publicado el código completo para análisis o evaluaciones comparativas independientes de terceros, ni ha proporcionado una interfaz API para pruebas independientes. La compañía aún no ha publicado publicaciones de blog ni documentos técnicos relevantes que describan la capacitación o las pruebas. Estructura R1-Lite-Preview, lo que hace que el origen detrás de él aún esté lleno de dudas.

Actualmente, R1-Lite-Preview está disponible de forma gratuita a través de DeepSeek Chat (chat.deepseek.com), pero su modo avanzado de “pensamiento profundo” está limitado a 50 mensajes por día, lo que permite a los usuarios experimentar sus poderosas capacidades. DeepSeek planea lanzar versiones de código abierto de los modelos de la serie R1 y API relacionadas para respaldar aún más el desarrollo de la comunidad de IA de código abierto.

DeepSeek continúa impulsando la innovación en el espacio de la IA de código abierto y el lanzamiento de R1-Lite-Preview agrega una nueva dimensión a su inferencia y escalabilidad. A medida que las empresas y los investigadores exploran aplicaciones para la IA con uso intensivo de inferencias, el compromiso de DeepSeek con la apertura garantizará que sus modelos se conviertan en un recurso importante para el desarrollo y la innovación.

Entrada oficial: https://www.deepseek.com/

Con todo, R1-Lite-Preview demuestra la gran fortaleza de DeepSeek en el campo de los modelos de lenguaje a gran escala, y también vale la pena esperar con ansias su plan de código abierto. Sin embargo, la falta de divulgación del código y los documentos técnicos también arroja una capa de misterio sobre sus detalles técnicos. El editor de Downcodes seguirá atento al progreso posterior de DeepSeek.